Alibi هي مكتبة Python تهدف إلى فحص نماذج التعلم الآلي وتفسيرها. تركز المكتبة على توفير تطبيقات عالية الجودة لطرق الشرح ذات الصندوق الأسود والصندوق الأبيض والمحلية والعالمية لنماذج التصنيف والانحدار.

إذا كنت مهتمًا بالكشف عن الحالات الشاذة أو انحراف المفهوم أو اكتشاف مثيلات الخصومة، فاطلع على مشروعنا الشقيق Alibi-detect.

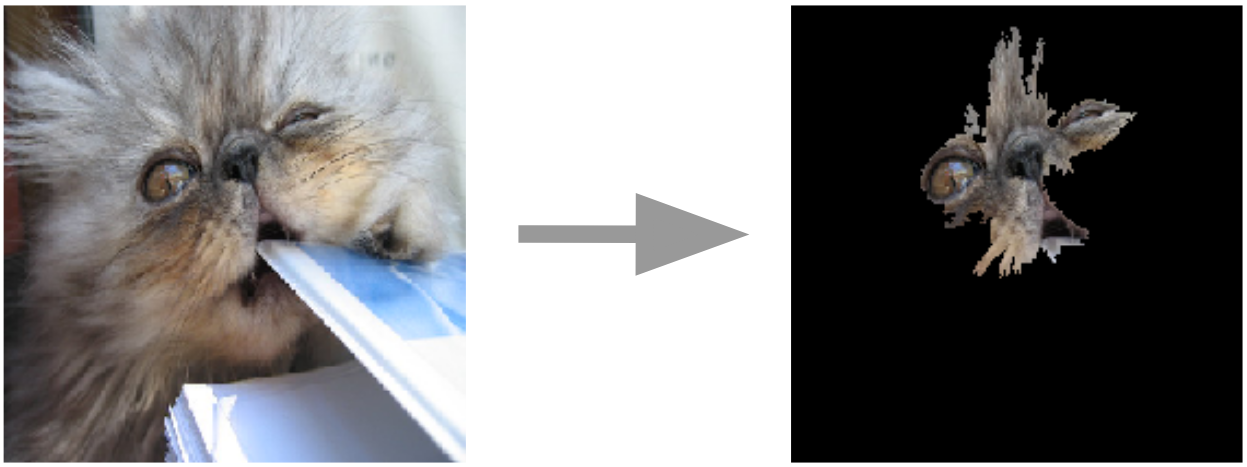

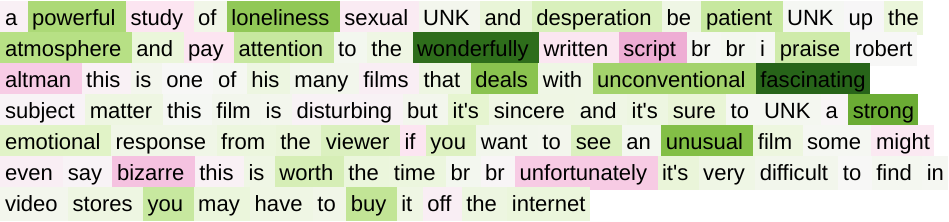

شرح مرساة للصور  | التدرجات المتكاملة للنص  |

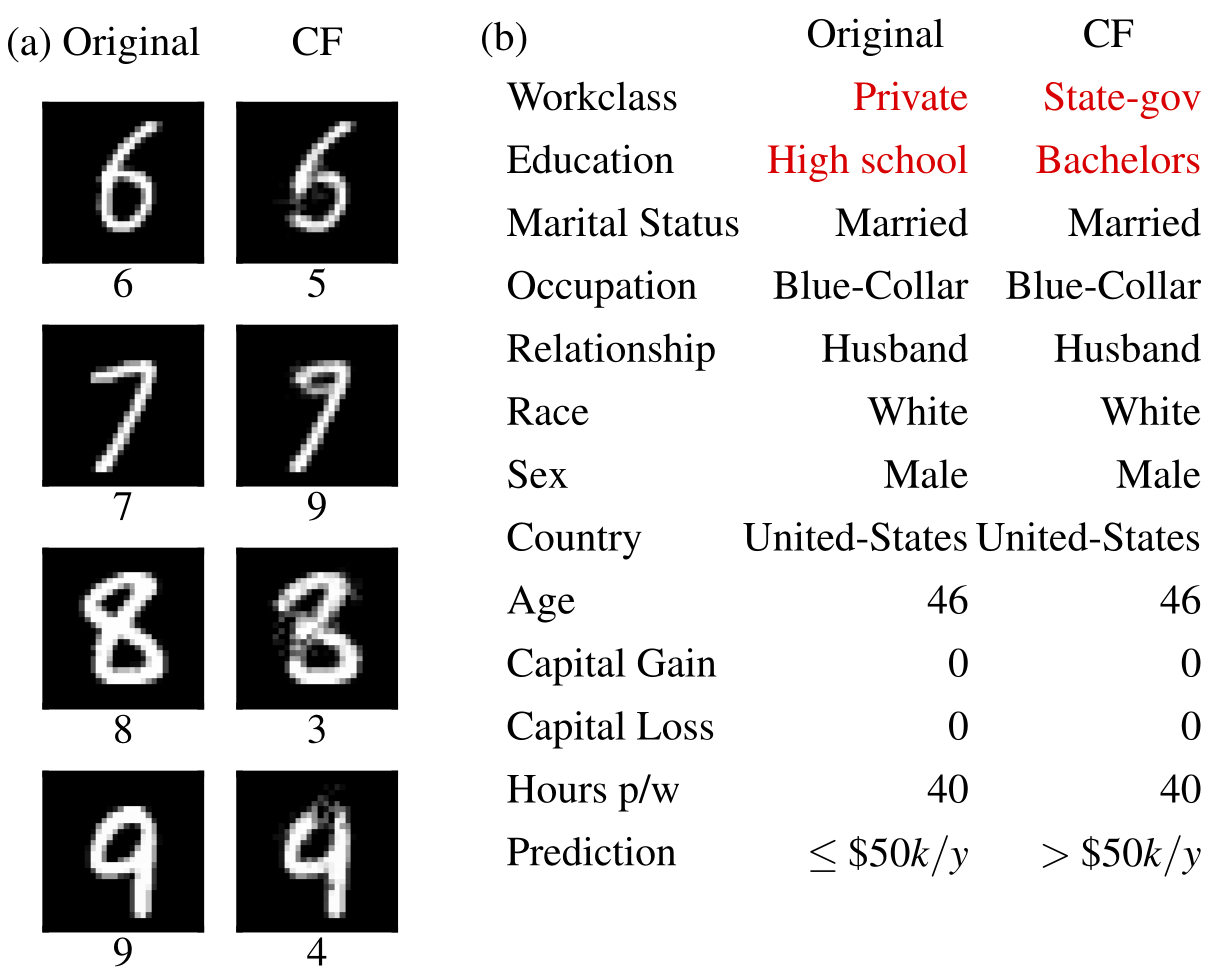

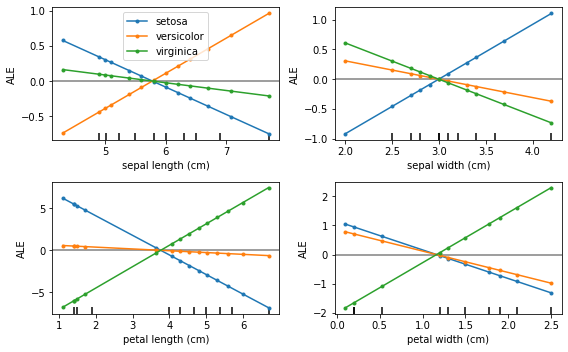

أمثلة مضادة  | التأثيرات المحلية المتراكمة  |

يمكن تثبيت Alibi من:

pip )conda / mamba )يمكن تثبيت Alibi من PyPI:

pip install alibiوبدلاً من ذلك، يمكن تثبيت الإصدار التطويري:

pip install git+https://github.com/SeldonIO/alibi.git للاستفادة من الحساب الموزع للشروحات، قم بتثبيت alibi باستخدام ray :

pip install alibi[ray] للحصول على دعم SHAP، قم بتثبيت alibi كما يلي:

pip install alibi[shap]للتثبيت من conda-forge، يوصى باستخدام mamba، والذي يمكن تثبيته على بيئة conda الأساسية باستخدام:

conda install mamba -n base -c conda-forgeلتثبيت Alibi القياسي:

mamba install -c conda-forge alibiلدعم الحوسبة الموزعة:

mamba install -c conda-forge alibi rayللحصول على دعم SHAP:

mamba install -c conda-forge alibi shap واجهة برمجة تطبيقات تفسير Alibi مستوحاة من scikit-learn ، والتي تتكون من خطوات تهيئة وملاءمة وشرح مميزة. سوف نستخدم شرح AnchorTabular لتوضيح واجهة برمجة التطبيقات:

from alibi . explainers import AnchorTabular

# initialize and fit explainer by passing a prediction function and any other required arguments

explainer = AnchorTabular ( predict_fn , feature_names = feature_names , category_map = category_map )

explainer . fit ( X_train )

# explain an instance

explanation = explainer . explain ( x ) التفسير الذي تم إرجاعه هو كائن Explanation ذو سمات meta data . meta عبارة عن قاموس يحتوي على البيانات الوصفية الموضحة وأي معلمات تشعبية data عبارة عن قاموس يحتوي على كل ما يتعلق بالشرح المحوسب. على سبيل المثال، بالنسبة لخوارزمية Anchor، يمكن الوصول إلى الشرح عبر explanation.data['anchor'] (أو explanation.anchor ). تختلف التفاصيل الدقيقة للحقول المتاحة من طريقة إلى أخرى، لذا نشجع القارئ على التعرف على أنواع الأساليب المدعومة.

تلخص الجداول التالية حالات الاستخدام المحتملة لكل طريقة.

| طريقة | نماذج | تفسيرات | تصنيف | الانحدار | مجدول | نص | الصور | الميزات الفئوية | مجموعة القطار المطلوبة | وزعت |

|---|---|---|---|---|---|---|---|---|---|---|

| البيرة | ب | عالمي | ✔ | ✔ | ✔ | |||||

| الاعتماد الجزئي | بي بي دبليو بي | عالمي | ✔ | ✔ | ✔ | ✔ | ||||

| تباين PD | بي بي دبليو بي | عالمي | ✔ | ✔ | ✔ | ✔ | ||||

| أهمية التقليب | ب | عالمي | ✔ | ✔ | ✔ | ✔ | ||||

| المراسي | ب | محلي | ✔ | ✔ | ✔ | ✔ | ✔ | لجدولي | ||

| CEM | بي بي* تي اف/كيراس | محلي | ✔ | ✔ | ✔ | خياري | ||||

| حقائق مضادة | بي بي* تي اف/كيراس | محلي | ✔ | ✔ | ✔ | لا | ||||

| نموذج أولي مضاد للواقع | بي بي* تي اف/كيراس | محلي | ✔ | ✔ | ✔ | ✔ | خياري | |||

| الحقائق المضادة مع RL | ب | محلي | ✔ | ✔ | ✔ | ✔ | ✔ | |||

| التدرجات المتكاملة | تي اف/كيراس | محلي | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | خياري | |

| نواة SHAP | ب | محلي عالمي | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ||

| شجرة شاب | البنك الدولي | محلي عالمي | ✔ | ✔ | ✔ | ✔ | خياري | |||

| تفسيرات التشابه | البنك الدولي | محلي | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ |

توفر هذه الخوارزميات درجات خاصة بالمثيلات تقيس ثقة النموذج لإجراء تنبؤ معين.

| طريقة | نماذج | تصنيف | الانحدار | مجدول | نص | الصور | الميزات الفئوية | مجموعة القطار المطلوبة |

|---|---|---|---|---|---|---|---|---|

| عشرات الثقة | ب | ✔ | ✔ | ✔(1) | ✔(2) | نعم | ||

| قياس الخطية | ب | ✔ | ✔ | ✔ | ✔ | خياري |

مفتاح:

توفر هذه الخوارزميات عرضًا مقطرًا لمجموعة البيانات وتساعد في إنشاء مصنف قابل للتفسير 1-KNN.

| طريقة | تصنيف | الانحدار | مجدول | نص | الصور | الميزات الفئوية | تسميات مجموعة القطار |

|---|---|---|---|---|---|---|---|

| بروتو سيليكت | ✔ | ✔ | ✔ | ✔ | ✔ | خياري |

التأثيرات المحلية المتراكمة (ALE, Apley and Zhu, 2016)

الاعتماد الجزئي (جيه إتش فريدمان، 2001)

تباين الاعتماد الجزئي (جرينويل وآخرون، 2018)

أهمية التقليب (بريمان، 2001؛ فيشر وآخرون، 2018)

تفسيرات المرساة (ريبيرو وآخرون، 2018)

طريقة الشرح التقابلي (CEM, Dhurandhar et al., 2018)

التفسيرات المضادة للواقع (امتداد Wachter وآخرون، 2017)

تفسيرات مضادة للواقع تسترشد بالنماذج الأولية (Van Looveren and Klaise, 2019)

التفسيرات المضادة للواقع المحايدة للنموذج عبر RL (Samoilescu et al.، 2021)

التدرجات المتكاملة (Sundararajan وآخرون، 2017)

تفسيرات Kernel Shapley المضافة (Lundberg et al., 2017)

تفسيرات شجرة شابلي المضافة (Lundberg et al., 2020)

نتائج الثقة (جيانغ وآخرون، 2018)

قياس الخطية

بروتو سيليكت

تفسيرات التشابه

إذا كنت تستخدم عذر الغياب في بحثك، فيرجى التفكير في الاستشهاد به.

إدخال BibTeX:

@article{JMLR:v22:21-0017,

author = {Janis Klaise and Arnaud Van Looveren and Giovanni Vacanti and Alexandru Coca},

title = {Alibi Explain: Algorithms for Explaining Machine Learning Models},

journal = {Journal of Machine Learning Research},

year = {2021},

volume = {22},

number = {181},

pages = {1-7},

url = {http://jmlr.org/papers/v22/21-0017.html}

}