هذه قائمة منسقة من أوراق "نموذج اللغة كخدمة (LMAAS)" ، والتي يحتفظ بها Tianxiang Sun. نشجع بشدة الباحثين في NLP المهتمين بهذا الموضوع على تقديم طلب سحب لإضافة أو تحديث الأوراق (انظر المساهمة). شاهد هذا المستودع للحصول على آخر التحديثات!

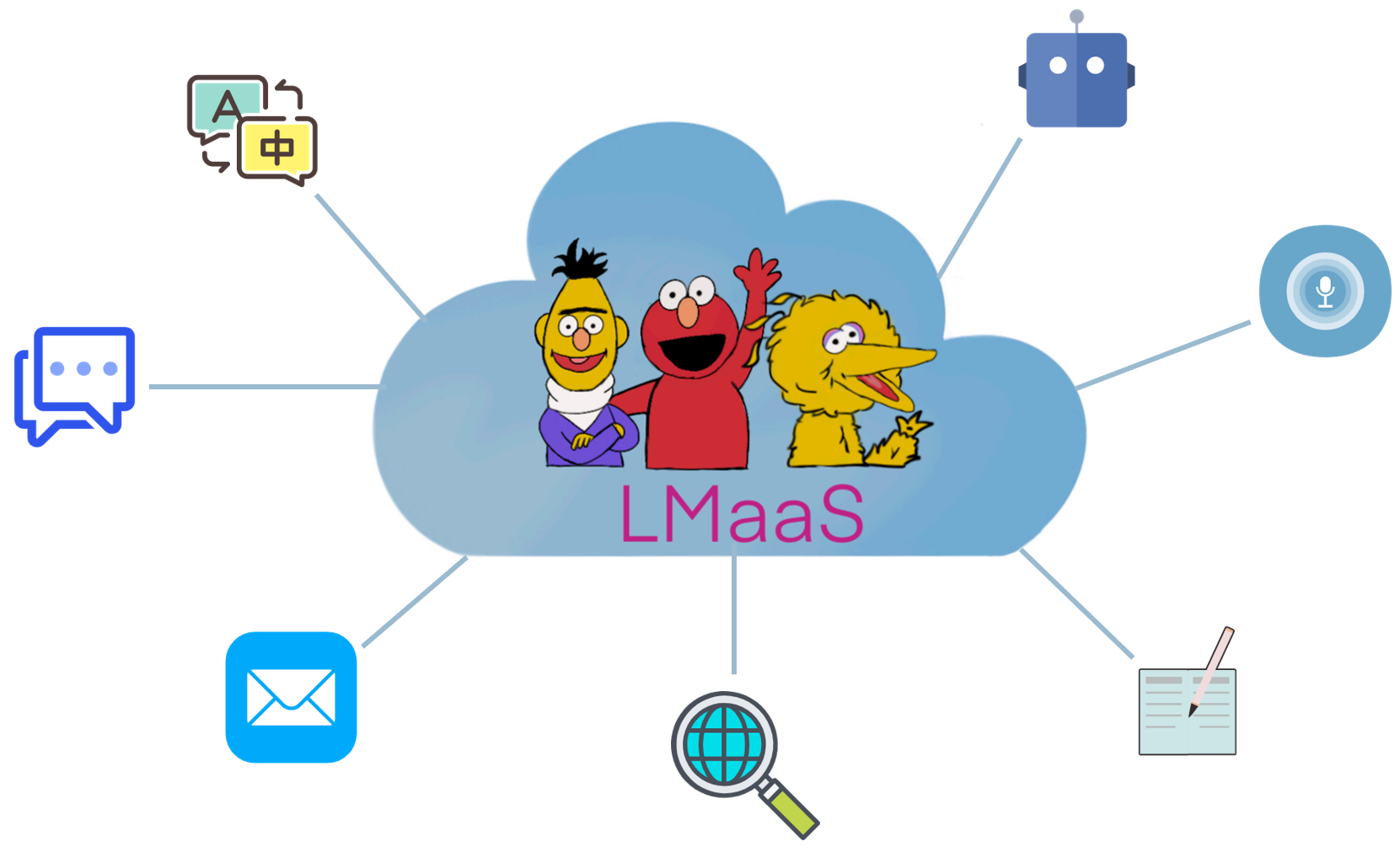

بسبب الأسباب التجارية وتكلفة ضبط باهظة الثمن ، يتم عادةً إصدار نماذج اللغة الكبيرة المدربة مسبقًا (LLMs) مثل GPT-3 كخدمة بدلاً من أوزان نموذج المصادر المفتوحة. نسمي هذا السيناريو " نموذج اللغة كخدمة (LMAAS) " (يستخدم المصطلح في الأصل في ورقة ICML'2022). في مثل هذا السيناريو ، يمكن للمستخدمين الوصول إلى LLMs القوية من خلال واجهات برمجة تطبيقات الاستدلال الخاصة بهم. قامت خدمة LLMS بتشغيل العديد من حالات الاستخدام (انظر GPT-3 Demo). على النقيض من صقله ، يسمح LMAAs لغرض عام واحد LLM لخدمة العديد من مهام الاختلاف وبالتالي فهي فعالة للغاية في النشر. ومع ذلك ، فإن كيفية تكييف LLMs لاستهداف المهام دون الوصول إلى المعلمات والتدرجات يمثل تحديًا. لجعل LLMS تستفيد من جمهور أوسع ، نجمع الأوراق التي تتناسب مع هذا السيناريو لتسهيل الأبحاث المستقبلية.

ما هي الأوراق التي تتناسب مع سيناريو LMAAS؟ نحن نفكر بشكل أساسي في الأوراق التي تكييف LLMs مع مهام المصب دون الوصول إلى معلمات النموذج والتدرجات. على الرغم من أن LLMs التي تم ضبطها يمكن أن تكون أيضًا خدمات بعد النشر ، إلا أنها تقتصر على حل مهمة واحدة للجمهور المحدود. في نطاقنا ، نفضل تقديم نماذج للأغراض العامة لمجموعة متنوعة من المستخدمين.

في الأدبيات الموجودة ، هناك عدة خطوط من الأبحاث التي تتناسب مع lmaas:

الحدود بين موجه النص والتعلم داخل السياق غير واضحة بعض الشيء. في هذا الريبو ، تحتوي فئة مطالبة النص على أوراق لا تستخدم العينات المسمى ، في حين تتألف فئة التعلم داخل السياق من أوراق تشمل عينات تحمل علامات في المطالبات.

ملاحظة: يتمثل الموضوع ذي الصلة (والمتداخلة جزئيًا) في التعلم القائم على الفاضل ، والذي يهدف إلى حل مهام المصب باستخدام LLMs للأغراض العامة عن طريق تحويل الإدخال والإخراج مع بعض القوالب واللفظية ، على التوالي. ومع ذلك ، تتطلب معظم الأعمال في التعلم المستند إلى المعلمات والتدرجات النموذجية ، وبالتالي لا تتناسب مع نطاقنا. بالنسبة لأوراق التعلم المستندة إلى السلسلة غير المناسبة لـ LMAAs ، نوصي بالمساهمة في قائمة ورق رهيبة أخرى: Prompaper.

بالمقارنة مع LLMs الخاصة بالضبط ، فإن LMAAs لديها المزايا التالية:

اختصار العمل.

الميزة الرئيسية للعمل.

الإعداد التجريبي الرئيسي للعمل.

نماذج اللغة كقواعد المعرفة؟ EMNLP 2019

فابيو بتروني ، تيم روكتشيل ، باتريك لويس ، أنطون باختين ، يوكسانغ وو ، ألكساندر هـ. ميلر ، سيباستيان ريدل . [PDF] [رمز]

كيف يمكن أن نعرف ما هي نماذج اللغة تعرف؟ TACL 2020

Zhengbao Jiang ، Frank F. Xu ، Jun Araki ، Graham Neubig . [PDF] [رمز]

نماذج اللغة هي متعلمين قليلة. Neupips 2020

توم بي براون ، بنيامين مان ، نيك رايدر ، ميلاني سوبريا ، جاريد كابلان ، براوللا داريوال ، آرفيند نيلاكانتان ، براناف شيام ، جيريش ساستري ، أماندا أسكيل ، سانهيني أغاروال ، آرييل هربرت ، غريتشن كروغر ، توم هينايغر ، رويان ، راميش ، دانيال م. زيغلر ، جيفري وو ، كليمنز وينتر ، كريستوفر هيس ، مارك تشن ، إريك سيغلر ، ميتوس ليتوين ، سكوت جراي ، بنيامين تشيس ، جاك كلارك ، كريستوفر بيرنر ، سام ماكاندش ، أليك رادفورد ، إيليا سوتسكيفر ، داريو أمودي . [PDF]

تكييف نماذج اللغة للتعلم صفريًا عن طريق ضبط البيانات الوصفية على مجموعات البيانات ومجموعات المطالبة . نتائج EMNLP 2021

Ruiqi Zhong ، Kristy Lee ، Zheng Zhang ، Dan Klein . [PDF] [رمز]

نماذج اللغات المحفورة بالحيوية هي متعلمين صفري . ICLR 2022

جيسون وي ، مارتن بوسما ، فنسنت ي. تشاو ، كيلفن غو ، آدمز وي يو ، براين ليستر ، نان دو ، أندرو م. داي ، كوك ف. لو . [PDF] [رمز]

تمكين المهام المتعددة التي تمكن التدريب من تعميم المهمة صفرية . ICLR 2022

فيكتور سانه ، ألبرت ويبسون ، كولين رافيل ، ستيفن هـ. إليزا Szczechla ، Taewoon كيم ، غونجان شاباني ، نيهال ناياك ، ديباجيوتي داتا ، جوناثان تشانغ ، مايك تيان جيان جيانغ ، هان وانغ ، ماتيو مانيكا ، شنغ شين ، تشنغ شين يونغ ، هارشيت باندي ، راشيل باودن ، توماس وانغ ، تريشالا نيرا. ، أندريا Santilli ، Thibault Fevry ، Jason Alan Fries ، Ryan Teehan ، Tali Bers ، Stella Biderman ، Leo Gao ، Thomas Wolf ، Alexander M. Rush . [PDF] [رمز]

نماذج لغة التدريب لمتابعة التعليمات مع ردود الفعل البشرية . preprint 2022.3

Long Ouyang ، Jeff Wu ، Xu Jiang ، Diogo Almeida ، Carroll L. Wainwright ، Pamela Mishkin ، Chong Zhang ، Sandhini Agarwal ، Katarina Slama ، Alex Ray ، John Schulman ، Jacob Hilton ، Fraser Kelton ، Luke Miller ، Maddie Simens بيتر عقل ، بول كريستيانو ، جان ليك ، ريان لوي . [PDF] [رمز]

نماذج اللغة الكبيرة هي أسباب صفرية . preprint 2022.6

Takeshi Kojima ، Shixiang Shane Gu ، Machel Reid ، Yutaka Matsuo ، Yusuke Iwasawa . [PDF] [رمز]

Zero-Shot Video Question الإجابة عبر نماذج لغة ثنائية الاتجاه المجمدة . preprint 2022.6

أنطوان يانغ ، أنطوان ميتش ، جوزيف سيفيتش ، إيفان لابتيف ، كورديليا شميد . [PDF] [رمز]

نماذج اللغة هي واجهات للأغراض العامة . preprint 2022.6

Yaru Hao ، Haoyu Song ، Li Dong ، Shaohan Huang ، Zewen Chi ، Wenhui Wang ، Shuming MA ، Furu Wei . [PDF] [رمز]

توليد موجه على مستوى المستودع لنماذج اللغة الكبيرة من التعليمات البرمجية. preprint 2022.6

Disha Shrivastava ، Hugo Larochelle ، Daniel Tarlow [PDF] [Code] ، 2022.6

تجاهل موجه السابق: تقنيات الهجوم لنماذج اللغة. جائزة أفضل ورقة @ Neups ML السلامة ورشة عمل 2022.

Fábio Perez ، Ian Ribeiro [PDF] [Project] ، 2022.11

نماذج اللغة هي متعلمين قليلة. Neupips 2020

توم بي براون ، بنيامين مان ، نيك رايدر ، ميلاني سوبريا ، جاريد كابلان ، براوللا داريوال ، آرفيند نيلاكانتان ، براناف شيام ، جيريش ساستري ، أماندا أسكيل ، سانهيني أغاروال ، آرييل هربرت ، غريتشن كروغر ، توم هينايغر ، رويان ، راميش ، دانيال م. زيغلر ، جيفري وو ، كليمنز وينتر ، كريستوفر هيس ، مارك تشن ، إريك سيغلر ، ميسوس ليتوين ، سكوت جراي ، بنيامين تشيس ، جاك كلارك ، كريستوفر بيرنر ، سام ماكاندش ، أليك رادفورد ، إيليا سوتسكيفر ، داريو أمودي . [PDF]

المعايرة قبل الاستخدام: تحسين أداء طلقة قليلة لنماذج اللغة . ICML 2021

توني زهو ، إريك والاس ، شي فنغ ، دان كلاين ، سمير سينغ . [PDF] [رمز]

شرح للتعلم داخل السياق على أنه استدلال بايزي ضمني . ICLR 2022

سانج مايكل شيه ، أديتي راغوناثان ، بيرسي ليانغ ، تينجيو ماجستير . [PDF] [رمز]

سلسلة من الفكر تثير التفكير في نماذج اللغة الكبيرة . preprint 2022.1

جيسون وي ، Xuezhi Wang ، Dale Schuurmans ، Maarten Bosma ، Brian Ichter ، Fei Xia ، Ed Chi ، Quoc LE ، Denny Zhou . [PDF]

التعميم عبر المهام عبر تعليمات التعهيد الجماعي للغة الطبيعية . ACL 2022

سواروب ميشرا ، دانييل خاشابي ، شيتا بارال ، هانانه هاجشييرزي . [PDF] [رمز]

المطالبات المطلوبة بشكل خيالي وأين يمكن العثور عليها: التغلب على حساسية ترتيب قليلة الطلقة . ACL 2022

ياو لو ، ماكس بارتوولو ، أليستر مور ، سيباستيان ريدي ، بونتوس ستينيتورب . [PDF]

نموذج لغة القناة الصاخبة التي تقدم لتصنيف نص قليل . ACL 2022

Sewon Min ، Mike Lewis ، Hannaneh Hajishirzi ، Luke Zettlemoyer . [PDF] [رمز]

التعلم التلوي عبر نمط اللغة في السياق . ACL 2022

ياندا تشن ، رويكي تشونغ ، شنغ تشا ، جورج كاريبيس ، هو . [PDF] [رمز]

ما الذي يجعل أمثلة جيدة في السياق لـ GPT-3؟ Deelio@ACL 2022

Jiachang Liu ، Dinghan Shen ، Yizhe Zhang ، Bill Dolan ، Lawrence Carin ، Weizhu Chen . [PDF]

تعلم استرداد المطالبات للتعلم داخل السياق . NAACL 2022

أوهاد روبن ، جوناثان هيرزيج ، جوناثان بيرانت . [PDF] [رمز]

metaicl: تعلم التعلم في السياق . NAACL 2022

Sewon Min ، Mike Lewis ، Luke Zettlemoyer ، Hannaneh Hajishirzi . [PDF] [رمز]

تحسين التعلم القليلة في السياق من خلال التدريب الخاضع للإشراف ذاتيا . NAACL 2022

Mingda Chen ، Jingfei Du ، Ramakanth Pasunuru ، Todor Mihaylov ، Srini Iyer ، Veselin Stoyanov ، Zornitsa Kozareva . [PDF]

التعلم الذي تم إنشاؤه ذاتيًا في السياق: الاستفادة من نماذج اللغات التلقائية للعبور كمولد عرض توضيحي . lplm@naacl 2022

Hyuhng Joon Kim ، Hyunso Cho ، Junyeob Kim ، Taeuk Kim ، Kang Min Yoo ، Sang-Goo Lee . [PDF]

إعادة التفكير في دور المظاهرات: ما الذي يجعل العمل التعليمي في السياق؟ preprint 2022.2

Sewon Min ، Xinxi Lyu ، Ari Holtzman ، Mikel Artetxe ، Mike Lewis ، Hannaneh Hajishirzi ، Luke Zettlemoyer . [PDF] [رمز]

التعلم داخل السياق لتتبع حالة حوار قليلة. preprint 2022.3

يوشي هو ، تشيا-هيسوان لي ، تيانباو شي ، تاو يو ، نوح أ. سميث ، ماري أوستندورف . [PDF] [رمز]

يتحسن التوافق الذاتي سلسلة من التفكير في نماذج اللغة . preprint 2022.3

Xuezhi Wang ، Jason Wei ، Dale Schuurmans ، Quoc LE ، Ed Chi ، Denny Zhou . [PDF]

النجمة: العقلاني الذي يدرس ذاتيا بوتستسترنزي مع المنطق . preprint 2022.3

إريك زيليكمان ، يوهواي وو ، نوح د. غودمان . [PDF]

التعميم القياسي عبر تعليمات داخل السياق على 1600+ مهام لغوية . preprint 2022.4

Yizhong Wang ، Swaroop Mishra ، Pegah Alipoormolabashi ، Yeganeh Kordi ، Amirreza Mirzaei ، Anjana Arunkumar ، Arjun Ashok ، Arut Selvan Dhanasekaran ، Atharva Naik ، David Stap ، Eshaan Pathak ، Giannis Karaman ، إيثاني موندال ، يعقوب أندرسون ، كيربي كوزنيا ، كريما دوشي ، ميتريا باتيل ، كونال كومار بال ، مهراد موراشاهي ، ميهير بارمار ، ميرالي بوروهيت ، نيراج فارشني ، فاني روهيثا كازا ، بولكيت ، سامبات ، سافان دوشي ، سيدهارثا ميشرا ، سوجان ريدي ، سومانتا باتو ، تاناي ديكسيت ، Xudong شين ، تشيتا بارال ، ياجين تشوي ، نوح أ . [PDF] [رمز]

هل يمكن أن تتعلم نماذج اللغة من التفسيرات في السياق؟ . preprint 2022.4

Andrew K. Lampinen ، Ishita Dasgupta ، Stephanie Cy Chan ، Kory Matthewson ، Michael Henry Tessler ، Antonia Creswell ، James L. McClelland ، Jane X. Wang ، Felix Hill . [PDF]

ملصقات الحقيقة الأرضية: نظرة أعمق في مظاهرات تسمية المدخلات . preprint 2022.5

Junyeob Kim ، Hyuhng Joon Kim ، Hyunso Cho ، Hwiyeol Jo ، Sang-Woo Lee ، Sang-Goo Lee ، Kang Min Yoo ، Taeuk Kim . [PDF]

عدم موثوقية التفسيرات في التعلم في السياق . preprint 2022.5

الحادي عشر يي ، جريج دوريت . [PDF]

يتيح المطالبة الأقل من أن تتيح التفكير المعقد في نماذج اللغة الكبيرة . preprint 2022.5

ديني تشو ، ناثانيل شرلي ، لو هو ، جيسون وي ، ناثان سكاليس ، Xuezhi Wang ، Dale Schuurmans ، Olivier Bousquet ، Quoc LE ، Ed Chi . [PDF]

المطالبة الوهمية: التفكير المتسق منطقيا مع التفسيرات العودية . preprint 2022.5

Jaehun Jung ، Lianhui Qin ، Sean Welleck ، Faeze Brahman ، Chandra Bhagavatula ، Ronan Le Bras ، Yejin Choi . [PDF]

على تقدم جعل نماذج اللغة أفضل . preprint 2022.6

Yifei Li ، Zeqi Lin ، Shizhuo Zhang ، Qiang Fu ، Bei Chen ، Jian-Guang Lou ، Weizhu Chen . [PDF] [رمز]

القدرات الناشئة لنماذج اللغة الكبيرة . preprint 2022.6

جيسون وي ، يي تاي ، ريشي بوماساني ، كولين رافيل ، باريت زوف ، سيباستيان بورجيود ، داني يوجاتاما ، مارتن بوسما ، ديني تشو ، دونالد ميتزلر ، إد هـ. تشي ، تاتسونوري هاشيموتو ، أوريول فينالس ، بيرسي ليانج ، جيف ديان . [PDF]

نماذج اللغة هي واجهات للأغراض العامة . preprint 2022.6

Yaru Hao ، Haoyu Song ، Li Dong ، Shaohan Huang ، Zewen Chi ، Wenhui Wang ، Shuming MA ، Furu Wei . [PDF] [رمز]

ما الذي يمكن أن تتعلمه المحولات داخل السياق؟ دراسة حالة لفئات الوظائف البسيطة . preprint 2022.8

شيفام جارج ، ديميتريس تسيبراس ، بيرسي ليانغ ، غريغوري فاليانت . [PDF] [رمز]

التعلم عن طريق تقطير السياق . preprint 2022.9

تشارلي سنيل ، دان كلاين ، رويكي تشونغ . [PDF]

نماذج لغة ملزمة باللغات الرمزية . preprint 2022.10

Zhoujun Cheng*، Tianbao Xie*، Peng Shi ، Chengzu Li ، Rahul Nadkarni ، Yushi Hu ، Caiming Xiong ، Dragomir Radev ، Mari Ostendorf ، Luke Zettlemoyer ، Noah A. Smith ، Tao Yu . [PDF] [رمز] [موقع ويب]

الحفاظ على القدرة التعليمية في السياق في نموذج اللغة الكبيرة . preprint 2022.11

Yihan Wang ، Si Si ، Daliang Li ، Michal Lukasik ، Felix Yu ، Cho-Jui Hsieh ، Inderjit S Dhillon ، Sanjiv Kumar . [PDF]

تدريس التفكير الخوارزمي عبر التعلم داخل السياق . preprint 2022.11

هاتي تشو ، أزاد نوفا ، هوغو لاروشيل ، آرون كورفيل ، بهنام نايشابور ، هاني سيدغي . [PDF]

ما هي خوارزمية التعلم التي تتعلم في السياق؟ التحقيقات مع النماذج الخطية . preprint 2022.11

Ekin Akyürek ، Dale Schuurmans ، Jacob Andreas ، Tengyu MA ، Denny Zhou . [PDF]

ضبط الصندوق الأسود لنظام اللغة كخدمة . ICML 2022

Tianxiang Sun ، Yunfan Shao ، Hong Qian ، Xuanjing Huang ، Xipeng Qiu. [PDF] [رمز]

التعلم السريع في صندوق الأسود لنماذج اللغة التي تم تدريبها مسبقًا . TMLR 2023.2

Shizhe Dio ، Xuechun Li ، Yong Lin ، Zhichao Huang ، Tong Zhang . [PDF]

Grips: البحث عن تعليمات خالية من التدرج ، والتحرير عن حث نماذج لغة كبيرة . preprint 2022.3

Archiki Prasad ، Peter Hase ، Xiang Zhou ، Mohit Bansal . [PDF] [رمز]

القليل من اللقطة التي تدفع نحو توليد استجابة يمكن السيطرة عليها . preprint 2022.6

Hsuan Su ، Pohan Chi ، Shih-Cheng Huang ، Chung Ho Lam ، Saurav Sahay ، Shang-Tse Chen ، Hung-Yi Lee . [PDF]

BBTV2: نحو مستقبل خالي من التدرج مع نماذج لغة كبيرة . EMNLP 2022

Tianxiang Sun ، Zhengfu He ، Hong Qian ، Yunhua Zhou ، Xuanjing Huang ، Xipeng Qiu . [PDF] [رمز]

RLPrompt: تحسين النص المنفصل يطالب بتعلم التعزيز . EMNLP 2022

Mingkai Deng ، Jianyu Wang ، Cheng-Ping Hsieh ، Yihan Wang ، Han Guo ، Tianmin Shu ، Meng Song ، Eric P. Xing ، Zhiting Hu . [PDF] [رمز]

صرف المقطع: نحو التعلم السريع الخالي من المشتقات مع مزيج من المكافآت . نتائج EMNLP 2022

Yekun Chai ، Shuohuan Wang ، Yu Sun ، Hao Tian ، Hua Wu ، Haifeng Wang . [PDF]

بيغا: التحرير المطري وقت اختبار عبر التعلم التعزيز . preprint 2022.11

Tianjun Zhang ، Xuezhi Wang ، Denny Zhou ، Dale Schuurmans ، Joseph E. Gonzalez. [PDF] [رمز]

Promsboosting: تصنيف نص صندوق الأسود مع عشرة تمريرات للأمام . preprint 2022.12

بيرو هو ، جو أوكونور ، يعقوب أندرياس ، شيو تشانغ ، يانغ تشانغ . [PDF]

تعدد المهام قبل التدريب لمطالبة معيارية للتعلم الصيني القليلة . ACL 2023

Tianxiang Sun ، Zhengfu He ، Qin Zhu ، Xipeng Qiu ، Xuanjing Huang . [PDF]

عندما يلتقي هبوط التدرج بالتحسين الخالي من المشتقات: تطابق مصنوع في سيناريو الصندوق الأسود . ACL 2023

Chengcheng Han ، Liqing Cui ، Renyu Zhu ، Jianing Wang ، Nuo Chen ، Qiushi Sun ، Xiang Li ، Ming Gao . [PDF]

اجعل ضبط الصندوق الأسود المستند إلى المطالبة ملونة: تعزيز تعميم نموذج من ثلاثة وجهات نظر متعامدة . LREC-COLING 2024

Qiushi Sun ، Chengcheng Han ، Nuo Chen ، Renyu Zhu ، Jingyang Gong ، Xiang Li ، Ming Gao . [PDF]

لضبط أم لا لضبط؟ تكييف تمثيلات ما قبله مع مهام متنوعة . REPL4NLP@ACL 2019

ماثيو إي بيترز ، سيباستيان رودر ، نوح أ. سميث . [PDF]

هل يمكن أن تكون التفسيرات مفيدة لمعايرة نماذج الصندوق الأسود؟ ACL 2022

الحادي عشر يي ، جريج دوريت . [PDF] [رمز]

يعمل التدريب المشترك على تحسين التعلم القائم على النماذج اللغوية الكبيرة . ICML 2022

هانتر لانج ، مونيكا أغراوال ، يون كيم ، ديفيد سونتاج . [PDF]

Y-Tuning: نموذج ضبط فعال للنماذج التي تم تدريبها مسبقًا على نطاق واسع عبر تعلم تمثيل الملصقات . preprint 2022.2

Yitao Liu ، Chenxin AN ، Xipeng Qiu . [PDF]

LST: صقل سلم جانبي للمعلمة والذاكرة التعلم النقل الفعال . Neupips 2022

يي لين سونغ ، جايمن تشو ، موهيت بانسال . [PDF] [رمز]

ضبط وحدة فك التشفير: فهم اللغة الفعالة على أنه فك التشفير . preprint 2022.12

Ganqu Cui ، Wentao Li ، Ning Ding ، Longtao Huang ، Zhiyuan Liu ، Maosong Sun. [PDF]

توليد مجموعات البيانات مع نماذج اللغة المسبق . EMNLP 2021

تيمو شيك ، هينريش شوتز . [PDF] [رمز]

GPT3MIX: الاستفادة من نماذج اللغة واسعة النطاق لزيادة النص . نتائج EMNLP 2021

Kang Min Yoo ، Dongju Park ، Jawook Kang ، Sang-Woo Lee ، Woomyeong Park . [PDF] [رمز]

ولدت المعرفة التي تدفع للمنطق المنطقي . ACL 2022

Jiacheng Liu ، Alisa Liu ، Ximing Lu ، Sean Welleck ، Peter West ، Ronan Le Bras ، Yejin Choi ، Hannaneh Hajishirzi . [PDF] [رمز]

ZEROGEN: التعلم الصفري الفعال من خلال توليد مجموعة البيانات . EMNLP 2022

Jiacheng Ye ، Jiahui Gao ، Qintong Li ، Hang Xu ، Jiangtao Feng ، Zhiyong Wu ، Tao Yu ، Lingpeng Kong . [PDF] [رمز]

Zerogen+: توليد بيانات عالي الجودة الموجهة ذاتيًا في التعلم الفعال الصفري . preprint 2022.2

Jiahui Gao ، Renjie Pi ، Yong Lin ، Hang Xu ، Jiacheng Ye ، Zhiyong Wu ، Xiaodan Liang ، Zhenguo Li ، Lingpeng Kong . [PDF]

Augesc: زيادة الحوار مع نماذج اللغة الكبيرة لمحادثة الدعم العاطفي . نتائج ACL 2023

Chujie Zheng ، Sahand Sabour ، Jiaxin Wen ، Zheng Zhang ، Minlie Huang . [PDF]

توليد بيانات التدريب مع نماذج اللغة: نحو فهم لغة الصفر . Neupips 2022

Yu Meng ، Jiaxin Huang ، Yu Zhang ، Jiawei Han [PDF] [Code]

؟ أولا ، شكرا لأخذ الوقت للمساهمة! ؟

خطوات للمساهمة:

PaperNumber في الجزء العلوي من الصفحة وفقًا لذلك وأرسل طلب السحب الخاص بك. نوصي بإعطاء شرح موجز للغاية لماذا تعتقد أنه يجب إضافة ورقة أو تغييرها.لا تقلق إذا وضعت شيئًا خاطئًا ، فسوف نصلحها لك. فقط المساهمة وترويج عملك الرائع هنا!

بالإضافة إلى المساهمين التاليين الذين قدموا طلبات السحب ، نود أيضًا أن نشكر Ohad Rubin و Kang Min Yoo على التوصية بالأوراق.