سيشرح لك محرر Downcodes أحدث نتائج الأبحاث من جامعة برينستون وجامعة ييل! يستكشف هذا البحث بعمق قدرات الاستدلال "لسلسلة الفكر (CoT)" لنماذج اللغة الكبيرة (LLM)، ويكشف أن استدلال CoT ليس تطبيقًا بسيطًا للقواعد المنطقية، ولكنه اندماج معقد لعوامل متعددة مثل الذاكرة والاحتمال والدقة. منطق الضوضاء. اختار الباحثون مهمة فك تشفير التحول وأجروا تحليلًا متعمقًا لثلاثة ماجستير في القانون: GPT-4 وClaude3 وLlama3.1، وأخيرًا، اكتشفوا ثلاثة عوامل رئيسية تؤثر على تأثير استدلال CoT، واقترحوا آلية الاستدلال في LLM. رؤى جديدة.

أصدر باحثون من جامعة برينستون وجامعة ييل مؤخرًا تقريرًا عن قدرات الاستدلال "سلسلة الفكر (CoT)" لنماذج اللغة الكبيرة (LLM)، وكشفوا سر استدلال CoT: فهو ليس تفكيرًا رمزيًا بحتًا يعتمد على قواعد منطقية، ولكنه فهو يجمع بين عوامل متعددة مثل الذاكرة والاحتمال والتفكير في الضوضاء.

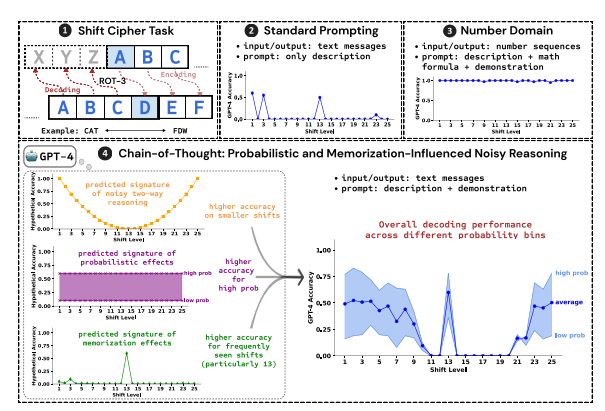

استخدم الباحثون فك تشفير التحول كمهمة اختبارية وقاموا بتحليل أداء ثلاثة ماجستير في إدارة الأعمال: GPT-4، وClaude3، وLlama3.1. تشفير التحول هو ترميز بسيط يتم فيه استبدال كل حرف بحرف يتم إزاحته للأمام بعدد محدد من الأماكن في الأبجدية. على سبيل المثال، حرك الحروف الأبجدية للأمام 3 أماكن، وسيصبح CAT FDW.

تظهر نتائج البحث أن العوامل الرئيسية الثلاثة التي تؤثر على تأثير تفكير CoT هي:

احتمالية: تفضل LLM إنشاء مخرجات ذات احتمالية أعلى، حتى لو كانت خطوات الاستدلال تؤدي إلى إجابات ذات احتمالية أقل. على سبيل المثال، إذا كانت خطوة الاستدلال تشير إلى STAZ، ولكن STAY هي كلمة أكثر شيوعًا، فقد تقوم LLM "بالتصحيح الذاتي" وإخراج STAY.

الذاكرة: تتذكر LLM كمية كبيرة من البيانات النصية أثناء التدريب المسبق، مما يؤثر على دقة استنتاج CoT الخاص بها. على سبيل المثال، يعد rot-13 هو أكثر تشفير الإزاحة شيوعًا، كما أن دقة LLM في rot-13 أعلى بكثير من الأنواع الأخرى من تشفير الإزاحة.

استدلال الضوضاء: عملية الاستدلال في LLM ليست دقيقة تمامًا، ولكن هناك درجة معينة من الضوضاء. مع زيادة مقدار التحول في تشفير التحول، تزداد أيضًا الخطوات الوسيطة المطلوبة لفك التشفير، ويصبح تأثير استنتاج الضوضاء أكثر وضوحًا، مما يؤدي إلى انخفاض دقة LLM.

وجد الباحثون أيضًا أن استدلال CoT الخاص بـ LLM يعتمد على التكييف الذاتي، أي أن LLM يحتاج إلى إنشاء نص بشكل صريح كسياق لخطوات الاستدلال اللاحقة. إذا تم توجيه LLM إلى "التفكير بصمت" دون إخراج أي نص، فإن قدرته على التفكير تنخفض بشكل كبير. بالإضافة إلى ذلك، فإن فعالية خطوات العرض التوضيحي لها تأثير ضئيل على استدلال CoT. حتى لو كانت هناك أخطاء في خطوات العرض التوضيحي، فإن تأثير استدلال CoT لـ LLM يمكن أن يظل مستقرًا.

توضح هذه الدراسة أن استدلال CoT الخاص بـ LLM ليس تفكيرًا رمزيًا مثاليًا، ولكنه يتضمن عوامل متعددة مثل الذاكرة والاحتمالية واستدلال الضوضاء. يُظهر LLM خصائص كل من الذاكرة الرئيسية والاحتمالية الرئيسية أثناء عملية التفكير في CoT. يساعدنا هذا البحث على اكتساب فهم أعمق لقدرات LLM الاستدلالية ويوفر رؤى قيمة لتطوير أنظمة ذكاء اصطناعي أكثر قوة في المستقبل.

عنوان الورقة: https://arxiv.org/pdf/2407.01687

يوفر هذا التقرير البحثي مرجعًا قيمًا لنا لفهم آلية التفكير "لسلسلة التفكير" لنماذج اللغة الكبيرة، كما يوفر أيضًا اتجاهًا جديدًا لتصميم أنظمة الذكاء الاصطناعي المستقبلية وتحسينها. سيستمر محرر Downcodes في الاهتمام بالتطورات المتطورة في مجال الذكاء الاصطناعي وسيقدم لك محتوى أكثر إثارة!