أثار أحدث نموذج للذكاء الاصطناعي من OpenAI "o1-preview" (الذي كان يحمل الاسم الرمزي سابقًا "Strawberry") مناقشات ساخنة. ادعى OpenAI أن قدراته كانت جيدة مثل قدرات طالب الدكتوراه، ولكن في الاختبارات الفعلية أظهرت أخطاء مخيبة للآمال. سيأخذك محرر Downcodes إلى فهم متعمق لنموذج الذكاء الاصطناعي المرتقب ولكنه مثير للمشاكل لمعرفة المستوى الذي وصل إليه والتعليقات الحقيقية من المستخدمين.

أطلقت OpenAI مؤخرًا نموذج الذكاء الاصطناعي الذي طال انتظاره، والذي كان يحمل الاسم الرمزي "الفراولة" سابقًا والمسمى رسميًا "o1-preview".

يعد OpenAI بأن النموذج الجديد سوف يؤدي أداءً مماثلاً لطالب الدكتوراه في المهام القياسية الصعبة في الفيزياء والكيمياء والأحياء. ومع ذلك، تظهر نتائج الاختبار الأولية أن هذا الذكاء الاصطناعي لا يزال بعيدًا عن هدفه المتمثل في استبدال العلماء أو المبرمجين البشريين.

وعلى وسائل التواصل الاجتماعي، شارك العديد من المستخدمين تجاربهم في التفاعل مع الذكاء الاصطناعي "OpenAI o1"، وأظهرت النتائج أن النموذج لا يزال يؤدي أداءً ضعيفًا في المهام الأساسية.

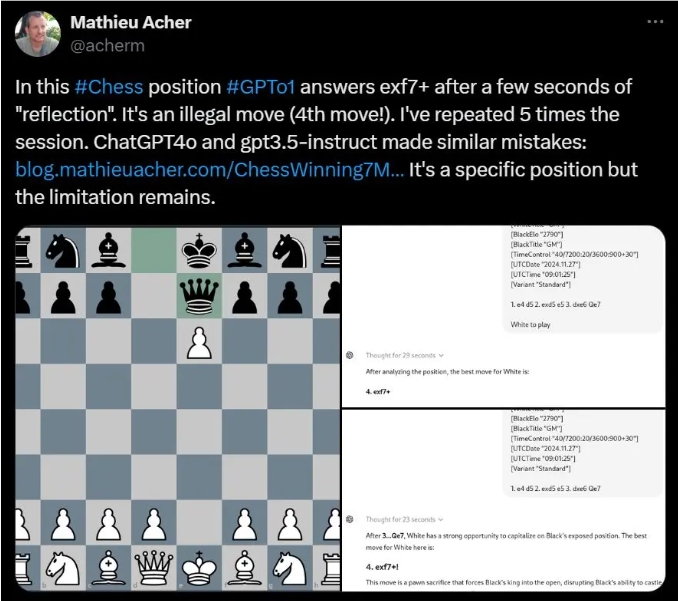

على سبيل المثال، وجد ماتيو آشر، الباحث في INSA Rennes، أن OpenAI o1 يقترح في كثير من الأحيان تحركات غير قانونية عند حل بعض ألغاز الشطرنج.

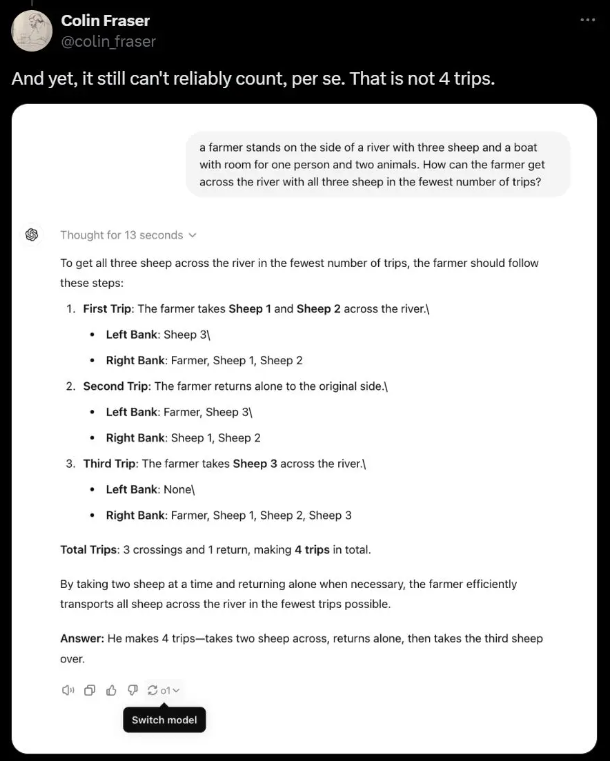

أشار عالم ميتا آي آي كولين فريزر إلى أنه في لغز كلمات بسيط حول المزارعين الذين ينقلون الأغنام عبر النهر، تخلى الذكاء الاصطناعي في الواقع عن الإجابة الصحيحة وقدم بدلاً من ذلك بعض الهراء غير المنطقي.

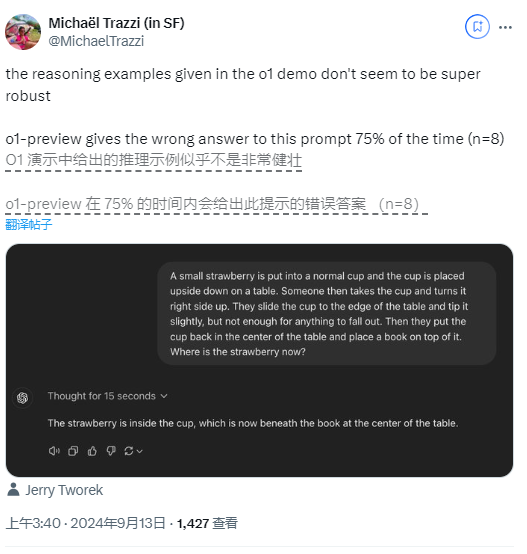

حتى في اللغز المنطقي الذي استخدمته OpenAI كعرض توضيحي، أدت الأسئلة المتعلقة بالفراولة إلى حصول المستخدمين على إجابات مختلفة، حيث وجد أحد المستخدمين أن النموذج به معدل خطأ يصل إلى 75%.

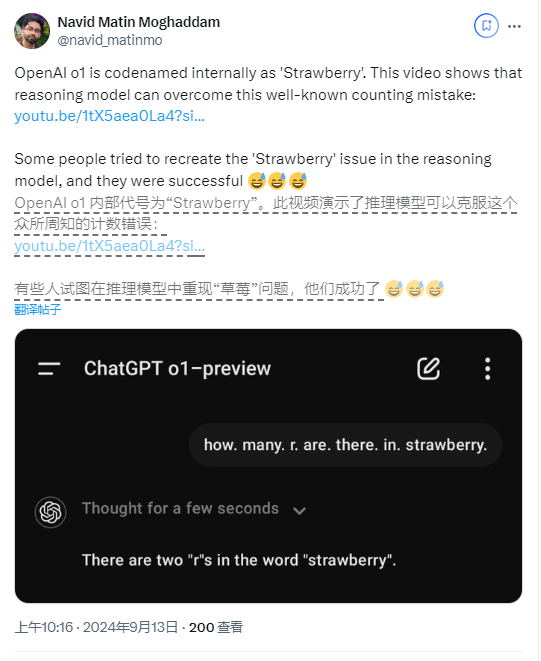

ليس هذا فحسب، بل أبلغ بعض المستخدمين أن النموذج الجديد يرتكب أخطاء عند حساب عدد مرات ظهور الحرف "R" في كلمة "الفراولة".

على الرغم من أن OpenAI ذكرت في وقت الإصدار أن هذا كان نموذجًا مبكرًا ولم يكن لديه بعد ميزات مثل تصفح الويب وتحميل الملفات، إلا أن مثل هذه الأخطاء الأساسية لا تزال مثيرة للدهشة.

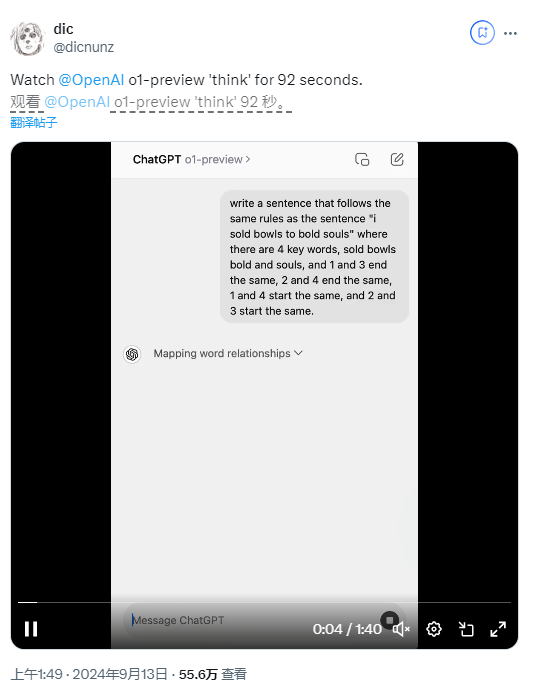

من أجل التحسين، قدمت OpenAI عملية "سلسلة التفكير" في النموذج الجديد، مما يجعل OpenAI o1 مختلفًا بشكل كبير عن نموذج GPT-4o السابق. يسمح هذا الأسلوب للذكاء الاصطناعي بالتفكير مرارًا وتكرارًا قبل الوصول إلى إجابة، على الرغم من أن هذا يؤدي أيضًا إلى أوقات استجابة أطول.

واكتشف بعض المستخدمين أن النموذج استغرق في الواقع 92 ثانية للإجابة على لغز الكلمات، لكن النتيجة ظلت خاطئة.

قال نوام براون، عالم الأبحاث في OpenAI، إنه على الرغم من أن سرعة الاستجابة الحالية بطيئة، إلا أنهم يتوقعون أن تفكر الإصدارات المستقبلية لفترة أطول، بل وتقدم رؤى جديدة حول المشكلات الخارقة.

ومع ذلك، فإن الناقد الشهير للذكاء الاصطناعي غاري ماركوس يشكك في هذا ويعتقد أن المعالجة طويلة المدى لا تؤدي بالضرورة إلى قدرات تفكير متسامية. وأكد أنه على الرغم من التطور المستمر لتكنولوجيا الذكاء الاصطناعي، إلا أن الأبحاث والتجارب الواقعية لا تزال لا غنى عنها.

يمكن ملاحظة أنه في الاستخدام الفعلي، لا يزال أداء نموذج الذكاء الاصطناعي الجديد الخاص بـ OpenAI مخيبًا للآمال من جميع الجوانب، وقد أثار هذا أيضًا مناقشات حول التطوير المستقبلي لتكنولوجيا الذكاء الاصطناعي.

تسليط الضوء على:

أطلقت OpenAI مؤخرًا نموذجًا جديدًا للذكاء الاصطناعي "الفراولة"، مدعيًا أنه يمكن مقارنته بطلاب الدكتوراه في المهام المعقدة.

ووجد العديد من المستخدمين أن الذكاء الاصطناعي يرتكب أخطاء متكررة في المهام الأساسية، مثل القيام بحركات غير قانونية والإجابة على الألغاز البسيطة بشكل غير صحيح.

تعترف OpenAI بأن النموذج لا يزال قيد التطوير، لكن التفكير لفترة طويلة قد لا يحسن قدرات التفكير، ولا تزال العديد من المشكلات الأساسية دون حل.

بشكل عام، على الرغم من أن نموذج "o1-preview" الخاص بـ OpenAI يُظهر إمكانات تطوير تكنولوجيا الذكاء الاصطناعي، فإنه يكشف أيضًا عن العديد من أوجه القصور في تطبيقه العملي. في المستقبل، لا يزال تطوير نماذج الذكاء الاصطناعي بحاجة إلى تحقيق التوازن بين التحسين التقني والتطبيق العملي من أجل تحقيق أهدافه المتوقعة حقًا. سيستمر محرر Downcodes في الاهتمام بالاتجاهات في مجال الذكاء الاصطناعي وسيقدم لك المزيد من التقارير المثيرة.