تعد القدرة الاستدلالية لنماذج اللغات الكبيرة (LLMs) نقطة بحثية ساخنة في مجال الذكاء الاصطناعي. نشر فريق أبحاث الذكاء الاصطناعي التابع لشركة Apple مؤخرًا ورقة بحثية تكشف عن القيود المفروضة على ماجستير إدارة الأعمال في التفكير الرياضي. سيقوم محرر Downcodes بتفسير المحتوى الرئيسي للورقة وتحليل تأثيرها على تطوير تكنولوجيا الذكاء الاصطناعي.

في عالم الذكاء الاصطناعي، كانت القدرات المنطقية لنماذج التعلم الآلي، وخاصة نماذج اللغات الكبيرة (LLMs)، دائمًا محور اهتمام العلماء.

ومؤخرًا، نشر فريق أبحاث الذكاء الاصطناعي التابع لشركة Apple ورقة بحثية بعنوان "فهم حدود النماذج اللغوية الكبيرة في الاستدلال الرياضي"، والتي كشفت عن حدود هذه النماذج في التعامل مع المشكلات المنطقية.

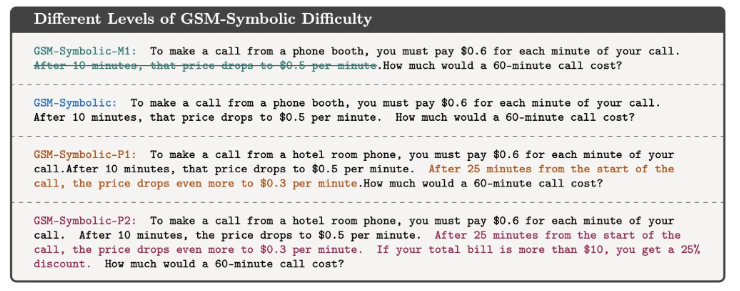

وفي هذه الورقة، يوضح الباحثون ذلك من خلال مسألة رياضية بسيطة. لقد طرحوا أولاً سؤالاً حول قطف أوليفر للكيوي:

كما هو موضح أدناه:

قطف أوليفر 44 ثمرة كيوي يوم الجمعة. وفي يوم السبت قطف 58 ثمرة كيوي أخرى. وفي يوم الأحد قام بقطف ضعف عدد الكيوي الذي التقطه في يوم الجمعة. كم عدد الكيوي الذي يمتلكه أوليفر إجمالاً؟

من الواضح أن الإجابة هي 44+58+ (44*2) =190. على الرغم من أن النماذج اللغوية الكبيرة ليست في الواقع مثالية رياضيًا، إلا أنها تستطيع حل مسائل مثل هذه بشكل موثوق إلى حد ما.

لكن إذا أضفت بعض المعلومات غير ذات الصلة لملاحظة استجابة النموذج، مثل:

قطف أوليفر 44 ثمرة كيوي يوم الجمعة. وفي يوم السبت اختار 58 آخرين. وفي يوم الأحد، قطف ضعف عدد حبات الكيوي التي قطفها في يوم الجمعة، لكن خمسة منها كانت أصغر قليلًا من المتوسط. كم عدد الكيوي الذي يمتلكه أوليفر؟

على الرغم من أن هذا لا يغير الطبيعة الرياضية للمشكلة، إلا أنه حتى طلاب ماجستير القانون المتطورين يقدمون إجابات خاطئة في ظل هذا الاضطراب البسيط. على سبيل المثال، قام GPT-o1-mini بطرح 5 حبات كيوي صغيرة بشكل غير صحيح من إجمالي عدد حبات الكيوي التي تم قطفها يوم الأحد.

تظهر هذه التجربة أنه على الرغم من أن ماجستير إدارة الأعمال يمكن أن يعطي الإجابة الصحيحة في بعض الحالات، إلا أنهم لا يفهمون حقًا طبيعة المشكلة.

يعتقد الباحثون أن أنماط فشل هذه النماذج تشير إلى أنها لا تؤدي تفكيرًا منطقيًا حقيقيًا ولكنها تكرر خطوات التفكير التي لاحظوها في بيانات التدريب. يبدو الأمر كما لو كان برنامج LLM قادرًا على حساب أن عبارة "أنا أحبك" تتبعها عادةً عبارة "أنا أحبك أيضًا"، لكن هذا لا يعني أنه يفهم حقًا معنى الحب.

وقام مهرداد فرجتابار، أحد المؤلفين المشاركين في الدراسة، بشرح النتائج على وسائل التواصل الاجتماعي. ويشير إلى أنه في حين أنه من الممكن تحسين أداء النموذج في بعض الحالات البسيطة من خلال هندسة تلميحات أفضل، فقد يحتاج النموذج بالنسبة للاضطرابات المعقدة إلى مزيد من البيانات السياقية للتعامل معها بشكل صحيح، وقد لا يكون من الممكن لطفل صغير التعامل معها على الإطلاق. ليست مشكلة.

تذكرنا هذه الدراسة أنه على الرغم من تفوق طلاب ماجستير اللغة في معالجة اللغة، إلا أن قدراتهم في التفكير المنطقي لا تزال محدودة. هذا ليس مجرد سؤال أكاديمي، فمع تحول تكنولوجيا الذكاء الاصطناعي إلى جزء متزايد من حياتنا اليومية، أصبحت الإجابات على هذه الأسئلة ذات أهمية متزايدة.

لا يمكننا أن نفترض ببساطة أن الذكاء الاصطناعي يمكنه فهم المهام المعقدة وتنفيذها، ولكن يجب أن يكون لديه فهم أعمق لكيفية عملها وقيودها. يزودنا هذا البحث بفهم أعمق لتقنيات الذكاء الاصطناعي، بينما يقدم أيضًا رؤى قيمة حول كيفية استخدامنا لهذه التقنيات وتطويرها.

المرجع: https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

بشكل عام، يسلط بحث فريق Apple الضوء على القيود التي تواجهها نماذج اللغات الكبيرة في التفكير المنطقي، مما يذكرنا بأننا بحاجة إلى توخي الحذر بشأن قدرات الذكاء الاصطناعي ومواصلة الاهتمام باتجاه تطويره لتجنب الاعتماد المفرط على قدراته. في المستقبل، نحتاج إلى دراسة أعمق لكيفية تحسين القدرات الاستدلالية لطلاب ماجستير القانون حتى يتمكنوا من فهم جوهر المشكلة حقًا بدلاً من مجرد تقليد الأنماط الموجودة.