يقدم لك محرر Downcodes أخبارًا كبيرة! هناك عضو جديد في مجال الذكاء الاصطناعي - Zyphra أصدرت رسميًا نموذجها اللغوي الصغير Zamba2-7B! حقق هذا النموذج ذو الـ 7 مليار معلمة طفرة في الأداء، خاصة من حيث الكفاءة والقدرة على التكيف، مما أظهر مزايا مثيرة للإعجاب. إنه ليس مناسبًا لبيئات الحوسبة عالية الأداء فحسب، ولكن الأهم من ذلك، يمكن أن يعمل Zamba2-7B أيضًا على وحدات معالجة الرسومات المخصصة للمستهلك، مما يسمح لمزيد من المستخدمين بتجربة سحر تقنية الذكاء الاصطناعي المتقدمة بسهولة. سوف تتعمق هذه المقالة في ابتكارات Zamba2-7B وتأثيرها على مجال معالجة اللغة الطبيعية.

في الآونة الأخيرة، أطلقت Zyphra رسميًا Zamba2-7B، وهو نموذج لغة صغير بأداء غير مسبوق، مع وصول عدد المعلمات إلى 7B.

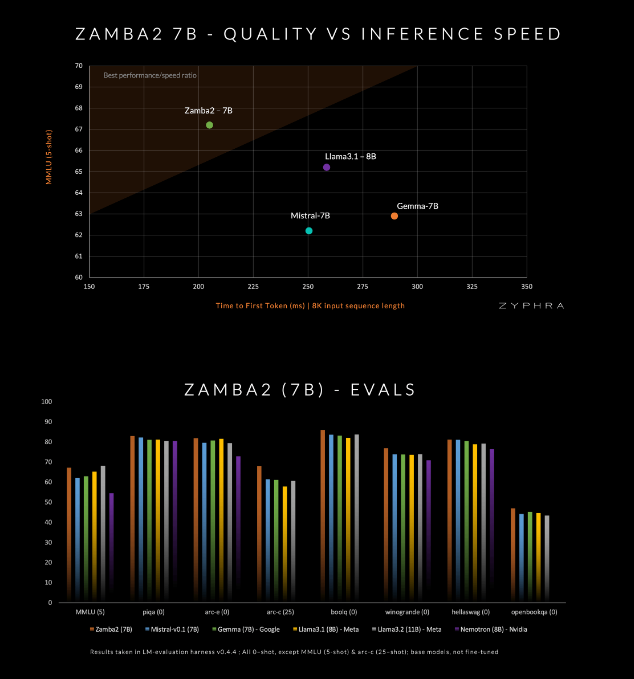

ويدعي هذا النموذج أنه يتفوق على المنافسين الحاليين من حيث الجودة والسرعة، بما في ذلك Mistral-7B، وGemma-7B من Google، وLlama3-8B من Meta.

تم تصميم Zamba2-7B لتلبية احتياجات البيئات التي تتطلب إمكانات معالجة لغوية قوية ولكنها محدودة بظروف الأجهزة، مثل المعالجة على الجهاز أو استخدام وحدات معالجة الرسومات على مستوى المستهلك. ومن خلال تحسين الكفاءة دون التضحية بالجودة، تأمل Zyphra في تمكين نطاق أوسع من المستخدمين، سواء كانوا من المؤسسات أو المطورين الأفراد، من الاستمتاع براحة الذكاء الاصطناعي المتقدم.

قام Zamba2-7B بالعديد من الابتكارات في هندسته المعمارية لتحسين كفاءة وقدرات التعبير للنموذج. يختلف Zamba2-7B عن نموذج الجيل السابق Zamba1، ويستخدم كتلتي اهتمام مشتركتين، ويمكن لهذا التصميم التعامل بشكل أفضل مع التبعيات بين تدفق المعلومات والتسلسلات.

تشكل كتلة Mamba2 جوهر البنية بأكملها، مما يجعل استخدام المعلمات للنموذج أعلى من نماذج المحولات التقليدية. بالإضافة إلى ذلك، تستخدم Zyphra أيضًا إسقاط التكيف منخفض المستوى (LoRA) على كتل MLP المشتركة، مما يعمل على تحسين القدرة على التكيف لكل طبقة مع الحفاظ على ضغط النموذج. بفضل هذه الابتكارات، تم تقليل وقت الاستجابة الأول لـ Zamba2-7B بنسبة 25%، وزاد عدد الرموز المميزة التي تتم معالجتها في الثانية بنسبة 20%.

تم التحقق من كفاءة Zamba2-7B وقدرته على التكيف من خلال اختبارات صارمة. تم تدريب النموذج مسبقًا على مجموعة بيانات ضخمة تحتوي على ثلاثة تريليونات رمز، وهي بيانات مفتوحة عالية الجودة ومفحوصة بدقة.

بالإضافة إلى ذلك، تقدم Zyphra أيضًا مرحلة ما قبل التدريب "التليين" التي تقلل بسرعة معدل التعلم لمعالجة الرموز عالية الجودة بشكل أكثر كفاءة. تسمح هذه الاستراتيجية لـZamba2-7B بأداء جيد في المعايير، والتفوق على المنافسين في سرعة الاستدلال والجودة، وهي مناسبة لمهام مثل فهم اللغة الطبيعية وتوليدها دون الحاجة إلى موارد الحوسبة الضخمة التي تتطلبها النماذج التقليدية عالية الجودة.

يمثل amba2-7B تقدمًا كبيرًا في نماذج اللغات الصغيرة، مع الحفاظ على الجودة العالية والأداء مع إيلاء اهتمام خاص لإمكانية الوصول. من خلال التصميم المعماري المبتكر وتكنولوجيا التدريب الفعالة، نجحت Zyphra في إنشاء نموذج ليس سهل الاستخدام فحسب، بل يمكنه أيضًا تلبية احتياجات معالجة اللغات الطبيعية المختلفة. يدعو الإصدار المفتوح المصدر لـ Zamba2-7B الباحثين والمطورين والشركات لاستكشاف إمكاناته ومن المتوقع أن يؤدي إلى تطوير معالجة متقدمة للغة الطبيعية داخل المجتمع الأوسع.

مدخل المشروع: https://www.zyphra.com/post/zamba2-7b

https://github.com/Zyphra/transformers_zamba2

جلب الإصدار المفتوح المصدر لـ Zamba2-7B حيوية جديدة إلى مجال معالجة اللغة الطبيعية ووفر المزيد من الإمكانيات للمطورين. ونحن نتطلع إلى استخدام Zamba2-7B على نطاق أوسع في المستقبل وتعزيز التقدم المستمر في تكنولوجيا الذكاء الاصطناعي!