سيأخذك محرر Downcodes للتعرف على الأبحاث الرائعة التي أجراها Google DeepMind: مزيج من الخبراء (MoE). لقد حقق هذا البحث تقدمًا ثوريًا في بنية المحولات. ويكمن جوهره في آلية استرجاع الخبراء ذات كفاءة المعلمات التي تستخدم تقنية مفتاح المنتج لموازنة التكلفة الحسابية وعدد المعلمات، وبالتالي تحسين إمكانات النموذج بشكل كبير مع الحفاظ على الكفاءة. لا يستكشف هذا البحث الإعدادات المتطرفة لوزارة التربية والتعليم فحسب، بل يثبت أيضًا لأول مرة أنه يمكن توجيه بنية مؤشر التعلم بشكل فعال إلى أكثر من مليون خبير، مما يوفر إمكانيات جديدة في مجال الذكاء الاصطناعي.

إن نموذج Mixture المكون من مليون خبير الذي اقترحته Google DeepMind هو بحث اتخذ خطوات ثورية في بنية Transformer.

تخيل نموذجًا يمكنه إجراء استرجاع متفرق من مليون خبير صغير. هل يبدو هذا مثل حبكة رواية خيال علمي؟ لكن هذا بالضبط ما تظهره أحدث أبحاث DeepMind. جوهر هذا البحث هو آلية استرجاع الخبراء ذات كفاءة المعلمات التي تستخدم تقنية مفتاح المنتج لفصل التكلفة الحسابية عن عدد المعلمات، وبالتالي إطلاق الإمكانات الأكبر لبنية المحولات مع الحفاظ على الكفاءة الحسابية.

أهم ما يميز هذا العمل هو أنه لا يستكشف إعدادات وزارة التربية والتعليم المتطرفة فحسب، بل يوضح أيضًا لأول مرة أنه يمكن توجيه بنية الفهرس المستفادة بكفاءة إلى أكثر من مليون خبير. وهذا يشبه العثور بسرعة على عدد قليل من الخبراء الذين يمكنهم حل المشكلة وسط حشد كبير من الناس، ويتم كل هذا في ظل فرضية تكاليف الحوسبة التي يمكن التحكم فيها.

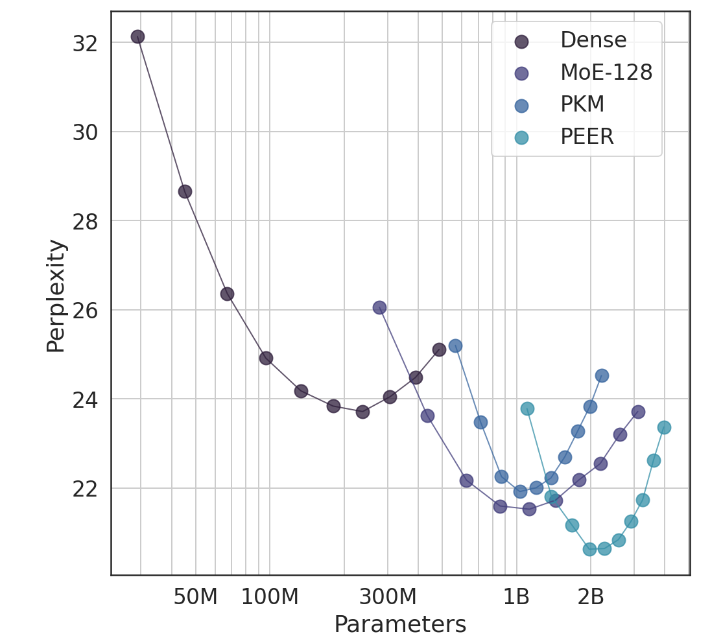

في التجارب، أظهرت بنية PEER أداءً حاسوبيًا فائقًا وكانت أكثر كفاءة من طبقات FFW الكثيفة، وMoE ذات الحبيبات الخشنة، وطبقات ذاكرة مفتاح المنتج (PKM). وهذا ليس انتصارا نظريا فحسب، بل هو أيضا قفزة هائلة في التطبيق العملي. من خلال النتائج التجريبية، يمكننا أن نرى الأداء المتفوق لـ PEER في مهام نمذجة اللغة، فهو لا يتمتع بدرجة أقل من الحيرة فحسب، بل أيضًا في تجربة الاجتثاث، من خلال ضبط عدد الخبراء وعدد الخبراء النشطين، وأداء PEER. تم تحسين النموذج بشكل ملحوظ.

مؤلف هذه الدراسة، شو هي (أوين)، هو عالم أبحاث في Google DeepMind، وقد أدى استكشافه الفردي بلا شك إلى اكتشافات جديدة في مجال الذكاء الاصطناعي. وكما أوضح، من خلال أساليب مخصصة وذكية، يمكننا تحسين معدلات التحويل بشكل كبير والاحتفاظ بالمستخدمين، وهو أمر مهم بشكل خاص في مجال AIGC.

عنوان الورقة: https://arxiv.org/abs/2407.04153

بشكل عام، توفر أبحاث النماذج الهجينة التي أجراها Google DeepMind أفكارًا جديدة لبناء نماذج لغوية واسعة النطاق، وتشير آلية استرجاع الخبراء الفعالة والنتائج التجريبية الممتازة إلى إمكانات كبيرة لتطوير نماذج الذكاء الاصطناعي في المستقبل. يتطلع محرر Downcodes إلى المزيد من نتائج الأبحاث الرائعة المماثلة!