أصدر مختبر شنغهاي للذكاء الاصطناعي أحدث إصدار من نموذج سلسلة Scholar Puyu، InternLM2.5، في المنتدى الرئيسي لـ WAIC Science Frontier في 4 يوليو 2024. تم تحسين قدرات الاستدلال لهذا الإصدار في السيناريوهات المعقدة بشكل كبير، وهو يدعم سياقًا طويل جدًا يبلغ 1 مليون، ويمكنه إجراء عمليات بحث على الإنترنت وتكامل المعلومات بشكل مستقل، وهو إنجاز كبير. سوف يشرح محرر Downcodes بالتفصيل الوظائف والمعلومات مفتوحة المصدر الخاصة بـ InterlLM2.5.

أطلق مختبر شنغهاي للذكاء الاصطناعي نسخة جديدة من نموذج سلسلة Scholar Puyu، InternLM2.5، في المنتدى الرئيسي لـ WAIC Science Frontier في 4 يوليو 2024. لقد تم تعزيز قدرات التفكير المنطقي لهذا الإصدار في السيناريوهات المعقدة بشكل شامل، وهو يدعم سياقًا طويل جدًا يبلغ مليونًا، ويمكنه إجراء عمليات بحث على الإنترنت بشكل مستقل ودمج المعلومات من مئات صفحات الويب.

أصدر InternLM2.5 ثلاثة إصدارات معلمات من النموذج، وهي 1.8B و7B و20B، للتكيف مع سيناريوهات التطبيقات المختلفة واحتياجات المطورين. يعد الإصدار 1.8B نموذجًا خفيف الوزن للغاية، بينما يوفر الإصدار 20B أداءً شاملاً أقوى ويدعم سيناريوهات عملية أكثر تعقيدًا. جميع هذه النماذج مفتوحة المصدر ويمكن العثور عليها على الصفحة الرئيسية للنماذج الكبيرة لسلسلة Scholar·Puyu، والصفحة الرئيسية لـ ModelScope، والصفحة الرئيسية لـ Hugging Face.

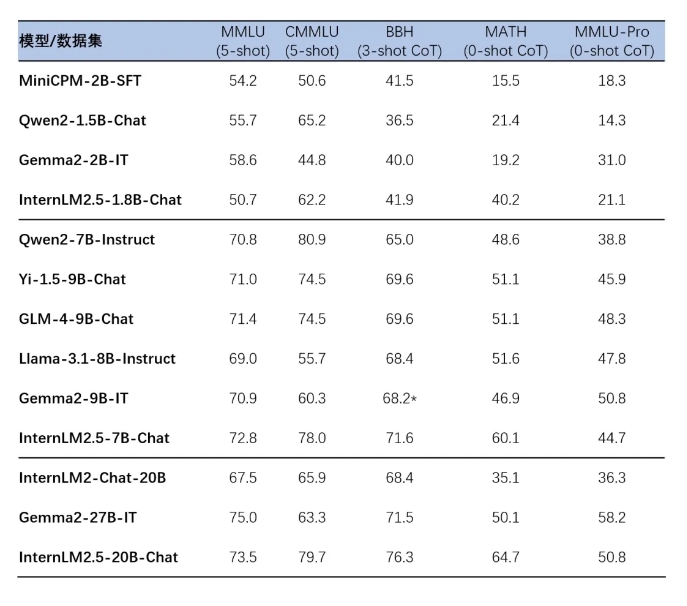

يتكرر برنامج InternLM2.5 على تقنيات متعددة لتركيب البيانات، مما يؤدي إلى تحسين كبير في قدرات الاستدلال للنموذج، وعلى وجه الخصوص، وصل معدل الدقة في مجموعة تقييم الرياضيات MATH إلى 64.7%. بالإضافة إلى ذلك، يعمل النموذج على تحسين قدرات معالجة طول السياق من خلال التدريب الفعال في مرحلة ما قبل التدريب.

تحقق نماذج سلسلة InternLM2.5 أيضًا تكاملًا سلسًا مع الاستدلال النهائي وأطر الضبط الدقيق، بما في ذلك إطار الضبط الدقيق XTuner وإطار الاستدلال LMDeploy الذي تم تطويره بشكل مستقل بواسطة مختبر شنغهاي للذكاء الاصطناعي، بالإضافة إلى أطر أخرى ذات قواعد مستخدمين واسعة النطاق في مجتمع مثل vLLM وOllama وllama.cpp. تدعم أداة SWIFT التي أطلقها مجتمع Moda أيضًا الاستدلال والضبط الدقيق ونشر نماذج سلسلة InternLM2.5.

تتضمن تجربة التطبيق لهذه النماذج التفكير المعقد متعدد الخطوات، والفهم الدقيق لنوايا المحادثة متعددة المنعطفات، وعمليات التحكم المرنة في التنسيق، والقدرة على اتباع التعليمات المعقدة. يتم توفير أدلة التثبيت والاستخدام التفصيلية لتسهيل على المطورين البدء بسرعة.

الصفحة الرئيسية للنموذج الكبير لسلسلة Scholar·Puyu:

https://internlm.intern-ai.org.cn

الصفحة الرئيسية لـ ModelScope:

https://www.modelscope.cn/organization/Shanghai_AI_Laboratory?tab=model

الصفحة الرئيسية للوجه المعانق:

https://huggingface.co/internlm

رابط InterLM2.5 مفتوح المصدر:

https://github.com/InternLM/InternLM

يوفر الإصدار المفتوح المصدر لـ InternLM2.5 إمكانيات جديدة للبحث والتطبيقات في مجال الذكاء الاصطناعي، ويُعتقد أن أدائه القوي وسهولة استخدامه سيجذب العديد من المطورين للاستكشاف والابتكار. يتطلع محرر Downcodes إلى رؤية المزيد من التطبيقات الممتازة المبنية على InternLM2.5!