أعلنت شركة علي بابا أنها ستفتح مصدر نموذج اللغة المرئية من الجيل الثاني Qwen2-VL وتوفر واجهات برمجة التطبيقات (API) وكود مفتوح المصدر لتسهيل استخدام المطورين. حقق النموذج تقدمًا كبيرًا في فهم الصور والفيديو، ويدعم لغات متعددة، ويتمتع بقدرات وكيل بصري قوية، وقادر على تشغيل الهواتف المحمولة والروبوتات بشكل مستقل. يوفر Qwen2-VL نماذج بثلاثة أحجام: 2B و7B و72B لتلبية احتياجات سيناريوهات التطبيق المختلفة. يعمل نموذج 72B بشكل أفضل على معظم المؤشرات، في حين أن نموذج 2B مناسب لتطبيقات الهاتف المحمول.

في 2 سبتمبر، أعلنت Tongyi Qianwen عن المصدر المفتوح لنموذج اللغة المرئية من الجيل الثاني Qwen2-VL، وأطلقت واجهات برمجة التطبيقات لأحجام 2B و7B ونموذج الإصدار الكمي الخاص بها على منصة Alibaba Cloud Bailian ليتمكن المستخدمون من الاتصال بها مباشرةً.

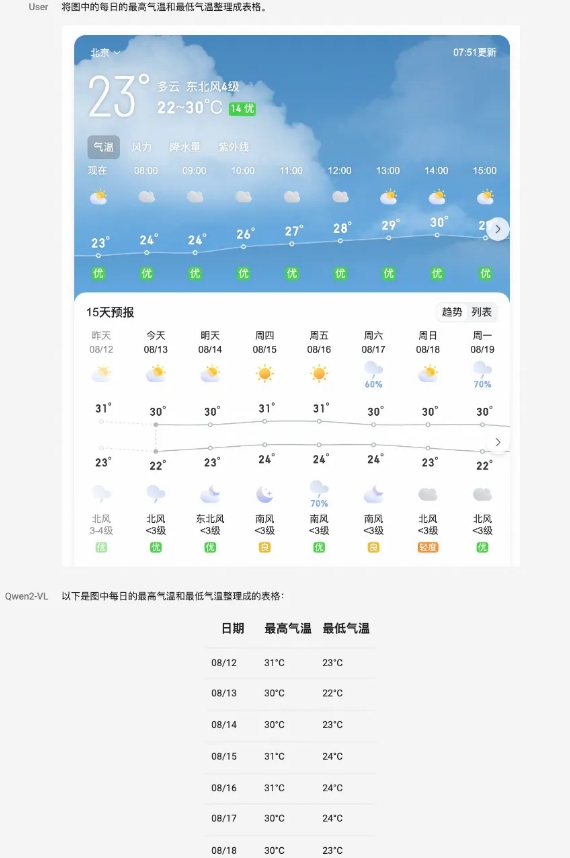

يحقق نموذج Qwen2-VL تحسينات شاملة في الأداء في جوانب متعددة. يمكنه فهم الصور ذات الدقة ونسب العرض إلى الارتفاع المختلفة، وقد حقق أداءً رائدًا عالميًا في الاختبارات المعيارية مثل DocVQA، وRealWorldQA، وMTVQA. بالإضافة إلى ذلك، يمكن للنموذج أيضًا فهم مقاطع الفيديو الطويلة التي تزيد مدتها عن 20 دقيقة ودعم تطبيقات الأسئلة والأجوبة والحوار وإنشاء المحتوى المستندة إلى الفيديو. يتمتع Qwen2-VL أيضًا بقدرات ذكاء بصري قوية ويمكنه تشغيل الهواتف المحمولة والروبوتات بشكل مستقل لأداء التفكير المعقد واتخاذ القرارات.

النموذج قادر على فهم النص متعدد اللغات في الصور ومقاطع الفيديو، بما في ذلك الصينية والإنجليزية ومعظم اللغات الأوروبية واليابانية والكورية والعربية والفيتنامية والمزيد. قام فريق Tongyi Qianwen بتقييم قدرات النموذج من ستة جوانب، بما في ذلك الأسئلة الجامعية الشاملة، والقدرة الرياضية، وفهم المستندات، والجداول، والنصوص والصور متعددة اللغات، والأسئلة والإجابة على المشهد العام، وفهم الفيديو، وقدرات الوكيل.

باعتباره النموذج الرئيسي، وصل Qwen2-VL-72B إلى المستوى الأمثل في معظم المؤشرات. يحقق Qwen2-VL-7B أداءً تنافسيًا للغاية بفضل مقياس المعلمات الاقتصادي الخاص به، بينما يدعم Qwen2-VL-2B تطبيقات الهاتف المحمول الغنية ويتمتع بقدرات كاملة على فهم الصور والفيديو متعدد اللغات.

فيما يتعلق ببنية النموذج، يواصل Qwen2-VL هيكل سلسلة ViT plus Qwen2. تستخدم جميع الأحجام الثلاثة للنماذج 600M ViT، مما يدعم الإدخال الموحد للصور ومقاطع الفيديو. من أجل تحسين إدراك النموذج للمعلومات المرئية وقدرات فهم الفيديو، قام الفريق بترقية البنية، بما في ذلك تنفيذ الدعم الكامل للدقة الديناميكية الأصلية واستخدام طريقة تضمين موضع التدوير متعدد الوسائط (M-ROPE).

توفر منصة Alibaba Cloud Bailian واجهة برمجة تطبيقات Qwen2-VL-72B، والتي يمكن للمستخدمين الاتصال بها مباشرة. وفي الوقت نفسه، تم دمج التعليمات البرمجية مفتوحة المصدر لـ Qwen2-VL-2B وQwen2-VL-7B في Hugging Face Transformers وvLLM وأطر عمل الطرف الثالث الأخرى، ويمكن للمطورين تنزيل النماذج واستخدامها من خلال هذه الأنظمة الأساسية.

منصة علي بابا كلاود بيليان:

https://help.aliyun.com/zh/model-studio/developer-reference/qwen-vl-api

جيثب:

https://github.com/QwenLM/Qwen2-VL

وجه معانق:

https://huggingface.co/collections/Qwen/qwen2-vl-66cee7455501d7126940800d

نطاق النموذج السحري:

https://modelscope.cn/organization/qwen?tab=model

تجربة النموذج:

https://huggingface.co/spaces/Qwen/Qwen2-VL

باختصار، يوفر المصدر المفتوح لنموذج Qwen2-VL للمطورين أدوات قوية، ويعزز تطوير تقنية نماذج اللغة المرئية، ويوفر المزيد من الإمكانيات لسيناريوهات التطبيقات المختلفة. يمكن للمطورين الحصول على النموذج والكود من خلال الرابط المقدم للبدء في بناء تطبيقاتهم الخاصة.