أدى التطور السريع لنماذج اللغات الكبيرة (LLMs) إلى توفير قدرات مذهلة في معالجة اللغات الطبيعية، لكن متطلبات الحوسبة والتخزين الضخمة الخاصة بها تحد من شعبيتها. يتطلب تشغيل نموذج يحتوي على 176 مليار معلمة مئات الجيجابايت من مساحة التخزين والعديد من وحدات معالجة الرسومات المتطورة، مما يجعله مكلفًا وصعب التوسع. لحل هذه المشكلة، ركز الباحثون على تقنيات ضغط النماذج، مثل التكميم، لتقليل حجم النموذج ومتطلبات التشغيل، لكنهم يواجهون أيضًا خطر فقدان الدقة.

أصبح الذكاء الاصطناعي (AI) أكثر ذكاءً، وخاصةً نماذج اللغات الكبيرة (LLMs)، والتي تتميز بقدرتها المذهلة على معالجة اللغة الطبيعية. ولكن هل تعلم أن وراء أدمغة الذكاء الاصطناعي الذكية هذه، هناك حاجة إلى قوة حاسوبية ضخمة ومساحة تخزين لدعمها.

يتطلب نموذج Bloom متعدد اللغات الذي يحتوي على 176 مليار معلمة مساحة لا تقل عن 350 جيجابايت فقط لتخزين أوزان النموذج، ويتطلب أيضًا تشغيل العديد من وحدات معالجة الرسومات المتقدمة. وهذا ليس مكلفًا فحسب، بل يصعب أيضًا تعميمه.

ومن أجل حل هذه المشكلة، اقترح الباحثون تقنية تسمى "القياس الكمي". يشبه القياس الكمي "تقليص حجم" دماغ الذكاء الاصطناعي، من خلال تعيين أوزان النموذج وتنشيطه إلى تنسيق بيانات ذي أرقام أقل، فهو لا يقلل حجم النموذج فحسب، بل يؤدي أيضًا إلى تسريع سرعة تشغيل النموذج. لكن هذه العملية تأتي أيضًا بمخاطر، وقد يتم فقدان بعض الدقة.

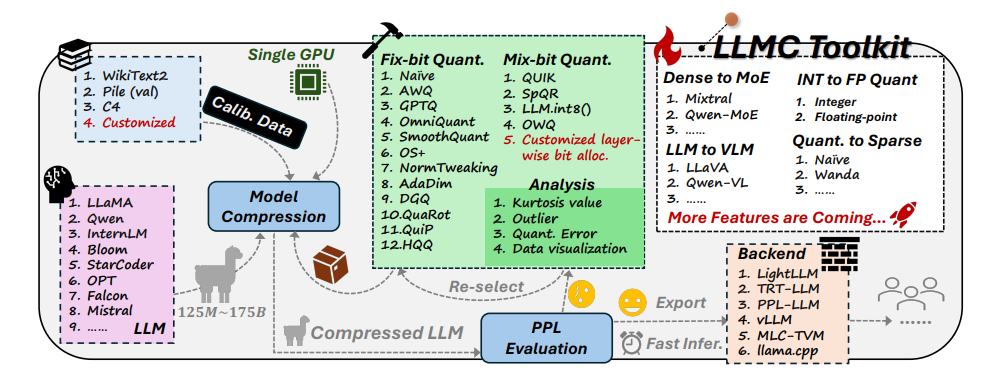

وفي مواجهة هذا التحدي، قام باحثون من جامعة Beihang وSenseTime Technology بشكل مشترك بتطوير مجموعة أدوات LLMC. يشبه LLMC مدربًا شخصيًا لفقدان الوزن للذكاء الاصطناعي، حيث يمكنه مساعدة الباحثين والمطورين في العثور على الخطة الأنسب لفقدان الوزن، والتي يمكن أن تجعل نموذج الذكاء الاصطناعي أخف وزنًا دون التأثير على مستوى ذكائه.

تحتوي مجموعة أدوات LLMC على ثلاث ميزات رئيسية:

التنويع: توفر LLMC 16 طريقة كمية مختلفة، وهو ما يشبه إعداد 16 وصفة مختلفة لفقدان الوزن باستخدام الذكاء الاصطناعي. سواء كان الذكاء الاصطناعي الخاص بك يريد إنقاص الوزن بالكامل أو محليًا، يمكن لـ LLMC تلبية احتياجاتك.

تكلفة منخفضة: تتميز شركة LLMC بتوفير الموارد بشكل كبير ولا تتطلب سوى القليل من دعم الأجهزة حتى لمعالجة النماذج الكبيرة جدًا. على سبيل المثال، باستخدام وحدة معالجة الرسومات A100 بسعة 40 جيجابايت فقط، يمكن تعديل وتقييم طراز OPT-175B الذي يحتوي على 175 مليار معلمة. وهذا فعال مثل استخدام جهاز المشي المنزلي لتدريب بطل أولمبي!

التوافق العالي: يدعم LLMC مجموعة متنوعة من إعدادات التكميم وتنسيقات النماذج، كما أنه متوافق أيضًا مع مجموعة متنوعة من الواجهات الخلفية ومنصات الأجهزة. إنه بمثابة مدرب عالمي يمكنه مساعدتك في تطوير خطة تدريب مناسبة بغض النظر عن المعدات التي تستخدمها.

التطبيقات العملية لـ LLMC: جعل الذكاء الاصطناعي أكثر ذكاءً وأكثر كفاءة في استخدام الطاقة

يوفر ظهور مجموعة أدوات LLMC اختبارًا مرجعيًا شاملاً وعادلاً لتقدير نماذج اللغات الكبيرة. يأخذ في الاعتبار ثلاثة عوامل رئيسية: بيانات التدريب والخوارزمية وتنسيق البيانات لمساعدة المستخدمين في العثور على أفضل حل لتحسين الأداء.

في التطبيقات العملية، يمكن لـ LLMC مساعدة الباحثين والمطورين على دمج الخوارزميات المناسبة وتنسيقات البت المنخفضة بشكل أكثر كفاءة، مما يعزز تعميم ضغط نماذج اللغات الكبيرة. وهذا يعني أننا قد نرى المزيد من تطبيقات الذكاء الاصطناعي خفيفة الوزن ولكنها بنفس القوة في المستقبل.

شارك مؤلفو الورقة أيضًا بعض النتائج والاقتراحات المثيرة للاهتمام:

عند اختيار بيانات التدريب، يجب عليك اختيار مجموعة بيانات أكثر تشابهًا مع بيانات الاختبار من حيث توزيع المفردات، تمامًا كما هو الحال عندما يفقد الإنسان الوزن، فإنه يحتاج إلى اختيار الوصفات المناسبة بناءً على ظروفه الخاصة.

وفيما يتعلق بخوارزميات القياس الكمي، فقد استكشفوا تأثير التقنيات الرئيسية الثلاثة للتحول والزراعات وإعادة البناء، تمامًا مثل مقارنة تأثيرات أساليب التمارين المختلفة على فقدان الوزن.

عند الاختيار بين تكميم الأعداد الصحيحة والفاصلة العائمة، وجدوا أن تكميم الفاصلة العائمة له مزايا أكثر في التعامل مع المواقف المعقدة، في حين أن تكميم الأعداد الصحيحة قد يكون أفضل في بعض الحالات الخاصة. يبدو الأمر كما لو أن هناك حاجة إلى شدة مختلفة للتمرين في مراحل مختلفة من فقدان الوزن.

لقد أدى ظهور مجموعة أدوات LLMC إلى ظهور اتجاه جديد في مجال الذكاء الاصطناعي. فهو لا يوفر مساعدًا قويًا للباحثين والمطورين فحسب، بل يشير أيضًا إلى اتجاه التطوير المستقبلي للذكاء الاصطناعي. من خلال LLMC، يمكننا أن نتوقع رؤية المزيد من تطبيقات الذكاء الاصطناعي خفيفة الوزن وعالية الأداء، مما يسمح للذكاء الاصطناعي بدخول حياتنا اليومية حقًا.

عنوان المشروع: https://github.com/ModelTC/llmc

عنوان الورقة: https://arxiv.org/pdf/2405.06001

بشكل عام، توفر مجموعة أدوات LLMC حلاً فعالاً لحل مشكلة استهلاك الموارد لنماذج اللغات الكبيرة، فهي لا تقلل فقط من تكلفة وعتبة تشغيل النموذج، ولكنها تعمل أيضًا على تحسين كفاءة النموذج وسهولة استخدامه، مما يؤدي إلى ضخ حقنة في النموذج. تعميم وتطوير الذكاء الاصطناعي حيوية جديدة. في المستقبل، يمكننا أن نتطلع إلى ظهور تطبيقات ذكاء اصطناعي خفيفة الوزن تعتمد على LLMC، مما يوفر المزيد من الراحة لحياتنا.