يُحدث نموذج اللغة Zamba2-2.7B الذي تم إصداره حديثًا من Zyphra موجات في مجال نماذج اللغات الصغيرة. يقلل هذا النموذج بشكل كبير من متطلبات موارد الاستدلال مع الحفاظ على أداء مشابه لنموذج 7B، مما يجعله مثاليًا لتطبيقات الأجهزة المحمولة. لقد قام Zamba2-2.7B بتحسين سرعة الاستجابة واستخدام الذاكرة وزمن الوصول بشكل كبير، وهو أمر بالغ الأهمية للتطبيقات التي تتطلب التفاعل في الوقت الفعلي، مثل المساعدين الافتراضيين وروبوتات الدردشة. تضمن آلية الاهتمام المشترك المشذرة المحسنة وجهاز عرض LoRA المعالجة الفعالة للمهام المعقدة.

أصدرت Zyphra مؤخرًا نموذج لغة Zamba2-2.7B الجديد، ولهذا الإصدار أهمية كبيرة في تاريخ تطوير نماذج اللغات الصغيرة. يحقق النموذج الجديد تحسينات كبيرة في الأداء والكفاءة، حيث تصل مجموعة بيانات التدريب الخاصة به إلى ما يقرب من 3 تريليون رمز، مما يجعله قابلاً للمقارنة في الأداء مع Zamba1-7B ونماذج 7B الرائدة الأخرى.

الأمر الأكثر إثارة للدهشة هو أن متطلبات موارد Zamba2-2.7B أثناء الاستدلال قد انخفضت بشكل كبير، مما يجعله حلاً فعالاً لتطبيقات الأجهزة المحمولة.

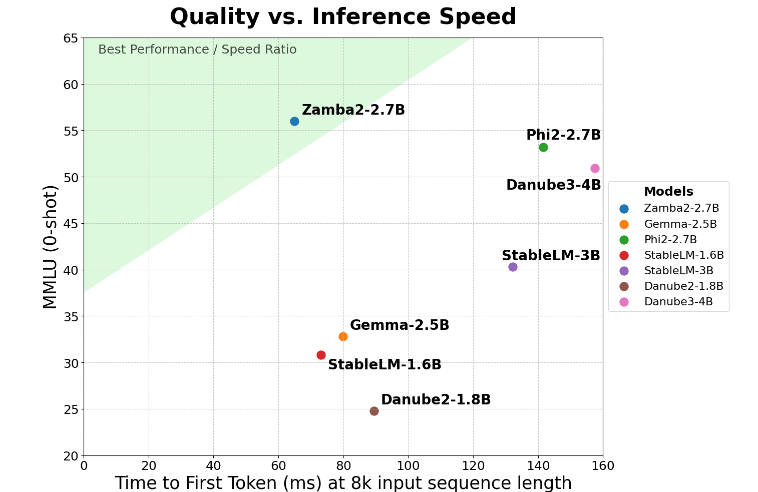

يحقق Zamba2-2.7B تحسنًا مضاعفًا في المقياس الرئيسي لـ "وقت استجابة التوليد الأول"، مما يعني أنه يمكنه توليد استجابات أولية بشكل أسرع من المنافسين. يعد هذا أمرًا بالغ الأهمية لتطبيقات مثل المساعدين الافتراضيين وروبوتات الدردشة التي تتطلب التفاعل في الوقت الفعلي.

بالإضافة إلى تحسين السرعة، يقوم Zamba2-2.7B أيضًا بعمل ممتاز في استخدام الذاكرة. فهو يقلل من حمل الذاكرة بنسبة 27%، مما يجعله مثاليًا للنشر على الأجهزة ذات موارد الذاكرة المحدودة. وتضمن إدارة الذاكرة الذكية هذه إمكانية تشغيل النموذج بفعالية في بيئات ذات موارد حوسبة محدودة، مما يؤدي إلى توسيع نطاق تطبيقه على مختلف الأجهزة والأنظمة الأساسية.

يتمتع Zamba2-2.7B أيضًا بميزة كبيرة تتمثل في انخفاض زمن الوصول للبناء. بالمقارنة مع Phi3-3.8B، يتم تقليل زمن الوصول بمقدار 1.29 مرة، مما يجعل التفاعل أكثر سلاسة. يعد زمن الاستجابة المنخفض مهمًا بشكل خاص في التطبيقات التي تتطلب اتصالاً سلسًا ومستمرًا، مثل روبوتات خدمة العملاء والأدوات التعليمية التفاعلية. ولذلك فإن Zamba2-2.7B هو بلا شك الخيار الأول للمطورين من حيث تحسين تجربة المستخدم.

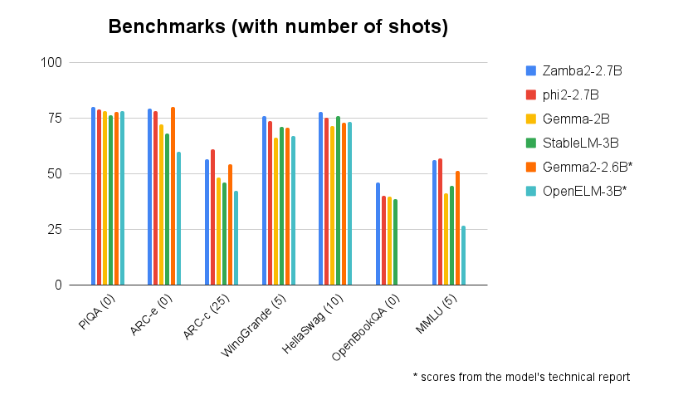

يتفوق أداء Zamba2-2.7B باستمرار في المقارنات المعيارية مع النماذج الأخرى ذات الحجم المماثل. ويثبت أدائها المتفوق ابتكار Zyphra وجهودها في تعزيز تطوير تكنولوجيا الذكاء الاصطناعي. يستخدم هذا النموذج آلية اهتمام مشترك مشذرة محسنة ومجهز بجهاز عرض LoRA على وحدة MLP مشتركة لضمان إخراج عالي الأداء عند معالجة المهام المعقدة.

مدخل النموذج: https://huggingface.co/Zyphra/Zamba2-2.7B

أبرز النقاط:

يضاعف نموذج Zamba2-27B وقت الاستجابة الأول، مما يجعله مناسبًا للتطبيقات التفاعلية في الوقت الفعلي.

يعمل هذا الطراز على تقليل حمل الذاكرة بنسبة 27% وهو مناسب للأجهزة ذات الموارد المحدودة.

فيما يتعلق بتأخير التوليد، يتفوق Zamba2-2.7B على النماذج المماثلة، مما يحسن تجربة المستخدم.

باختصار، وضع Zamba2-2.7B معيارًا جديدًا لنماذج اللغات الصغيرة بأدائه وكفاءته الممتازين، مما يوفر للمطورين أدوات ذكاء اصطناعي أكثر قوة ومرونة، ومن المتوقع أن يلعب دورًا مهمًا في تطبيقات الهاتف المحمول. إن الاستخدام الفعال للموارد وتجربة المستخدم السلسة يجعلها قوة دافعة رئيسية لتطوير تطبيقات الذكاء الاصطناعي المستقبلية.