ماذا سيحدث لو أعيد تدريب الذكاء الاصطناعي باستخدام الصور التي أنشأها؟ في الآونة الأخيرة، أجرى باحثون في جامعة ستانفورد وجامعة كاليفورنيا في بيركلي مثل هذه التجربة، وكانت النتائج مفاجئة.

ووجد الباحثون أنه عندما تم إعادة تدريب نماذج توليد الصور بتقنية الذكاء الاصطناعي لاستخدام الصور التي أنتجتها بنفسها، أنتجت النماذج صورًا مشوهة للغاية. والأسوأ من ذلك، أن هذا التشويه لا يقتصر على إشارات النص المستخدمة لإعادة التدريب، فبمجرد أن يصبح النموذج "ملوثًا"، يكون من الصعب على النموذج أن يتعافى بالكامل، حتى لو تم إعادة تدريبه لاحقًا باستخدام صور حقيقية فقط.

نقطة البداية للتجربة هي نموذج مفتوح المصدر يسمى الانتشار المستقر (SD). اختار الباحثون أولاً 70 ألف صورة وجه عالية الجودة من مجموعة بيانات الوجه FFHQ وقاموا بتصنيفها تلقائيًا. ثم استخدموا هذه الصور الحقيقية كمدخلات لتوليد 900 صورة تتوافق مع خصائص مجموعة معينة من الأشخاص من خلال نموذج الانتشار المستقر.

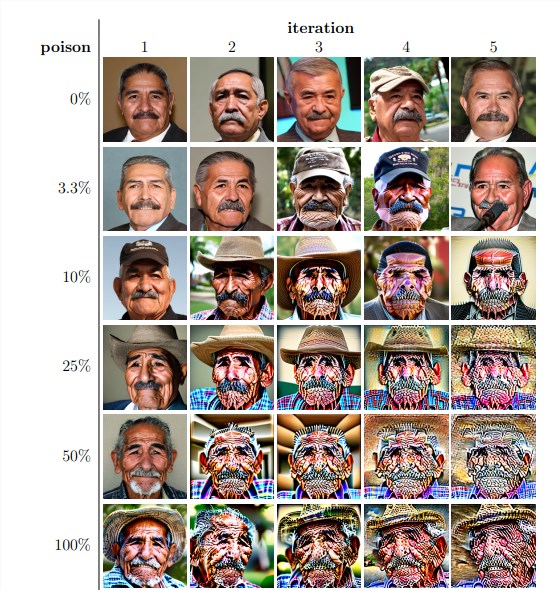

بعد ذلك، استخدم الباحثون هذه الصور المولدة لإعادة التدريب التكراري للنموذج. ووجدوا أنه بغض النظر عن نسبة الصور المولدة ذاتيًا في مجموعة بيانات إعادة التدريب، فقد انهار النموذج في النهاية وانخفضت جودة الصور المولدة بشكل كبير. حتى عندما تحتوي بيانات إعادة التدريب على 3% فقط من الصور المولدة ذاتيًا، فإن ظاهرة انهيار النموذج لا تزال موجودة.

تظهر النتائج التجريبية أن الإصدار الأساسي من نموذج Stable Diffusion ينشئ صورًا تتوافق مع الإشارات النصية وتتميز بجودة بصرية عالية. ولكن مع إعادة تدريب النموذج بشكل متكرر، بدأت الصور التي تم إنشاؤها تظهر تناقضات دلالية وتشوهات بصرية. ووجد الباحثون أيضًا أن انهيار النموذج لم يؤثر على جودة الصورة فحسب، بل أدى أيضًا إلى نقص التنوع في الصور التي تم إنشاؤها.

وللتحقق من ذلك، أجرى الباحثون أيضًا تجارب مضبوطة لمحاولة التخفيف من تأثير انهيار النموذج عن طريق ضبط الرسم البياني اللوني للصور التي تم إنشاؤها وإزالة الصور منخفضة الجودة. لكن النتائج تظهر أن هذه التدابير ليست فعالة في منع انهيار النموذج.

واستكشف الباحثون أيضًا ما إذا كان من الممكن أن يتعافى النموذج من خلال إعادة التدريب بعد "التلوث". ووجدوا أنه على الرغم من استعادة جودة الصور الناتجة في بعض الحالات بعد تكرارات متعددة لإعادة التدريب، إلا أن علامات انهيار النموذج ظلت قائمة. وهذا يوضح أنه بمجرد "تلوث" النموذج، فإن التأثيرات قد تكون طويلة المدى أو حتى لا رجعة فيها.

تكشف هذه الدراسة عن مشكلة مهمة: أنظمة الذكاء الاصطناعي الشائعة حاليًا والتي تعتمد على تحويل النص إلى صورة، حساسة جدًا "لتلوث" البيانات. يمكن أن يحدث هذا "التلوث" عن غير قصد، مثل نسخ الصور بشكل عشوائي من مصادر عبر الإنترنت. ويمكن أيضًا أن يكون هجومًا مستهدفًا، مثل وضع بيانات "ملوثة" عمدًا على موقع ويب.

وفي مواجهة هذه التحديات، اقترح الباحثون بعض الحلول الممكنة، مثل استخدام أجهزة كشف صحة الصورة لاستبعاد الصور التي تم إنشاؤها بواسطة الذكاء الاصطناعي، أو إضافة علامات مائية إلى الصور التي تم إنشاؤها. على الرغم من أنها غير مثالية، إلا أن هذه الأساليب مجتمعة قد تقلل بشكل كبير من خطر "تلوث" البيانات.

تذكرنا هذه الدراسة بأن تطوير تكنولوجيا الذكاء الاصطناعي لا يخلو من المخاطر. نحن بحاجة إلى أن نكون أكثر حذراً مع المحتوى الذي ينشئه الذكاء الاصطناعي لضمان عدم وجود آثار سلبية طويلة المدى على نماذجنا ومجموعات البيانات لدينا. تحتاج الأبحاث المستقبلية إلى مزيد من الاستكشاف لكيفية جعل أنظمة الذكاء الاصطناعي أكثر مرونة في التعامل مع هذا النوع من "تلوث" البيانات أو تطوير تقنيات يمكنها تسريع عملية "شفاء" النماذج.