أطلقت Google رسميًا الجيل السادس من مادة TPU، Trillium، وفتحته لعملاء Google Cloud. Trillium هو أقوى TPU من Google حتى الآن ويستخدم لتدريب Gemini 2.0، أقوى نموذج للذكاء الاصطناعي. فهو يعمل على تحسين أداء التدريب وإنتاجية الاستدلال وكفاءة الطاقة بشكل كبير، مع تحقيق تكاليف أقل. ستلقي هذه المقالة نظرة متعمقة على تحسينات أداء Trillium TPU، والميزات الرئيسية، والأداء المتميز في أعباء عمل الذكاء الاصطناعي المختلفة، وستوضح حالات التطبيق العملي الخاصة بها بين العملاء مثل AI21Labs.

في وقت سابق من هذا العام، أصدرت جوجل Trillium، وهو الجيل السادس وأقوى مادة TPU حتى الآن. اليوم، أصبح Trillium متاحًا رسميًا لعملاء Google Cloud.

استخدمت Google Trillium TPU لتدريب أحدث إصدار من Gemini2.0، وهو أقوى نموذج للذكاء الاصطناعي من Google حتى الآن. والآن، يمكن للمؤسسات والشركات الناشئة على حد سواء الاستفادة من نفس البنية التحتية القوية والفعالة والمستدامة.

جوهر الكمبيوتر العملاق AI: Trillium TPU

يعد Trillium TPU مكونًا رئيسيًا لجهاز Google Cloud AI Hypercomputer. يعد AI Hypercomputer عبارة عن بنية حاسوبية خارقة تعمل على تعزيز الأجهزة المحسنة الأداء، والبرمجيات المفتوحة، وأطر تعلم الآلة الرائدة، وأنظمة تكامل نماذج الاستهلاك المرنة. مع الإطلاق الرسمي لـ Trillium TPU، أجرت Google أيضًا تحسينات رئيسية على طبقة البرامج المفتوحة للكمبيوتر Hypercomputer المدعم بالذكاء الاصطناعي، بما في ذلك تحسين مترجم XLA والأطر الشائعة مثل JAX وPyTorch وTensorFlow لتحقيق سعر/أداء رائد في تدريب الذكاء الاصطناعي. وضبط والخدمات .

بالإضافة إلى ذلك، توفر ميزات مثل إلغاء تحميل المضيف باستخدام DRAM المضيف الضخم (ذاكرة النطاق الترددي العالي الإضافية، أو HBM) مستويات أعلى من الكفاءة. يمكّنك AI Hypercomputer من استخلاص أقصى قيمة من النشر غير المسبوق لأكثر من 100000 شريحة Trillium لكل بنية شبكة Jupiter مع 13 بيتابت/ثانية من عرض النطاق الترددي ثنائي الاتجاه والقدرة على توسيع نطاق مهمة تدريب موزعة واحدة لمئات الآلاف من المسرعات.

يستخدم عملاء مثل AI21Labs بالفعل Trillium لتقديم حلول ذكاء اصطناعي مفيدة لعملائهم بشكل أسرع:

قال باراك لينز، الرئيس التنفيذي للتكنولوجيا في AI21Labs: "في AI21، نعمل باستمرار على تحسين أداء وكفاءة نماذج لغة Mamba وJamba باعتبارنا مستخدمين على المدى الطويل لـ TPU v4، نحن معجبون بقدرات Trillium من Google Cloud. على نطاق واسع، والسرعة والتكلفة، تعتبر التحسينات في الكفاءة كبيرة، ونعتقد أن Trillium ستلعب دورًا حيويًا في تسريع تطوير الجيل القادم من نماذج اللغات المعقدة، مما يسمح لنا بتقديم حلول ذكاء اصطناعي أكثر قوة ويمكن الوصول إليها لعملائنا.

لقد تحسن أداء Trillium بشكل كبير، وسجلت العديد من المؤشرات أرقامًا قياسية جديدة.

بالمقارنة مع الجيل السابق، حققت تريليوم تحسينات كبيرة في:

تحسن أداء التدريب بأكثر من 4 مرات

تحسن بمقدار 3 مرات في إنتاجية الاستدلال

زيادة كفاءة الطاقة بنسبة 67%

تحسن بمقدار 4.7 أضعاف في ذروة أداء الحوسبة لكل شريحة

تعمل الذاكرة ذات النطاق الترددي العالي (HBM) على مضاعفة السعة

يعمل التوصيل البيني بين الشرائح (ICI) على مضاعفة عرض النطاق الترددي

تحتوي بنية شبكة المشتري الواحدة على 100000 شريحة تريليوم

تحسين بمقدار 2.5 مرة في أداء التدريب لكل دولار وتحسين بمقدار 1.4 مرة في أداء الاستدلال لكل دولار

تعمل هذه التحسينات على تمكين Trillium من الأداء الجيد عبر مجموعة متنوعة من أعباء عمل الذكاء الاصطناعي، بما في ذلك:

توسيع نطاق أعباء العمل التدريبية الخاصة بالذكاء الاصطناعي

تدريب LLMs، بما في ذلك النماذج الكثيفة ونماذج الخبراء المختلطة (MoE).

أداء الاستدلال والجدولة الجماعية

تضمين نماذج كثيفة

توفير التدريب واستنتاج فعالية التكلفة

كيف يعمل Trillium عبر أعباء العمل المختلفة؟

توسيع نطاق أعباء العمل التدريبية الخاصة بالذكاء الاصطناعي

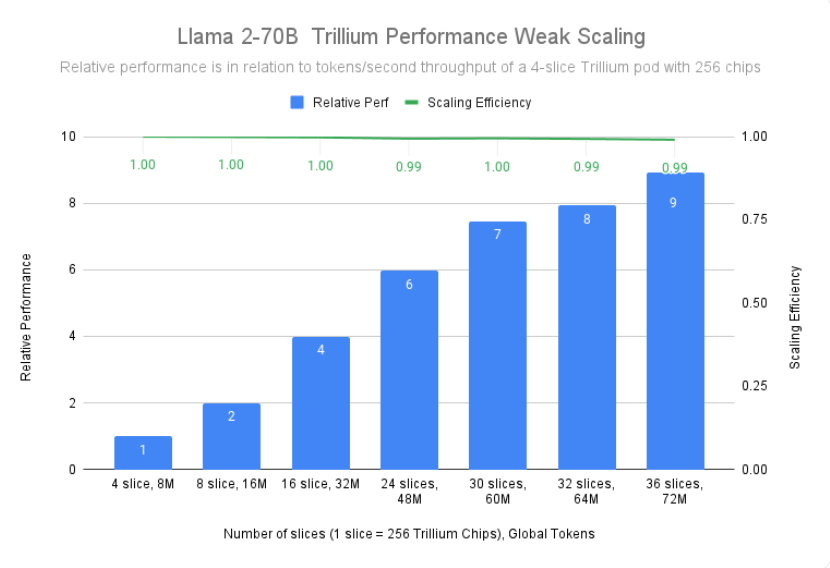

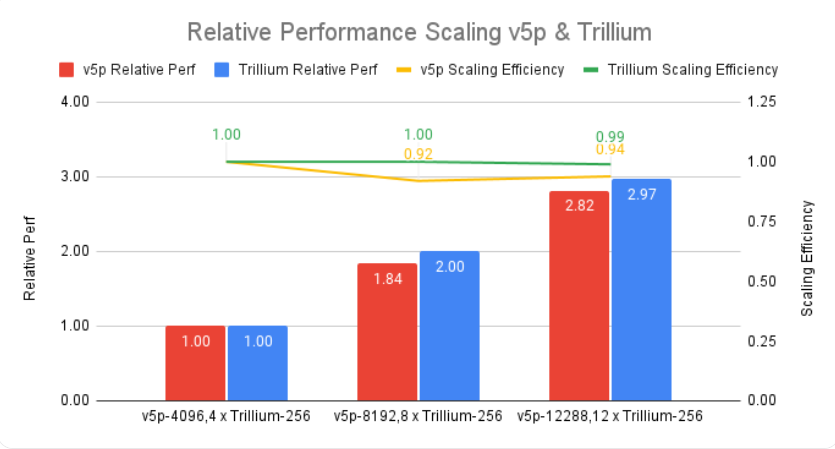

يتطلب تدريب نموذج كبير مثل Gemini2.0 الكثير من البيانات والحسابات. تسمح قابلية التوسع شبه الخطي لـ Trillium بتدريب هذه النماذج بشكل أسرع بكثير من خلال توزيع أحمال العمل بفعالية وكفاءة عبر مضيفات Trillium المتعددة، والمتصلة عبر وصلات بينية عالية السرعة من شريحة إلى شريحة في حجرات مكونة من 256 شريحة وأحدث ما لدينا في شبكة مركز بيانات جوبيتر. يتم تحقيق ذلك من خلال تقنية TPU متعددة الرقائق والمكدسة بالكامل للتدريب على نطاق واسع، ويتم تحسينها بشكل أكبر من خلال Titanium، وهو نظام تفريغ ديناميكي على مستوى مركز البيانات يتراوح من محولات المضيف إلى بنية الشبكة.

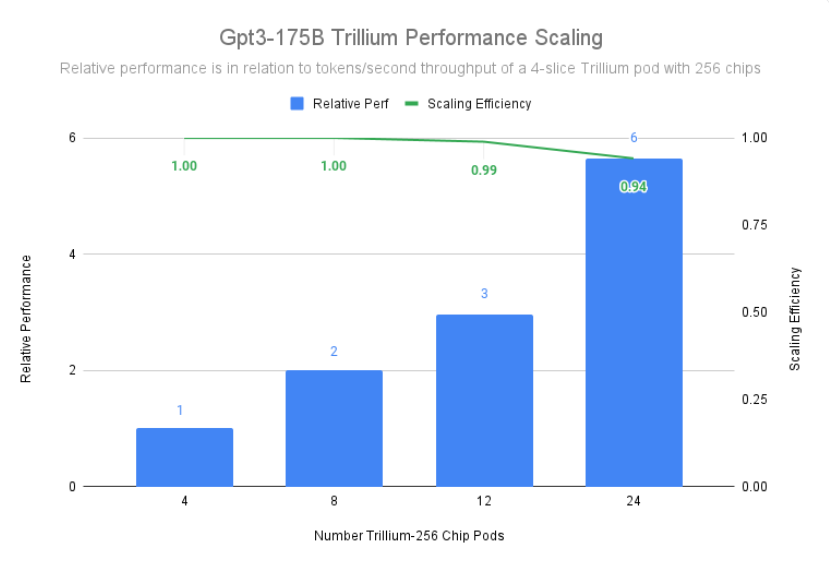

حققت Trillium كفاءة توسيع بنسبة 99% في نشر 12 حاوية مع 3072 شريحة وأظهرت كفاءة توسيع بنسبة 94% في 24 حاوية مع 6144 شريحة للتدريب المسبق على gpt3-175b، حتى في نفس الشيء عند التشغيل عبر شبكات مراكز البيانات.

تدريب LLMs، بما في ذلك النماذج الكثيفة ونماذج الخبراء المختلطة (MoE).

إن دورات LLM مثل Gemini قوية ومعقدة بطبيعتها، مع مليارات من المعلمات. يتطلب التدريب على مثل هذا البرنامج المكثف من LLM قوة حاسوبية هائلة بالإضافة إلى تحسين البرامج المصممة بشكل مشترك. يعد Trillium أسرع 4 مرات من الجيل السابق من Cloud TPU v5e عند تدريب دورات LLM مكثفة مثل Llama-2-70b وgpt3-175b.

بالإضافة إلى LLM المكثف، هناك نهج شائع بشكل متزايد يتمثل في تدريب LLM باستخدام بنية خبيرة مختلطة (MoE)، والتي تجمع بين شبكات عصبية متعددة "خبيرة"، كل منها متخصص في جوانب مختلفة من مهمة الذكاء الاصطناعي. إن إدارة وتنسيق هؤلاء الخبراء أثناء التدريب يزيد من التعقيد مقارنة بتدريب نموذج واحد متجانس. يعد Trillium أسرع بمقدار 3.8 مرة من الجيل السابق من Cloud TPU v5e عند تدريب نماذج MoE.

بالإضافة إلى ذلك، يوفر Trillium TPU ضعف ذاكرة الوصول العشوائي الديناميكي المضيف (DRAM) مقارنة بـ Cloud TPU v5e. يؤدي هذا إلى تفريغ بعض العمليات الحسابية للمضيف، مما يساعد على زيادة الأداء واسع النطاق والإنتاجية الجيدة. توفر ميزة تفريغ مضيف Trillium تحسينًا في الأداء بنسبة تزيد عن 50% في استخدام نموذج FLOP (MFU) عند تدريب نموذج Llama-3.1-405B.

أداء الاستدلال والجدولة الجماعية

تتطلب الأهمية المتزايدة للاستدلال متعدد الخطوات مسرعات يمكنها التعامل بكفاءة مع المتطلبات الحسابية المتزايدة. توفر Trillium تطورات كبيرة في أحمال عمل الاستدلال، مما يتيح نشر نماذج الذكاء الاصطناعي بشكل أسرع وأكثر كفاءة. في الواقع، تقدم Trillium أفضل أداء لدينا لاستدلال مادة TPU لنشر الصور وLLM الكثيفة. تُظهر اختباراتنا أن Stable Diffusion XL يتمتع بإنتاجية استدلال نسبي أعلى بأكثر من 3 مرات (صور في الثانية) مقارنة بـ Cloud TPU v5e، في حين أن Llama2-70B لديه ما يقرب من مرتين.

Trillium هو جهاز TPU الأعلى أداءً لدينا لحالات استخدام الاستدلال في وضع عدم الاتصال والخادم. يوضح الشكل أدناه أنه بالمقارنة مع Cloud TPU v5e، فإن الإنتاجية النسبية لـ Stable Diffusion XL (الصور في الثانية) للاستدلال في وضع عدم الاتصال أعلى بمقدار 3.1 مرة، والإنتاجية النسبية لاستدلال الخادم أعلى بـ 2.9 مرة.

بالإضافة إلى الأداء الأفضل، تقدم Trillium أيضًا إمكانات جدولة جماعية جديدة. تسمح هذه الميزة لنظام الجدولة الخاص بـ Google باتخاذ قرارات ذكية لجدولة المهام لتحسين التوفر العام وكفاءة أعباء عمل الاستدلال عند وجود نسخ متماثلة متعددة في المجموعة. فهو يوفر طريقة لإدارة شرائح TPU المتعددة التي تقوم بتشغيل أحمال عمل الاستدلال لمضيف واحد أو متعدد المضيف، بما في ذلك من خلال Google Kubernetes Engine (GKE). إن تجميع هذه القطع في مجموعة يجعل من السهل ضبط عدد النسخ المتماثلة لتتناسب مع الطلب.

تضمين نماذج كثيفة

من خلال إضافة الجيل الثالث من SparseCore، تعمل Trillium على تحسين أداء النماذج كثيفة التضمين بمقدار 2x وDLRM DCNv2 بمقدار 5x.

SparseCore هو معالج لتدفق البيانات يوفر أساسًا معماريًا أكثر قابلية للتكيف لأعباء العمل المكثفة المضمنة. يتفوق الجيل الثالث من SparseCore من Trillium في تسريع العمليات الديناميكية والمتعلقة بالبيانات مثل التجميع المبعثر، ومجموع الأجزاء المتفرقة، والتقسيم.

توفير التدريب واستنتاج فعالية التكلفة

بالإضافة إلى الأداء الهائل والنطاق المطلوب لتدريب بعض أكبر أعباء عمل الذكاء الاصطناعي في العالم، تم تصميم Trillium لتحسين الأداء لكل دولار. حتى الآن، حققت Trillium أداءً أفضل بمقدار 2.1 مرة لكل دولار مقارنة بـ Cloud TPU v5e و2.5 مرة أفضل من Cloud TPU v5p عند تدريب دورات LLM مكثفة مثل Llama2-70b وLlama3.1-405b.

تتفوق Trillium في معالجة النماذج الكبيرة بشكل متوازٍ وبتكلفة معقولة. وهو مصمم لتمكين الباحثين والمطورين من تقديم نماذج صور قوية وفعالة بتكلفة أقل بكثير من ذي قبل. تكلفة إنشاء ألف صورة على Trillium أقل بنسبة 27% من Cloud TPU v5e للاستدلال في وضع عدم الاتصال، وأقل بنسبة 22% من Cloud TPU v5e لاستدلال الخادم على SDXL.

الارتقاء بابتكار الذكاء الاصطناعي إلى المستوى التالي

يمثل Trillium قفزة كبيرة إلى الأمام في البنية التحتية لـ Google Cloud AI، مما يوفر أداءً مذهلاً وقابلية للتوسعة وكفاءة لمجموعة متنوعة من أعباء عمل الذكاء الاصطناعي. بفضل قدرتها على التوسع إلى مئات الآلاف من الرقائق باستخدام برامج التصميم المشترك ذات المستوى العالمي، تمكنك Trillium من تحقيق اختراقات أسرع وتقديم حلول الذكاء الاصطناعي المتفوقة. بالإضافة إلى ذلك، فإن السعر/الأداء الاستثنائي لشركة Trillium يجعلها خيارًا فعالاً من حيث التكلفة للمؤسسات التي تتطلع إلى تعظيم قيمة استثماراتها في الذكاء الاصطناعي. مع استمرار تطور مشهد الذكاء الاصطناعي، تُظهر Trillium التزام Google Cloud بتوفير بنية تحتية متطورة لمساعدة المؤسسات على إطلاق الإمكانات الكاملة للذكاء الاصطناعي.

المقدمة الرسمية: https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga

بشكل عام، يمثل ظهور Trillium TPU تحسنًا كبيرًا في قدرات الحوسبة السحابية للذكاء الاصطناعي، وسيعمل أدائها القوي وقابليتها للتوسع وفوائدها الاقتصادية على تعزيز التطوير الأسرع في مجال الذكاء الاصطناعي وتوفير حلول ذكاء اصطناعي أكثر قوة للمؤسسات والمؤسسات البحثية.