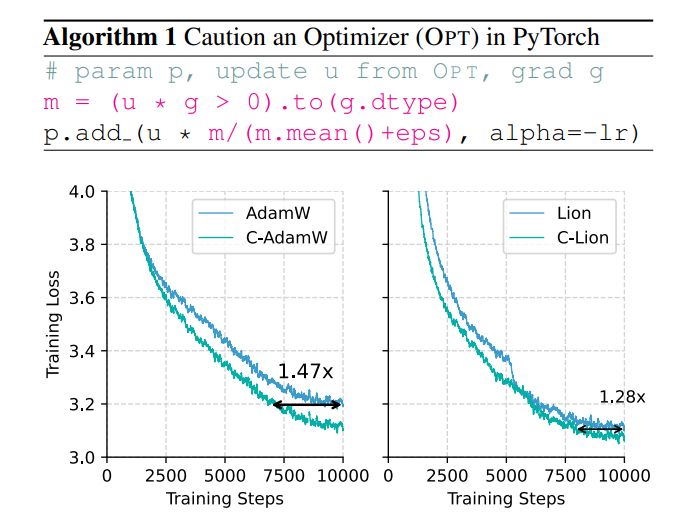

أصبحت قضايا الكفاءة واستهلاك الطاقة الخاصة بتدريب النماذج الكبيرة بارزة بشكل متزايد، وأصبح مُحسِّن AdamW التقليدي غير قادر على التعامل مع حجم النموذج الضخم. لحل هذه المشكلة، اقترح فريق صيني بالكامل مُحسِّنًا جديدًا يسمى C-AdamW (Crudent AdamW). الفكرة الأساسية لـ C-AdamW هي "التفكير قبل التصرف". من خلال تحديد اتجاه التحديث بدقة، يمكن للنموذج تجنب إهدار الموارد في المسار الخاطئ، وبالتالي تحسين سرعة التدريب وتقليل استهلاك الطاقة. يعمل هذا المحسن على تحسين سرعة التدريب بما يصل إلى 1.47x في التدريب المسبق لـ Llama وMAE دون أي نفقات حسابية إضافية تقريبًا ويمكن تحقيقه من خلال تعديلات بسيطة على التعليمات البرمجية الموجودة.

في عالم الذكاء الاصطناعي، يبدو أن "القوة يمكنها أن تصنع المعجزات" هي القاعدة الذهبية. كلما كان النموذج أكبر، زادت البيانات، وكانت قوة الحوسبة أقوى، ويبدو أنه أقرب إلى الكأس المقدسة للذكاء. ومع ذلك، وراء هذا التطور السريع، هناك أيضًا ضغوط هائلة على التكلفة واستهلاك الطاقة.

من أجل جعل تدريب الذكاء الاصطناعي أكثر كفاءة، كان العلماء يبحثون عن أدوات تحسين أكثر قوة، مثل المدرب، لتوجيه معلمات النموذج للتحسين المستمر والوصول في النهاية إلى أفضل حالة. لقد كان AdamW، باعتباره المُحسِّن الافتراضي للتدريب المسبق على Transformer، بمثابة معيار الصناعة لسنوات عديدة. ومع ذلك، في مواجهة الحجم المتزايد للنموذج، بدأ AdamW يبدو أيضًا غير قادر على التعامل مع قيوده.

أليس هناك طريقة لزيادة سرعة التدريب مع تقليل استهلاك الطاقة؟ لا تقلق، فريق صيني بالكامل موجود هنا مع "سلاحهم السري" C-AdamW!

الاسم الكامل لـ C-AdamW هو Cautious AdamW، واسمها الصيني هو "AdamW الحذر". ألا يبدو هذا "بوذيًا" جدًا؟ نعم، الفكرة الأساسية لـ C-AdamW هي "التفكير مرتين قبل التمثيل".

تخيل أن معلمات النموذج تشبه مجموعة من الأطفال النشيطين الذين يرغبون دائمًا في الركض. AdamW يشبه المعلم المتفاني، الذي يحاول توجيههم في الاتجاه الصحيح. لكن في بعض الأحيان، يشعر الأطفال بالحماس الشديد ويركضون في الاتجاه الخاطئ، مما يؤدي إلى إضاعة الوقت والطاقة.

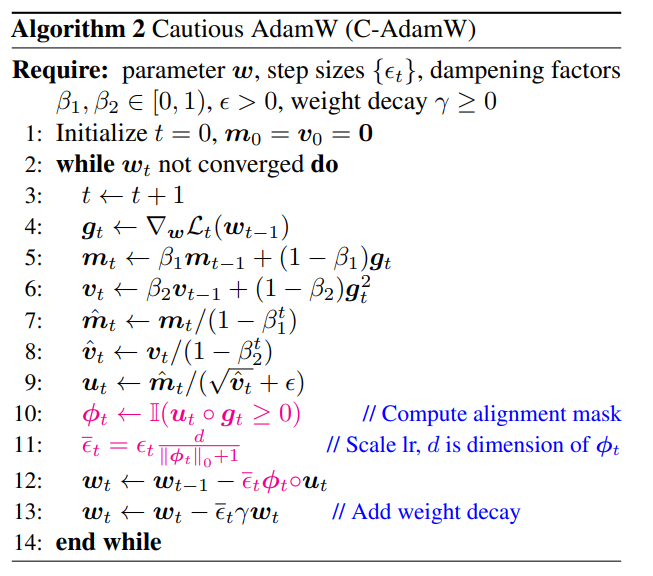

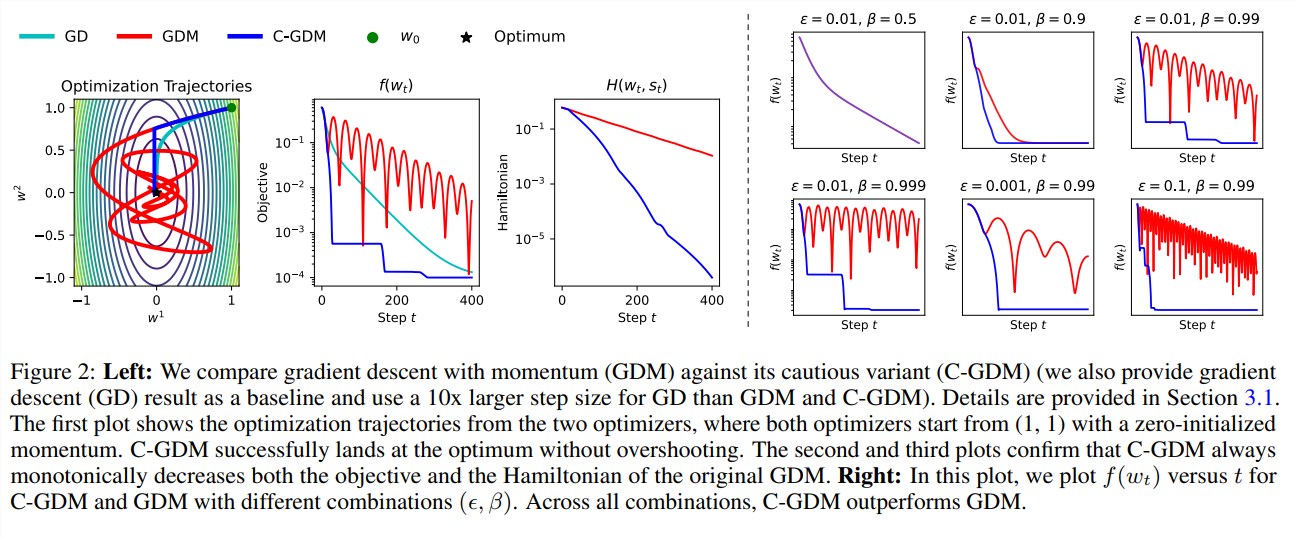

في هذا الوقت، يشبه C-AdamW شيخًا حكيمًا، يرتدي زوجًا من "العيون النارية" التي يمكنها تحديد ما إذا كان اتجاه التحديث صحيحًا بدقة. إذا كان الاتجاه خاطئًا، فسوف يقوم C-AdamW باستدعاء التوقف بشكل حاسم لمنع النموذج من المضي قدمًا في الطريق الخطأ.

تضمن هذه الإستراتيجية "الحذرة" أن كل تحديث يمكن أن يقلل بشكل فعال من وظيفة الخسارة، وبالتالي تسريع تقارب النموذج. تظهر النتائج التجريبية أن C-AdamW يزيد من سرعة التدريب إلى 1.47 مرة في تدريب Llama وMAE المسبق!

والأهم من ذلك، أن C-AdamW لا يتطلب أي نفقات حسابية إضافية تقريبًا ويمكن تنفيذه من خلال تعديل بسيط من سطر واحد للكود الموجود. وهذا يعني أنه يمكن للمطورين تطبيق C-AdamW بسهولة على نماذج التدريب المختلفة والاستمتاع "بالسرعة والشغف"!

الجانب "البوذي" لـ C-AdamW هو أنه يحتفظ بوظيفة آدم الهاملتونية ولا يدمر ضمان التقارب في ظل تحليل ليابونوف. وهذا يعني أن C-AdamW ليس أسرع فحسب، بل إن استقراره مضمون أيضًا، ولن تكون هناك مشاكل مثل أعطال التدريب.

بالطبع، "البوذي" لا يعني "غير طموح". صرح فريق البحث أنهم سيستمرون في استكشاف وظائف ϕ الأكثر ثراءً وتطبيق الأقنعة في مساحة الميزات بدلاً من مساحة المعلمة لزيادة تحسين أداء C-AdamW.

من المتوقع أن يصبح C-AdamW هو المفضل الجديد في مجال التعلم العميق، مما يؤدي إلى تغييرات ثورية في نماذج التدريب الكبيرة!

عنوان الورقة: https://arxiv.org/abs/2411.16085

جيثب:

https://github.com/kyleliang919/C-Optim

يوفر ظهور C-AdamW طريقة جديدة للتفكير لحل مشكلات الكفاءة واستهلاك الطاقة للتدريب على النماذج الكبيرة. إن كفاءته العالية وتكلفته المنخفضة تجعله يتمتع بآفاق تطبيق واسعة، ويستحق التطلع إلى تطويره في هذا المجال التعلم العميق في المستقبل.