أطلقت NVIDIA بسرعة وحدات معالجة الرسومات GB300 وB300، وحققت تحسينات كبيرة في الأداء بعد نصف عام فقط من إصدار GB200 وB200، خاصة في نماذج الاستدلال. هذه ليست مجرد ترقية بسيطة للأجهزة، ولكنها تمثل أيضًا تعديل التخطيط الاستراتيجي لـ NVIDIA في مجال تسريع الذكاء الاصطناعي، والذي سيكون له تأثير عميق على الصناعة. يكمن جوهر هذه الترقية في قفزة هائلة في أداء الاستدلال، فضلاً عن تحسين الذاكرة والهندسة المعمارية، مما سيؤثر بشكل مباشر على كفاءة وتكلفة نماذج اللغات الكبيرة.

بعد 6 أشهر فقط من إصدار GB200 وB200، أطلقت Nvidia مرة أخرى وحدات معالجة الرسوميات الجديدة GB300 وB300. قد يبدو هذا بمثابة ترقية صغيرة، لكنه في الواقع يحتوي على تغييرات ضخمة، وخاصة التحسن الكبير في أداء نموذج الاستدلال، والذي سيكون له تأثير عميق على الصناعة بأكملها.

B300/GB300: قفزة هائلة في أداء الاستدلال

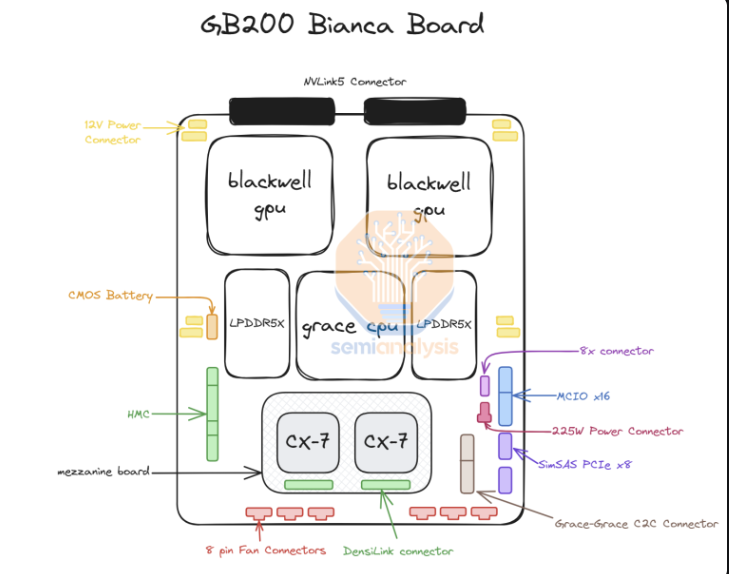

يستخدم B300GPU عقدة عملية 4NP الخاصة بـ TSMC وهو مُحسّن لرقائق الحوسبة. وهذا يجعل أداء FLOPS لـ B300 أعلى بنسبة 50% من أداء B200. يأتي جزء من تحسين الأداء من زيادة TDP. يصل TDP لـ GB300 وB300HGX إلى 1.4KW و1.2KW على التوالي (GB200 وB200 هما 1.2KW و1KW على التوالي). وتأتي مكاسب الأداء المتبقية من التحسينات المعمارية والتحسينات على مستوى النظام، مثل التوزيع الديناميكي للطاقة بين وحدة المعالجة المركزية ووحدة معالجة الرسومات.

بالإضافة إلى الزيادة في FLOPS، تمت ترقية الذاكرة أيضًا إلى 12-Hi HBM3E، وتمت زيادة سعة HBM لكل وحدة معالجة رسومات إلى 288 جيجابايت. ومع ذلك، تظل سرعة الدبوس دون تغيير، وبالتالي فإن عرض النطاق الترددي للذاكرة لكل وحدة معالجة رسومات لا يزال 8 تيرابايت/ثانية. ومن الجدير بالذكر أن سامسونج فشلت في دخول سلسلة التوريد GB200 أو GB300.

بالإضافة إلى ذلك، قامت Nvidia أيضًا بإجراء تعديلات على الأسعار. سيؤثر هذا على هامش ربح منتجات Blackwell إلى حد ما، ولكن الأهم من ذلك، أن تحسين أداء B300/GB300 سوف ينعكس بشكل أساسي في نموذج الاستدلال.

مصممة لنماذج الاستدلال

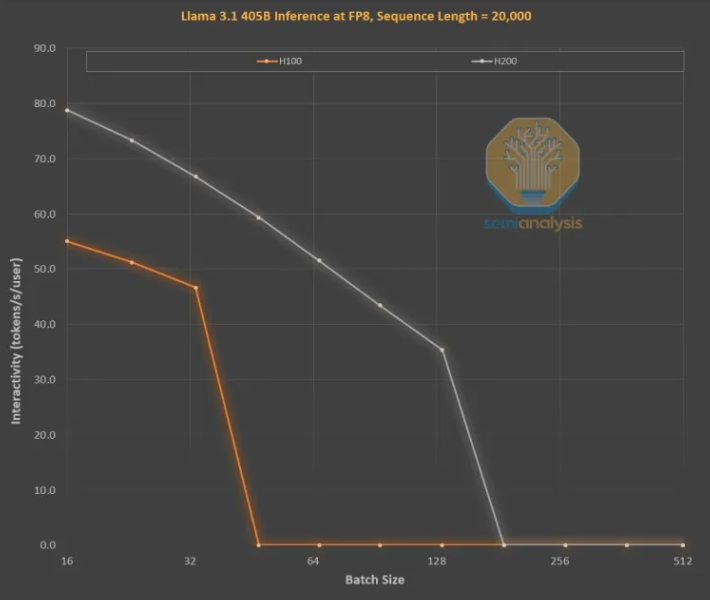

تعد تحسينات الذاكرة أمرًا بالغ الأهمية للتدريب الاستدلالي على نمط OpenAI O3 LLM، حيث تعمل التسلسلات الطويلة على زيادة KVCache، مما يحد من حجم الدفعة المهمة ووقت الاستجابة. أدت الترقية من H100 إلى H200 (زيادة الذاكرة بشكل أساسي) إلى تحسينات في الجانبين التاليين:

أدى عرض النطاق الترددي الأعلى للذاكرة (4.8 تيرابايت/ثانية على H200 و3.35 تيرابايت/ثانية على H100) إلى تحسن عام بنسبة 43% في التفاعل عبر جميع أحجام الدُفعات القابلة للمقارنة.

نظرًا لأن H200 يشغل حجم دفعة أكبر من H100، فإن عدد الرموز المميزة التي يتم إنشاؤها في الثانية يزيد بمقدار 3 مرات، وتنخفض التكلفة بحوالي 3 مرات. يرجع هذا الاختلاف بشكل أساسي إلى تقييد KVCache لحجم الدفعة الإجمالي.

يعد تحسين أداء سعة الذاكرة الأكبر أمرًا ضخمًا. إن الأداء والاختلافات الاقتصادية بين وحدتي معالجة الرسوميات أكبر بكثير مما توحي به المواصفات:

يمكن أن تكون تجربة المستخدم مع نماذج الاستدلال سيئة بسبب وجود زمن استجابة كبير بين الطلبات والاستجابات. إذا كان من الممكن تسريع وقت الاستدلال بشكل كبير، فسيتم زيادة رغبة المستخدمين في الاستخدام والدفع.

يعد التحسن بمقدار 3 أضعاف في أداء الأجهزة من خلال ترقيات ذاكرة الجيل المتوسط أمرًا مذهلاً وأسرع بكثير من قانون مور أو قانون هوانغ أو أي تحسين آخر للأجهزة شهدناه.

بشكل عام، لا يعد إطلاق NVIDIA B300/GB300 قفزة أخرى في تقنية GPU فحسب، بل يعد أيضًا ترويجًا قويًا لتطبيق نماذج استدلال الذكاء الاصطناعي، وسيؤدي إلى تحسين تجربة المستخدم بشكل كبير وتقليل التكاليف، مما يؤدي إلى صناعة الذكاء الاصطناعي الدخول في مرحلة جديدة من التطور.