يعد تدريب نماذج الذكاء الاصطناعي الكبيرة أمرًا مكلفًا، كما أن متطلباتها الضخمة من الموارد تحد من تطبيقها على نطاق واسع وتثير المخاوف بشأن كفاءة استخدام الطاقة والأثر البيئي. أساليب التدريب التقليدية غير فعالة، وتعتمد على مصفوفات كثيفة، وتتطلب كميات كبيرة من الذاكرة وقدرة الحوسبة. وعلى الرغم من أن بعض الأساليب الحالية تحاول التخفيف من حدة هذه المشكلات، إلا أنها لا تزال تعاني من قيود في التطبيقات العملية. لذلك، من الضروري تطوير نهج يمكنه تقليل استخدام الذاكرة والتكلفة الحسابية ووقت التدريب في نفس الوقت دون المساس بالأداء.

أصبح تدريب نماذج الذكاء الاصطناعي واسعة النطاق (مثل المحولات ونماذج اللغة) رابطًا رئيسيًا لا غنى عنه في مجال الذكاء الاصطناعي، ولكنه يواجه أيضًا تكاليف حوسبة عالية واستهلاك الذاكرة ومتطلبات الطاقة. على سبيل المثال، يحتوي GPT-3 الخاص بـ OpenAI على 175 مليار معلمة ويتطلب أسابيع من التدريب على وحدة معالجة الرسومات. يحد هذا الطلب الضخم من الموارد من تطبيق هذه التكنولوجيا على المؤسسات واسعة النطاق التي تتمتع بموارد حوسبة وفيرة، بينما يؤدي أيضًا إلى تفاقم المخاوف بشأن كفاءة استخدام الطاقة والأثر البيئي. تعد معالجة هذه التحديات أمرًا بالغ الأهمية لضمان إمكانية الوصول على نطاق أوسع واستدامة تطوير الذكاء الاصطناعي.

أساليب التدريب التقليدية غير فعالة وهناك حاجة ماسة إلى حلول مبتكرة

إطار عمل CoMERA: تدريب فعال من خلال تحسين الموتر التكيفي

أساس CoMERA هو تمثيل الموتر التكيفي، والذي يسمح لطبقات النموذج بتعديل صفوفها ديناميكيًا بناءً على قيود الموارد. من خلال تعديل رتبة الموتر، يتيح الإطار الضغط دون المساس بالسلامة التشغيلية للشبكة العصبية. يتم تحقيق هذا التحسين الديناميكي من خلال عملية تدريب مكونة من مرحلتين:

المراحل المبكرة: التركيز على التقارب المستقر.

المراحل اللاحقة: ضبط الترتيب لتحقيق أهداف ضغط محددة.

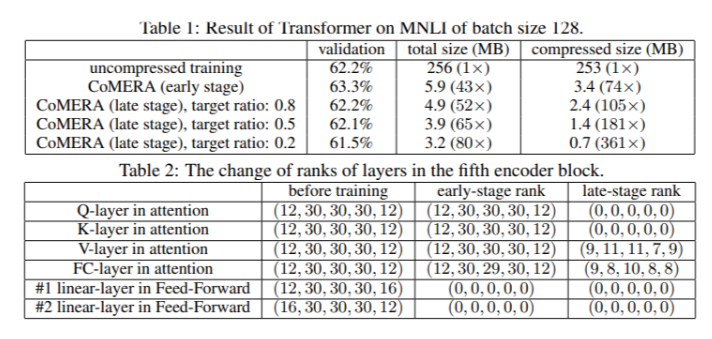

في نموذج المحول المكون من ستة أجهزة تشفير، حققت CoMERA نسبة ضغط تصل إلى 43x في مراحلها المبكرة، ونسبة ضغط أعلى تصل إلى 361x في مراحل التحسين اللاحقة. بالإضافة إلى ذلك، فهو يقلل من استهلاك الذاكرة بمقدار 9 مرات ويسرع التدريب بمقدار 2-3 مرات في كل جولة مقارنة بـ GaLore.

تظهر نتائج الاختبارات المتعددة أن CoMERA يتمتع بأداء ممتاز

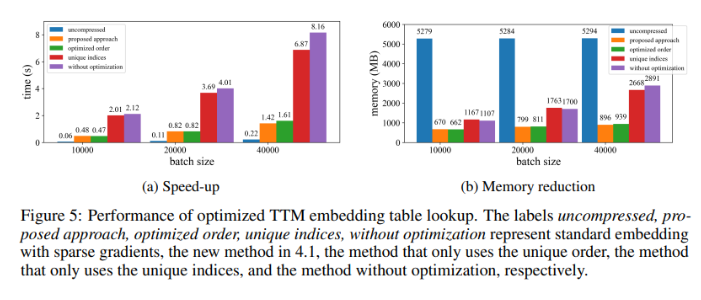

عند تطبيقه على نموذج Transformer الذي تم تدريبه على مجموعة بيانات MNLI، يقوم CoMERA بتقليل حجم النموذج من 256 ميجابايت إلى 3.2 ميجابايت مع الحفاظ على الدقة. في أنظمة التوصية واسعة النطاق مثل DLRM، تقوم CoMERA بضغط النماذج بمقدار 99x وتقليل استخدام الذاكرة الأقصى بمقدار 7x. كان أداء الإطار جيدًا أيضًا في مرحلة ما قبل التدريب CodeBERT، وهو نموذج لغة واسع النطاق خاص بالمجال، حيث حقق نسبة ضغط إجمالية تبلغ 4.23x وحقق تسريعًا بمقدار 2x في بعض مراحل التدريب. تسلط هذه النتائج الضوء على قدرتها على التعامل مع مجموعة متنوعة من المهام والبنيات، مما يزيد من إمكانية تطبيقها في مختلف المجالات.

ملخص الفوائد الرئيسية لإطار عمل CoMERA

الاستنتاجات الرئيسية لهذه الدراسة هي كما يلي:

تحقق CoMERA نسب ضغط تصل إلى 361x لطبقات محددة و99x للنموذج بأكمله، مما يقلل بشكل كبير من متطلبات التخزين والذاكرة.

يعمل إطار العمل هذا على تقليل وقت التدريب لكل جولة من أنظمة المحولات والتوصية بمقدار 2-3 مرات، مما يوفر موارد الحوسبة والوقت.

باستخدام التمثيلات المتوترة والرسوم البيانية CUDA، تقلل CoMERA من ذروة استهلاك الذاكرة بمقدار 7x، مما يجعل التدريب على وحدات معالجة الرسومات الأصغر أمرًا ممكنًا.

يدعم نهج CoMERA بنيات متعددة، بما في ذلك المحولات ونماذج اللغات الكبيرة، مع الحفاظ على الدقة أو تحسينها.

ومن خلال تقليل الطاقة والموارد اللازمة للتدريب، تساعد CoMERA على تمكين ممارسات الذكاء الاصطناعي الأكثر استدامة وتجعل النماذج المتطورة متاحة لجمهور أوسع.

بشكل عام، يوفر إطار عمل CoMERA حلاً مبتكرًا لتدريب نماذج الذكاء الاصطناعي الكبيرة بكفاءة، مما يقلل بشكل كبير من التكاليف الحسابية ومتطلبات الذاكرة من خلال تحسين الموتر التكيفي مع الحفاظ على دقة النموذج. يقدم هذا البحث مساهمة مهمة في التطوير المستمر وإمكانية الوصول على نطاق أوسع إلى مجال الذكاء الاصطناعي.