لقد كانت سرعة فك تشفير نموذج المحولات دائمًا بمثابة عنق الزجاجة الرئيسي الذي يقيد تطبيقه. في الآونة الأخيرة، تغلب باحثون من المعهد الكوري للعلوم والتكنولوجيا، وLG، وDeepMind بشكل مشترك على هذه المشكلة، واقترحوا بنية جديدة تسمى Block Transformer، والتي زادت سرعة فك التشفير بنسبة مذهلة من 10 إلى 20 مرة! يكمن جوهر هذا التطور المذهل في "التشريح" الذكي لآلية انتباه Transformer، والتي تحل بشكل فعال مشكلة الاستخدام المنخفض لوحدة معالجة الرسومات في Transformer التقليدي وتقلل بشكل كبير من حمل الذاكرة.

على الرغم من أن نموذج المحولات قوي، إلا أن كفاءته في فك التشفير كانت دائمًا بمثابة صداع. ومع ذلك، فقد جلب لنا باحثون من المعهد الكوري للعلوم والتكنولوجيا وLG وDeepMind مفاجأة لنا هذه المرة - فقد اقترحوا بنية محولات جديدة تسمى Block Transformer، والتي زادت بشكل مباشر سرعة فك التشفير بمقدار 10 إلى 20 مرة!

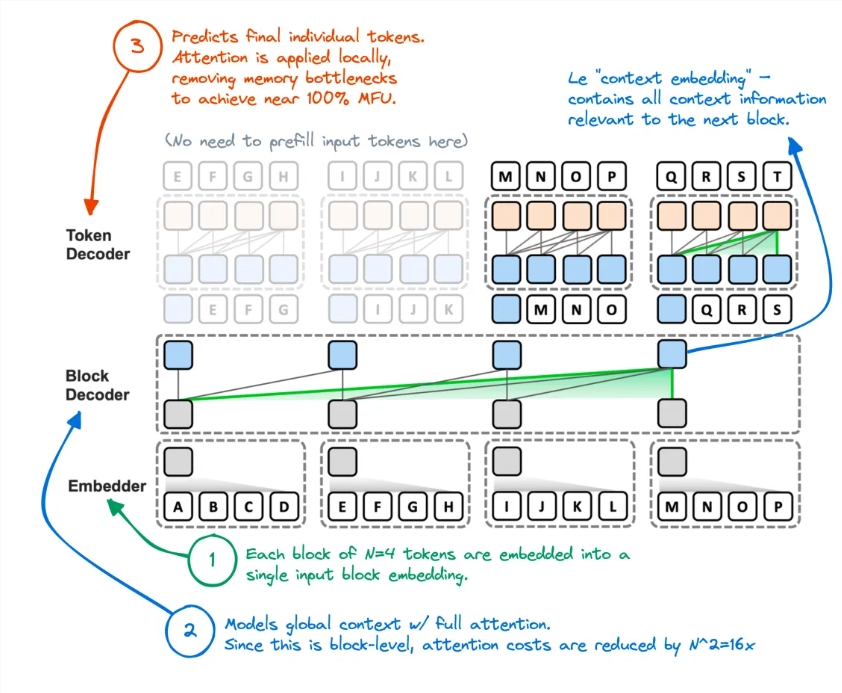

كيف يتم ذلك؟ اتضح أنهم "يقطعون" آلية انتباه المحول. بهذه الطريقة، تم إلغاء الطريقة غير الفعالة التي اتبعها Transformer الأصلي للوصول إلى ذاكرة التخزين المؤقت العالمية لـ KV في كل مرة يتم فيها إنشاء الرمز المميز تمامًا.

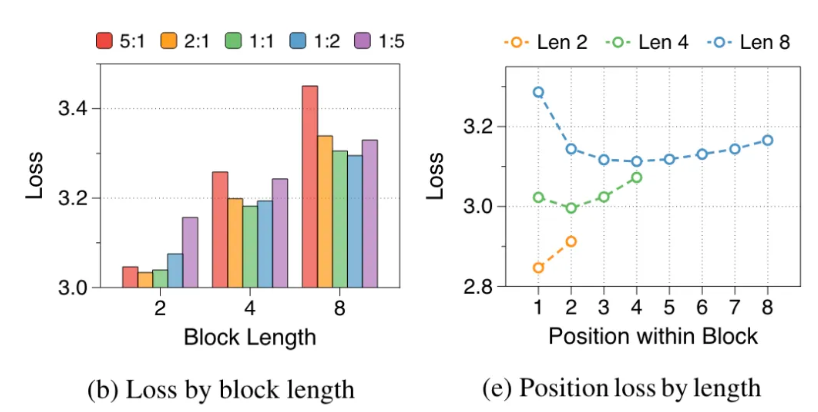

قام الباحثون بتحليل عيوب المحول الأصلي: كان الاستخدام الفعال لوحدة معالجة الرسومات أقل من 1%، وتم استخدام 99% المتبقية للوصول إلى الذاكرة. من الواضح أن هذا غير معقول، لذلك اقترحوا Block Transformer. تستخدم هذه البنية الجديدة تحليل الاهتمام على مستوى الكتلة والاهتمام داخل الكتلة لجعل إنتاجية الاستدلال للنموذج تنفجر مباشرة.

على وجه التحديد، يكون سير عمل Block Transformer كما يلي: قم أولاً بقص التسلسل إلى كتل، ثم استخدم Embedder لتحويل كل كتلة إلى متجه التضمين. وحدة فك ترميز الكتل مسؤولة عن معالجة متجهات تضمين الكتل والتقاط التبعيات العالمية بين الكتل؛ وحدة فك ترميز الرموز مسؤولة عن معالجة التبعيات المحلية بين الرموز المميزة وإنشاء تسلسلات الرموز المميزة.

لا تعمل هذه الطريقة على تحسين سرعة الاستدلال فحسب، بل تقلل أيضًا من حمل الذاكرة بشكل كبير. قال بعض مستخدمي الإنترنت إن لديهم فكرة مماثلة من قبل، لكن أداء النموذج الناتج لم يكن كافيًا الآن، ويبدو أن هذه الطريقة قد قللت بشكل فعال من ذاكرة التخزين المؤقت لـ KV.

علاوة على ذلك، فإن دقة Block Transformer في المهام الصفرية المتعددة يمكن مقارنتها أو حتى أعلى قليلاً من دقة Transformer الأصلية من نفس الحجم، مما يثبت أنه يحسن الكفاءة دون التضحية بالجودة.

الآثار المترتبة على هذا البحث لا تتوقف عند هذا الحد. كما أنه يقلل من تكلفة تدريب النموذج، ويتم تقليل الحمل الثانوي للوصول إلى الذاكرة للانتباه العالمي بمقدار 16 مرة، كما يتم زيادة استخدام وحدة معالجة الرسومات من 1% إلى 44%.

عنوان الورقة: https://arxiv.org/abs/2406.02657

أدى ظهور Block Transformer إلى توسيع الإمكانيات الجديدة لتطبيق نماذج Transformer، كما قدم اتجاهًا جديدًا لتحسين كفاءة نماذج اللغة واسعة النطاق في المستقبل. ومن المتوقع أن يؤدي التحسن الكبير في السرعة والكفاءة إلى تعزيز مواصلة تطوير وتطبيق تكنولوجيا الذكاء الاصطناعي.