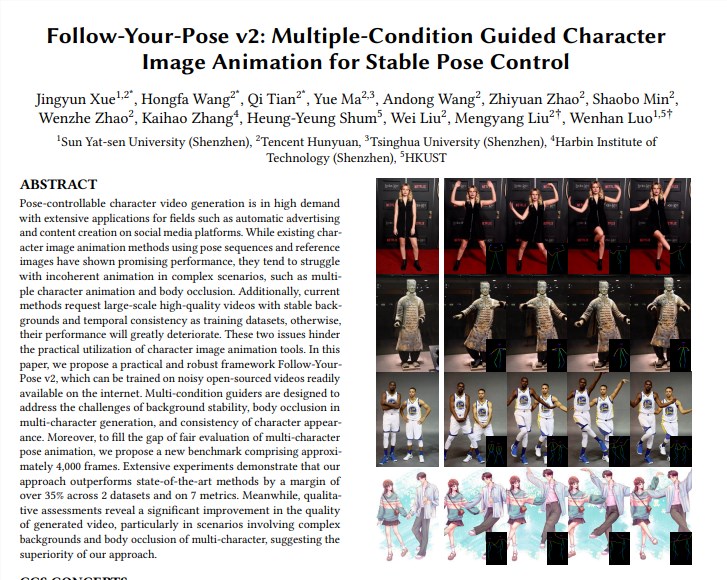

تعاون فريق Tencent Hunyuan مع جامعة Sun Yat-sen وجامعة هونغ كونغ للعلوم والتكنولوجيا لإطلاق نموذج فيديو Tusheng الجديد "Follow-Your-Pose-v2"، مما حقق طفرة في تكنولوجيا توليد الفيديو من فرد واحد إلى عدة أشخاص. يمكن لهذا النموذج التعامل مع الصور الجماعية لعدة أشخاص وجعل الأشخاص الموجودين في الصور يتحركون في الفيديو الذي تم إنشاؤه في نفس الوقت، مما يحسن بشكل كبير كفاءة وجودة إنشاء الفيديو. أهم ما يميز تقنيتها هو أنها تدعم إنشاء إجراءات فيديو متعددة الأشخاص، ولديها إمكانات تعميم قوية، ويمكن تدريبها وإنشاؤها باستخدام صور/مقاطع فيديو الحياة اليومية، ويمكنها التعامل بشكل صحيح مع مشكلات مثل انسداد الشخصية. ويتفوق النموذج على التقنيات الحالية في مجموعات بيانات متعددة، مما يدل على أدائه القوي وآفاق التطبيق الواسعة.

دعم إنشاء إجراءات فيديو متعددة الأشخاص: تحقيق إنشاء إجراءات فيديو متعددة الأشخاص مع تفكير أقل استهلاكًا للوقت.

قدرة تعميم قوية: يمكن إنشاء مقاطع فيديو عالية الجودة بغض النظر عن العمر أو الملابس أو العرق أو فوضى الخلفية أو تعقيد الإجراء.

تتوفر صور/مقاطع فيديو للحياة اليومية: يمكن لتدريب النماذج وتوليدها استخدام صور الحياة اليومية (بما في ذلك اللقطات) أو مقاطع الفيديو، دون البحث عن صور/مقاطع فيديو عالية الجودة.

التعامل بشكل صحيح مع إطباق الأحرف: في مواجهة مشكلة أجسام الشخصيات المتعددة التي تحجب بعضها البعض في صورة واحدة، يمكنها إنشاء صورة إطباق مع العلاقة الصحيحة من الأمام إلى الخلف.

التنفيذ الفني:

يستخدم النموذج "دليل التدفق البصري" لتقديم معلومات التدفق البصري في الخلفية، والتي يمكن أن تولد رسوم متحركة ثابتة في الخلفية حتى عندما تهتز الكاميرا أو تكون الخلفية غير مستقرة.

من خلال "دليل خريطة الاستدلال" و"دليل خريطة العمق"، يمكن للنموذج فهم المعلومات المكانية للأحرف الموجودة في الصورة بشكل أفضل وعلاقات الموقع المكاني لأحرف متعددة، وحل مشاكل الرسوم المتحركة متعددة الأحرف وانسداد الجسم بشكل فعال .

التقييم والمقارنة:

اقترح الفريق معيارًا جديدًا للأحرف المتعددة، والذي يحتوي على حوالي 4000 إطار من مقاطع الفيديو متعددة الأحرف لتقييم تأثير إنشاء الأحرف المتعددة.

تظهر النتائج التجريبية أن "Follow-Your-Pose-v2" يتفوق على أحدث التقنيات بنسبة تزيد عن 35% في مجموعتين من البيانات العامة (خطابات TikTok وTED) و7 مؤشرات.

آفاق التطبيق:

تتمتع تقنية تحويل الصورة إلى فيديو بآفاق تطبيقية واسعة في العديد من الصناعات مثل إنتاج محتوى الأفلام والواقع المعزز وإنتاج الألعاب والإعلان، وهي إحدى تقنيات الذكاء الاصطناعي التي ستجذب الكثير من الاهتمام في عام 2024.

معلومات إضافية:

أعلن فريق Hunyuan من Tencent أيضًا عن مكتبة تسريع للنموذج الكبير مفتوح المصدر للرسوم البيانية Vincentian (Hunyuan DiT)، والتي تعمل على تحسين كفاءة التفكير بشكل كبير وتقصير وقت إنشاء الرسم البياني بنسبة 75%.

تم تخفيض الحد الأدنى لاستخدام نموذج Hunyuan DiT. يمكن للمستخدمين استدعاء النموذج في مكتبة النماذج الرسمية لـ Hugging Face بثلاثة أسطر من التعليمات البرمجية.

عنوان الورقة: https://arxiv.org/pdf/2406.03035

صفحة المشروع: https://top.aibase.com/tool/follow-your-pose

يمثل ظهور نموذج "Follow-Your-Pose-v2" إنجازًا كبيرًا في تكنولوجيا الفيديو الخاصة بشركة Tusheng، وتستحق آفاق تطبيقه في العديد من المجالات التطلع إليها. في المستقبل، مع التطوير والتحسين المستمر للتكنولوجيا، يُعتقد أن هذا النموذج سيلعب دورًا مهمًا في المزيد من السيناريوهات وسيوفر للناس تجربة أكثر ملاءمة وذكاءً لتوليد الفيديو.