غالبًا ما يكون تأثير التطبيق العملي لنماذج اللغة التوليدية محدودًا باستراتيجية فك التشفير في مرحلة الاستدلال. تركز الأساليب الحالية مثل RLHF بشكل أساسي على معدل فوز النموذج وتتجاهل تأثير استراتيجيات فك التشفير على أداء النموذج، مما يؤدي إلى انخفاض الكفاءة وصعوبة ضمان جودة المخرجات. ومن أجل حل هذه المشكلة، اقترح Google DeepMind وفريق بحث Google إطار عمل InfAlign، الذي يهدف إلى الجمع بين استراتيجية الاستدلال مع عملية محاذاة النموذج لتحسين أداء الاستدلال وموثوقية النموذج.

تواجه نماذج اللغة التوليدية العديد من التحديات في العملية بدءًا من التدريب وحتى التطبيقات العملية. إحدى المشكلات الرئيسية هي كيفية تحقيق الأداء الأمثل للنموذج أثناء مرحلة الاستدلال.

تركز التدابير المضادة الحالية، مثل التعلم المعزز من خلال ردود الفعل البشرية (RLHF)، بشكل أساسي على تحسين معدل الفوز للنموذج، ولكنها غالبًا ما تتجاهل استراتيجيات فك التشفير أثناء الاستدلال، مثل أخذ العينات الأفضل من N وفك التشفير المتحكم فيه. هذه الفجوة بين أهداف التدريب والاستخدام الفعلي يمكن أن تؤدي إلى عدم الكفاءة وتؤثر على جودة وموثوقية المخرجات.

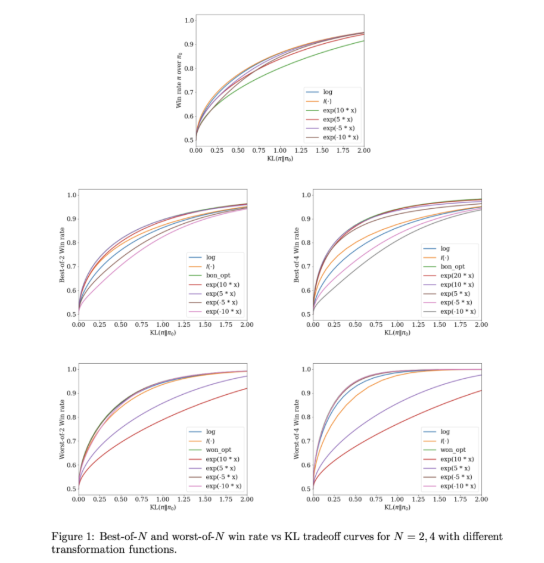

ولمعالجة هذه المشكلات، قام Google DeepMind وفريق أبحاث Google بتطوير InfAlign، وهو إطار عمل للتعلم الآلي مصمم ليتم دمجه مع استراتيجيات الاستدلال. يدمج InfAlign أساليب وقت الاستدلال في عملية المحاذاة ويسعى جاهداً لسد الفجوة بين التدريب والتطبيق. إنها تعتمد طريقة تعلم معززة معايرة لضبط وظيفة المكافأة بناءً على استراتيجية استدلال محددة. يعد InfAlign فعالاً بشكل خاص مع تقنيات مثل أخذ عينات Best-of-N (توليد استجابات متعددة واختيار الأفضل) وأسوأ-of-N (يشيع استخدامه في تقييمات السلامة)، مما يضمن أداء النموذج المحاذي في كل من البيئات الخاضعة للرقابة والواقعية -سيناريوهات العالم جيدة.

جوهر InfAlign هو خوارزمية المعايرة والتعلم المعزز للتحويل (CTRL)، والتي تتبع ثلاث خطوات: معايرة درجات المكافأة، وتحويل هذه الدرجات وفقًا لاستراتيجية الاستدلال، وحل مشكلة التحسين المنتظمة في KL. يعمل InfAlign على مواءمة أهداف التدريب مع متطلبات الاستدلال من خلال تخصيص تحويلات المكافآت لسيناريوهات محددة. لا تعمل هذه الطريقة على تحسين معدل الفوز أثناء الاستدلال فحسب، بل تحافظ أيضًا على الكفاءة الحسابية. بالإضافة إلى ذلك، يعمل InfAlign على تعزيز قوة النموذج، مما يسمح له بالتعامل بفعالية مع استراتيجيات فك التشفير المختلفة وإنتاج مخرجات متسقة عالية الجودة.

يتم التحقق من فعالية InfAlign في التجارب باستخدام مجموعات بيانات Anthropic الخاصة بالفائدة وعدم الضرر. بالمقارنة مع الطرق الحالية، يعمل InfAlign على تحسين معدل الفوز بالاستدلال بنسبة 8% - 12% في أخذ العينات Best-of-N و4%-9% في تقييم الأمان الأسوأ من بين N. ترجع هذه التحسينات إلى تحويل المكافأة المُعاير، والذي يحل بشكل فعال مشكلة المعايرة الخاطئة لنموذج المكافأة ويضمن أداءً متسقًا في سيناريوهات الاستدلال المختلفة.

يمثل InfAlign تقدمًا مهمًا في محاذاة نماذج اللغة التوليدية. ومن خلال دمج الاستراتيجيات المدركة للاستدلال، يعالج InfAlign الفرق الحاسم بين التدريب والنشر. يسلط أساسها النظري القوي ونتائجها التجريبية الضوء على قدرتها على تحسين محاذاة نظام الذكاء الاصطناعي بشكل شامل.

الرابط: https://arxiv.org/abs/2412.19792

أبرز النقاط:

InfAlign هو إطار عمل جديد تم تطويره بواسطة Google DeepMind، يهدف إلى تحسين أداء نماذج اللغة في مرحلة الاستدلال.

يقوم هذا الإطار بضبط وظيفة المكافأة لاستراتيجية الاستدلال من خلال أساليب التعلم المعزز المعايرة لتحقيق التوافق بين أهداف التدريب ومتطلبات الاستدلال.

تظهر النتائج التجريبية أن InfAlign يحسن بشكل كبير معدل فوز النموذج بالاستدلال في مهام متعددة، مما يدل على القدرة على التكيف والموثوقية الجيدة.

يوفر ظهور إطار InfAlign أفكارًا جديدة لحل مشكلات الكفاءة والجودة لنماذج اللغة التوليدية في مرحلة الاستدلال، وتستحق مساهمتها في تحسين قوة النموذج وموثوقيته الاهتمام. يمكن للأبحاث المستقبلية أن تستكشف تطبيق InfAlign على نماذج ومهام مختلفة لتعزيز التطوير المستمر لتكنولوجيا الذكاء الاصطناعي التوليدية.