يعد تقليل تكلفة التدريب على النماذج الكبيرة نقطة اهتمام بحثية حالية في مجال الذكاء الاصطناعي. يناقش البحث الأخير الذي أصدره فريق Tencent Hunyuan بعمق قواعد مقياس التدريب على تكميم النقطة العائمة ذات البت المنخفض، ويقدم أفكارًا جديدة للتدريب الفعال للنماذج الكبيرة. من خلال عدد كبير من التجارب، قامت هذه الدراسة بتحليل تأثير عوامل مثل حجم النموذج، وحجم بيانات التدريب، ودقة القياس الكمي على تأثير التدريب، وأخيراً توصلت إلى قواعد حول كيفية تخصيص موارد التدريب بشكل فعال في ظل دقة مختلفة للحصول على أفضل النتائج. ليس لهذا البحث أهمية نظرية مهمة فحسب، بل يوفر أيضًا إرشادات قيمة للتطبيق العملي للنماذج الكبيرة.

اليوم، مع التطور السريع لنموذج اللغة الكبير (LLM)، أصبحت تكلفة تدريب النموذج والاستدلال بشكل متزايد محور البحث والتطبيق. في الآونة الأخيرة، أصدر فريق Tencent Hunyuan دراسة مهمة، والتي استكشفت بعمق "قوانين القياس" للتدريب على تكميم النقطة العائمة منخفضة البت، أي قانون القياس للتدريب على تكميم النقطة العائمة. جوهر هذا البحث هو استكشاف كيفية تقليل تكاليف الحوسبة والتخزين بشكل كبير دون فقدان الأداء عن طريق تقليل دقة النموذج.

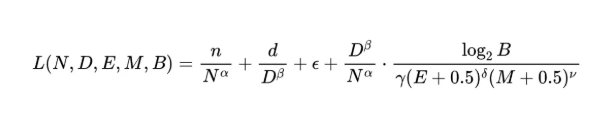

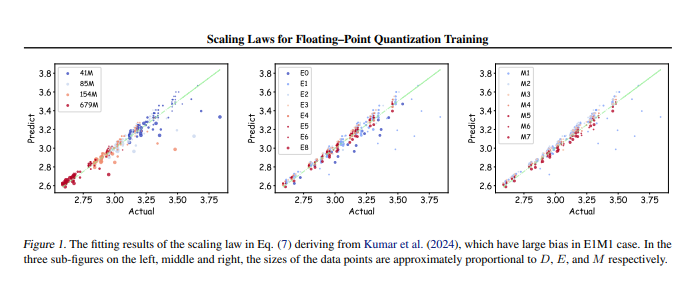

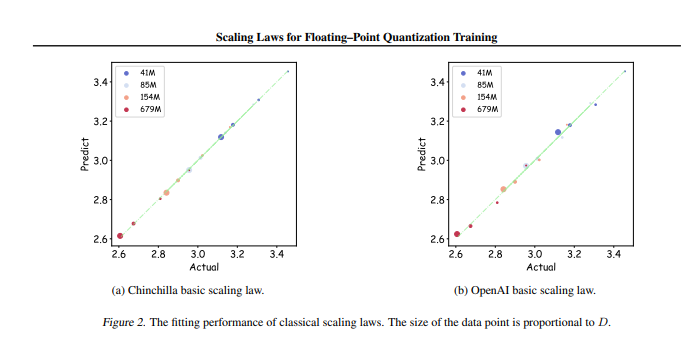

أجرى فريق البحث ما يصل إلى 366 مجموعة من التدريب الكمي بالفاصلة العائمة بأحجام ودقة معلمات مختلفة، وقام بتحليل منهجي للعوامل المختلفة التي تؤثر على تأثير التدريب، بما في ذلك حجم النموذج (N)، وحجم بيانات التدريب (D)، والبت الأسي (E). )، بتات الجزء العشري (M) وتفاصيل التكميم (B). من خلال هذه التجارب، استنتج الباحثون مجموعة موحدة من قانون القياس، والتي كشفت عن كيفية تكوين بيانات التدريب ومعلمات النموذج بشكل فعال تحت دقة مختلفة للحصول على أفضل تأثير للتدريب.

الشيء الأكثر أهمية هو أن البحث يشير إلى أنه في التدريب التعسفي المنخفض الدقة لتقدير الفاصلة العائمة، هناك "تأثير محدود"، أي أنه في ظل كمية محددة من البيانات، سيصل أداء النموذج إلى المستوى الأمثل، ويتجاوز قد تتسبب هذه الكمية من البيانات في حدوث انخفاض. بالإضافة إلى ذلك، وجدت الدراسة أيضًا أن أفضل دقة للتدريب على تحديد النقطة العائمة فعالة من الناحية النظرية يجب أن تتراوح بين 4 و8 بتات، وهو ما له أهمية توجيهية مهمة لتطوير LLM فعال.

لا يسد هذا البحث الفجوة في مجال التدريب على قياس الفاصلة العائمة فحسب، بل يوفر أيضًا مرجعًا لمصنعي الأجهزة في المستقبل لمساعدتهم على تحسين قدرات حوسبة الفاصلة العائمة في ظل دقة مختلفة. في النهاية، يوفر هذا البحث اتجاهًا واضحًا لممارسة التدريب النموذجي الكبير، مما يضمن إمكانية تحقيق تأثيرات التدريب الفعالة حتى مع الموارد المحدودة.

عنوان الورقة: https://arxiv.org/pdf/2501.02423

باختصار، يوفر هذا البحث الذي أجراه فريق Tencent Hunyuan حلاً فعالاً لتقليل تكلفة تدريب النماذج الكبيرة. سيكون لقواعد النطاق ونطاق الدقة الأمثل المكتشفين تأثير عميق على تطوير النماذج الكبيرة وتطبيقها في المستقبل. يشير هذا العمل إلى الاتجاه نحو التدريب على النماذج الكبيرة عالية الأداء ومنخفضة التكلفة، الأمر الذي يستحق الاهتمام والبحث المتعمق.