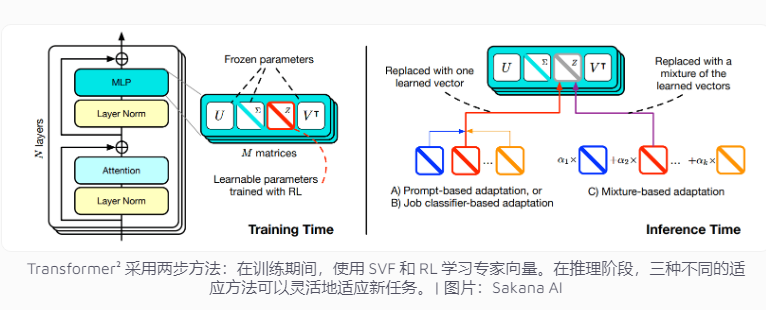

أصدرت شركة Sakana AI اليابانية مؤخرًا تقنية Transformer²، وهي تقنية مبتكرة مصممة لتحسين القدرة على التكيف في مهام نماذج اللغة. على عكس أنظمة الذكاء الاصطناعي التقليدية التي تحتاج إلى معالجة مهام متعددة في وقت واحد، يستخدم Transformer² التعلم على مرحلتين، باستخدام ناقلات الخبراء وتقنية الضبط الدقيق للقيمة الفردية (SVF)، بحيث يمكنه التكيف بكفاءة مع المهام الجديدة دون إعادة تدريب الشبكة بأكملها، بشكل كبير وهذا يقلل بشكل كبير من استهلاك الموارد ويحسن مرونة النموذج ودقته. تركز هذه التقنية على مهام محددة مثل العمليات الرياضية والبرمجة والتفكير المنطقي من خلال تعلم ناقلات الخبراء التي تتحكم في أهمية اتصالات الشبكة، وتجمع بين التعلم المعزز لتحسين أداء النموذج بشكل أكبر.

تحتاج أنظمة الذكاء الاصطناعي الحالية عادةً إلى التعامل مع مهام متعددة في تدريب واحد، ومع ذلك، فهي عرضة لمواجهة تحديات غير متوقعة عند مواجهة مهام جديدة، مما يؤدي إلى محدودية قدرة النموذج على التكيف. يهدف مفهوم تصميم Transformer² إلى حل هذه المشكلة، وذلك باستخدام تقنية الضبط الدقيق للقيمة الفردية (SVF) المتخصصة لتمكين النموذج من التعامل بمرونة مع المهام الجديدة دون إعادة تدريب الشبكة بأكملها.

تتطلب أساليب التدريب التقليدية تعديل أوزان الشبكة العصبية بأكملها، وهو أمر ليس مكلفًا فحسب، بل قد يتسبب أيضًا في "نسيان" النموذج للمعرفة التي تم تعلمها مسبقًا. في المقابل، تتجنب تقنيات SVF هذه المشكلات من خلال تعلم ناقلات الخبراء التي تتحكم في أهمية كل اتصال بالشبكة. تساعد المتجهات المتخصصة النموذج على التركيز على مهام محددة، مثل العمليات الرياضية والبرمجة والتفكير المنطقي، عن طريق ضبط مصفوفة الوزن لاتصالات الشبكة.

يقلل هذا الأسلوب بشكل كبير من عدد المعلمات المطلوبة لتكييف النموذج مع المهام الجديدة. على سبيل المثال، تتطلب طريقة LoRA 6.82 مليون معلمة، بينما يتطلب SVF 160,000 معلمة فقط. وهذا لا يقلل من استهلاك الذاكرة وقوة المعالجة فحسب، بل يمنع النموذج أيضًا من نسيان المعرفة الأخرى أثناء التركيز على مهمة معينة. والأهم من ذلك، يمكن لهذه النواقل الخبيرة أن تعمل معًا بشكل فعال لتحسين قدرة النموذج على التكيف مع المهام المتنوعة.

لتحسين القدرة على التكيف بشكل أكبر، يقدم Transformer² التعلم المعزز. أثناء عملية التدريب، يعمل النموذج باستمرار على تحسين المتجهات المتخصصة من خلال اقتراح حلول المهام والحصول على التعليقات، وبالتالي تحسين الأداء في المهام الجديدة. طور الفريق ثلاث استراتيجيات للاستفادة من هذه المعرفة المتخصصة: الإشارات التكيفية، ومصنفات المهام، والتكيف مع اللقطات القليلة. على وجه الخصوص، تعمل الإستراتيجية التكيفية ذات اللقطات القليلة على تحسين مرونة النموذج ودقته من خلال تحليل أمثلة للمهام الجديدة وضبط المتجهات المتخصصة.

يتفوق Transformer² على طريقة LoRA التقليدية في معايير متعددة. وفي المهام الرياضية، زاد أدائها بنسبة 16%، وانخفضت المعلمات المطلوبة بشكل كبير. عند مواجهة مهمة جديدة، كانت دقة Transformer² أعلى بنسبة 4% من النموذج الأصلي، بينما فشلت LoRA في تحقيق النتائج المتوقعة.

لا يحل Transformer² المشكلات الرياضية المعقدة فحسب، بل يجمع أيضًا بين قدرات البرمجة والتفكير المنطقي لتحقيق مشاركة المعرفة عبر المجالات. على سبيل المثال، اكتشف الفريق أن النماذج الأصغر يمكنها أيضًا تحسين الأداء من خلال الاستفادة من معرفة النماذج الأكبر حجمًا عن طريق نقل المتجهات المتخصصة، مما يوفر إمكانيات جديدة لمشاركة المعرفة بين النماذج.

على الرغم من أن Transformer² قد حقق تقدمًا كبيرًا في القدرة على التكيف مع المهام، إلا أنه لا يزال يواجه بعض القيود. في الوقت الحالي، لا يمكن للموجهين الخبراء المدربين باستخدام SVF الاعتماد إلا على القدرات الموجودة في النموذج المُدرب مسبقًا ولا يمكنهم إضافة مهارات جديدة تمامًا. يعني التعلم المستمر الحقيقي أن النموذج يمكنه تعلم مهارات جديدة بشكل مستقل. ولا يزال تحقيق هذا الهدف يستغرق وقتًا. تظل كيفية توسيع نطاق هذه التقنية عبر النماذج الكبيرة التي تحتوي على أكثر من 70 مليار معلمة سؤالًا مفتوحًا.

بشكل عام، يُظهر Transformer² إمكانات كبيرة في مجال التعلم المستمر، ويوفر استخدامه الفعال للموارد والتحسين الكبير في الأداء اتجاهًا جديدًا لتطوير نماذج اللغة المستقبلية. ومع ذلك، لا تزال التكنولوجيا بحاجة إلى التحسين المستمر للتغلب على القيود الحالية وتحقيق أهداف التعلم المستمر الحقيقية.