حقق Codestral 25.01، وهو أحدث نموذج ترميز مفتوح المصدر أصدرته شركة Mistral، تحسينات كبيرة في الأداء وهو أسرع بمرتين من الجيل السابق. كنسخة مطورة من Codestral، يرث Codestral 25.01 خصائص التشغيل ذات زمن الوصول المنخفض والتردد العالي، وتم تحسينه للتطبيقات على مستوى المؤسسة، ودعم المهام مثل تصحيح التعليمات البرمجية، وإنشاء الاختبار، والتعبئة المتوسطة. إن أدائها الممتاز في اختبار ترميز Python، وخاصة النتيجة العالية البالغة 86.6% في اختبار HumanEval، يجعلها الرائدة بين نماذج الترميز الحالية ذات الوزن الثقيل، متجاوزة العديد من المنتجات المماثلة.

على غرار Codestral الأصلي، لا يزال Codestral 25.01 يركز على العمليات ذات زمن الوصول المنخفض والتردد العالي، ويدعم تصحيح التعليمات البرمجية، وتوليد الاختبار، ومهام التعبئة المتوسطة. وقالت ميسترال إن هذا الإصدار مناسب بشكل خاص للمؤسسات التي تتطلب المزيد من البيانات وإقامة النماذج. تُظهر الاختبارات المعيارية أن أداء Codestral25.01 يفوق التوقعات في اختبار ترميز Python، حيث حصل على درجة اختبار HumanEval تبلغ 86.6%، وهو ما يتجاوز بكثير الإصدار السابق، Codellama70B Instruct وDeepSeek Coder33B Instruct.

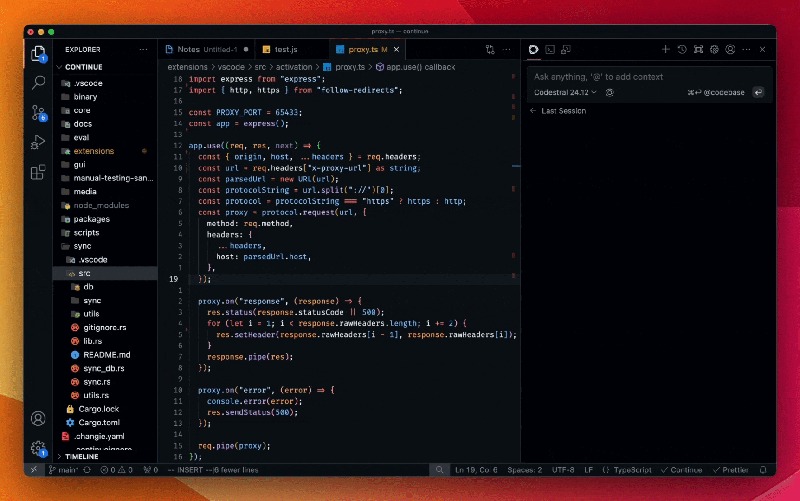

يمكن للمطورين الوصول إلى النموذج من خلال البرنامج الإضافي Mistral IDE بالإضافة إلى أداة النشر المحلية، بالإضافة إلى ذلك، توفر Mistral أيضًا الوصول إلى واجهة برمجة التطبيقات من خلال Google Vertex AI وMistral la Plateforme. النموذج متاح حاليًا للمعاينة على Azure AI Foundry وسيكون متاحًا قريبًا على منصة Amazon Bedrock.

منذ إصدارها في العام الماضي، أصبحت Codestral من Mistral رائدة في نموذج مفتوح المصدر يركز على التعليمات البرمجية. الإصدار الأول من Codestral هو نموذج معلمة 22B يدعم ما يصل إلى 80 لغة ويتمتع بأداء ترميز أفضل من العديد من المنتجات المماثلة. بعد ذلك مباشرة، أطلقت ميسترال Codestral-Mamba، وهو نموذج لتوليد التعليمات البرمجية يعتمد على بنية Mamba التي يمكنها التعامل مع سلاسل التعليمات البرمجية الأطول والتعامل مع المزيد من متطلبات الإدخال.

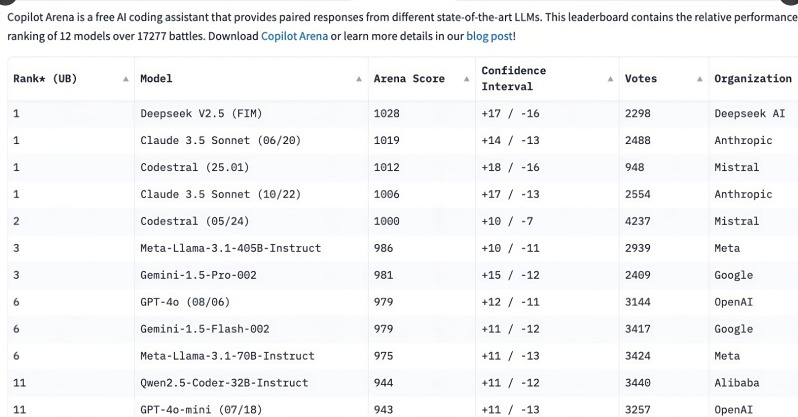

اجتذب إطلاق Codestral 25.01 اهتمامًا واسع النطاق من المطورين، حيث احتل المرتبة الأولى في تصنيفات C o Pilot Arena في غضون ساعات قليلة من الإصدار. يوضح هذا الاتجاه أن نماذج الترميز المتخصصة أصبحت بسرعة الخيار الأول للمطورين، خاصة في مجال مهام الترميز، ومقارنة بالنماذج العامة متعددة الوظائف، أصبحت الحاجة إلى نماذج ترميز مركزة واضحة بشكل متزايد.

على الرغم من أن النماذج ذات الأغراض العامة مثل OpenAI’s o3 وAnthropic’s Claude يمكنها أيضًا التشفير، إلا أن نماذج التشفير المحسنة خصيصًا تميل إلى الأداء بشكل أفضل. في العام الماضي، أصدرت العديد من الشركات نماذج مخصصة للبرمجة، مثل Qwen2.5-Coder من Alibaba وDeepSeek Coder الصيني، وأصبح الأخير أول نموذج يتفوق على GPT-4Turbo. بالإضافة إلى ذلك، أطلقت Microsoft أيضًا GRIN-MoE استنادًا إلى نموذج مزيج الخبراء (MOE)، والذي لا يمكنه فقط البرمجة ولكن أيضًا حل المشكلات الرياضية.

على الرغم من أن المطورين لا يزالون يناقشون ما إذا كانوا سيختارون نماذج للأغراض العامة أو نماذج متخصصة، إلا أن الارتفاع السريع في نماذج الترميز كشف عن حاجة كبيرة لأدوات ترميز فعالة ودقيقة. مع ميزة التدريب الخاص على مهام البرمجة، لا شك أن Codestral25.01 يحتل مكانًا في مستقبل البرمجة.

يمثل إصدار Codestral25.01 خطوة أخرى إلى الأمام في مجال نماذج الترميز الاحترافية. سيؤدي أدائها المتفوق وسهولة الوصول إليها إلى توفير تجربة برمجة أكثر كفاءة للمطورين وتعزيز التطوير الإضافي للذكاء الاصطناعي في مجال تطوير البرمجيات. في المستقبل، نتطلع إلى رؤية المزيد من النماذج الاحترافية المشابهة لتزويد المطورين بمزيد من الخيارات.