تقوم Sakana AI بإطلاق محول نموذج اللغة التكيفي المبتكرة ، والتي تستخدم آلية فريدة من نوعها تعديل الوزن الديناميكي المكونة من خطوتين تتعلم ديناميكيًا وتتكيف مع مهام جديدة أثناء عملية الاستدلال دون ضبط دقيق باهظ الثمن. هذا يمثل تقدماً كبيرًا في تقنية نموذج اللغة الكبير (LLM) ومن المتوقع أن يغير الطريقة التي يتم بها تطبيق LLM لجعلها أكثر كفاءة وتخصيص وعملي. بالمقارنة مع أساليب الضبط التقليدي التقليدي ، يقوم Transformer² بضبط المكونات الرئيسية لأوزان النماذج بشكل انتقائي من خلال تحلل القيمة المفرد (SVD) وتقنيات صقل القيمة المفرد (SVF) لتحسين الأداء في الوقت الفعلي ، وتجنب إعادة التدريب المستغرق للوقت. تُظهر نتائج الاختبار أن Transformer² متفوق على نموذج LORA في مهام متعددة ، مع عدد أقل من المعلمات ، ويوضح أيضًا قدرات نقل المعرفة القوية.

يكمن الابتكار الأساسي لـ Transformer² في آلية تعديل الوزن الديناميكية الفريدة من خطوتين. أولاً ، يحلل طلبات المستخدم الواردة ويفهم متطلبات المهمة ؛ من خلال ضبط المكونات الرئيسية لأوزان النماذج بشكل انتقائي ، يتيح Transformer² تحسين الأداء في الوقت الفعلي دون إعادة التدريب المستهلكة للوقت. هذا في تناقض حاد مع طريقة الضبط التقليدي التقليدي ، والتي تتطلب الحفاظ على المعلمات ثابتة بعد التدريب ، أو استخدام طرق مثل التكيف منخفض الرتبة (LORA) لتعديل عدد صغير فقط من المعلمات.

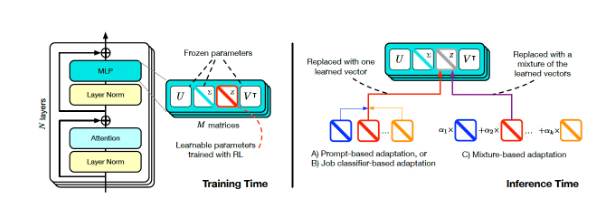

تدريب مربع المحول واستدلاله (المصدر: Arxiv)

لتحقيق التعديل الديناميكي ، اعتمد الباحثون طريقة ضبط القيمة المفرد (SVF). أثناء التدريب ، يتعلم SVF مجموعة من تمثيلات المهارة تسمى محلات Z من مكونات SVD للنموذج. عند التفكير ، يحدد Transformer² المهارات المطلوبة من خلال تحليل المطالبات ثم تكوين مجالات z المقابلة لتحقيق استجابة مصممة لكل موجه.

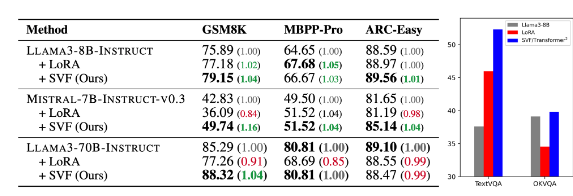

تُظهر نتائج الاختبار أن Transformer² متفوق على نموذج Lora في مهام مختلفة مثل الرياضيات والترميز والمنطق والسؤال المرئي والإجابة ، وله معلمات أقل. والأكثر بروزًا هو أن النموذج لديه أيضًا قدرة نقل المعرفة ، أي أن المجاري z المستفادة من نموذج يمكن تطبيقه على نموذج آخر ، مما يدل على احتمال تطبيق واسع النطاق.

مقارنة بين المحولات المربعة (SVF في الجدول) مع النموذج الأساسي ولورا (المصدر: arxiv)

أصدرت Sakana AI رمز التدريب لمكون Transformer² على صفحة GitHub الخاصة به ، وفتح الباب للباحثين والمطورين الآخرين.

مع استمرار المؤسسات في استكشاف تطبيق LLM ، أصبحت تقنية تخصيص الاستدلال تدريجياً الاتجاه السائد. يقوم Transformer² ، جنبًا إلى جنب مع تقنيات أخرى مثل جبابرة جوجل ، بتغيير طريقة استخدام LLM ، مما يمكّن المستخدمين من ضبط النماذج ديناميكيًا على احتياجاتهم الخاصة دون إعادة التدريب. سيجعل هذا التقدم التكنولوجي LLM أكثر فائدة وعملية في مجموعة واسعة من المجالات.

قال الباحثون في Sakana AI إن Transformer² يمثل جسرًا بين الذكاء الاصطناعي الثابت وذكاء الحياة ، ووضع الأساس لأدوات الذكاء الاصطناعى الفعالة والشخصية والمتكاملة بالكامل.

سيعزز الإصدار المفتوح المصدر من Transformer² بشكل كبير تطوير وتطبيق تقنية LLM ويوفر اتجاهًا جديدًا لبناء أنظمة ذكاء اصطناعية أكثر كفاءة وشخصية. إن قدرتها على التعلم ديناميكيًا والتكيف مع المهام الجديدة تجعلها لديها إمكانات تطبيق ضخمة في مختلف المجالات وتتطلع إلى التطوير المستقبلي.