أصدر معهد ألين للذكاء الاصطناعي (AI2) مؤخرًا نموذجًا جديدًا على نطاق واسع على نطاق واسع Olmoe ، وهو نموذج خبير مختلط متفرق (MOE) مع 7 مليارات من المعلمات ، ولكن كل علامة إدخال تستخدم 1 مليار فقط ، مما يقلل بشكل كبير من عدد الاستدلال التكاليف ومتطلبات الذاكرة. لدى Olmoe نسختين: الإصدار العالمي Olmoe-1B-7B وإصدار تعليمات صقل Olmoe-1B-7B ، والذي لا يقل عن نماذج كبيرة أخرى في المعايير ، وحتى يتجاوز بعض النماذج الكبيرة. تؤكد AI2 على المصدر المفتوح الكامل لـ Olmoe ، والذي يعتبر ثمينًا بشكل خاص في مجال نماذج MOE ويوفر موارد قيمة للبحث الأكاديمي.

يعتمد Olmoe بنية خبراء هجينة متناثرة (MOE) مع 7 مليارات من المعلمات ، ولكن يتم استخدام 1 مليار فقط من المعلمة لكل علامة إدخال. إنه يأتي في نسختين ، كلما Olmoe-1B-7B بشكل عام و olmoe-1b-7b-instructive.

على عكس معظم نماذج الخبراء الهجينة الأخرى التي يتم إغلاقها ، تؤكد AI2 على أن Olmoe مفتوح بالكامل. لقد ذكروا في الورقة أن "معظم نماذج MOE مغلقة: على الرغم من أن بعض الأوزان النموذجية ، إلا أن هناك معلومات محدودة للغاية عن بيانات التدريب أو الكود أو الوصفات."

وقال ناثان لامبرت ، عالم أبحاث AI2 على وسائل التواصل الاجتماعي ، إن Olmoe ستساعد في صنع السياسات ، والتي يمكن أن توفر نقطة انطلاق لإطلاق مجموعة H100 في الأوساط الأكاديمية. وذكر أيضًا أن إصدار نموذج Olmoe هو جزء من هدف AI2 المتمثل في تطوير نماذج مفتوحة المصدر وجعل أدائها مماثلة للنماذج المغلقة.

فيما يتعلق ببناء النماذج ، قررت AI2 استخدام 64 خبيرًا صغيرًا للتوجيه الجيد وتفعيل ثمانية منهم فقط في وقت التشغيل. تبين التجارب أن Olmoe يمكن مقارنته بالنماذج الأخرى في الأداء ، ولكن يتم تقليلها بشكل كبير في تكلفة الاستدلال وتخزين الذاكرة. يعتمد Olmoe أيضًا على طراز Open Source Olmo1.7-7b قبل AI2 ، ويدعم 4096 Windows Dited Dited Windows. تأتي بيانات تدريب Olmoe من مصادر متعددة ، بما في ذلك الزحف المشترك ، Dolma CC ، ويكيبيديا ، إلخ.

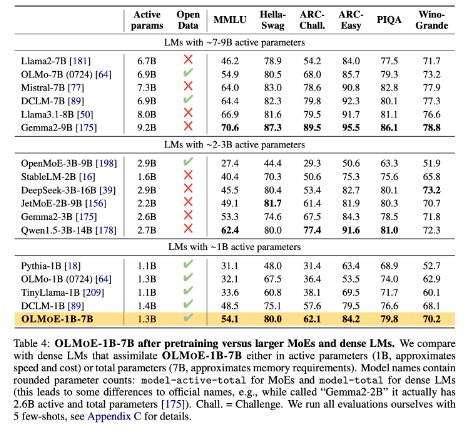

في المعيار ، يتفوق OLMOE-1B-7B على العديد من النماذج الحالية عند مقارنتها مع النماذج ذات المعلمات المماثلة ، وحتى يتجاوز نماذج أكبر مثل LLAMA2-13B-Chat و DeepSeekmoe-16B.

يتمثل أحد أهداف AI2 في تزويد الباحثين بنماذج منظمة العفو الدولية مفتوحة المصدر بشكل كامل ، بما في ذلك بنيات الخبراء المختلطة. على الرغم من أن العديد من المطورين يستخدمون بنية MOE ، إلا أن AI2 يعتقد أن معظم نماذج الذكاء الاصطناعى الأخرى بعيدة عن أن تكون مفتوحة بما فيه الكفاية.

Huggingface: https://huggingface.co/Collections/allenai/olmoe-66cf678c047657a30c8cd3da

مدخل الورق: https://arxiv.org/abs/2409.02060

النقاط الرئيسية:

- يعد نموذج Olmoe المصدر المفتوح الجديد الذي تم إصداره بواسطة AI2 منافسة من حيث الأداء والتكلفة.

- يعتمد Olmoe بنية خبراء هجينة متناثرة يمكن أن تقلل بشكل فعال من تكاليف الاستدلال ومتطلبات الذاكرة.

- تلتزم AI2 بتوفير نموذج AI مفتوح المصدر بالكامل يعزز البحث الأكاديمي والتطوير.

باختصار ، يعد الإصدار المفتوح المصدر من Olmoe تقدمًا كبيرًا في مجال نماذج اللغة على نطاق واسع. تعكس خطوة AI2 التزامها الثابت بتطوير Open Source AI ويستحق التطلع إلى المزيد من المساهمات المماثلة في المستقبل.