في السنوات الأخيرة ، ظلت تكلفة تدريب نماذج اللغة الكبيرة مرتفعة ، والتي أصبحت عاملاً مهمًا يقيد تطوير الذكاء الاصطناعي. أصبحت كيفية تقليل تكاليف التدريب وتحسين الكفاءة محور اهتمام الصناعة. اتبع الباحثون في جامعة هارفارد وستانفورد مقاربة مختلفة وبدأوا بدقة التدريب النموذجي لاستكشاف طريقة تدريب فعالة من حيث التكلفة. وجدوا أنه من خلال تقليل دقة النموذج ، يمكن تقليل كمية الحساب بشكل فعال وحتى تحسين أداء النموذج في بعض الحالات. توفر هذه الدراسة أفكارًا جديدة لتحسين التدريب على نموذج اللغة وتشير أيضًا إلى اتجاه تطوير الذكاء الاصطناعي في المستقبل.

في مجال الذكاء الاصطناعي ، كلما كان المقياس أكبر ، كلما كانت القدرة أقوى. من أجل متابعة نموذج لغة أكثر قوة ، تقوم شركات التكنولوجيا الكبرى بتكديس المعلمات النموذجية وبيانات التدريب ، لكنهم يجدون أن التكلفة قد ارتفعت أيضًا. ألا توجد طريقة فعالة من حيث التكلفة وفعالة لتدريب نماذج اللغة؟

نشر باحثون من جامعة هارفارد وستانفورد مؤخرًا ورقة وجدوا أن دقة التدريب النموذجي تشبه المفتاح الخفي الذي يفتح "كلمة مرور التكلفة" للتدريب على نموذج اللغة.

ما هي دقة النموذج؟ عادة ما يتم تدريب نماذج التعلم العميق التقليدية باستخدام أرقام نقاط عائمة 32 بت (FP32) ، ولكن في السنوات الأخيرة ، مع تطوير الأجهزة ، تستخدم أنواعًا رقمية أقل ، مثل أرقام النقاط العائمة 16 بت (FP16) أو 8 بت أصبح التدريب الأعداد الصحيحة (INT8) ممكنًا.

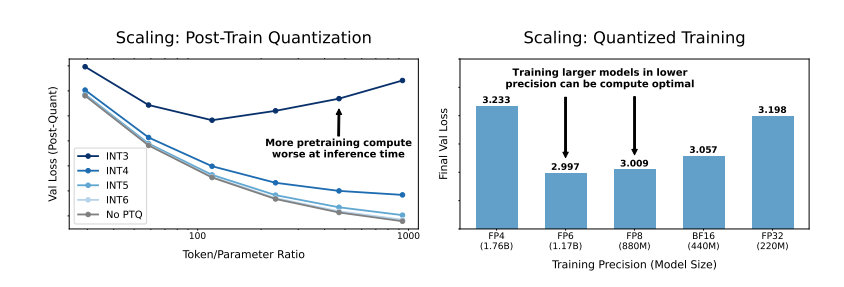

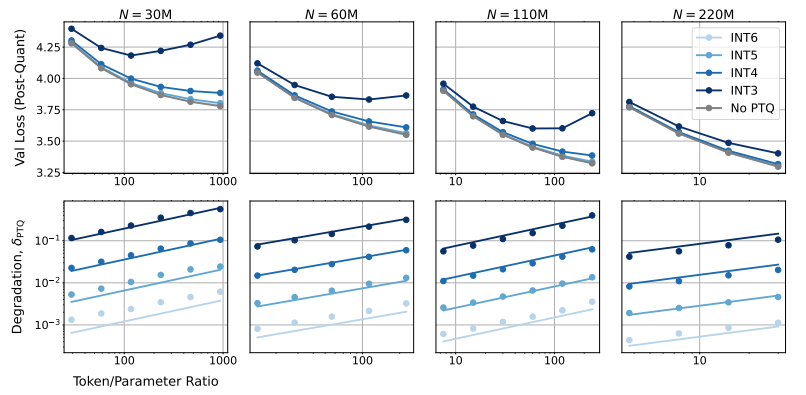

لذا ، ما هو تأثير دقة النموذج على أداء النموذج؟ من خلال عدد كبير من التجارب ، قام الباحثون بتحليل التغيرات في التكلفة والأداء في التدريب النموذجي والاستدلال بدقة مختلفة ، واقترحوا مجموعة جديدة من قواعد التحجيم "الإدراك الدقيق".

وجدوا أن التدريب بدقة أقل يمكن أن يقلل بشكل فعال من "عدد المعلمات الفعالة" للنموذج ، وبالتالي تقليل مقدار الحساب المطلوب للتدريب. هذا يعني أنه في ظل نفس الميزانية الحسابية ، يمكننا تدريب نماذج أكبر ، أو على نفس الحجم ، يمكن أن يوفر استخدام دقة أقل الكثير من موارد الحوسبة.

والأهم من ذلك ، أن الباحثين وجد أيضًا أنه في بعض الحالات ، يمكن للتدريب ذوي الدقة المنخفضة تحسين أداء النموذج! المرحلة ، سيكون النموذج أكثر قوة لتخفيض دقة القياس ، وبالتالي إظهار أداء أفضل في مرحلة الاستدلال.

لذلك ، ما الدقة التي يجب أن نختار تدريب النموذج؟

قد لا يكون التدريب الدقيق التقليدي 16 بت هو الخيار الأفضل. تظهر أبحاثهم أن دقة 7-8 بت قد تكون خيارًا أكثر فعالية من حيث التكلفة.

إنها ليست خطوة حكيمة لمتابعة التدريب الدقيق للغاية (مثل 4 بت). لأنه في دقة منخفضة للغاية ، سينخفض عدد المعلمات الفعالة للنموذج بشكل حاد ، من أجل الحفاظ على الأداء ، نحتاج إلى زيادة حجم النموذج بشكل كبير ، مما سيؤدي إلى ارتفاع تكاليف الحوسبة.

قد تختلف دقة التدريب المثلى لنماذج من الأحجام المختلفة. بالنسبة للنماذج التي تتطلب الكثير من "التدريب المبالغ فيها" ، مثل سلسلة LLAMA-3 و GEMMA-2 ، قد يكون التدريب بدقة أعلى أكثر فعالية من حيث التكلفة.

توفر هذه الدراسة منظورًا جديدًا تمامًا لنا لفهم التدريب على نموذج اللغة وتحسينه. يخبرنا أن اختيار الدقة ليس ثابتًا ، ولكن يجب تداوله بناءً على حجم النموذج المحدد ، وحجم بيانات التدريب وسيناريوهات التطبيق.

بالطبع ، هذه الدراسة لديها أيضا بعض القيود. على سبيل المثال ، يكون النموذج الذي يستخدمونه صغيراً نسبياً في الحجم وقد لا يتم تعميم النتائج التجريبية مباشرة على نماذج أكبر. علاوة على ذلك ، ركزوا فقط على وظيفة فقدان النموذج ولم يقيموا أداء النموذج في مهام المصب.

ومع ذلك ، هذه الدراسة ذات أهمية كبيرة. إنه يكشف عن العلاقة المعقدة بين دقة النموذج وتكاليف الأداء النموذجية وتكاليف التدريب ، ويوفر رؤى قيمة لنا لتصميم وتدريب نماذج لغة أقوى وأكثر اقتصادا في المستقبل.

ورقة: https://arxiv.org/pdf/2411.04330

باختصار ، توفر هذه الدراسة أفكارًا وطرقًا جديدة لتقليل تكاليف تدريب نماذج اللغة الكبيرة ، وتوفر قيمة مرجعية مهمة للتطوير المستقبلي لمجال الذكاء الاصطناعي. على الرغم من وجود بعض القيود في البحث ، فإن قاعدة التحجيم "الإدراك الدقيق" الذي تقترحه والمناقشة المتعمقة للعلاقة بين دقة النموذج والتكلفة والأداء لها أهمية توجيهية نظرية وعملية مهمة.