أصدرت Rakuten Group أول نموذج اللغة الياباني الكبير (LLM) Rakuten AI2.0 ونموذج اللغة الصغيرة (SLM) Rakuten AI2.0mini ، بهدف تعزيز تطوير الذكاء الاصطناعي في اليابان. يتبنى Rakuten AI2.0 بنية خبراء هجينة (MOE) ولديها ثمانية نماذج خبراء بها 7 مليارات من المعلمات. Rakuten AI2.0Mini هو نموذج مضغوط مع 1.5 مليار معلمة ، مصممة لنشر الجهاز EDGE ، مع مراعاة فعالية التكلفة وسهولة التطبيق. كلا النموذجين مفتوح المصدر ويوفران الإصدارات الدقيقة والمحسّنة للتفضيل لدعم مختلف مهام توليد النصوص.

أعلنت مجموعة Rakuten عن إطلاق أول نموذج للغة اليابانية (LLM) ونموذج اللغة الصغيرة (SLM) ، المسمى Rakuten AI2.0 و Rakuten AI2.0 Mini.

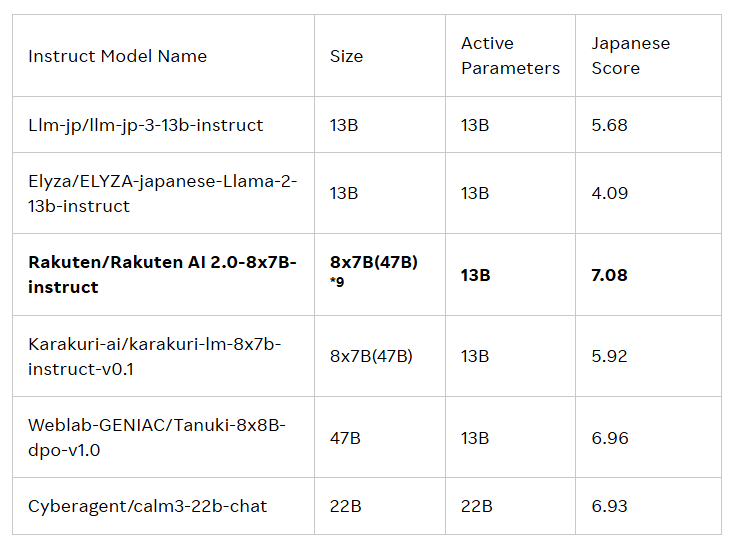

يهدف إصدار هذين النموذجين إلى دفع تطور الذكاء الاصطناعي (AI) في اليابان. يعتمد Rakuten AI2.0 على بنية الخبراء المختلط (MOE) وهو نموذج 8 × 7B يتكون من ثمانية نماذج مع 7 مليارات معلمات ، كل منها خبير. كلما تتم معالجة رمز الإدخال ، سيرسله النظام إلى الخبراء الأكثر صلة ، والجهاز الموجه مسؤول عن اختياره. يتدرب هؤلاء الخبراء وأجهزة التوجيه باستمرار معًا من خلال كمية كبيرة من البيانات الثنائية اليابانية والإنجليزية عالية الجودة.

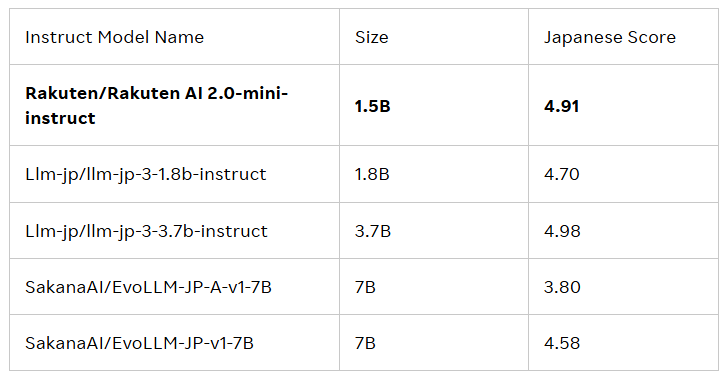

Rakuten AI2.0Mini هو نموذج كثيف جديد مع حجم معلمة 1.5 مليار ، مصمم لنشر جهاز الحافة الفعالة من حيث التكلفة ومناسبة لسيناريوهات التطبيق المحددة. كما يتم تدريبه على البيانات المختلطة في اليابان والمملكة المتحدة ، بهدف توفير حل مناسب. تم ضبط كلا النموذجين وفضحهما ، وقد أصدرا النماذج الأساسية ونماذج التعليمات الأساسية لدعم المؤسسات والمهنيين في تطوير تطبيقات الذكاء الاصطناعي.

جميع النماذج قيد الترخيص Apache2.0 ، والتي يمكن للمستخدمين الحصول عليها في المكتبة الرسمية للوجه المعانقة لمجموعة Rakuten. بالإضافة إلى ذلك ، يمكن أن تكون هذه النماذج أيضًا بمثابة أساس للنماذج الأخرى ، مما يسهل المزيد من التطوير والتطبيق.

وقال كاي تينغ ، كبير موظفي البيانات في مجموعة راكوتن: "أنا فخور للغاية بكيفية جمع فريقنا بين البيانات والهندسة والعلوم لإطلاق Rakuten AI2.0. تتخذ المؤسسات قرارات ذكية ، وتسريع تحقيق القيمة ، وفتح إمكانيات جديدة من خلال النموذج المفتوح. "

المدونة الرسمية: https://global.rakuten.com/corp/news/press/2025/0212_02.html

النقاط الرئيسية:

تطلق Rakuten Group أول نموذج لغوي ياباني كبير (LLM) ونموذج اللغة الصغيرة (SLM) ، يسمى Rakuten AI2.0 و Rakuten AI2.0 Mini.

يعتمد Rakuten AI2.0 على بنية خبراء هجينة ولديها ثمانية نماذج خبراء تحتوي على 7 مليارات معلمات ، ملتزمة بمعالجة البيانات اليابانية والإنجليزية بكفاءة.

تتوفر جميع النماذج في مكتبة Rakuten Hugging Face الرسمية ، وهي مناسبة لمجموعة متنوعة من مهام توليد النصوص وتكون بمثابة أساس للنماذج الأخرى.

باختصار ، تم إطلاق Rakuten AI2.0 و Rakuten AI2.0Mini تقدمًا مهمًا آخر في اليابان في مجال نماذج اللغة الكبيرة. لتطبيقها وتأثيرها المستقبلي.