مع التطور السريع لتكنولوجيا الذكاء الاصطناعي ، أصبحت نماذج اللغة تستخدم على نطاق أوسع في مجالات متعددة. ومع ذلك ، كشفت دراسة Openai الجديدة أن هذه النماذج كانت تقصر بكثير من التوقعات عند الإجابة على الأسئلة الواقعية ، مما يؤدي إلى إعادة التفكير في قدرة الذكاء الاصطناعي على اكتساب المعرفة.

أظهرت دراسة حديثة أجرتها Openai أنه على الرغم من التطور السريع لتكنولوجيا الذكاء الاصطناعي ، فإن نماذج اللغة الأكثر تقدماً الحالية لها معدلات نجاح أقل بكثير في الإجابة على الأسئلة الواقعية.

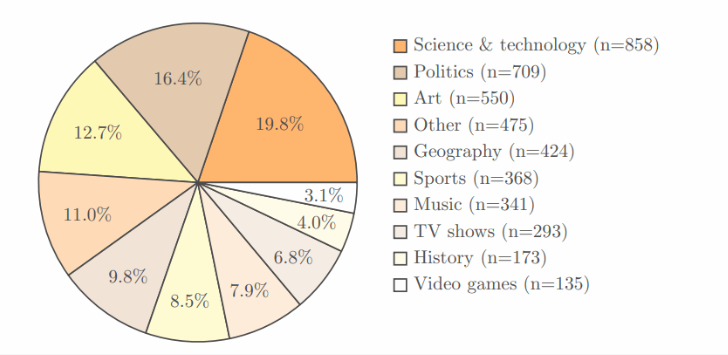

اعتمدت الدراسة اختبار SimpleQa القياسي الخاص بـ Openai ، والذي يحتوي على 4326 منطقة ، تغطي حقول متعددة مثل العلوم والسياسة والفن ، وكل سؤال له إجابة واضحة وصحيح.

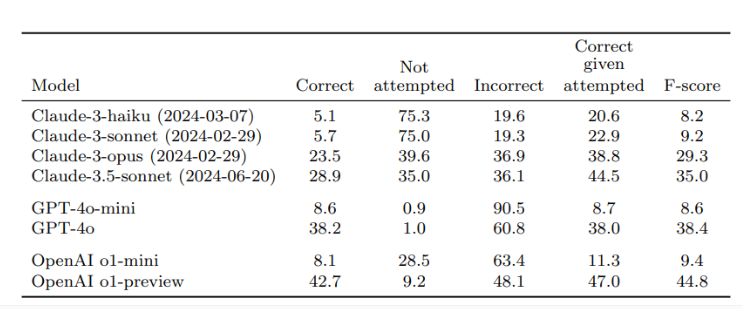

بعد التحقق من قبل اثنين من المراجعين المستقلين ، أظهرت النتائج أن معدل الدقة لـ O1-Preview ، أفضل نموذج لـ Openai ، كان 42.7 ٪ فقط ، في حين كان GPT-4O أقل قليلاً ، 38.2 ٪ فقط. أما بالنسبة إلى GPT-4O-Mini الأصغر ، فإن معدل الدقة هو 8.6 ٪ فقط. على النقيض من ذلك ، كان أداء كلود في الإنسان أسوأ ، حيث كان معدل دقة Claude-3.5-Sonnet 28.9 ٪ فقط.

مفتاح هذه الدراسة هو تصميم الاختبار ، ليس فقط لاختبار أداء الذكاء الاصطناعي ، ولكن أيضًا لجعل الجميع يدركون حدود نماذج الذكاء الاصطناعى من حيث اكتساب المعرفة. يؤكد الباحثون أنه عند استخدام هذه النماذج ، يجب على المستخدمين اعتبارهم أدوات لمعالجة المعلومات بدلاً من الاعتماد بالكامل على مصادر المعرفة. للحصول على إجابات أكثر دقة ، من الأفضل توفير بيانات موثوقة لمنظمة العفو الدولية بدلاً من الاعتماد فقط على معرفتها المدمجة.

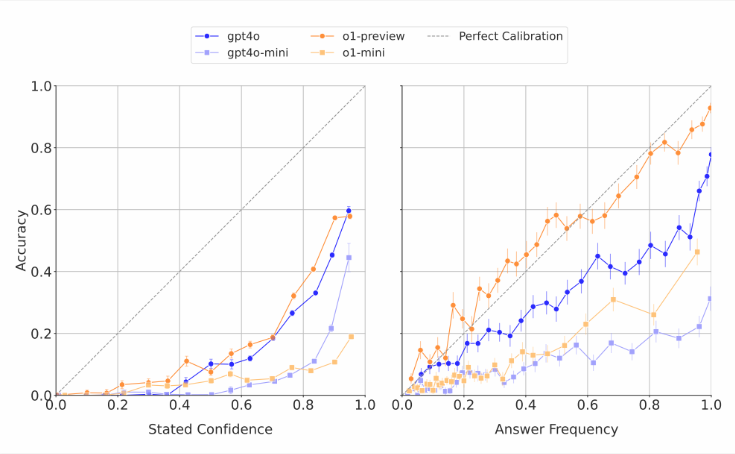

تجدر الإشارة إلى أن نماذج الذكاء الاصطناعى تقدر في كثير من الأحيان قدراتها. ووجد الباحثون أنه عندما طُلب من هذه النماذج تسجيل الثقة في ردودهم ، فإنهم عادة ما يعطون درجة دقة مبالغ فيها. في الاختبارات التي تجيب بشكل متكرر على نفس السؤال ، حتى لو أعطى النموذج نفس الإجابة عدة مرات ، فإن معدل نجاحه الفعلي لا يزال أقل من دقة التقييم الذاتي. وهذا يتفق مع انتقادات العالم الخارجي الذي ينتج غالبًا إجابات سخيفة لنماذج اللغة ولكنها تبدو واثقة.

يعتقد الباحثون أن هناك فجوة واضحة في الدقة الواقعية لأنظمة الذكاء الاصطناعى الحالية وتحتاج إلى تحسين بشكل عاجل. في الوقت نفسه ، طرحوا أيضًا سؤالًا مفتوحًا: ما إذا كان أداء AI في الإجابة على الأسئلة الواقعية القصيرة يمكن أن يتنبأ بكيفية أداءه عند التعامل مع إجابات أطول وأكثر تعقيدًا. لدعم تطوير نماذج لغة أكثر موثوقية ، نشر Openai بيانات عن معايير SimpleQA علنًا على Github.

النقاط الرئيسية:

تُظهر أبحاث Openai أن نماذج اللغة الأكثر تقدماً لها معدلات نجاح منخفضة عند الإجابة على الأسئلة الواقعية ، مع أقصى معدل نجاح قدره 42.7 ٪ فقط.

غالبًا ما تبالغ نماذج الذكاء الاصطناعى في تقدير قدراتها ودرجات ثقتها مبالغ فيها بشكل عام.

جعل Openai SimpleQa Penchmark Public للمساعدة في البحث عن نماذج لغة أكثر موثوقية.

تذكرنا هذه الدراسة أنه على الرغم من التقدم الكبير في تكنولوجيا الذكاء الاصطناعي ، يجب التعامل مع قيودها بحذر في التطبيقات العملية ومواصلة تعزيز التحسينات التكنولوجية.