من خلال التطور السريع لنماذج اللغة الكبيرة متعددة الوسائط (MLLMs) ، تم إدخال المهام المتعلقة بالصور والفيديو في اختراقات غير مسبوقة ، وخاصة في مجالات الأسئلة والأجوبة البصرية ، الجيل السردي والتحرير التفاعلي. ومع ذلك ، على الرغم من التقدم الكبير في هذه التقنيات ، لا يزال فهم محتوى الفيديو الدقيق يمثل مشكلة صعبة يجب حلها. لا يتضمن هذا التحدي تجزئة على مستوى البكسل وتتبعها فقط مع أوصاف اللغة ، ولكن أيضًا المهام المعقدة مثل أسئلة وأجوبة مرئية على مطالبات فيديو محددة.

على الرغم من أن نماذج إدراك الفيديو الحديثة التي تعمل بشكل جيد في مهام التجزئة والتتبع ، إلا أنها لا تزال غير كافية في إمكانات فهم اللغة المفتوحة والحوار. لا تزال MLLMs الفيديو ، على الرغم من أداءها جيدًا في فهم الفيديو ومهام الأسئلة والأجوبة ، غير قادرة على التعامل مع المهام الإدراكية والإشارات المرئية. هذا القيد يحد من استخدامها في مجموعة واسعة من السيناريوهات.

يتم تقسيم الحلول الحالية بشكل أساسي إلى فئتين: نماذج لغة كبيرة متعددة الوسائط (MLLMS) وأنظمة التجزئة المرجعية. ركزت MLLMS في البداية على تحسين أساليب الانصهار متعددة الوسائط ومستخرجات الميزات ، وتطوير تدريجياً لتصبح إطارًا لضبط التعليمات على LLMs ، مثل LLAVA. في الآونة الأخيرة ، حاول الباحثون توحيد الصور ومقاطع الفيديو وتحليل الصور المتعددة إلى إطار واحد ، مثل LLAVA-onevision. في الوقت نفسه ، خضع نظام التجزئة المرجعية أيضًا لتحويل من وحدات الانصهار الأساسية إلى التجزئة المتكاملة والتتبع. ومع ذلك ، لا تزال هذه الحلول لديها أوجه قصور في التكامل الشامل لقدرات الإدراك وقدرات فهم اللغة.

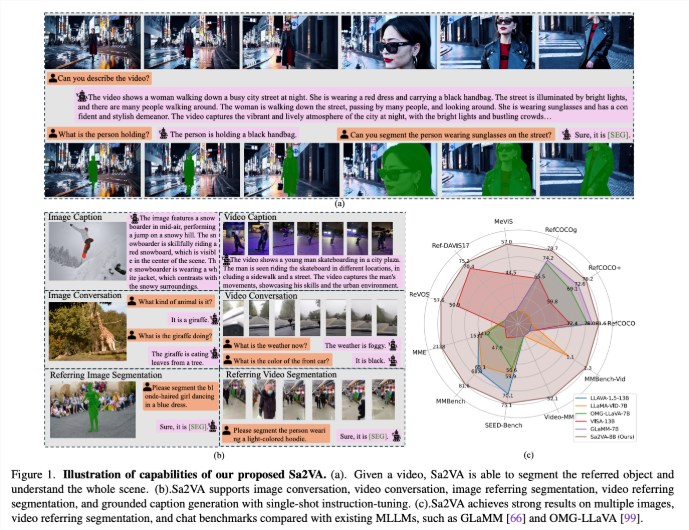

اقترح باحثون من جامعة كاليفورنيا في ميرسيد ، وفريق بذرة بيتيانس ، وجامعة ووهان وجامعة بكين SA2VA ، وهو نموذج موحد رائد مصمم لتحقيق فهم أساسي مكثف للصور ومقاطع الفيديو. يتغلب هذا النموذج على قيود نماذج اللغة الكبيرة المتعددة الوسائط الحالية من خلال تقليل ضبط التعليمات لمرة واحدة ودعم مجموعة واسعة من مهام الصور والفيديو.

يدمج SA2VA بشكل مبتكر SAM-2 مع LLAVA لتوحيد النص والصور والفيديو في مساحة رمزية LLM المشتركة. بالإضافة إلى ذلك ، أطلق الباحثون مجموعة بيانات شرح أوتوماتيكية شاملة تسمى Ref-SAV ، والتي تحتوي على تعبيرات كائنات في أكثر من سيناريوهات الفيديو المعقدة 72k ، وكائنات الفيديو 2K التي تم التحقق منها يدويًا لضمان إمكانات قوية للتقييم.

تتألف بنية SA2VA بشكل أساسي من جزأين: نموذج مشابه لـ LLAVA و SAM-2 ، ويعتمد تصميمًا جديدًا فك الارتباط. يتضمن المكون الذي يشبه LLAVA مشفرًا مرئيًا يعالج الصور ومقاطع الفيديو ، وطبقة الإسقاط المرئي ، و LLM للتنبؤ الرمزي النص. يتبنى النظام طريقة فك شمولية فريدة تسمح لـ SAM-2 بالعمل بجوار نموذج LLAVA الذي تم تدريبه مسبقًا دون تبادل الرمز المباشر ، وبالتالي الحفاظ على الكفاءة الحسابية والسماح بالمكونات الإضافية والانصهار مع MLLMs المختلفة التي تم تدريبها.

تُظهر نتائج البحث أن SA2VA حققت أحدث النتائج في مهمة تجزئة الاقتباس ، مع وجود نموذج SA2VA-8B الذي يحتوي على درجات CIOU على REFCOCO ، REFCOCO+ و REFCOCOG ، على التوالي ، متجاوزة الأنظمة السابقة مثل GLAMM-7B. من حيث قدرات الحوار ، حقق SA2VA نتائج ممتازة من 2128 و 81.6 و 75.1 على MME و MMBNCH و SEEE على التوالي.

بالإضافة إلى ذلك ، تجاوز أداء SA2VA في معايير الفيديو بشكل كبير الحالة السابقة-من VISA-13B ، مما يدل على كفاءته وفعاليته في مهام فهم الصور والفيديو.

ورقة: https://arxiv.org/abs/2501.04001

النموذج: https://huggingface.co/Collections/bytedance/sa2va-model-zoo-677e3084d71b5f108d00e093

النقاط الرئيسية:

SA2VA هو إطار عمل جديد موحد من الذكاء الاصطناعي يحقق فهمًا متعمقًا للصور ومقاطع الفيديو ويتغلب على قيود النماذج المتعددة الوسائط الحالية.

لقد حقق النموذج نتائج حديثة في العديد من المعايير مثل تجزئة الاقتباس وقدرات الحوار ، مما يدل على الأداء المتميز.

يدمج تصميم SA2VA بشكل فعال قدرات الفهم البصري واللغة من خلال طريقة فك الارتباط ، ودعم مجموعة واسعة من مهام الصور والفيديو.