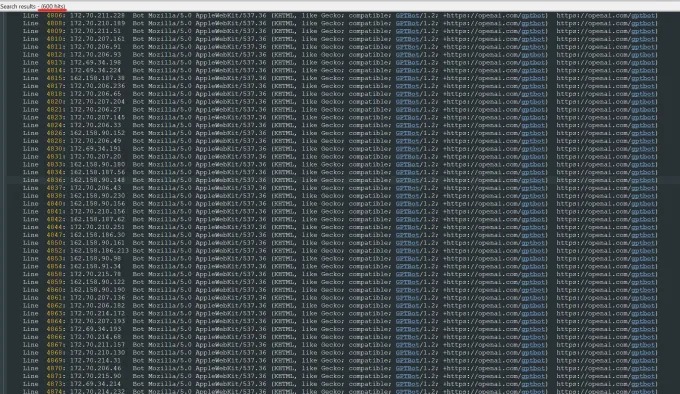

في الآونة الأخيرة ، تلقى Oleksandr Tomchuk ، الرئيس التنفيذي لشركة Trilegangers ، تنبيهًا للطوارئ قائلاً إن موقع التجارة الإلكترونية لشركته قد أصيب بالشلل فجأة. بعد إجراء تحقيق متعمق ، وجد أن جذر المشكلة يكمن في روبوت Openai الذي يزحف بلا هوادة محتوى موقعه الإلكتروني بأكمله. يحتوي موقع Trilegangers على أكثر من 65000 منتج ، ولكل منها صفحات مفصلة وثلاث صور على الأقل. أرسل روبوت Openai عشرات الآلاف من طلبات الخادم لمحاولة تنزيل كل شيء ، بما في ذلك مئات الآلاف من الصور وأوصافها.

أشار Tomchuk إلى أن زاحف Openai كان له تأثير خطير على الموقع الإلكتروني ، أي ما يعادل تقريبًا لهجوم رفض الخدمة الموزع (DDOS). تتمثل الأعمال التجارية الرئيسية لـ Trilegangers في توفير ملفات وصور ثلاثية الأبعاد للفنانين ثلاثي الأبعاد ومطوري ألعاب الفيديو وغيرهم من المستخدمين الذين يحتاجون إلى إعادة إنتاج خصائص إنسانية حقيقية رقميًا. تتضمن هذه المستندات بيانات مسح مفصلة من اليدين إلى الشعر والجلد والجسم كله.

يقع موقع Trilegangers في قلب أعماله. أمضت الشركة أكثر من عقد من الزمان في بناء أكبر قاعدة بيانات "موقف رقمي للأجسام البشرية" على الشبكة ، كل ذلك من عمليات مسح ثلاثية الأبعاد من الأجسام البشرية الحقيقية. يقع فريق Tomchuk في أوكرانيا ، ولكن تم ترخيصه أيضًا في تامبا ، فلوريدا ، الولايات المتحدة الأمريكية. على الرغم من أن هناك صفحة شروط الخدمة على موقع الويب تحظر صراحة تزحف الروبوت غير المصرح بها ، إلا أن هذا لم يمنع روبوتات Openai بشكل فعال.

من أجل منع زحف الروبوت بشكل فعال ، يجب على موقع الويب تكوين ملف Robot.txt بشكل صحيح. تم تصميم Robot.txt ، المعروف أيضًا باسم بروتوكول استبعاد الروبوت ، لإبلاغ محركات البحث عن المحتوى الذي لا ينبغي فهرسته. قال Openai على صفحته الرسمية إنه يحترم الملفات عندما يتم تكوين موقع الويب بعلامات محظورة من الزحف ، ولكنه يحذر أيضًا من أن روبوته قد يستغرق ما يصل إلى 24 ساعة للتعرف على ملف Robot.txt المحدث.

أكد Tomchuk أنه إذا لم يستخدم موقع الويب robot.txt بشكل صحيح ، فقد يعتقد Openai والشركات الأخرى أنها يمكن أن تزحف البيانات حسب الرغبة. هذا ليس نظامًا اختياريًا ، ولكنه مقياس ضروري لحماية محتوى الموقع. والأسوأ من ذلك ، أنه لم يضطر Trilegangers فقط إلى عدم الاتصال بالإنترنت من قبل Openai's Robots خلال ساعات العمل في الولايات المتحدة ، بل توقع Tomchuk زيادة كبيرة في فواتير AWS بسبب وحدة المعالجة المركزية الضخمة للروبوت ونشاط التنزيل.

ومع ذلك ، فإن robot.txt ليس حلًا كاملاً. ما إذا كانت شركات الذكاء الاصطناعي تتوافق مع هذه الاتفاقية تعتمد بالكامل على تطوعها. اجتذب الحادث اهتمامًا واسع النطاق في الصيف الماضي عندما تم التحقيق في شركة ناشئة أخرى من الذكاء الاصطناعي ، في حيرة ، من قبل Wired لفشلها المزعوم في الامتثال لبروتوكول Robot.txt.

قال Tomchuk إنه لا يستطيع إيجاد طريقة للاتصال بـ Openai والسؤال عنها. لم يرد Openai أيضًا على طلب TechCrunch للتعليق. بالإضافة إلى ذلك ، فشلت Openai حتى الآن في توفير التزامها طويل الأجل بأداة إلغاء الاشتراك ، مما يجعل القضية أكثر تعقيدًا.

هذه مشكلة صعبة بشكل خاص ل trilegangers. أشار Tomchuk إلى أن الأعمال التي يشاركون فيها تنطوي على مشكلات خطيرة في الحقوق لأنهم يقومون بالمسح الضوئي للأشخاص الحقيقيين. بموجب الناتج المحلي الإجمالي الأوروبي والقوانين الأخرى ، من غير القانوني استخدام الصور الحية عبر الإنترنت دون إذن.

ومن المفارقات أن السلوك الجشع لروبوتات Openai جعل Trilegangers على دراية بضعف مواقع الويب الخاصة بهم. قال Tomchuk إنه إذا زحف الروبوت البيانات بطريقة أكثر لطيفة ، فقد لا يلاحظ المشكلة أبدًا.

وقال Tomchuk: "إنه أمر مخيف لأن هذه الشركات يبدو أنها تستغل ثغرة في تزحف البيانات ، وهم يقولون" إذا قمت بتحديث robot.txt بعلاماتنا ، يمكنك إلغاء الاشتراك ". ومع ذلك ، فإن هذا في الواقع يضع اللوم على أصحاب الأعمال ، ويطلب منهم فهم كيفية إيقاف هذه الروبوتات.

يأمل Tomchuk أن تدرك الشركات الصغيرة الأخرى عبر الإنترنت أن الطريقة الوحيدة لاكتشاف ما إذا كانت روبوتات منظمة العفو الدولية تسرق أصول حقوق الطبع والنشر على الموقع الإلكتروني هي البحث عنها بنشاط. إنه ليس الشخص الوحيد الذي يتعرض لقلق من روبوتات الذكاء الاصطناعي. كشف أصحاب المواقع الإلكترونية الأخرى أيضًا إلى Business Insider كيف تعطل روبوتات Openai موقع الويب الخاص بهم وزيادة رسوم AWS الخاصة بهم.

بحلول عام 2024 ، من المتوقع أن تزيد هذه المشكلة أكثر. وجدت بحث جديد من قبل شركة الإعلانات الرقمية Doubleverify أن زحف الذكاء الاصطناعى والزحف قد أدى إلى زيادة بنسبة 86 ٪ في "حركة المرور غير الصالحة" لا تأتي من مستخدمين حقيقيين ولكن من نشاط الروبوتات.