مع التطور السريع لتكنولوجيا الذكاء الاصطناعي ، يلعب نموذج اللغة الكبير (LLM) دورًا متزايد الأهمية في التطبيقات الحديثة. سواء أكان ذلك عبارة عن chatbot أو مولد رمز أو مهام أخرى قائمة على معالجة اللغة الطبيعية ، أصبحت إمكانيات LLM هي السائق الأساسي. ومع ذلك ، مع التوسع المستمر لمقياس النموذج والزيادة في التعقيد ، أصبحت مشاكل الكفاءة في عملية الاستدلال تدريجياً بارزة ، خاصة عند معالجة البيانات واسعة النطاق والحسابات المعقدة ، وأصبحت تأخير واستهلاك الموارد اختناقات تحتاج إلى حلها على وجه السرعة.

كمكون أساسي في LLM ، تؤثر آلية الانتباه بشكل مباشر على كفاءة الاستدلال للنموذج. ومع ذلك ، غالبًا ما تؤدي آليات الاهتمام التقليدية مثل Flashattention و sparstenttation بشكل سيئ عند مواجهة أعباء العمل المتنوعة ، وأنماط الإدخال الديناميكية ، وقيود موارد GPU. أدى زمن الوصول العالي ، اختناقات الذاكرة ، استخدام الموارد المنخفضة بشكل خطير على قابلية التوسع وسرعة الاستجابة لاستدلال LLM. لذلك ، أصبح تطوير حل فعال ومرن محور البحث الحالي.

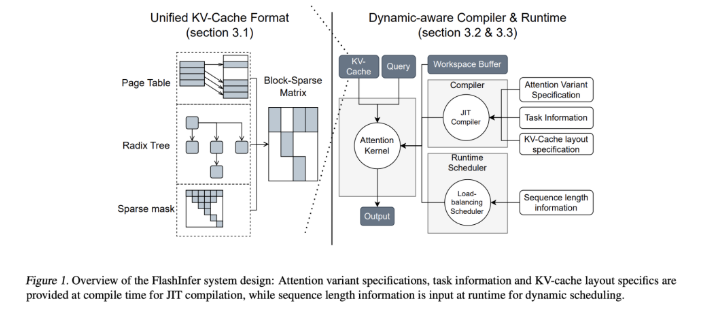

لمواجهة هذا التحدي ، قامت فرق البحث من جامعة واشنطن و NVIDIA و PERPLEXITY AI وجامعة كارنيجي ميلون بتطوير FlashInfer. هذه هي مكتبة ذكاء اصطناعي ومولد kernel مصممة خصيصًا لمنطق LLM ، مصمم لتحسين آليات الانتباه المتعددة ، بما في ذلك الفلاش ، و sparseattree ، و pageattention ، وأخذ العينات من خلال نوى GPU عالية الأداء. تؤكد فلسفة تصميم FlashInfer على المرونة والكفاءة ، ويمكن أن تستجيب بشكل فعال للتحديات الرئيسية في خدمات الاستدلال LLM ، وتوفر حلولًا عملية للاستدلال في نماذج اللغة الواسعة النطاق.

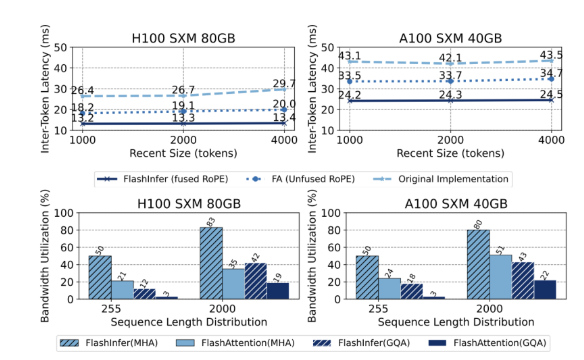

تتضمن الميزات التقنية الأساسية لـ FlashInfer الجوانب التالية: أولاً ، توفر دعمًا شاملاً للاختراق ، وتغطي آليات مختلفة مثل ملء ما قبل الرمز المسبق والاهتمام الإضافي. أداء سيناريوهات الطلب وخدمة الدُفعات. ثانياً ، من خلال انتباه الاستعلام المجمعة (GQA) وانتباه التضمين الدوراني المنصهر (ROPE) ، يحقق FlashInfer تحسينات كبيرة في الأداء في فك التشفير الطويل ، أسرع 31 مرة من اهتمام صفحة VLLM. بالإضافة إلى ذلك ، يمكن لجدولة موازنة التحميل الديناميكية من FlashInfer ضبطها ديناميكيًا وفقًا لتغييرات الإدخال ، وتقليل وقت خمول GPU وضمان استخدام الموارد الفعال. توافقها مع الرسوم البيانية CUDA يعزز قابلية تطبيقها في بيئات الإنتاج.

من حيث الأداء ، يؤدي FlashInfer أداءً جيدًا في معايير متعددة ، خاصة عند التعامل مع استدلال السياق الطويل ومهام التوليد المتوازية ، مما يقلل بشكل كبير من الكمون. على NVIDIA H100 GPU ، يحقق FlashInfer زيادة السرعة بنسبة 13-17 ٪ في مهام التوليد المتوازية. يحسن جدولة الديناميكية واللباس المحسن بشكل كبير استخدام النطاق الترددي واستخدام التقليب ، مما يتيح الاستخدام الفعال لموارد GPU سواء في أطوال التسلسل غير المتكافئة أو الموحدة. هذه المزايا تجعل FlashInfer أداة مهمة لتعزيز تطوير إطار خدمة LLM.

كمشروع مفتوح المصدر ، لا يوفر FlashInfer حلولًا فعالة فقط لتحديات التفكير في LLM ، ولكنها تشجع أيضًا على مزيد من التعاون والابتكار في مجتمع الأبحاث. تتيح قدرات التصميم والتكامل المرنة لها التكيف مع احتياجات البنية التحتية المتغيرة وضمان بقائها قبل قيادتها في مواجهة التحديات الناشئة. من خلال الجهود المشتركة لمجتمع المصادر المفتوحة ، من المتوقع أن يلعب FlashInfer دورًا أكثر أهمية في التطوير المستقبلي لتكنولوجيا الذكاء الاصطناعي.

مدخل المشروع: https://github.com/flashinfer-ai/flashinfer

النقاط الرئيسية:

FlashInfer هي مكتبة الذكاء الاصطناعي التي تم إصدارها حديثًا مصممة لمنطق نموذج اللغة الكبير ويمكن أن تحسن الكفاءة بشكل كبير.

تدعم هذه المكتبة آليات الاهتمام المتعددة ، وتحسن استخدام موارد GPU وتقلل من زمن الاستنتاج.

كمشروع مفتوح المصدر ، يرحب FlashInfer للباحثين بالمشاركة في تعزيز الابتكار والتطوير في البنية التحتية لمنظمة العفو الدولية.