Dieses öffentliche Repository ist schreibgeschützt und wird nicht mehr gepflegt.

Data Hub INteractive Education (DINE) ist ein Bildungsinhalt für SAP Data Hub. Unsere praktischen Übungen sollen Ihnen zeigen, wie Sie die Funktionen von SAP Data Hub nutzen. Mit SAP Data Hub können Sie eine Verbindung zu verschiedenen Datenquellen wie SAP HANA, SAP ERP, SAP BW, Oracle DB2, SQL Server und vielen mehr herstellen und verschiedene Datentypen verarbeiten. strukturiert, halbstrukturiert und unstrukturiert mit Kafka, Streaming-Engine, Text- und Bildanalyse usw. SAP Data Hub kann alle Ihre Daten zusammenführen, sodass Sie nahtlos daran arbeiten können. Sie können Ihren Prototyp schnell auf SAP Data Hub entwickeln und das Ergebnis problemlos in ein System auf Produktionsebene umwandeln, da SAP Data Hub die Ausführung, Orchestrierung, Planung und Überwachung übernimmt. SAP Data Hub wird auf Kubernetes entwickelt und kann daher vor Ort oder in der Cloud bereitgestellt werden. Es läuft auf einer verteilten Ausführungs-Engine und ist für die Big-Data-Welt konzipiert, indem es Verständnis für Metadaten in einer Big-Data-Landschaft nachweist.

Sehen Sie sich auch die offizielle Dokumentation von SAP Data Hub an

Mit DINE können Sie ganz einfach lernen, wie Sie mithilfe seiner Operatoren Pipelines in SAP Data Hub erstellen. Es dient als Referenz für Anwendungsentwickler und stellt die Funktionen von Data Hub in einem leicht verständlichen Geschäftsszenario vor. Dieser Demoinhalt enthält Folgendes:

Beispieldaten

Codeausschnitte

Tutorials

Einrichtung von SAP Data Hub – Befolgen Sie die Installationsanleitung für SAP Data Hub und richten Sie Ihre SAP Data Hub-Umgebung ein.

Sie können auch die SAP Data Hub Developer Edition oder die SAP Data Hub Trial Edition verwenden

Wir lernen SAP Data Hub anhand der folgenden Szenarien kennen, die auf einer Dummy-Entität namens SAP Data Hub Market Place basieren, einer E-Commerce-Plattform, die zu Demo- und Lernzwecken entwickelt wurde und auf der Kunden auf der ganzen Welt täglich Tausende von Einkäufen tätigen .

Die Szenarien werden im Folgenden detailliert beschrieben:

Kundenretourenvorhersage: Dieses Szenario wird verwendet, um die Produkte zu identifizieren, die vom Kunden häufig auf der Grundlage verschiedener Parameter zurückgegeben werden können. Dieses Szenario ist in Python implementiert und verwendet die Sklearn-Bibliothek, um den Entscheidungsbaum-Klassifizierungsalgorithmus zu implementieren. Hier in diesem Szenario lesen wir Daten aus verschiedenen Datenquellen und verwenden die SAP Analytics Cloud, um den Ergebnisdatensatz zu visualisieren. Befolgen Sie das Tutorial, um dieses Szenario zu implementieren.

Weitere Szenarien finden Sie im teched-2018-Zweig.

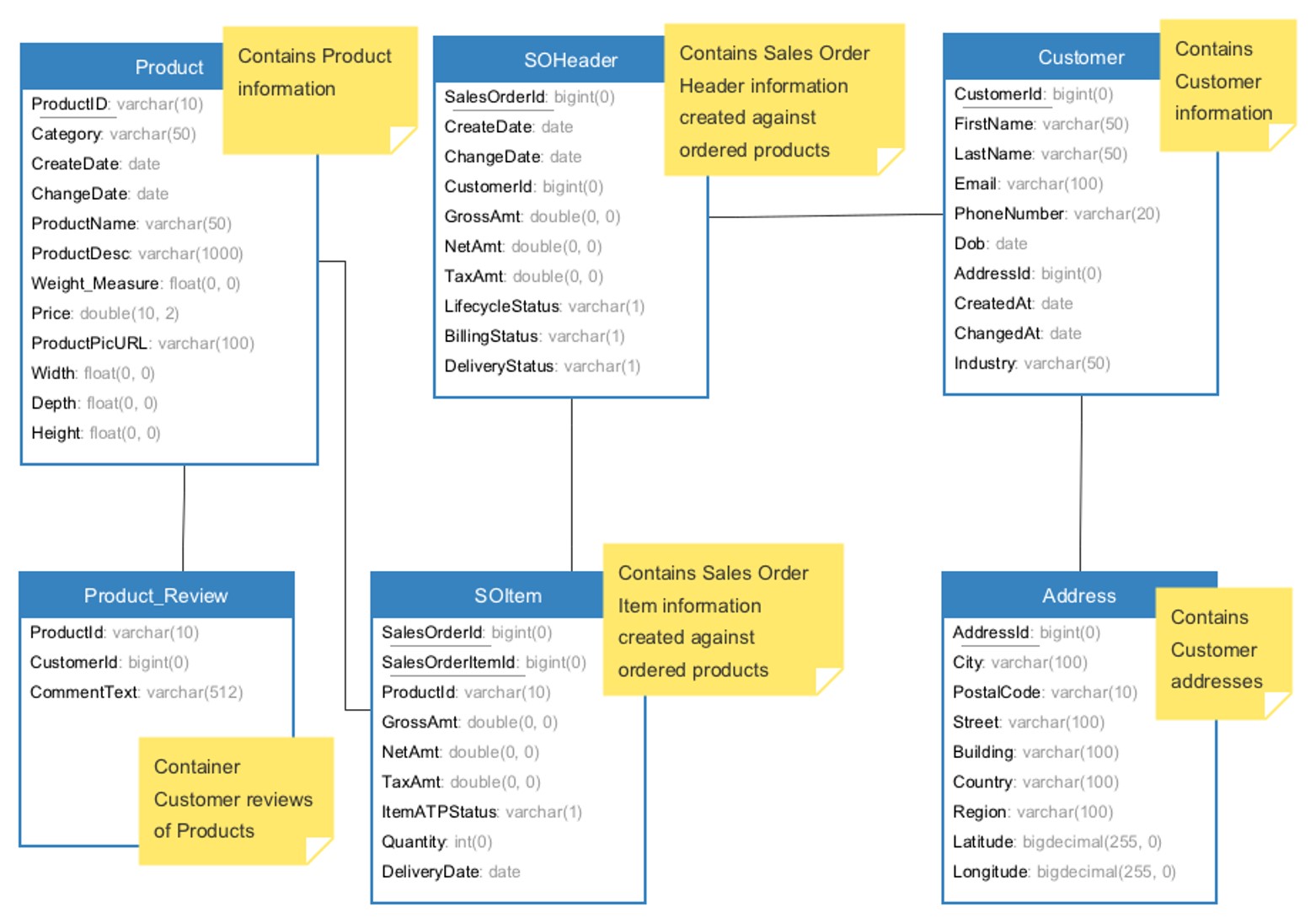

Unser Datensatz für die oben genannten Szenarien besteht aus 6 Dateien, die Kunden- , Produkt- und Verkaufsinformationen enthalten.

Die Tabelle CUSTOMER enthält Details zu Kunden. Diese Tabelle verfügt über ADDRESSID , die der Tabelle ADDRESS zugeordnet ist, in der Details zur Adresse des Kunden gespeichert sind.

Wenn ein Kunde ein Produkt kauft, wird ein Kundenauftrag generiert ( SO_HEADER ) und jeder Kundenauftrag hat mehrere Bestellpositionen ( SO_ITEM ).

SO_HEADER hat PARTNERID , einen Fremdschlüssel, der mit der Tabelle CUSTOMER verknüpft ist.

SO_ITEM hat SALESORDERID, einen Fremdschlüssel, der auf SO_HEADER verweist.

Jedes SO_ITEM verfügt über eine PRODUCTID , die der PRODUCT -Tabelle zugeordnet ist, in der Produktdetails gespeichert sind.

Kundenrezensionen zu den Produkten werden in der REVIEW -Tabelle gespeichert.

Informationen über von Kunden getätigte Rücksendungen werden in der RETURN -Tabelle gespeichert.

Im Grunde haben wir also 7 Tische.

Es handelt sich um einen synthetischen Datensatz, der von SHINE abgeleitet und entsprechend unseren Anwendungsfällen angereichert wird

Um auf die Datensätze zuzugreifen, durchsuchen Sie den Datenordner in diesem Repository.

Keiner

Bitte nutzen Sie GitHub Issues, um etwaige Fehler zu melden.

Copyright (c) 2017-2020 SAP SE oder ein SAP-Tochterunternehmen. Alle Rechte vorbehalten. Dieses Projekt ist unter der Apache-Softwarelizenz, Version 2.0, lizenziert, sofern in der LIZENZdatei nichts anderes angegeben ist.