中文 | 한국어 | 日本語 | Russisch | Deutsch | Französisch | Spanisch | Portugiesisch | Türkei | Tiếng Việt | العربية

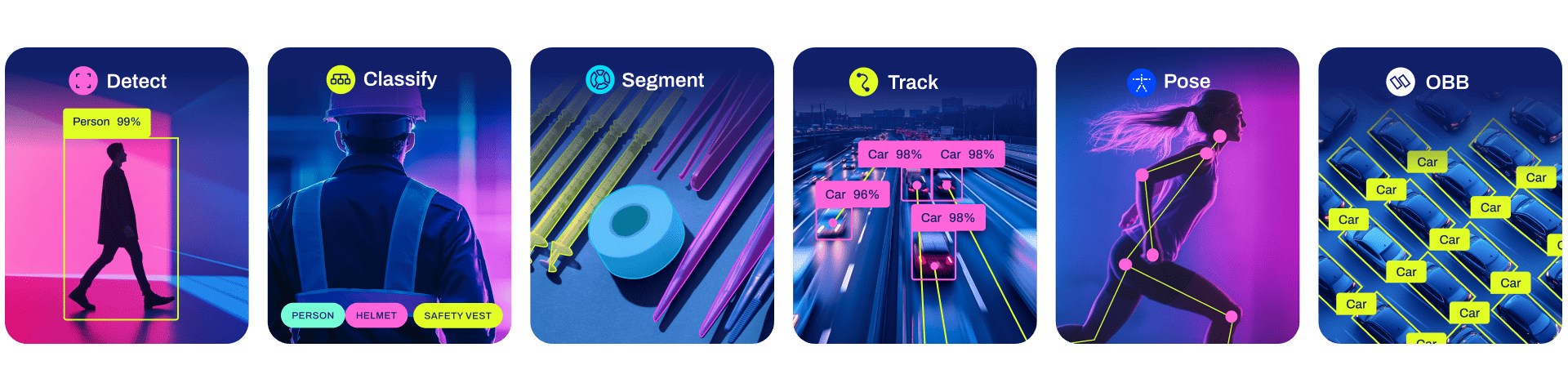

Ultralytics YOLO11 ist ein hochmodernes, hochmodernes (SOTA) Modell, das auf dem Erfolg früherer YOLO-Versionen aufbaut und neue Funktionen und Verbesserungen einführt, um Leistung und Flexibilität weiter zu steigern. YOLO11 ist schnell, genau und einfach zu bedienen und eignet sich daher hervorragend für eine Vielzahl von Aufgaben zur Objekterkennung und -verfolgung, Instanzsegmentierung, Bildklassifizierung und Posenschätzung.

Wir hoffen, dass die hier bereitgestellten Ressourcen Ihnen dabei helfen, das Beste aus YOLO herauszuholen. Bitte durchsuchen Sie die Ultralytics-Dokumente nach Einzelheiten, äußern Sie ein Problem auf GitHub für Support, Fragen oder Diskussionen, werden Sie Mitglied im Ultralytics Discord, Reddit und den Foren!

Um eine Unternehmenslizenz anzufordern, füllen Sie bitte das Formular bei Ultralytics Licensing aus.

Dokumentation

Unten finden Sie eine Schnellstart-Installation und Anwendungsbeispiele. Eine vollständige Dokumentation zu Schulung, Validierung, Vorhersage und Bereitstellung finden Sie in unseren Dokumenten.

Pip installiert das Ultralytics-Paket einschließlich aller Anforderungen in einer Python>=3.8 -Umgebung mit PyTorch>=1.8 .

Pip Install Ultralytics

Informationen zu alternativen Installationsmethoden, einschließlich Conda, Docker und Git, finden Sie im Quickstart Guide.

YOLO kann direkt im Command Line Interface (CLI) mit einem yolo -Befehl verwendet werden:

yolo Prediction model=yolo11n.pt source='https://ultralytics.com/images/bus.jpg'

yolo kann für eine Vielzahl von Aufgaben und Modi verwendet werden und akzeptiert zusätzliche Argumente, z. B. imgsz=640 . Beispiele finden Sie in den YOLO CLI-Dokumenten.

YOLO kann auch direkt in einer Python-Umgebung verwendet werden und akzeptiert dieselben Argumente wie im obigen CLI-Beispiel:

from ultralytics import YOLO# Laden Sie ein Modellmodell = YOLO("yolo11n.pt")# Trainieren Sie das Modelltrain_results = model.train( data="coco8.yaml", # Pfad zum Datensatz YAML epochs=100, # Anzahl der Trainingsepochen imgsz= 640, # Trainingsbildgröße device="cpu", # Gerät zur Ausführung, z. B. Gerät=0 oder Gerät=0,1,2,3 oder device=cpu)# Bewerten Sie die Modellleistung bei der Validierung. setmetrics = model.val()# Führen Sie eine Objekterkennung für ein Bild durch.results = model("path/to/image.jpg")results[0].show()# Exportieren Sie das Modell zu ONNX formatpath = model.export(format="onnx") # Rückgabepfad zum exportierten ModellWeitere Beispiele finden Sie in den YOLO-Python-Dokumenten.

Modelle

Hier sind YOLO11-Erkennungs-, Segment- und Pose-Modelle verfügbar, die auf dem COCO-Datensatz vorab trainiert wurden, sowie YOLO11-Klassifizierungsmodelle, die auf dem ImageNet-Datensatz vorab trainiert wurden. Der Track-Modus ist für alle Detect-, Segment- und Pose-Modelle verfügbar.

Alle Modelle werden bei der ersten Verwendung automatisch von der neuesten Ultralytics-Version heruntergeladen.

Anwendungsbeispiele für diese auf COCO trainierten Modelle, die 80 vorab trainierte Klassen umfassen, finden Sie in den Erkennungsdokumenten.

| Modell | Größe (Pixel) | Kartenwert 50-95 | Geschwindigkeit CPU ONNX (MS) | Geschwindigkeit T4 TensorRT10 (MS) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|

| YOLO11n | 640 | 39,5 | 56,1 ± 0,8 | 1,5 ± 0,0 | 2.6 | 6.5 |

| YOLO11s | 640 | 47,0 | 90,0 ± 1,2 | 2,5 ± 0,0 | 9.4 | 21.5 |

| YOLO11m | 640 | 51,5 | 183,2 ± 2,0 | 4,7 ± 0,1 | 20.1 | 68,0 |

| YOLO11l | 640 | 53.4 | 238,6 ± 1,4 | 6,2 ± 0,1 | 25.3 | 86,9 |

| YOLO11x | 640 | 54,7 | 462,8 ± 6,7 | 11,3 ± 0,2 | 56.9 | 194.9 |

mAP - Werte gelten für Einzelmodell-Einzelskalen im COCO-Datensatz val2017.

Reproduzieren Sie durch yolo val detect data=coco.yaml device=0

Geschwindigkeit gemittelt über COCO-Val-Bilder unter Verwendung einer Amazon EC2 P4d-Instanz.

Reproduzieren Sie mit yolo val detect data=coco.yaml batch=1 device=0|cpu

Anwendungsbeispiele für diese auf COCO-Seg trainierten Modelle, die 80 vorab trainierte Klassen umfassen, finden Sie in den Segmentierungsdokumenten.

| Modell | Größe (Pixel) | Kartenbox 50-95 | Kartenmaske 50-95 | Geschwindigkeit CPU ONNX (MS) | Geschwindigkeit T4 TensorRT10 (MS) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-seg | 640 | 38.9 | 32,0 | 65,9 ± 1,1 | 1,8 ± 0,0 | 2.9 | 10.4 |

| YOLO11s-seg | 640 | 46.6 | 37.8 | 117,6 ± 4,9 | 2,9 ± 0,0 | 10.1 | 35,5 |

| YOLO11m-seg | 640 | 51,5 | 41,5 | 281,6 ± 1,2 | 6,3 ± 0,1 | 22.4 | 123,3 |

| YOLO11l-seg | 640 | 53.4 | 42.9 | 344,2 ± 3,2 | 7,8 ± 0,2 | 27.6 | 142.2 |

| YOLO11x-seg | 640 | 54,7 | 43,8 | 664,5 ± 3,2 | 15,8 ± 0,7 | 62.1 | 319,0 |

mAP - Werte gelten für Einzelmodell-Einzelskalen im COCO-Datensatz val2017.

Reproduktion durch yolo val segment data=coco-seg.yaml device=0

Geschwindigkeit gemittelt über COCO-Val-Bilder unter Verwendung einer Amazon EC2 P4d-Instanz.

Reproduzieren Sie durch yolo val segment data=coco-seg.yaml batch=1 device=0|cpu

Anwendungsbeispiele für diese auf ImageNet trainierten Modelle, die 1000 vorab trainierte Klassen umfassen, finden Sie in den Klassifizierungsdokumenten.

| Modell | Größe (Pixel) | gem top1 | gem top5 | Geschwindigkeit CPU ONNX (MS) | Geschwindigkeit T4 TensorRT10 (MS) | Parameter (M) | FLOPs (B) bei 640 |

|---|---|---|---|---|---|---|---|

| YOLO11n-cls | 224 | 70,0 | 89,4 | 5,0 ± 0,3 | 1,1 ± 0,0 | 1.6 | 3.3 |

| YOLO11s-cls | 224 | 75,4 | 92,7 | 7,9 ± 0,2 | 1,3 ± 0,0 | 5.5 | 12.1 |

| YOLO11m-cls | 224 | 77,3 | 93,9 | 17,2 ± 0,4 | 2,0 ± 0,0 | 10.4 | 39.3 |

| YOLO11l-cls | 224 | 78,3 | 94,3 | 23,2 ± 0,3 | 2,8 ± 0,0 | 12.9 | 49.4 |

| YOLO11x-cls | 224 | 79,5 | 94,9 | 41,4 ± 0,9 | 3,8 ± 0,0 | 28.4 | 110.4 |

acc- Werte sind Modellgenauigkeiten im ImageNet-Dataset-Validierungssatz.

Reproduzieren Sie mit yolo val classify data=path/to/ImageNet device=0

Geschwindigkeit gemittelt über ImageNet-Wertbilder unter Verwendung einer Amazon EC2 P4d-Instanz.

Reproduzieren Sie mit yolo val classify data=path/to/ImageNet batch=1 device=0|cpu

Anwendungsbeispiele für diese auf COCO-Pose trainierten Modelle, die eine vorab trainierte Klasse und Person umfassen, finden Sie in den Pose-Dokumenten.

| Modell | Größe (Pixel) | Kartenpose 50-95 | Kartenpose 50 | Geschwindigkeit CPU ONNX (MS) | Geschwindigkeit T4 TensorRT10 (MS) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-pose | 640 | 50,0 | 81,0 | 52,4 ± 0,5 | 1,7 ± 0,0 | 2.9 | 7.6 |

| YOLO11s-Pose | 640 | 58.9 | 86,3 | 90,5 ± 0,6 | 2,6 ± 0,0 | 9.9 | 23.2 |

| YOLO11m-Pose | 640 | 64,9 | 89,4 | 187,3 ± 0,8 | 4,9 ± 0,1 | 20.9 | 71,7 |

| YOLO11l-pose | 640 | 66.1 | 89,9 | 247,7 ± 1,1 | 6,4 ± 0,1 | 26.2 | 90,7 |

| YOLO11x-Pose | 640 | 69,5 | 91.1 | 488,0 ± 13,9 | 12,1 ± 0,2 | 58,8 | 203.3 |

mAP - Werte gelten für Einzelmodell-Einzelskalen im COCO Keypoints val2017-Datensatz.

Reproduzieren Sie mit yolo val pose data=coco-pose.yaml device=0

Geschwindigkeit gemittelt über COCO-Val-Bilder unter Verwendung einer Amazon EC2 P4d-Instanz.

Reproduzieren Sie mit yolo val pose data=coco-pose.yaml batch=1 device=0|cpu

Anwendungsbeispiele für diese auf DOTAv1 trainierten Modelle, die 15 vorab trainierte Klassen umfassen, finden Sie in den OBB-Dokumenten.

| Modell | Größe (Pixel) | mAP- Test 50 | Geschwindigkeit CPU ONNX (MS) | Geschwindigkeit T4 TensorRT10 (MS) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|

| YOLO11n-obb | 1024 | 78,4 | 117,6 ± 0,8 | 4,4 ± 0,0 | 2.7 | 17.2 |

| YOLO11s-obb | 1024 | 79,5 | 219,4 ± 4,0 | 5,1 ± 0,0 | 9.7 | 57,5 |

| YOLO11m-obb | 1024 | 80,9 | 562,8 ± 2,9 | 10,1 ± 0,4 | 20.9 | 183,5 |

| YOLO11l-obb | 1024 | 81,0 | 712,5 ± 5,0 | 13,5 ± 0,6 | 26.2 | 232,0 |

| YOLO11x-obb | 1024 | 81,3 | 1408,6 ± 7,7 | 28,6 ± 1,0 | 58,8 | 520.2 |

Die mAP- Testwerte gelten für Einzelmodell-Multiskalen im DOTAv1-Datensatz.

Reproduzieren Sie es mit yolo val obb data=DOTAv1.yaml device=0 split=test und senden Sie die zusammengeführten Ergebnisse an die DOTA-Bewertung.

Geschwindigkeit gemittelt über DOTAv1-Wertbilder unter Verwendung einer Amazon EC2 P4d-Instanz.

Reproduzieren Sie mit yolo val obb data=DOTAv1.yaml batch=1 device=0|cpu

Integrationen

Unsere wichtigen Integrationen mit führenden KI-Plattformen erweitern die Funktionalität der Angebote von Ultralytics und verbessern Aufgaben wie Datensatzkennzeichnung, Schulung, Visualisierung und Modellverwaltung. Entdecken Sie, wie Ultralytics in Zusammenarbeit mit W&B, Comet, Roboflow und OpenVINO Ihren KI-Workflow optimieren kann.

![]()

![]()

![]()

| Ultralytics HUB ? | W&B | Komet ⭐ NEU | Neuronale Magie |

|---|---|---|---|

| Optimieren Sie YOLO-Workflows: Beschriften, trainieren und bereitstellen Sie mühelos mit Ultralytics HUB. Probieren Sie es jetzt aus! | Verfolgen Sie Experimente, Hyperparameter und Ergebnisse mit Weights & Biases | Mit Comet, das für immer kostenlos ist, können Sie YOLO11-Modelle speichern, das Training fortsetzen und Vorhersagen interaktiv visualisieren und debuggen | Führen Sie YOLO11-Inferenzen mit Neural Magic DeepSparse bis zu 6x schneller aus |

Ultralytics HUB

Erleben Sie nahtlose KI mit Ultralytics HUB ⭐, der Komplettlösung für Datenvisualisierung, YOLO11 ? Modellschulung und -bereitstellung, ohne jegliche Codierung. Verwandeln Sie Bilder in umsetzbare Erkenntnisse und erwecken Sie Ihre KI-Visionen ganz einfach zum Leben – mit unserer hochmodernen Plattform und der benutzerfreundlichen Ultralytics-App. Beginnen Sie Ihre Reise jetzt kostenlos !

Beitragen

Wir freuen uns über Ihren Beitrag! Ultralytics YOLO wäre ohne die Hilfe unserer Community nicht möglich. Bitte sehen Sie sich für den Einstieg unseren Beitragsleitfaden an und füllen Sie unsere Umfrage aus, um uns Feedback zu Ihren Erfahrungen zu senden. Danke ? an alle unsere Mitwirkenden!

Lizenz

Ultralytics bietet zwei Lizenzierungsoptionen für unterschiedliche Anwendungsfälle:

AGPL-3.0-Lizenz : Diese vom OSI genehmigte Open-Source-Lizenz ist ideal für Studenten und Enthusiasten und fördert die offene Zusammenarbeit und den Wissensaustausch. Weitere Einzelheiten finden Sie in der LICENSE-Datei.

Unternehmenslizenz : Diese für die kommerzielle Nutzung konzipierte Lizenz ermöglicht die nahtlose Integration der Ultralytics-Software und KI-Modelle in kommerzielle Waren und Dienstleistungen unter Umgehung der Open-Source-Anforderungen von AGPL-3.0. Wenn Ihr Szenario die Einbettung unserer Lösungen in ein kommerzielles Angebot beinhaltet, wenden Sie sich an Ultralytics Licensing.

Kontakt

Für Ultralytics-Fehlerberichte und Funktionsanfragen besuchen Sie bitte GitHub Issues. Werden Sie Mitglied von Ultralytics Discord, Reddit oder den Foren, um Fragen zu stellen, Projekte zu teilen, Diskussionen zu lernen oder Hilfe zu allen Themen rund um Ultralytics zu erhalten!