5/8/2024 : Aktualisierung des GPT-3.5- und LLama2-Inferenzcodes und der Ergebnisse für Abbildung 6, die die aufkommende Natur kognitiver Synergien zeigt.3/15/2024 : Dieser Beitrag wurde als Hauptkonferenzbeitrag bei NAACL2024 angenommen! pip install -r requirements.txt

config_template.sh ein und führen Sie source config_template.sh aus, um die Umgebungsvariablen einzurichten (Beachten Sie, dass wir in unseren Experimenten die Azure-API verwenden). Für jede der drei Aufgaben stellen wir laufende Skripte zur Verfügung. Weitere Informationen finden Sie in den Kommentaren in den „.sh“-Skripten:

bash scripts/trivia_creative_writing.shbash scripts/codenames_collaborative.shbash scripts/logic_grid_puzzle.sh Alle Eingabeaufforderungen finden Sie im Ordner prompts/ .

Alle Datensätze finden Sie im Ordner data/ .

Die experimentellen Ergebnisse in der Arbeit für jede Aufgabe finden Sie im Ordner logs/ “. gpt4_w_sys_mes und gpt4_wo_sys_mes enthalten Ergebnisse, die Tabelle 2 in unserem Artikel entsprechen. Wir schließen auch gpt-3.5- und llama2-13b-Ergebnisse ein, die den Ergebnissen in Abbildung 6 entsprechen, wobei die Hyperparameter, z. B. ob das Hinzufügen einer Systemnachricht erfolgt oder nicht, den leistungsstärksten Entscheidungen in den gpt4-Experimenten folgen.

"test_output_infos" : enthält Bewertungsmetriken für jede Instanz, z. B. # richtige Antworten genannt."*raw_responses" : Rohantworten von jedem API-Aufruf."*parsing_flag" : ob die Rohantwort erfolgreich analysiert wurde. (Für die Codenamen-Aufgabe ist dieses Feld in „parsing_success_flag_spymaster“ und „parsing_success_flag_guesser“ unterteilt.)"unwrapped_output" : analysierte Ausgabe, die zur Berechnung von Bewertungsmetriken verwendet wird. (Für die Codenamen-Aufgabe ist dieses Feld in „spymaster_output“ und „guesser_output“ unterteilt; es gibt ein zusätzliches Feld namens „hint_word“, das aus der Ausgabe des Spymasters geparst und in die Eingabe des Guessers eingefügt wird; die Bewertungsmetrik wird basierend auf „ berechnet. "gueser_output")"task data" : Daten für die aktuelle Aufgabeninstanz, z. B. Fragen, Antworten, Zielwörter usw."usage" : Protokollierung der Anzahl der bisher ausgegebenen Token und Kosten.Bitte zitieren Sie den Artikel und markieren Sie dieses Repo, wenn Sie diese Arbeit interessant/hilfreich finden.

@article{wang2023unleashing,

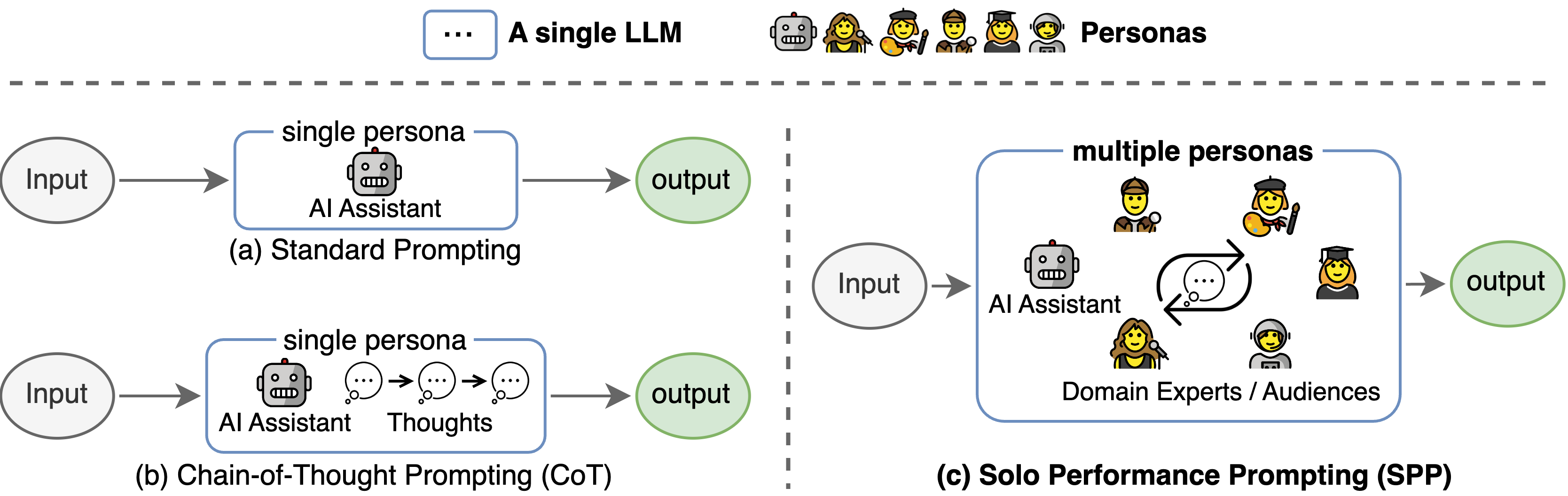

title={Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration},

author={Wang, Zhenhailong and Mao, Shaoguang and Wu, Wenshan and Ge, Tao and Wei, Furu and Ji, Heng},

journal={arXiv preprint arXiv:2307.05300},

year={2023}

}

Diese Codebasis verwies auf die Struktur des offiziellen Tree-of-thought-Repositorys. Wir danken den Autoren für ihre Open-Source-Bemühungen.