Hyeongjin Nam* 1 , Daniel Sungho Jung* 1 , Gyeongsik Moon 2 , Kyoung Mu Lee 1

![]()

![]()

1 Seoul National University , 2 Codec Avatars Lab, Meta

(*Gleicher Beitrag)

CONTHO rekonstruiert gemeinsam dreidimensionale Menschen und Objekte , indem es den Kontakt zwischen Mensch und Objekt als Schlüsselsignal für eine genaue Rekonstruktion nutzt. Zu diesem Zweck integrieren wir „3D-Mensch-Objekt-Rekonstruktion“ und „Mensch-Objekt-Kontaktschätzung“ , die beiden unterschiedlichen Aufgaben, die separat in zwei Tracks untersucht wurden, in einem einheitlichen Rahmen.

Wir empfehlen Ihnen, eine virtuelle Anaconda-Umgebung zu verwenden. Installieren Sie PyTorch >=1.10.1 und Python >= 3.7.0. Unser neuestes CONTHO-Modell wurde auf Python 3.9.13, PyTorch 1.10.1, CUDA 10.2 getestet.

Richten Sie die Umgebung ein

# Initialize conda environment conda create -n contho python=3.9 conda activate contho # Install PyTorch conda install pytorch==1.10.1 torchvision==0.11.2 torchaudio==0.10.1 cudatoolkit=10.2 -c pytorch # Install all remaining packages pip install -r requirements.txt

Bereiten Sie die base_data entweder von Google Drive oder Onedrive vor und platzieren Sie sie als ${ROOT}/data/base_data .

Laden Sie den vorab trainierten Prüfpunkt entweder von Google Drive oder OneDrive herunter.

Zum Schluss laufen Sie bitte

python main/demo.py --gpu 0 --checkpoint {CKPT_PATH} Sie müssen die Verzeichnisstruktur der data wie folgt befolgen.

${ROOT}

|-- data

| |-- base_data

| | |-- annotations

| | |-- backbone_models

| | |-- human_models

| | |-- object_models

| |-- BEHAVE

| | |-- dataset.py

| | |-- sequences

| | | |-- Date01_Sub01_backpack_back

| | | |-- Date01_Sub01_backpack_hand

| | | |-- ...

| | | |-- Date07_Sub08_yogamat

| |-- InterCap

| | |-- dataset.py

| | |-- sequences

| | | |-- 01

| | | |-- 02

| | | |-- ...

| | | |-- 10 Laden Sie die Data01~Data07-Sequenzen aus dem BEHAVE-Datensatz nach ${ROOT}/data/BEHAVE/sequences herunter.

(Option 1) Laden Sie den BEHAVE-Datensatz direkt von der Download-Seite herunter.

(Option 2) Führen Sie das folgende Skript aus.

scripts/download_behave.sh

Laden Sie RGBD_Images.zip und Res.zip vom InterCap-Datensatz nach ${ROOT}/data/InterCap/sequences herunter.

(Option 1) Laden Sie den InterCap-Datensatz direkt von der Download-Seite herunter.

(Option 2) Führen Sie das folgende Skript aus.

scripts/download_intercap.sh

Laden Sie base_data entweder von Google Drive oder Onedrive herunter.

(Optional) Laden Sie die veröffentlichten Prüfpunkte für die Datensätze BEHAVE (Google Drive | OneDrive) und InterCap (Google Drive | OneDrive) herunter.

Um CONTHO auf dem BEHAVE- oder InterCap-Datensatz zu trainieren, führen Sie bitte Folgendes aus

python main/train.py --gpu 0 --dataset {DATASET}Führen Sie bitte Folgendes aus, um CONTHO anhand des BEHAVE- oder InterCap-Datensatzes auszuwerten

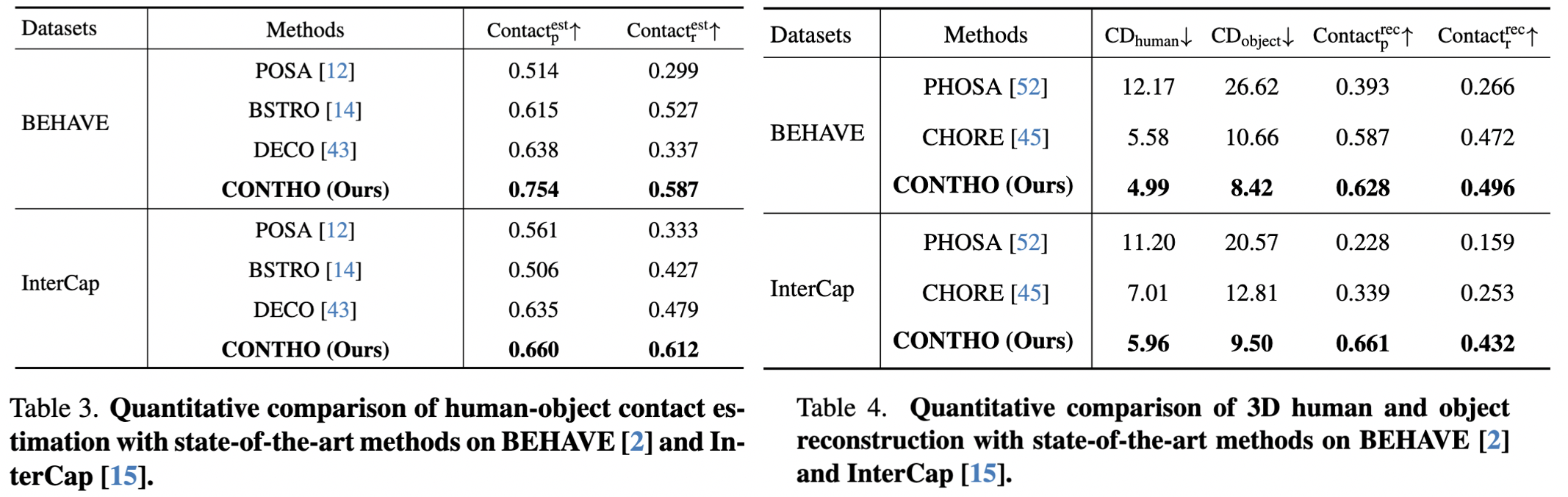

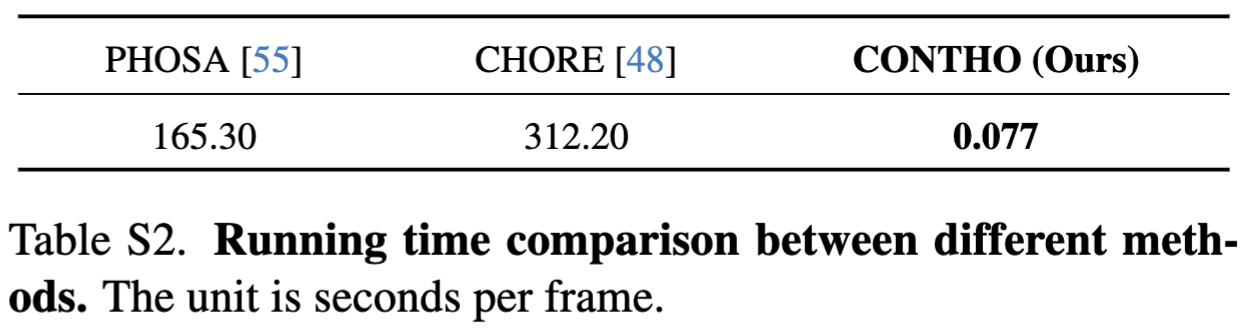

python main/test.py --gpu 0 --dataset {DATASET} --checkpoint {CKPT_PATH} Hier berichten wir über die Leistung von CONTHO.

CONTHO ist ein schnelles und genaues 3D-Rekonstruktionsframework für Menschen und Objekte!

RuntimeError: Subtraktion, der - , mit einem Bool-Tensor wird nicht unterstützt. Wenn Sie versuchen, eine Maske umzukehren, verwenden Sie stattdessen den Operator ~ oder logical_not() : Bitte überprüfen Sie die Referenz.

bash: scripts/download_behave.sh: Berechtigung verweigert: Bitte überprüfen Sie die Referenz.

Wir danken:

Hand4Whole für die 3D-Rekonstruktion menschlicher Netze.

CHORE für Training und Tests zu BEHAVE.

InterCap zum Herunterladen des Skripts des Datensatzes.

DECO für den Versuchsaufbau in freier Wildbahn.

@inproceedings{nam2024contho,

title = {Joint Reconstruction of 3D Human and Object via Contact-Based Refinement Transformer},

author = {Nam, Hyeongjin and Jung, Daniel Sungho and Moon, Gyeongsik and Lee, Kyoung Mu},

booktitle = {Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year = {2024}

}