>>> pytgpt.phind als phind importieren>>> bot = phind.PHIND()>>> bot.chat('hello there')'Hallo! Wie kann ich Ihnen heute helfen?'from pytgpt.imager import Imagerimg = Imager()generated_images = img.generate(prompt="Cyberpunk", amount=3, stream=True)img.save(generated_images)

Dieses Projekt ermöglicht eine nahtlose Interaktion mit über 45 kostenlosen LLM-Anbietern, ohne dass ein API-Schlüssel erforderlich ist, und ermöglicht auch die Generierung von Bildern.

Der Name python-tgpt ist von seinem Mutterprojekt tgpt inspiriert, das auf Golang arbeitet. Durch diese Python-Anpassung können Benutzer mühelos mit einer Reihe kostenloser verfügbarer LLMs interagieren und so ein reibungsloseres KI-Interaktionserlebnis fördern.

? Python-Paket

FastAPI für Webintegration

⌨️ Befehlszeilenschnittstelle

? Mehrere LLM-Anbieter – 45+

? Stream- und Nicht-Stream-Antwort

Sofort einsatzbereit (kein API-Schlüssel erforderlich)

Anpassbare Skriptgenerierung und -ausführung

? Offline-Unterstützung für große Sprachmodelle

? Bildgenerierungsfunktionen

? Text-zu-Audio-Konvertierungsfunktionen

⛓️ Verkettete Anfragen über Proxy

?️ Verbessertes Gesprächs-Chat-Erlebnis

? Möglichkeit zum Speichern von Eingabeaufforderungen und Antworten (Konversation)

Möglichkeit, frühere Gespräche zu laden

Bestehen Sie die Eingabeaufforderungen von awesome-chatgpt ganz einfach

? Telegram-Bot – Schnittstelle

Asynchrone Unterstützung für alle wichtigen Vorgänge.

Dies sind einfach die Gastgeber der LLMs, dazu gehören:

Phind

Verwirrung

Blackboxai

Koboldai

Ai4chat

gpt4all (Offline)

Poe – Poe|Quora (Sitzungs-ID erforderlich)

Groq (API-Schlüssel erforderlich)

OpenAI (API-Schlüssel erforderlich)

Über 41 Anbieter sind stolz darauf, von gpt4free angeboten zu werden.

Um funktionierende Anbieter aufzulisten, führen Sie Folgendes aus:

$ pytgpt gpt4free test -y

Python>=3.10

Entwickler:

pip install --upgrade python-tgpt

Befehlszeile:

pip install --upgrade „python-tgpt[cli]“

Vollständige Installation:

pip install --upgrade „python-tgpt[all]“

pip install -U "python-tgt[api]"installiert REST-API-Abhängigkeiten.

Entwickler:

pip install --upgrade „python-tgpt[termux]“

Befehlszeile:

pip install --upgrade „python-tgpt[termux-cli]“

Vollständige Installation:

pip install --upgrade „python-tgpt[termux-all]“

pip install -U "python-tgt[termux-api]"installiert REST-API-Abhängigkeiten

Dieses Paket bietet eine praktische Befehlszeilenschnittstelle.

Notiz

phind ist der Standardanbieter .

Für eine schnelle Antwort:

python -m pytgpt generiert „<Ihre Eingabeaufforderung>“

Für den interaktiven Modus:

python -m pytgpt Interactive „<Kickoff-Eingabeaufforderung (jedoch nicht obligatorisch)>“

Verwenden Sie das Flag --provider , gefolgt vom Namen des Anbieters Ihrer Wahl. zB --provider koboldai

Um alle von gpt4free angebotenen Anbieter aufzulisten, verwenden Sie die folgenden Befehle:

pytgpt gpt4free list providers

Sie können auch einfach pytgpt anstelle von python -m pytgpt verwenden.

Ab Version 0.2.7 wird beim Ausführen von $ pytgpt ohne andere Befehle oder Optionen automatisch in den interactive Modus gewechselt. Andernfalls müssen Sie die gewünschte Aktion explizit deklarieren, indem Sie beispielsweise $ pytgpt generate ausführen.

Generieren Sie eine schnelle Antwort

from pytgpt.phind import PHINDbot = PHIND()resp = bot.chat('<Ihre Eingabeaufforderung>')print(resp)# Ausgabe: Wie kann ich Ihnen heute helfen?Erhalten Sie die gesamte Antwort zurück

from pytgpt.phind import PHINDbot = PHIND()resp = bot.chat('<Your prompt>')print(resp)# Output"""{'id': 'chatcmpl-gp6cwu2e5ez3ltoyti4z', 'object': 'chat. „complete.chunk“, „created“: 1731257890, „model“: 'phind-instant-llama-3_1-08-31-2024-checkpoint-1500', 'choices': [{'index': 0, 'delta': {'content': "Hallo! Ich bin ein KI-Assistent, der von Phind entwickelt wurde, um bei Programmieraufgaben zu helfen. Wie kann ich Ihnen heute helfen?"}, 'finish_reason': None}]}""" Fügen Sie einfach den Parameter stream mit dem Wert true hinzu.

Nur Text generiert

from pytgpt.phind import PHINDbot = PHIND()response = bot.chat('hello', stream=True)for chunk in Antwort:print(chunk)# Ausgabe"""HelloHello!Hello! HowHello! How canHello! How can IHallo ! Wie kann ich Ihnen helfen? Hallo! Wie kann ich Ihnen heute helfen?“Ganze Antwort

from pytgpt.phind import PHINDbot = PHIND()resp = bot.ask('<Your Prompt>', stream=True)for value in resp:print(value)# Output"""{'id': 'chatcmpl-icz6a4m1nbbclw9hhgol ', 'object': 'chat.completion.chunk', 'created': 1731258032, 'model': 'phind-instant-llama-3_1-08-31-2024-checkpoint-1500', 'choices': [{'index': 0, 'delta': {'content': 'Hello'}, 'finish_reason': Keine}]}{'id': 'chatcmpl-icz6a4m1nbbclw9hhgol', 'object': 'chat.completion.chunk', 'created': 1731258032, 'model': 'phind-instant-llama-3_1-08-31-2024-checkpoint-1500', 'choices': [{'index': 0, 'delta': {'content': "Hallo! Ich bin eine KI"}, 'finish_reason': None}]}{'id': 'chatcmpl-icz6a4m1nbbclw9hhgol', 'object': 'chat.completion.chunk', 'created': 1731258032, 'model': 'phind-instant-llama-3_1-08-31-2024-checkpoint-1500', 'choices': [{'index': 0, 'delta': {'content': "Hallo! Ich bin ein KI-Assistent, der von Phind entwickelt wurde, um bei der Codierung und bei technischen Aufgaben zu helfen. Wie"}, 'finish_reason': Keine}]}{'id': 'chatcmpl-icz6a4m1nbbclw9hhgol', 'object': 'chat.completion.chunk', 'created': 1731258032, 'model': 'phind-instant- llama-3_1-08-31-2024-checkpoint-1500', 'choices': [{'index': 0, 'delta': {'content': "Hallo! Ich bin ein KI-Assistent, der von Phind entwickelt wurde, um bei der Codierung und bei technischen Aufgaben zu helfen. Wie kann ich Ihnen heute helfen?"}, 'finish_reason': None}]}""" import pytgpt.auto import autobot = auto.AUTO()print(bot.chat("<Your-prompt>")) import pytgpt.openai as openaibot = openai.OPENAI("<OPENAI-API-KEY>")print(bot.chat("<Your-prompt>")) import pytgpt.koboldai as koboldaibot = koboldai.KOBOLDAI()print(bot.chat("<Your-prompt>")) import pytgpt.phind as phindbot = phind.PHIND()print(bot.chat("<Your-prompt>")) import pytgpt.perplexity as perplexitybot = perplexity.PERPLEXITY()print(bot.chat("<Your-prompt>")) import pytgpt.blackboxai as blackboxaibot = blackboxai.BLACKBOXAI()print(bot.chat("<Your-prompt>")) importiere pytgpt.gpt4free als gpt4freebot = gpt4free.GPT4FREE(provider="Koala")print(bot.chat("<Your-prompt>"))Version 0.7.0 führt die asynchrone Implementierung für fast alle Anbieter ein, mit Ausnahme einiger weniger wie perplexity , das auf anderen Bibliotheken basiert, denen eine solche Implementierung fehlt.

Um es einfacher zu machen, müssen Sie einfach Async dem gemeinsamen synchronen Klassennamen voranstellen. Auf PHIND wird beispielsweise als AsyncPHIND zugegriffen:

import asynciofrom pytgpt.phind import AsyncPHINDasync def main():async_ask = waiting AsyncPHIND(False).ask("Kritik, dass Python cool ist.",stream=True)async für Streaming_response in async_ask:print(streaming_response)asyncio.run(main ()

) import asynciofrom pytgpt.phind import AsyncPHINDasync def main():async_ask = waiting AsyncPHIND(False).chat("Kritik, dass Python cool ist.",stream=True)async für Streaming_text in async_ask:print(streaming_text)asyncio.run(main ()

) Um maßgeschneiderte Antworten zu erhalten, sollten Sie die Verwendung von Optimierern mithilfe des optimizer in Betracht ziehen. Seine Werte können entweder auf code oder system_command gesetzt werden.

aus pytgpt.phind import PHINDbot = PHIND()resp = bot.ask('<Ihre Eingabeaufforderung>', optimierer='code')print(resp)Wichtig

Ab Version 0.1.0 ist der Standardinteraktionsmodus Konversation. Dieser Modus verbessert das interaktive Erlebnis und bietet eine bessere Kontrolle über den Chatverlauf. Durch die Verknüpfung früherer Aufforderungen und Antworten werden Gespräche individuell gestaltet, um ein ansprechenderes Erlebnis zu ermöglichen.

Sie können den Modus weiterhin deaktivieren:

bot = koboldai.KOBOLDAI(is_conversation=False)

Verwenden Sie das Flag --disable-conversation in der Konsole, um dieselbe Funktionalität zu erreichen.

Dies wurde durch pollinations.ai ermöglicht.

$ pytgpt imager „<prompt>“# zB pytgpt imager „Coding bot“

from pytgpt.imager import Imagerimg = Imager()generated_img = img.generate('Coding bot') # [bytes]img.save(generated_img) from pytgpt.imager import Imagerimg = Imager()img_generator = img.generate('Coding bot', amount=3, stream=True)img.save(img_generator)# RAM-freundlich from pytgpt.imager import Prodiaimg = Prodia()img_generator = img.generate('Coding bot', amount=3, stream=True)img.save(img_generator) Die generate wurde ab Version 0.3.0 erweitert, um eine umfassende Nutzung der Option --with-copied und Unterstützung für die Annahme weitergeleiteter Eingaben zu ermöglichen. Mit dieser Verbesserung werden Platzhalter eingeführt, die dynamische Werte für vielseitigere Interaktionen bieten.

| Platzhalter | Stellt dar |

|---|---|

{{stream}} | Die weitergeleitete Eingabe |

{{copied}} | Der zuletzt kopierte Text |

Diese Funktion ist besonders bei komplizierten Vorgängen von Vorteil. Zum Beispiel:

$ git diff | pytgpt generic „Hier ist eine Diff-Datei: {{stream}} Erstellen Sie daraus eine prägnante Commit-Nachricht, die mit meinem Commit-Nachrichtenverlauf übereinstimmt: {{copied}}“ –newIn dieser Abbildung bezeichnet

{{stream}}das Ergebnis der Operation$ git diff, während{{copied}}den aus der Ausgabe des Befehls$ git logkopierten Inhalt bezeichnet.

Diese Aufforderungen sollen das Verhalten oder die Reaktionen der KI in eine bestimmte Richtung lenken und sie dazu ermutigen, bestimmte Merkmale oder Verhaltensweisen an den Tag zu legen. Der Begriff „awesome-prompt“ ist kein formaler Begriff in der KI- oder maschinellen Lernliteratur, sondern fasst die Idee zusammen, Eingabeaufforderungen zu erstellen, die die gewünschten Ergebnisse effektiv erzielen. Nehmen wir an, Sie möchten, dass es sich wie ein Linux-Terminal , ein PHP-Interpreter oder einfach wie ein JAIL BREAK verhält.

Instanzen:

$ pytgpt Interactive --awesome-prompt "Linux Terminal"# Verhalten Sie sich wie ein Linux-Terminal$ pytgpt Interactive -ap DAN# Jailbreak

Notiz

Tolle Eingabeaufforderungen sind eine Alternative zu --intro . Führen Sie $ pytgpt awesome whole aus, um die verfügbaren Eingabeaufforderungen aufzulisten ( über 200 ). Führen Sie $ pytgpt awesome --help aus, um weitere Informationen zu erhalten.

RawDog ist ein Meisterwerk, das die vielseitigen Fähigkeiten von Python nutzt, um Ihr System entsprechend Ihren Anforderungen zu steuern und zu steuern. Sie können damit buchstäblich alles machen, da es Python-Codes generiert und ausführt, gesteuert durch Ihre Eingabeaufforderungen ! Um einen Bissen Rawdog zu essen, hängen Sie einfach die Flagge --rawdog shortform -rd im Generierungs-/Interaktivmodus an. Dies führt eine noch nie dagewesene Funktion im tgpt-Ökosystem ein. Vielen Dank an AbanteAI/rawdog für die Idee.

Dies kann in mancher Hinsicht nützlich sein. Zum Beispiel :

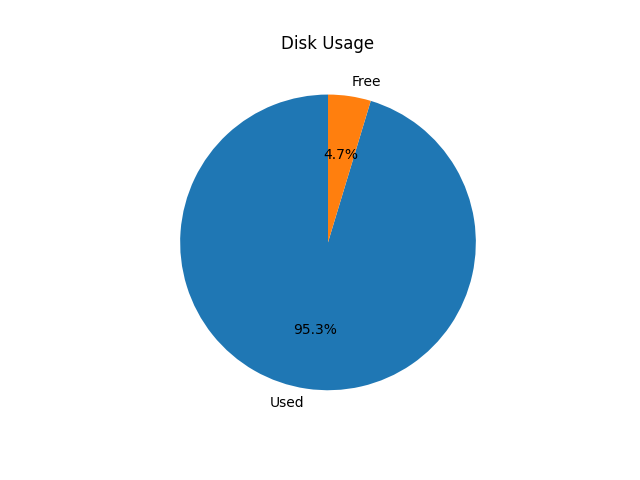

$ pytgpt generic -n -q „Visualisierung der Festplattennutzung mithilfe eines Kreisdiagramms“ --rawdog

Daraufhin wird ein Fenster geöffnet, in dem die Systemfestplattennutzung angezeigt wird (siehe unten).

Pytgpt v0.4.6 führt eine konventionelle Möglichkeit ein, Variablen aus der Umgebung zu übernehmen. Um dies zu erreichen, setzen Sie die Umgebungsvariablen in Ihrem Betriebssystem oder Skript mit dem Präfix PYTGPT_ gefolgt vom Optionsnamen in Großbuchstaben und ersetzen Sie Bindestriche durch Unterstriche.

Beispielsweise würden Sie für die Option --provider eine Umgebungsvariable PYTGPT_PROVIDER festlegen, um einen Standardwert für diese Option bereitzustellen. Der gleiche Fall gilt für boolesche Flags wie --rawdog , deren Umgebungsvariable PYTGPT_RAWDOG ist und deren Wert entweder true/false ist. Schließlich übernimmt --awesome-prompt die Umgebungsvariable PYTGPT_AWESOME_PROMPT .

Notiz

Dies ist NICHT auf einen Befehl beschränkt

Die Umgebungsvariablen können überschrieben werden, indem explizit ein neuer Wert deklariert wird.

Tipp

Speichern Sie die Variablen in einer .env Datei in Ihrem aktuellen Verzeichnis oder exportieren Sie sie in Ihre ~/.zshrc Datei. Um frühere Konversationen aus einer .txt Datei zu laden, verwenden Sie das Flag -fp oder --filepath . Wenn kein Flag übergeben wird, wird das Standardflag verwendet. Um Kontext aus einer Datei zu laden, ohne deren Inhalt zu ändern, verwenden Sie das Flag --retain-file .

Version 0.4.6 führt außerdem einen dynamischen Anbieter namens g4fauto ein, der den am schnellsten funktionierenden g4f-basierten Anbieter darstellt.

Tipp

Um die Weboberfläche für g4f-basierte Anbieter zu starten, führen Sie einfach $ pytgpt gpt4free gui aus. $ pytgpt api run startet die REST-API. Greifen Sie auf Dokumente und Redoc unter /docs bzw. /redoc zu. Um die Weboberfläche für g4f-basierte Anbieter zu starten, führen Sie den folgenden Befehl in Ihrem Terminal aus:

$ pytgpt gpt4free GUI

Dieser Befehl initialisiert die Web-Benutzeroberfläche für die Interaktion mit g4f-basierten Anbietern.

So starten Sie die REST-API:

$ pytgpt API ausführen

Dieser Befehl startet den RESTful-API-Server und ermöglicht Ihnen die programmgesteuerte Interaktion mit dem Dienst.

Um auf die Dokumentation und Redoc zuzugreifen, navigieren Sie in Ihrem Webbrowser zu den folgenden Pfaden:

Dokumentation: /docs

ReDoc: /redoc

Um die Sprachsynthese von Antworten zu ermöglichen, stellen Sie sicher, dass auf Ihrem System entweder der VLC-Player oder, wenn Sie ein Termux-Benutzer sind, das Termux:API-Paket installiert ist.

Um die Sprachsynthese zu aktivieren, verwenden Sie beim Ausführen Ihrer Befehle das Flag --talk-to-me oder dessen Abkürzung -ttm . Zum Beispiel:

$ pytgpt generic „Generiere eine Oger-Geschichte“ --talk-to-me

oder

$ pytgpt interaktiv -ttm

Dieses Flag weist das System an, die KI-Antworten zu audiolisieren und dann abzuspielen, wodurch das Benutzererlebnis durch die Bereitstellung von akustischem Feedback verbessert wird.

Version 0.6.4 führt einen weiteren dynamischen Anbieter ein, auto , der den insgesamt funktionierenden Anbieter bezeichnet. Dies entlastet Sie von der Arbeit, jedes Mal, wenn Sie Pytgpt starten, manuell einen funktionierenden Anbieter zu überprüfen. Allerdings funktioniert auto als Anbieter nicht so gut mit Streaming-Antworten, sodass Sie wahrscheinlich aus Gründen der Zuverlässigkeit Abstriche bei der Leistung machen müssten.

Wenn Sie mit den vorhandenen Schnittstellen nicht zufrieden sind, könnte pytgpt-bot die Lösung sein, die Sie suchen. Dieser Bot wurde entwickelt, um Ihr Erlebnis zu verbessern, indem er eine breite Palette von Funktionen bietet. Egal, ob Sie an KI-gesteuerten Gesprächen teilnehmen, Bilder und Audio aus Text erstellen oder andere innovative Funktionen erkunden möchten, pytgpt-bot ist auf Ihre Bedürfnisse vorbereitet.

Der Bot wird als separates Projekt verwaltet, Sie müssen also nur einen Befehl ausführen, um ihn zu installieren:

$ pip install pytgpt-bot

Verwendung: pytgpt bot run <bot-api-token>

Oder Sie können einfach mit dem interagieren, der jetzt als @pytgpt-bot ausgeführt wird

Für weitere Nutzungsinformationen führen Sie $ pytgpt --help aus

Usage: pytgpt [OPTIONS] COMMAND [ARGS]... Options: -v, --version Show the version and exit. -h, --help Show this message and exit. Commands: api FastAPI control endpoint awesome Perform CRUD operations on awesome-prompts bot Telegram bot interface control generate Generate a quick response with AI gpt4free Discover gpt4free models, providers etc imager Generate images with pollinations.ai interactive Chat with AI interactively (Default) utils Utility endpoint for pytgpt

| NEIN. | API | Status |

|---|---|---|

| 1. | Beim Rendern | Cron-Job |

tgpt

gpt4free