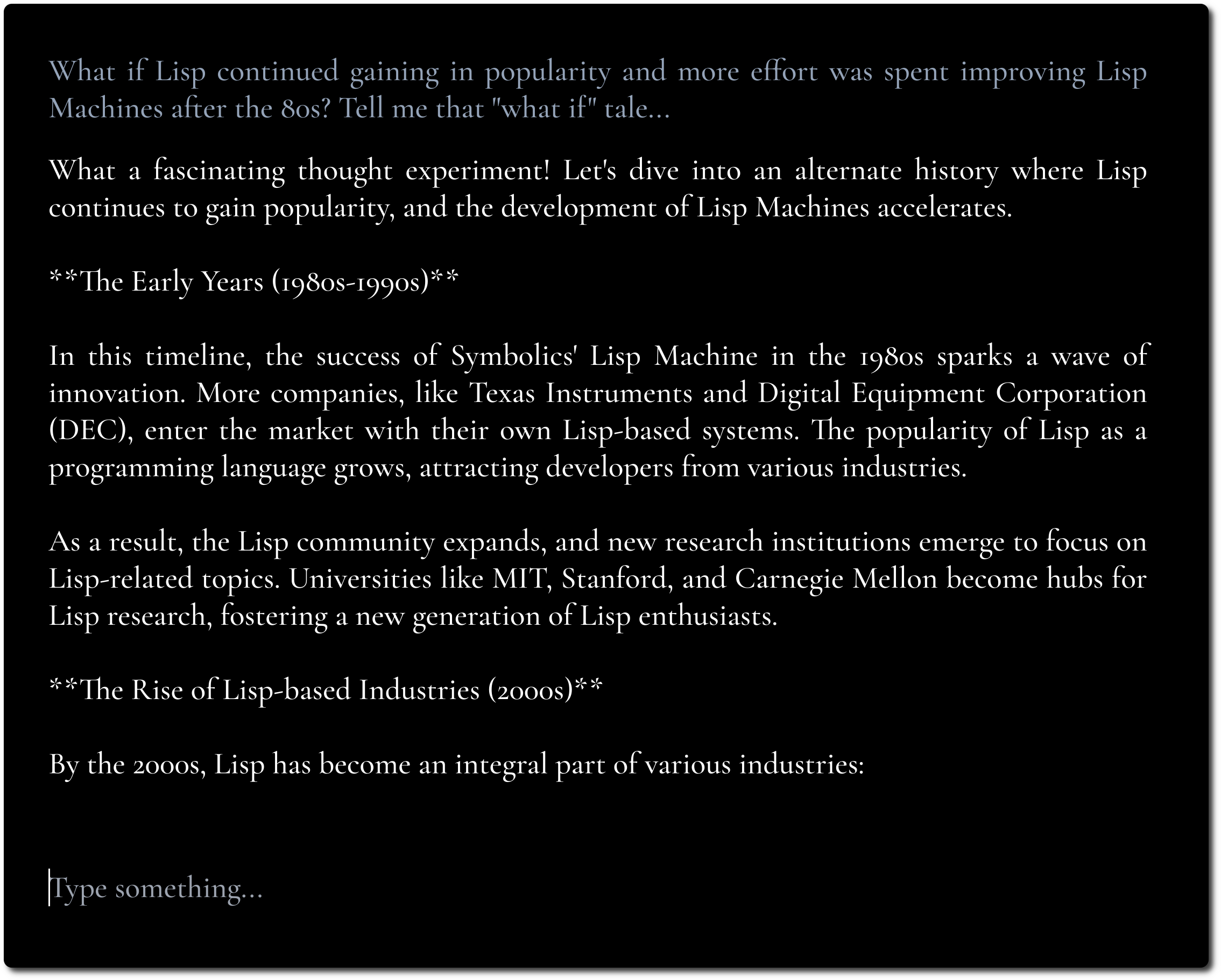

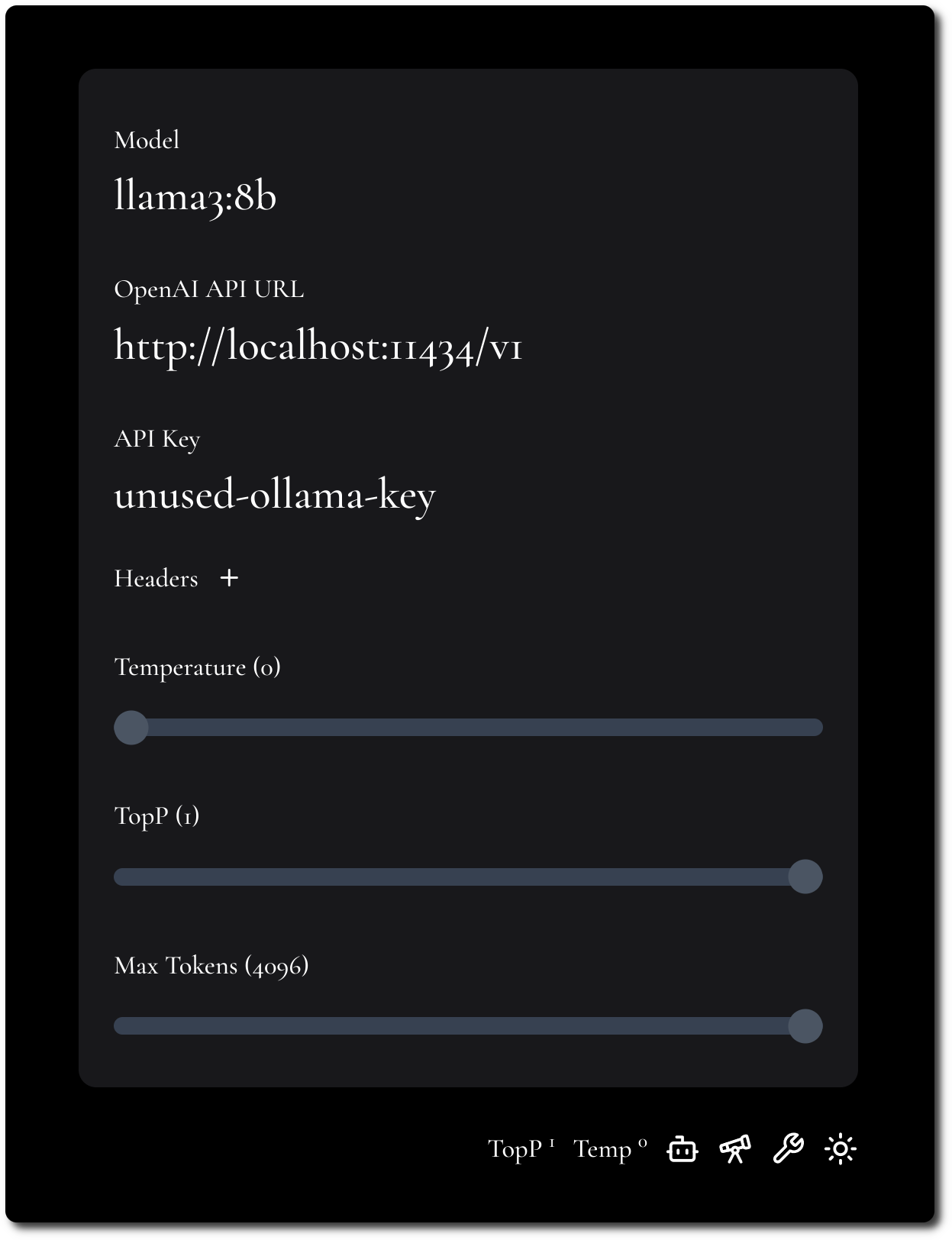

Eine minimalistische LLM-Chat-Benutzeroberfläche, inspiriert von Fooocus und Pi.

Wenn Sie einen CORS-fähigen API-Endpunkt verwenden möchten, können Sie ihn hier ausprobieren.

Das Ziel besteht darin, sich auf den Inhalt zu konzentrieren und so viele Basteleien und Anpassungen wie möglich zu vermeiden.

Wir betonen den Inhalt durch fette Typografie und minimalistisches Design.

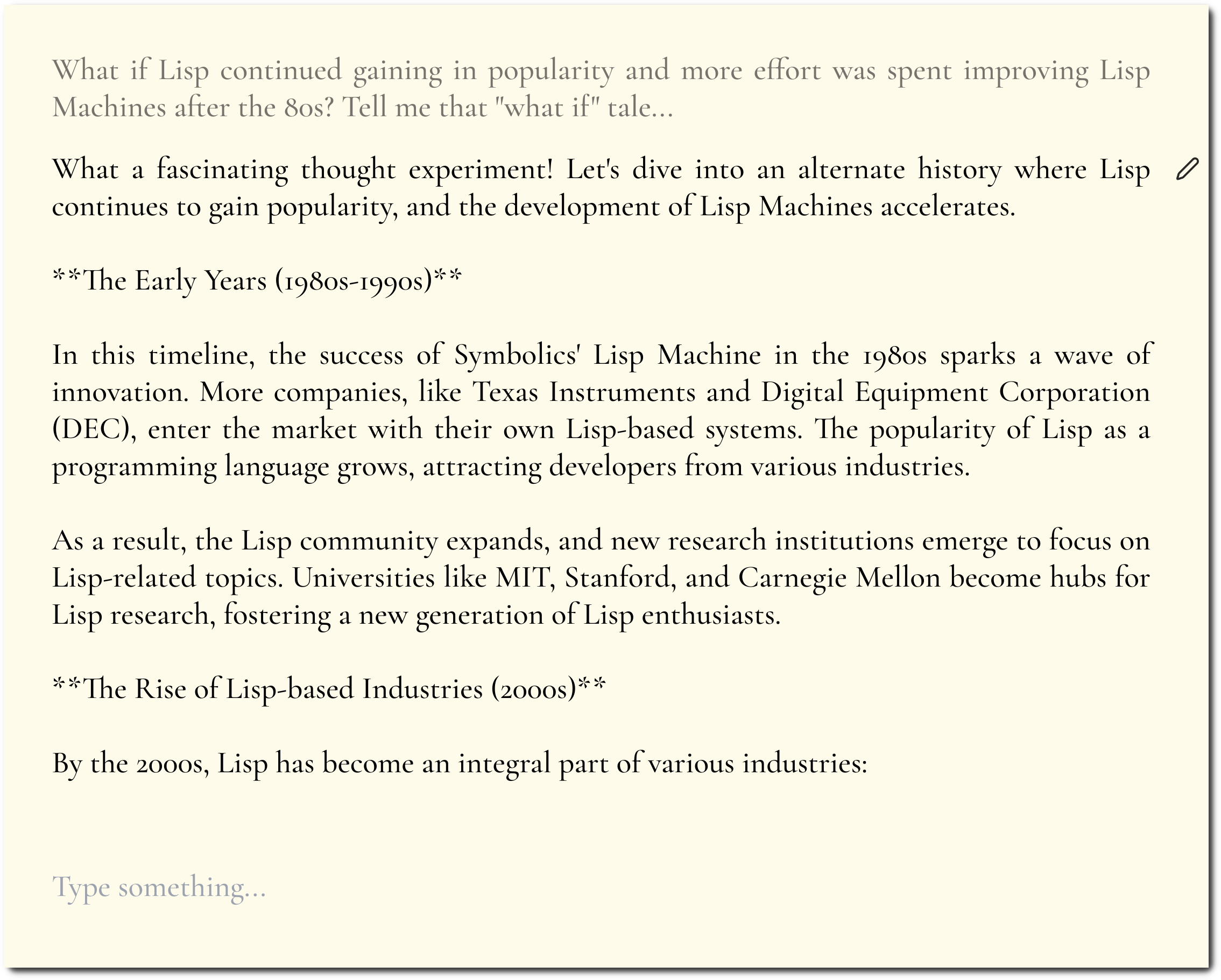

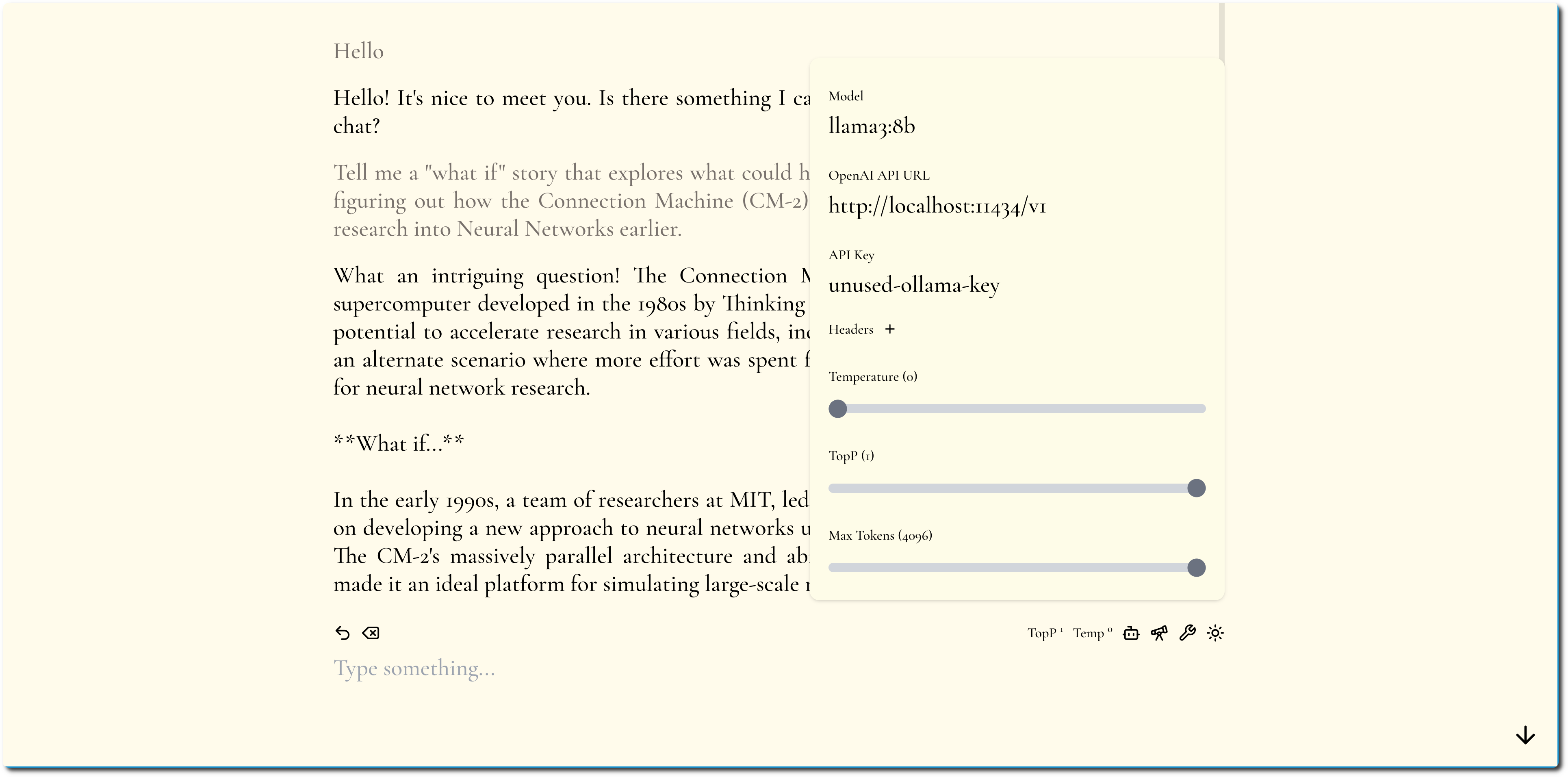

Wir versuchen, die Konfiguration minimal und dennoch flexibel zu halten.

MiniChat unterstützt OpenAI-kompatible APIs. Informationen zum Ausführen von MiniChat mit verschiedenen Modellanbietern durch Nutzung von Gateways wie Portkey finden Sie im Abschnitt „Docker Compose“.

Sie können MiniChat mit Docker ausführen, das Image ist weniger als 2 MB groß.

docker run -p 3216:3216 ghcr.io/functorism/minichat:master

Laufen

docker compose -f docker-compose-ollama.yml up

docker exec minichat-ollama-1 ollama pull llama3:8b

UI-Einstellungen:

Laufen

docker compose -f docker-compose-portkey.yml up

UI-Einstellungen:

Laufen

docker compose -f docker-compose-tf-tgi.yml up

UI-Einstellungen: