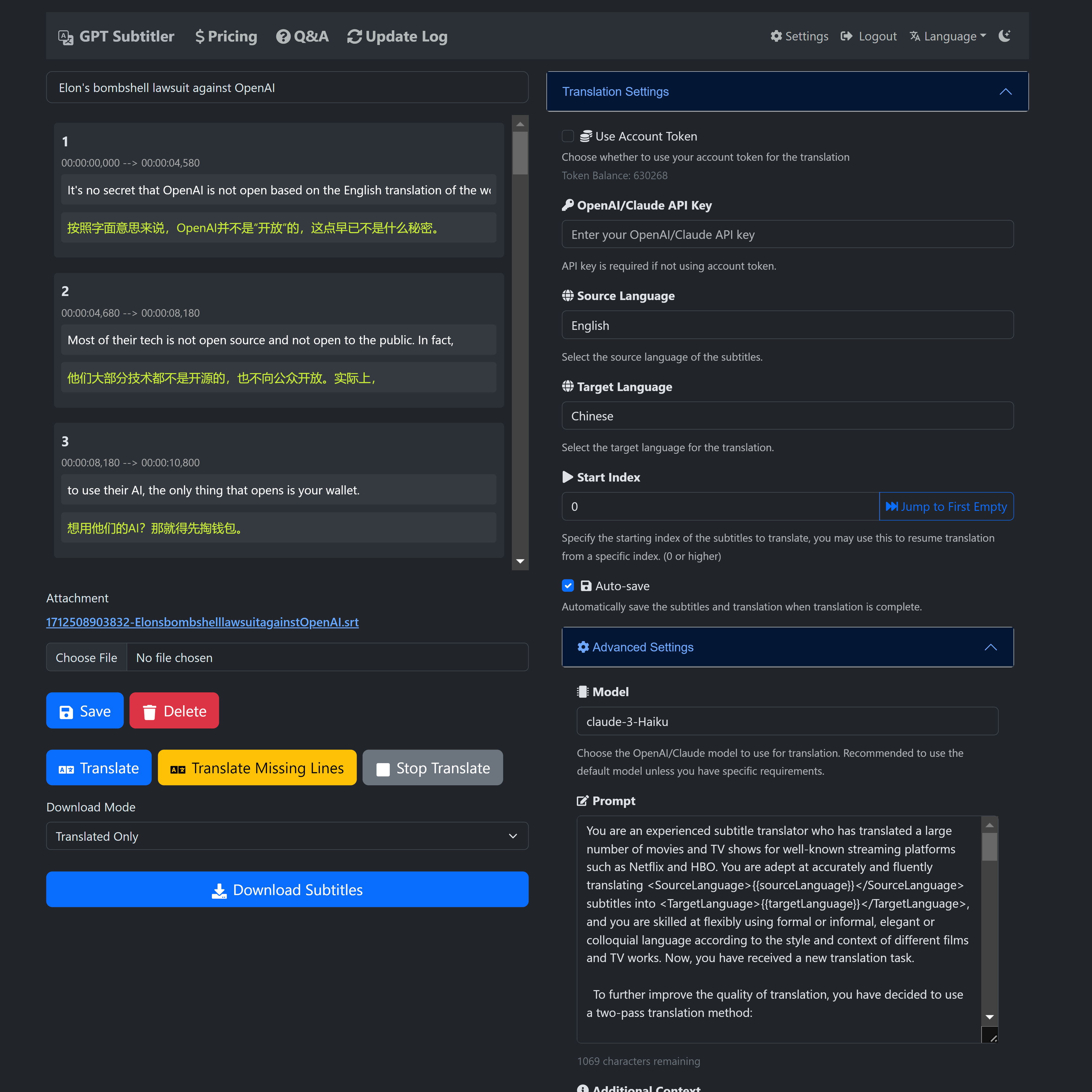

? GPT Subtitler ist eine von diesem Projekt inspirierte Webanwendung mit vielen leistungsstarken Funktionen:

Unterstützt hochwertige Untertitelübersetzungen mit verschiedenen Modellen wie Anthropic Claude, GPT-3.5 und GPT-4. Derzeit wird das Claude-Haiku -Modell empfohlen.

Darüber hinaus stehen den Benutzern die Modelle Gemini-1.5-flash und Gemini-1.5-pro kostenlos zum Ausprobieren zur Verfügung, obwohl sie möglicherweise nicht so genau sind wie das Claude-Haiku-Modell.

? Neue Benutzer erhalten bei der Registrierung 100.000 kostenlose Token, genug, um 20 Minuten Videountertitel kostenlos zu übersetzen.

? Täglich können kostenlose Token beansprucht werden, außerdem können Token zu günstigen Preisen erworben werden. Für die Verwendung der KI-Übersetzung ist kein API-Schlüssel erforderlich.

? Echtzeitvorschau der Übersetzungsergebnisse, Unterstützung für Bearbeitungsaufforderungen, Beispiele mit wenigen Aufnahmen und die Möglichkeit, die Übersetzung jederzeit zu stoppen und an jeder Position neu zu starten. Nach der Übersetzung können mehrere SRT-Untertiteldateiformate exportiert werden (Übersetzung + Original oder Original + Übersetzung zweisprachiger Untertitel).

Die Website befindet sich derzeit in der frühen Entwicklungsphase und benötigt Ihre Unterstützung und Ihr Feedback! Gerne können Sie es ausprobieren und wertvolle Anregungen geben.

Wenn Sie während der Nutzung auf Fehler stoßen oder Vorschläge haben, können Sie gerne ein Problem im GitHub-Projekt melden oder Feedback per E-Mail senden.

Website-Link https://gptsubtitler.com/en

Vielen Dank für Ihre Unterstützung und dafür, dass Sie bis hierher gelesen haben!

Hier ist ein Einlösecode für 100.000 Token: GPTSubtitler_github_repo

Sie können es in den Einstellungen verwenden

下载 YouTube 视频 (或提供您自己的视频) und Whisper 和翻译API生成双语字幕, 中文文档请见 中文

Bei diesem Projekt handelt es sich um ein Python-Skript, das ein YouTube-Video herunterlädt (oder eine lokale Videodatei verwendet), es transkribiert, das Transkript in eine Zielsprache übersetzt und ein Video mit doppelten Untertiteln (Original und übersetzt) generiert. Die Transkription und Übersetzung werden durch das Whisper-Modell bzw. die Übersetzungs-API (M2M100, Google, GPT3.5) unterstützt.

GPT-3.5-Übersetzung im Vergleich zu Google Translate

Argumente:

Wenn das Skript zum ersten Mal ausgeführt wird, werden außerdem die folgenden vorab trainierten Modelle heruntergeladen:

pip install -r requirements.txtSie können entweder eine YouTube-URL oder eine lokale Videodatei zur Verarbeitung bereitstellen. Das Skript transkribiert das Video, übersetzt das Transkript und generiert zwei Untertitel in Form einer SRT-Datei.

python main.py --youtube_url [YOUTUBE_URL] --target_language [TARGET_LANGUAGE] --model [WHISPER_MODEL] --translation_method [TRANSLATION_METHOD]

--youtube_url: Die URL des YouTube-Videos.

--local_video: Der Pfad zur lokalen Videodatei.

--target_lingual: Die Zielsprache für die Übersetzung (Standard: 'zh').

--model: Wählen Sie eines der Whisper-Modelle (Standard: 'klein', Auswahlmöglichkeiten: ['tiny', 'base', 'small', 'medium', 'large']).

--translation_method: Die für die Übersetzung zu verwendende Methode. (Standard: 'google', Auswahlmöglichkeiten: ['m2m100', 'google', 'whisper', 'gpt', 'no_translate']).

--no_transcribe: Den Transkriptionsschritt überspringen. Angenommen, es gibt eine SRT-Datei mit demselben Namen wie die Videodatei

Hinweis: Sie müssen entweder --youtube_url oder --local_video angeben, aber nicht beides.

So laden Sie ein YouTube-Video herunter, transkribieren es und generieren Untertitel in der Zielsprache mithilfe der Google-API zum Übersetzen:

python main.py --youtube_url [YOUTUBE_URL] --target_language 'zh' --model 'small' --translation_method 'google'

Um eine lokale Videodatei zu verarbeiten, zu transkribieren und Untertitel in der Zielsprache mit gpt3.5-16k zu generieren (Sie müssen einen OpenAI-API-Schlüssel angeben)):

python main.py --local_video [VIDEO_FILE_PATH] --target_language 'zh' --model 'medium' --translation_method 'gpt'

Das Skript generiert die folgenden Ausgabedateien im selben Verzeichnis wie das Eingabevideo:

Dieses Skript übersetzt Untertitel mithilfe des GPT-3.5-Sprachmodells von OpenAI. Für die Funktion ist ein OpenAI-API-Schlüssel erforderlich. In den meisten Fällen liefern GPT-basierte Übersetzungen viel bessere Ergebnisse als Google Translate, insbesondere wenn es um kontextspezifische Übersetzungen oder idiomatische Ausdrücke geht. Dieses Skript soll eine alternative Methode zum Übersetzen von Untertiteln bieten, wenn herkömmliche Übersetzungsdienste wie Google Translate keine zufriedenstellenden Ergebnisse liefern.

OPENAI_API_KEY=your_api_key_here

Ersetzen Sie your_api_key_here durch den API-Schlüssel, den Sie von OpenAI erhalten haben.

python translate_gpt.py --input_file INPUT_FILE_PATH [--batch_size BATCH_SIZE] [--target_language TARGET_LANGUAGE] [--source_language SOURCE_LANGUAGE] [--video_info VIDEO_INFO] [--model MODEL_NAME] [--no_mapping] [--load_tmp_file]

Sie können die Datei response.log im Ordner mit der Eingabevideodatei auf Live-Updates überprüfen, ähnlich wie bei ChatGPT.

Notiz:

Videoinformationen: Das Argument --video_info akzeptiert Details in jeder Sprache. Es kann verwendet werden, um das GPT-Modell über den Inhalt des Videos zu informieren und so die Übersetzung kontextspezifischer Begriffe, wie z. B. Eigennamen innerhalb eines Spiels, zu verbessern. Wenn Sie beispielsweise ein Video zum Thema Gaming übersetzen, können Sie GPT anweisen, präzise Übersetzungen für die Terminologie im Spiel zu verwenden.

Übersetzungszuordnung: Diese Funktionalität gewährleistet die Konsistenz häufig verwendeter Begriffe durch die Speicherung von Quelle-Ziel-Übersetzungspaaren. Wenn diese Option aktiviert ist, werden Variationen bei der Übersetzung von Begriffen wie Eigennamen und Fachjargon im gesamten Video verhindert. Deaktivieren Sie dies bei Bedarf mit dem Flag --no_mapping .

Übersetzungen fortsetzen: Verwenden Sie das Flag --load_tmp_file um eine Übersetzungsaufgabe an der Stelle fortzusetzen, an der sie zuvor unterbrochen wurde. Das Skript speichert den Fortschritt in tmp_subtitles.json und ermöglicht so eine nahtlose Wiederaufnahme, ohne vorherige Arbeiten wiederholen zu müssen.

Sprachunterstützung: Während sich das Skript durch Übersetzungen vom Englischen ins vereinfachte Chinesisch auszeichnet, kann es auch andere Sprachpaare unterstützen. Erhöhen Sie die Genauigkeit für weitere Sprachen, indem Sie maßgeschneiderte Few-Shot-Beispiele zu few_shot_examples.json hinzufügen. Beachten Sie, dass die Leistung der GPT-Modelle bei mehrsprachigen Eingaben variieren kann und sofortige Anpassungen in translate_gpt.py erforderlich sein könnten.

Beiträge sind herzlich willkommen!

Sie können dieses Skript auch mit einem Google Colab-Notizbuch ausprobieren. Klicken Sie auf den Link unten, um auf das Beispiel zuzugreifen:

Befolgen Sie die Anweisungen im Notizbuch, um die erforderlichen Pakete und Modelle herunterzuladen und das Skript für Ihr gewünschtes YouTube-Video oder Ihre lokale Videodatei auszuführen.