Eine auf UniAI entwickelte und von KimiChat inspirierte Anwendung mit Integration in mehrere KI-Modelle.

中文说明

Wir sind von Moonshot und seinem Produkt KimiChat inspiriert. Dies veranlasste uns, LeChat Pro zu entwickeln und als Open-Source-Lösung bereitzustellen, eine Dokumentenanalyse- und Frage-und-Antwort-Chat-Plattform, die auf generativen KI-Modellen und Wissensgraphen basiert. LeChat Pro unterstützt das Parsen einer vollständigen Suite von Office-Dokumenten, PDFs, Bildern und mehr, präsentiert in einem Chat-Format ähnlich wie ChatGPT.

Unser Projekt ist einfach und von der Community getragen und stützt sich auf Open-Source-Beiträge, um die Funktionalität zu verbessern. Wir heißen Sie herzlich willkommen, gemeinsam mit uns LeChat zu aktualisieren!

Obwohl uns die Ressourcen fehlen, um unsere eigenen großen Sprachmodelle zu trainieren, gewährt uns dies Flexibilität bei der Modellauswahl und ermöglicht die Integration mit jedem Modell. Derzeit unterstützt LeChat Pro :

Sie können zusätzliche Modelle verbinden, indem Sie zu unserem anderen Open-Source-Projekt UniAI beitragen, das die Kernbibliothek für die Multi-Modell-Unterstützung von LeChat darstellt.

Wenn Sie Open-Source-Modelle gegenüber kommerziellen bevorzugen, bieten wir Unterstützung für das GLM-Modell. Befolgen Sie für die Bereitstellung bitte die Anweisungen unter https://github.com/uni-openai/GLM-API und konfigurieren Sie dann die Backend-Umgebungsvariablen, um die GLM_API -Adresse hinzuzufügen.

Erleben Sie es hier:

https://lechat.cas-ll.cn

Open-Source-Backend-Repository:

https://github.com/uni-openai/uniai-maas

UniAI-Kernbibliothek:

https://github.com/uni-openai/uniai

Mini-Programm-Repository:

https://github.com/uniai-lab/lechat-miniapp-v1

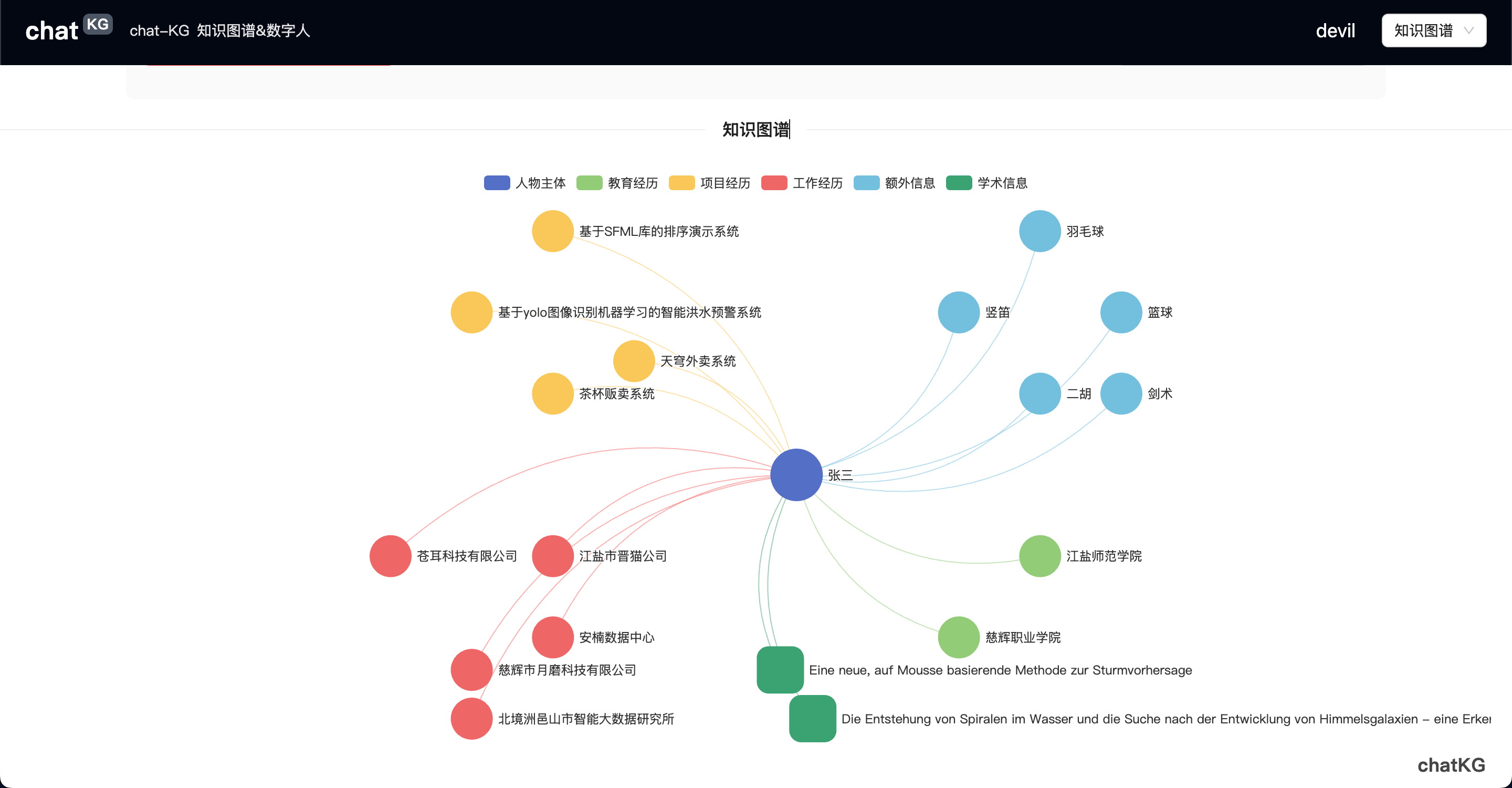

Wir entwickeln eine innovative Funktion für den Chat basierend auf Wissensgraphen – ChatKG .

Hinweis: Für dieses Projekt ist das UniAI-Backend-Framework erforderlich. Stellen Sie es hier bereit.

Bevor Sie beginnen, stellen Sie sicher, dass Node.js installiert ist. Wenn nicht, laden Sie es hier herunter.

Navigieren Sie nach der Einrichtung zum Stammverzeichnis des Projekts und führen Sie zum Starten die folgenden Befehle aus:

npm install

npm run devOder

yarn

yarn devBei Erfolg sehen Sie normalerweise eine Ausgabe ähnlich der folgenden:

VITE v3.2.5 ready in 294 ms

➜ Local: http://localhost:5173/

➜ Network: use --host to expose Halten Sie Ctrl oder Command gedrückt und klicken Sie auf den Link „Lokal“, um das Projekt in Ihrem Browser zu öffnen. Sie können sich mit einem QR-Code oder einem mobilen Verifizierungscode anmelden, um mit der Nutzung der Anwendung zu beginnen.

Wenn Sie planen, das Projekt für die lokale Bereitstellung zu packen, lesen Sie hier.

Weilong Yu

Youwei Huang

Dieses Projekt ist unter der MIT-Lizenz lizenziert.