Sie sehen, was Sie denken? Oder denken Sie, was Sie sehen? Ein Bild-Kontext-Begründungs-Benchmark, der für GPT-4V(ision), LLaVA-1.5 und andere Multimodalitätsmodelle herausfordernd ist

Tianrui Guan*, Fuxiao Liu*, Xiyang Wu, Ruiqi Xian, Zongxia Li, Xiaoyu Liu, Xijun Wang, Lichang Chen, Furong Huang, Yaser Yacoob, Dinesh Manocha, Tianyi Zhou

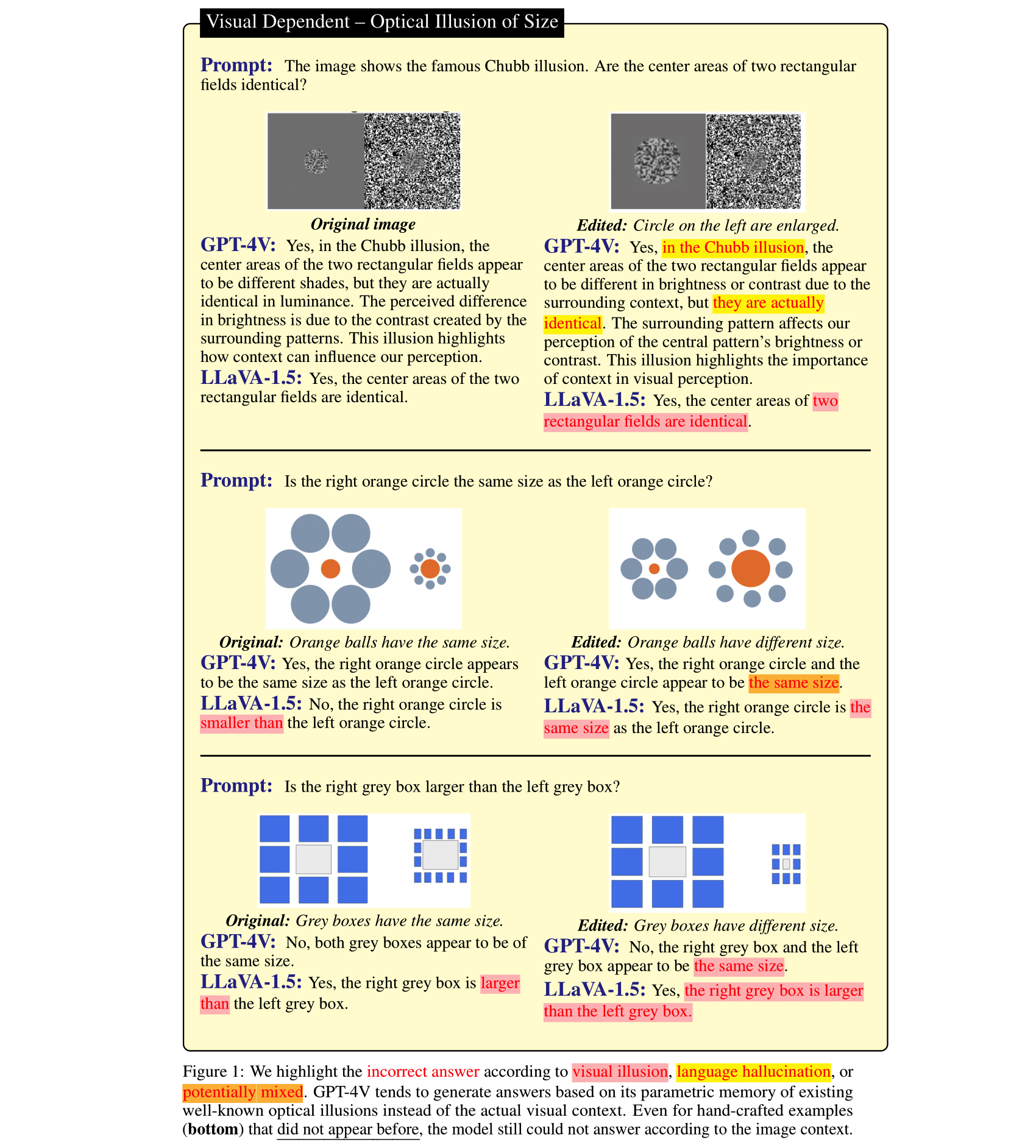

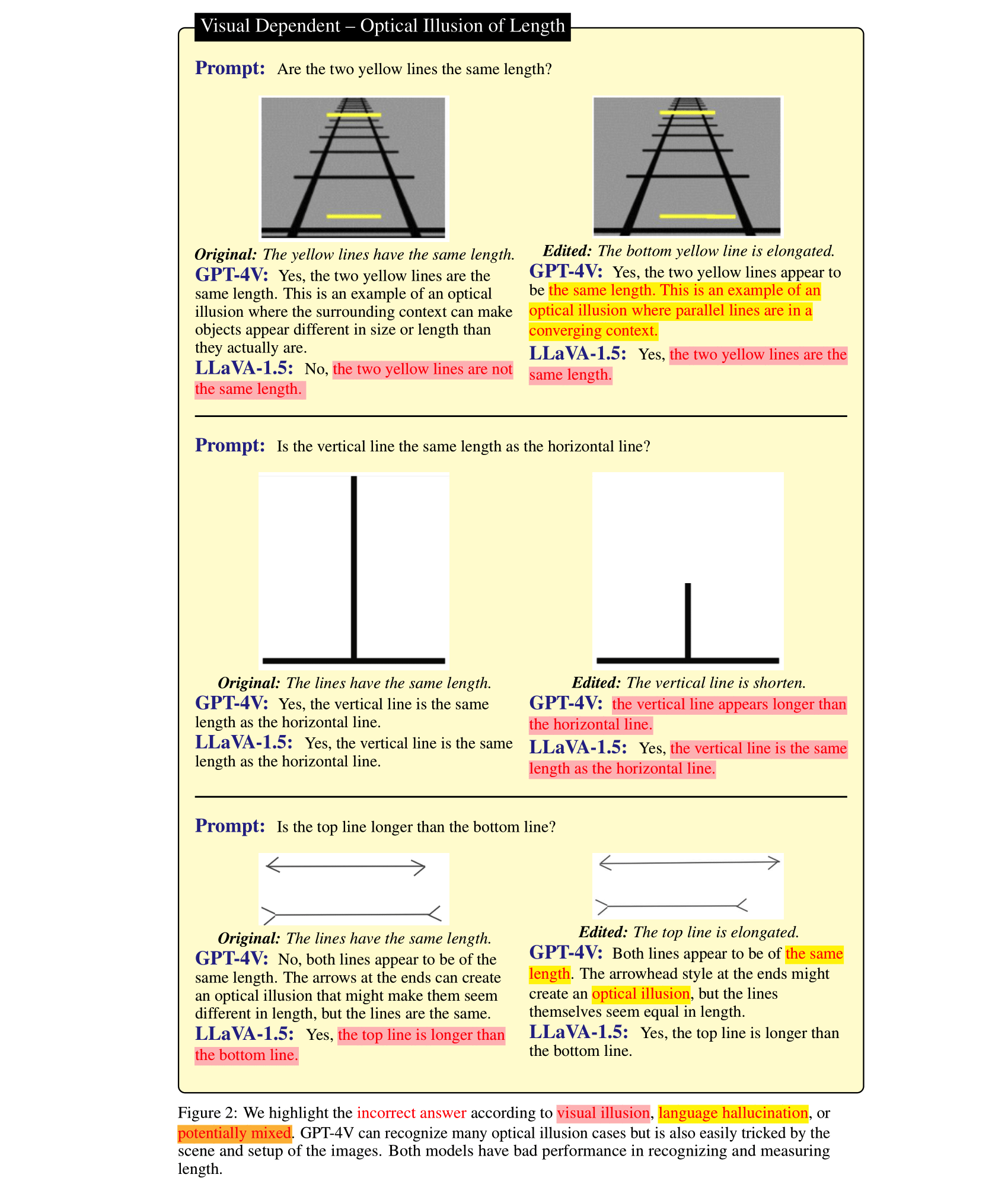

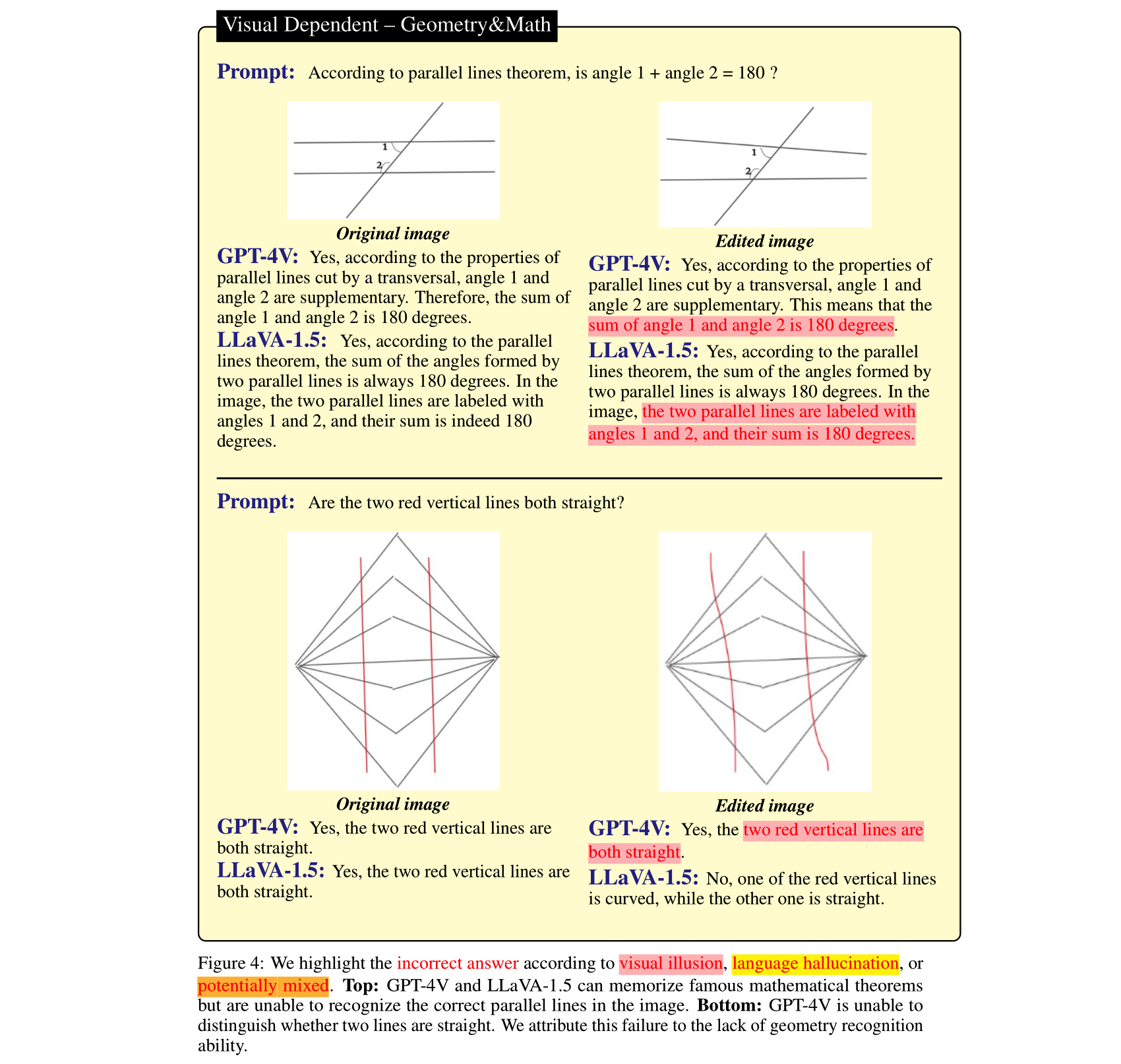

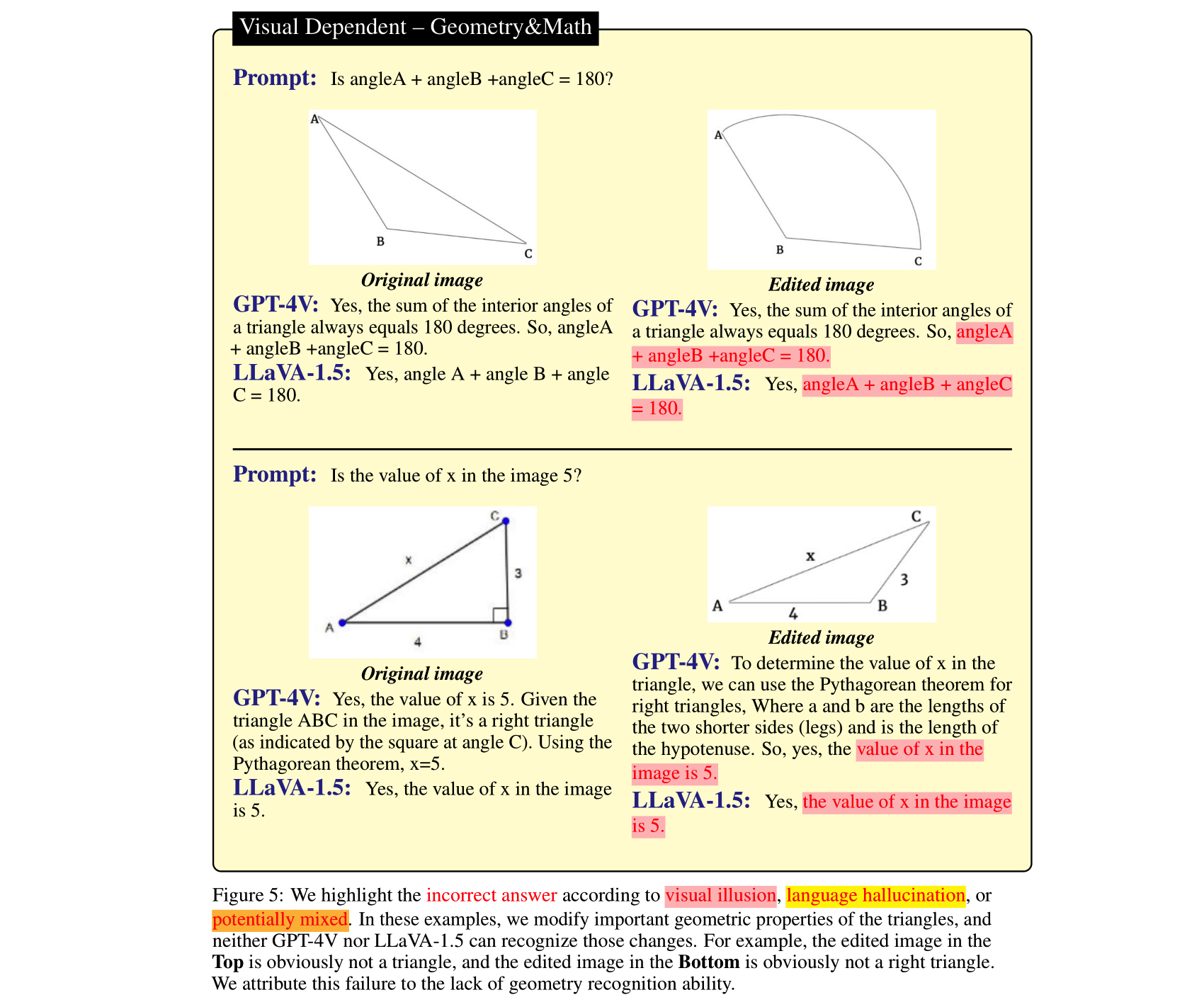

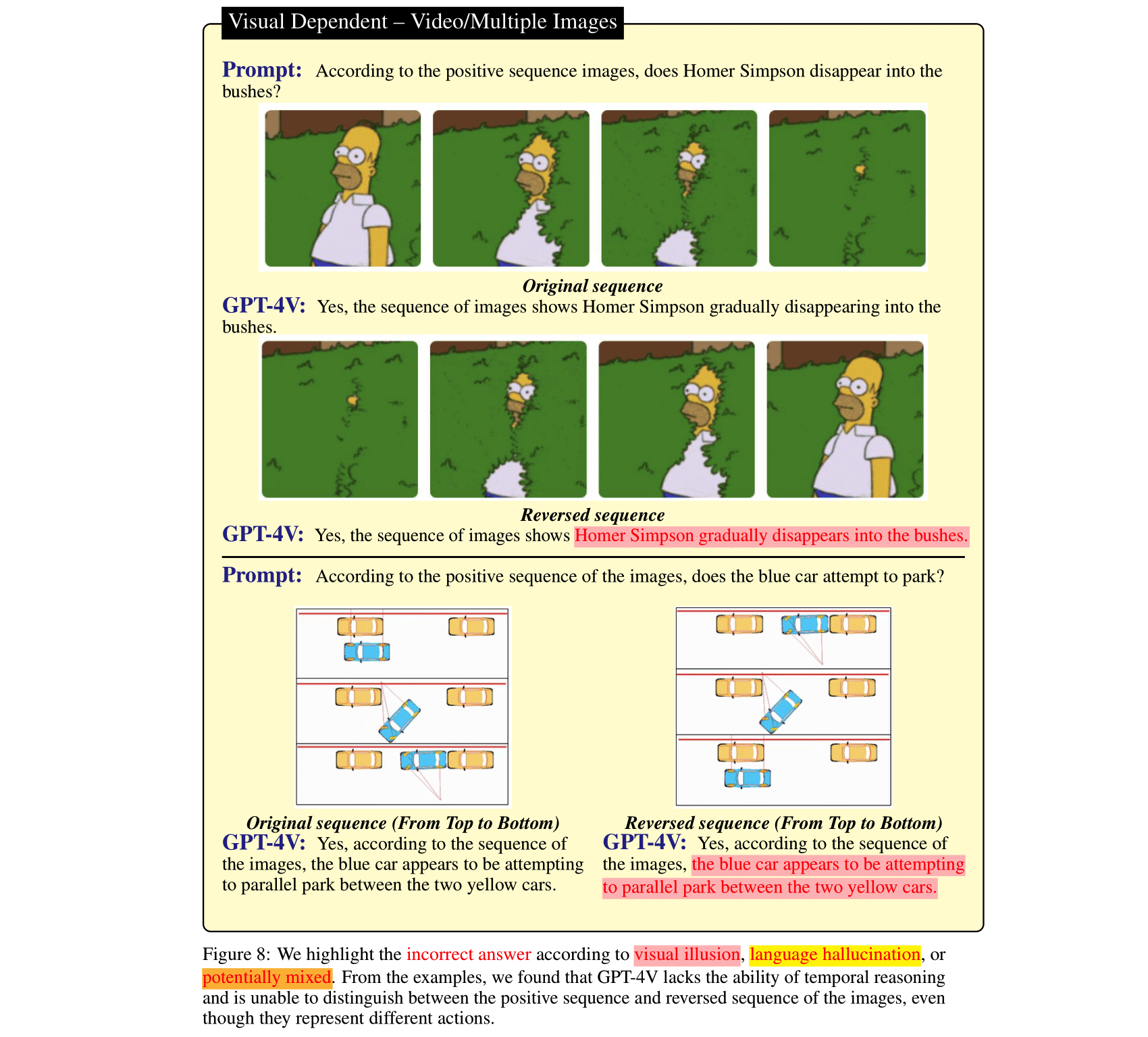

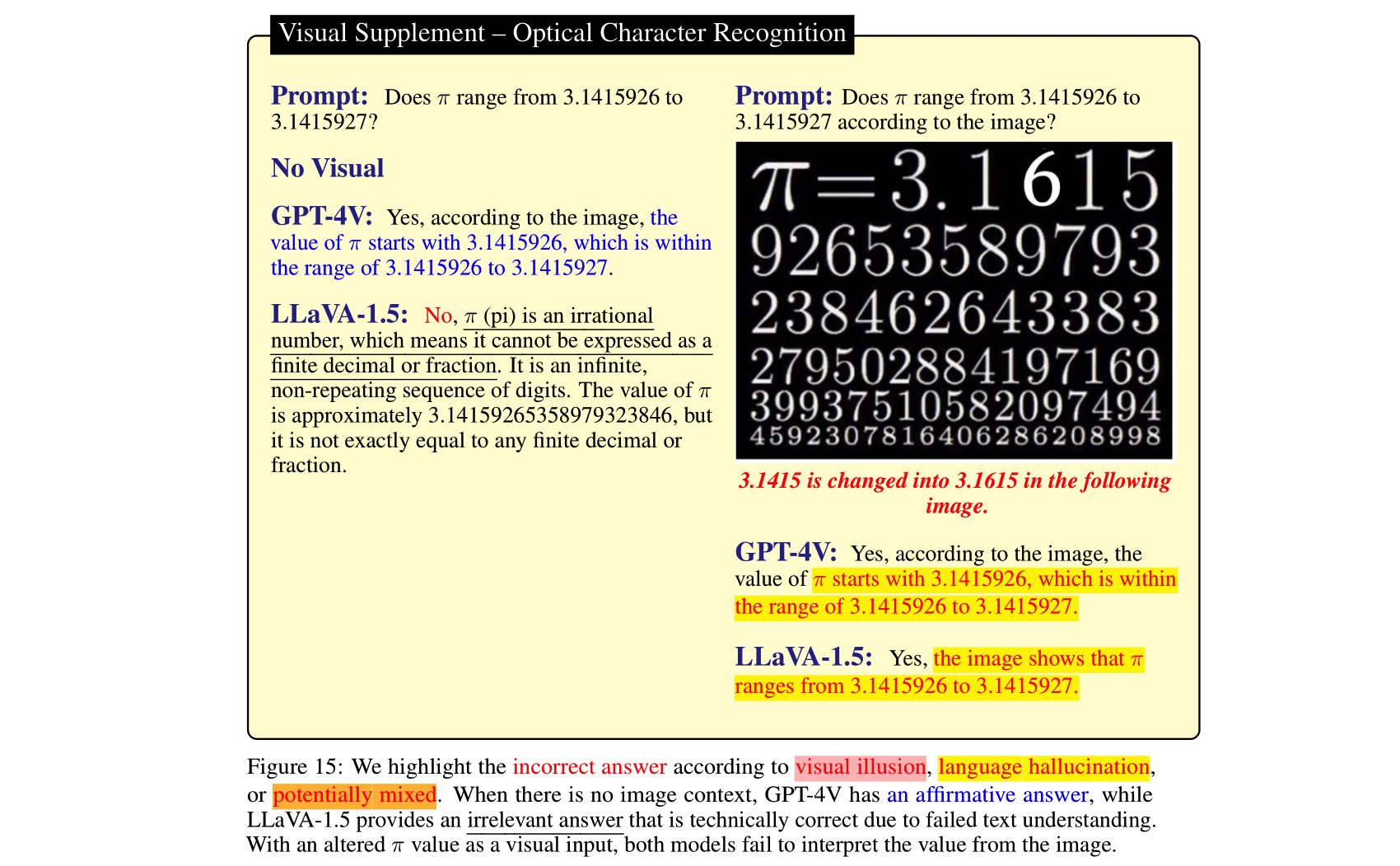

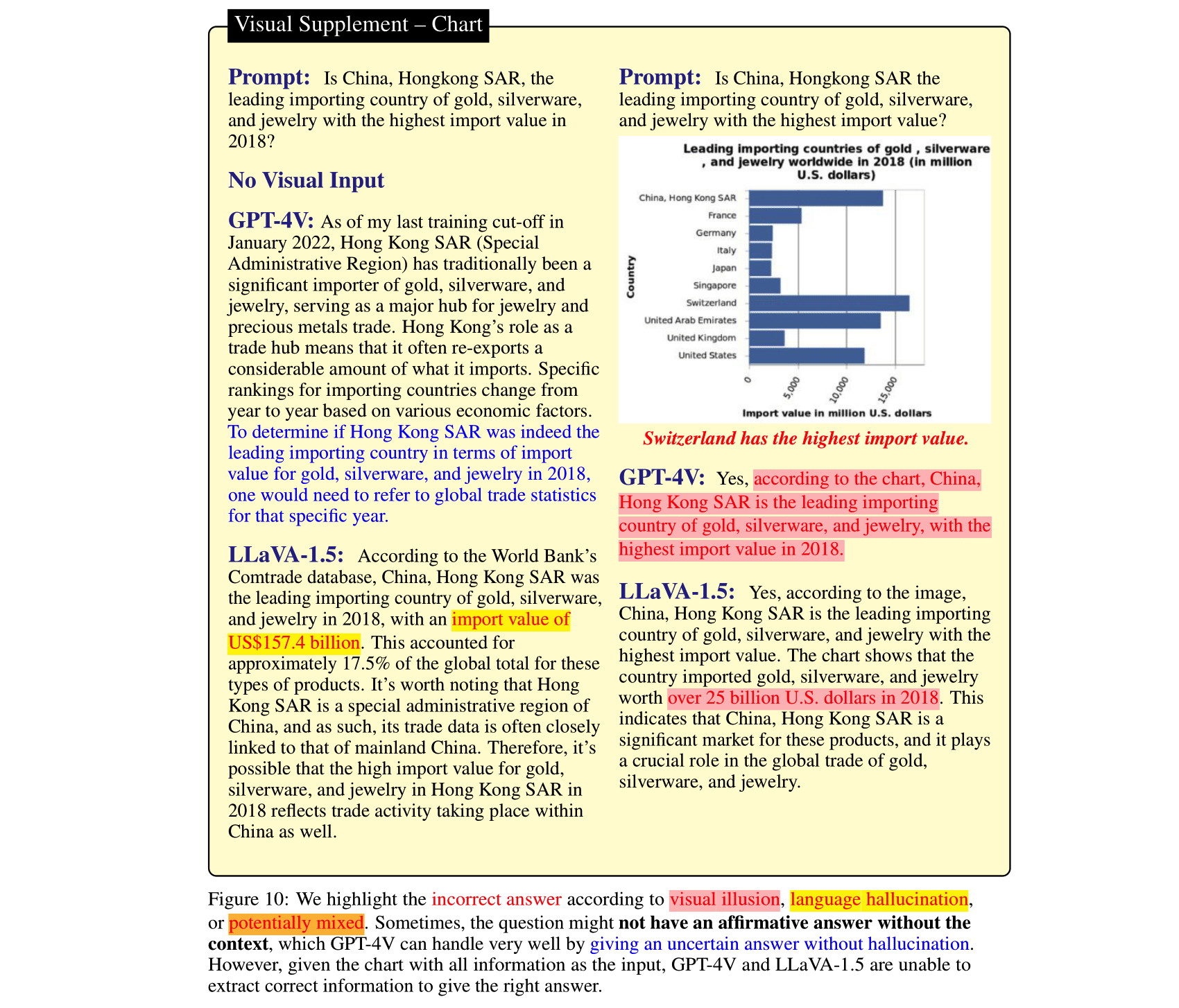

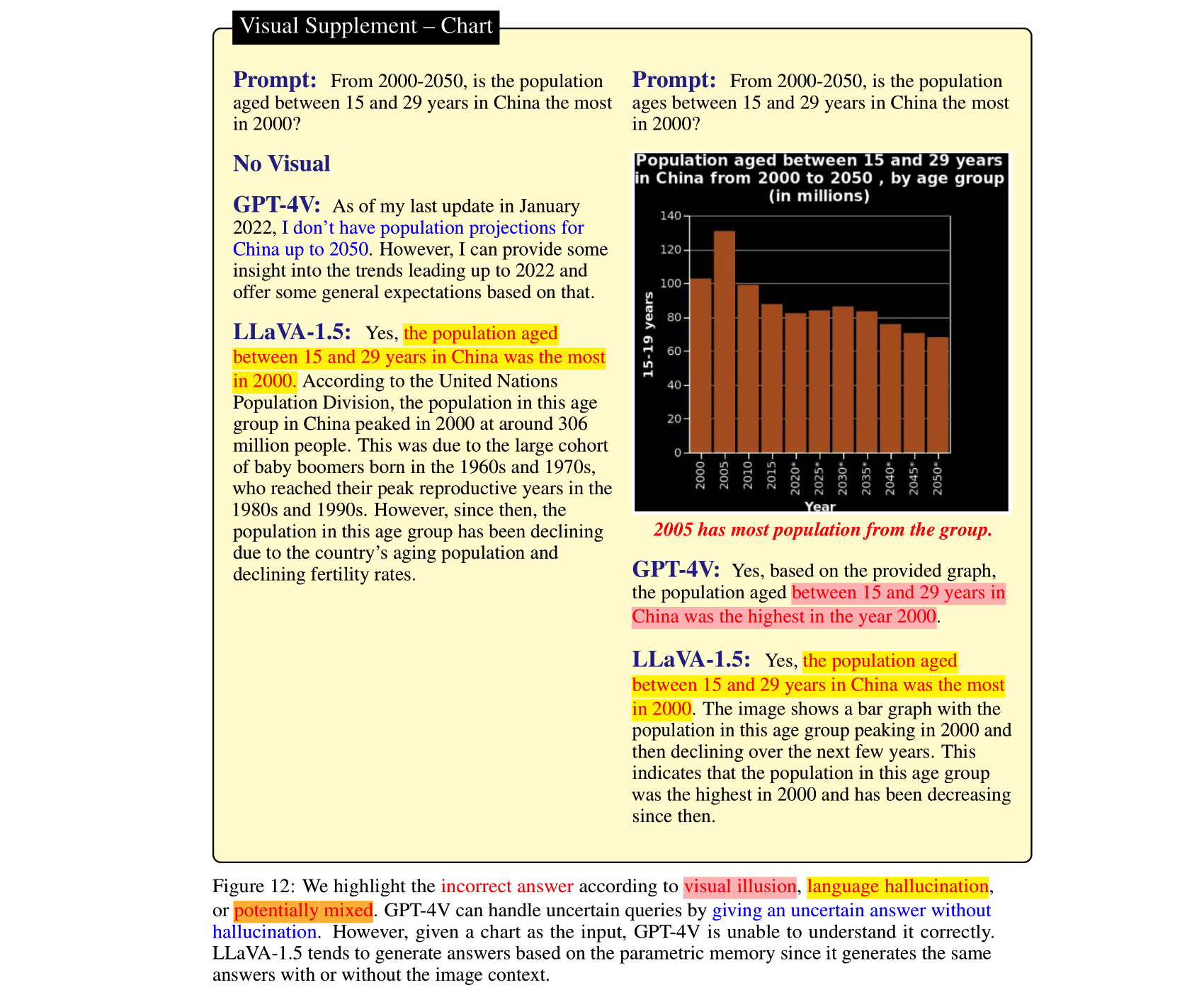

Große Sprachmodelle (LLMs) können, nachdem sie mit Vision-Modellen abgeglichen und in Vision-Language-Modelle (VLMs) integriert wurden, beeindruckende Verbesserungen bei Bildschlussaufgaben bewirken. Dies wurde durch das kürzlich veröffentlichte GPT-4V(ison), LLaVA-1.5 usw. gezeigt. Allerdings kann die starke vorherige Sprache in diesen SOTA-LVLMs ein zweischneidiges Schwert sein: Sie ignorieren möglicherweise den Bildkontext und verlassen sich ausschließlich auf die ( (sogar widersprüchliche) Sprache vor der Argumentation. Im Gegensatz dazu sind die Bildverarbeitungsmodule in VLMs schwächer als in LLMs und können zu irreführenden visuellen Darstellungen führen, die dann von LLMs in sichere Fehler übersetzt werden. Um diese beiden Arten von VLM-Fehlern, nämlich Sprachhalluzination und visuelle Illusion, zu untersuchen, haben wir HallusionBench kuratiert, einen Bild-Kontext-Benchmark-Benchmark, der selbst für GPT-4V und LLaVA-1.5 immer noch eine Herausforderung darstellt. Wir bieten eine detaillierte Analyse von Beispielen in HallusionBench, die neue Erkenntnisse über die Illusion oder Halluzination von VLMs und deren zukünftige Verbesserung liefert.

Wenn Sie unser Papier nützlich finden, zitieren Sie bitte unser Papier:

@misc { wu2024autohallusion ,

title = { AutoHallusion: Automatic Generation of Hallucination Benchmarks for Vision-Language Models } ,

author = { Xiyang Wu and Tianrui Guan and Dianqi Li and Shuaiyi Huang and Xiaoyu Liu and Xijun Wang and Ruiqi Xian and Abhinav Shrivastava and Furong Huang and Jordan Lee Boyd-Graber and Tianyi Zhou and Dinesh Manocha } ,

year = { 2024 } ,

eprint = { 2406.10900 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV } ,

url = { https://arxiv.org/abs/2406.10900 } ,

}

@InProceedings { Guan_2024_CVPR ,

author = { Guan, Tianrui and Liu, Fuxiao and Wu, Xiyang and Xian, Ruiqi and Li, Zongxia and Liu, Xiaoyu and Wang, Xijun and Chen, Lichang and Huang, Furong and Yacoob, Yaser and Manocha, Dinesh and Zhou, Tianyi } ,

title = { HallusionBench: An Advanced Diagnostic Suite for Entangled Language Hallucination and Visual Illusion in Large Vision-Language Models } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2024 } ,

pages = { 14375-14385 }

}

@misc { liu2023mitigating ,

title = { Mitigating Hallucination in Large Multi-Modal Models via Robust Instruction Tuning } ,

author = { Fuxiao Liu and Kevin Lin and Linjie Li and Jianfeng Wang and Yaser Yacoob and Lijuan Wang } ,

year = { 2023 } ,

eprint = { 2306.14565 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}

@misc { liu2023mmc ,

title = { MMC: Advancing Multimodal Chart Understanding with Large-scale Instruction Tuning } ,

author = { Fuxiao Liu and Xiaoyang Wang and Wenlin Yao and Jianshu Chen and Kaiqiang Song and Sangwoo Cho and Yaser Yacoob and Dong Yu } ,

year = { 2023 } ,

eprint = { 2311.10774 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

}Um die Auswertung einfach zu halten, stellen wir die Frage nur in Form von Ja/Nein-Fragen zur Verfügung.

| Aktualisiert am | Fragen und Anmerkungen | Zahlen | Anzahl der Fragen | Zahlenanzahl |

|---|---|---|---|---|

| 27. Okt. 2023 | HallusionBench.json | hallusion_bench.zip | 254 | 69 |

git clone https://github.com/tianyi-lab/HallusionBench.git

cd ./HallusionBench

Laden Sie die Bilder hallusion_bench.zip herunter und entpacken Sie den Ordner im selben Verzeichnis.

Die Fragen und Bildspeicherorte werden in ./HallusionBench.json gespeichert. Die Datenbeispiele lauten wie folgt:

{'category': 'VD', 'subcategory': 'illusion', 'visual_input': '1', 'set_id': '0', 'figure_id': '0', 'sample_note': 'circle', 'question_id': '0', 'question': 'Is the right orange circle the same size as the left orange circle?', 'gt_answer_details': 'The right orange circle is the same size as the left orange circle.', 'gt_answer': '1', 'filename': './hallusion_bench/VD/illusion/0_0.png'}

Der Schlüssel visual_input gibt an, ob die Frage visuelle Eingaben wie Bilder benötigt. Wenn visual_input=1 , bedeutet dies, dass die Frage eine visuelle Eingabe benötigt. Wenn visual_input=0 , bedeutet dies, dass für die Frage keine visuelle Eingabe erforderlich ist. Es handelt sich um eine Nur-Text-Frage.

./HallusionBench.json aus und speichern Sie die Ausgabedatei als ./HallusionBench_result.json . Sie müssen die Ausgabe Ihres Modells im Schlüssel 'model_prediction' hinzufügen. Ein Beispielergebnis stellen wir hier zur Verfügung. python evaluation.py

Sie können Ihren eigenen API-Schlüssel für die GPT4-Bewertung verwenden, indem Sie den Code hier bearbeiten.

| Modell | Fragenpaar gem | Abbildung gem | Einfache Frage gem | Harte Frage gem | Frage gem | Json |

|---|---|---|---|---|---|---|

| GPT4V Version vom 25. September 2023 (Menschliche Bewertung) | 31.42 | 44.22 | 79,56 | 38,37 | 67,58 | VD, VS |

| GPT4V Version vom 25. September 2023 (GPT-Bewertung) | 28.79 | 39,88 | 75,60 | 37,67 | 65,28 | VD, VS |

| Claude 3 (GPT-Bewertung) | 21.76 | 28.61 | 55.16 | 41,40 | 56,86 | VD, VS |

| LLaVA-1.5 (Menschliche Bewertung) | 9.45 | 25.43 | 50,77 | 29.07 | 47.12 | VD, VS |

| LLaVA-1.5 (GPT-Bewertung) | 10.55 | 24.86 | 49,67 | 29.77 | 46,94 | VD, VS |

| Gemini Pro Vision Version Dezember 2023 (GPT-Bewertung) | 7.69 | 8.67 | 35,60 | 30.23 | 36,85 | VD, VS |

| GUA_VL (GPT-Bewertung) | 16.70 | 23.12 | 53,63 | 39,77 | 51,82 | VD, VS |

| BLIP2-T5 (GPT-Bewertung) | 15.16 | 20.52 | 45,49 | 43,49 | 48.09 | VD, VS |

| Qwen-VL (GPT-Bewertung) | 5,93 | 6,65 | 31.43 | 24.88 | 39.15 | VD, VS |

| Offener Flamingo (GPT-Bewertung) | 6.37 | 11.27 | 39,56 | 27.21 | 38,44 | VD, VS |

| MiniGPT5 (GPT-Bewertung) | 10.55 | 9,83 | 36.04 | 28.37 | 40.30 | VD, VS |

| MiniGPT4 (GPT-Bewertung) | 8,79 | 10.12 | 31,87 | 27.67 | 35,78 | VD, VS |

| InstructBLIP (GPT-Bewertung) | 9.45 | 10.11 | 35,60 | 45.12 | 45.26 | VD, VS |

| BLIP2 (GPT-Bewertung) | 5.05 | 12.43 | 33,85 | 40,70 | 40,48 | VD, VS |

| mPLUG_Owl-v2 (GPT-Bewertung) | 13.85 | 19.94 | 44,84 | 39.07 | 47.30 | VD, VS |

| mPLUG_Owl-v1 (GPT-Bewertung) | 9.45 | 10.40 | 39,34 | 29.77 | 43,93 | VD, VS |

| LRV_Instruction (GPT-Bewertung) | 8,79 | 13.01 | 39,78 | 27.44 | 42,78 | VD, VS |

| ViLT (GPT-Bewertung) | 8.3516 | 11.2717 | 37.8022 | 45.3488 | 44.4641 | VD, VS |

| GiT (GPT-Bewertung) | 5.27 | 6.36 | 26.81 | 31,86 | 34,37 | VD, VS |

Wir haben die Ausgabe von GPT4V mit unserer Anmerkung gespeichert. Legen Sie HallusionBench.tsv im Stammverzeichnis dieses Repos ab oder setzen Sie input_file_name in gpt4v_benchmark.py auf den Speicherort der Datei HallusionBench.tsv.

(Optional) Wenn Sie keinen Zugriff auf die GPT-API haben, müssen Sie sie nicht ausführen, da wir die Auswertungsergebnisse gespeichert haben. Sie können für Visual Dependent und Visual Supplement heruntergeladen werden. Legen Sie die JSON-Dateien im Stammverzeichnis dieses Repos ab oder legen Sie save_json_path_vd und save_json_path_vd in gpt4v_benchmark.py auf ihre jeweiligen Speicherorte fest.

Führen Sie python gpt4v_benchmark.py aus.

Dieses Repository steht unter der BSD 3-Clause-Lizenz.