„Es ist, als hätte AutoGPT eine brew install “, ermöglicht durch Kurtosis.

HINWEIS : Dies läuft jetzt mit 0.4.0, wodurch die Unterstützung für Milvus, Weaviate und PineCone eingestellt wird. Sie können Kurtosis gegen 0.3.1 ausführen, indem Sie kurtosis run github.com/kurtosis-tech/[email protected] mit den gewünschten Argumenten ausführen

YOUR_API_KEY_HERE durch Ihren OpenAI-API-Schlüssel). kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} 'kurtosis service shell autogpt autogpt --exec " python -m autogpt "

YOUR_API_KEY_HERE durch Ihren OpenAI-API-Schlüssel). kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} 'kurtosis service shell autogpt autogptund dann innerhalb der Eingabeaufforderung:

> python -m autogpt kurtosis enclave rm -f autogpt

Um einen der hier aufgeführten AutoGPT-Konfigurationswerte zu übergeben, übergeben Sie das Argument als Eigenschaft des JSON-Objekts, das Sie an Kurtosis übergeben, genau wie Sie es in OPENAI_API_KEY übergeben haben.

So übergeben Sie beispielsweise das Flag RESTRICT_TO_WORKSPACE :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "RESTRICT_TO_WORKSPACE": "False"} ' HINWEIS: Dieses Paket startet AutoGPT standardmäßig über das local Backend. Andere Backends sind verfügbar, indem Sie den Parameter MEMORY_BACKEND im JSON-Objekt festlegen, das Sie übergeben, wenn Sie den obigen Befehl kurtosis run ausführen.

So legen Sie beispielsweise das redis Speicher-Backend fest:

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "MEMORY_BACKEND": "redis"} 'HINWEIS : Redis funktioniert derzeit nicht mit 0.4.0

Um mit einem anderen Bild als dem in main.star fest codierten Bild zu laufen, verwenden Sie es

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "AUTOGPT_IMAGE": "significantgravitas/auto-gpt:v0.4.0"} ' Kurtosis unterstützt das Konfigurationsflag ALLOWLISTED_PLUGINS , mit dem AutoGPT ausgeliefert wird. Um beispielsweise das AutoGPTTwitter -Plugin auszuführen, gehen Sie wie folgt vor:

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "ALLOWLISTED_PLUGINS": "AutoGPTTwitter"} 'Um mehrere Plugins gleichzeitig laufen zu lassen; Trennen Sie sie durch Komma ohne Leerzeichen wie folgt:

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt '{"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "ALLOWLISTED_PLUGINS": "AutoGPTTwitter,AutoGPTEmailPlugin"}'

Unter der Haube lädt Kurtosis das Paket für Sie herunter und installiert es.

Ab sofort werden folgende Plugins unterstützt:

Um Unterstützung für weitere Plugins hinzuzufügen, erstellen Sie einfach ein Problem oder erstellen Sie eine PR, indem Sie einen Eintrag zu plugins.star hinzufügen.

Wir verstehen, dass OpenAI für manche Menschen teuer sein kann; Immer mehr Leute versuchen möglicherweise, dies mit ihren eigenen Modellen zu verwenden. Das AutoGPT-Paket unterstützt die Ausführung von AutoGPT gegen ein GPT4All -Modell, das über LocalAI ausgeführt wird. So verwenden Sie ein lokales Modell:

kurtosis run github.com/kurtosis-tech/autogpt-package ' {"GPT_4ALL": true} ' Dabei wird der Modellstandard https://gpt4all.io/models/ggml-gpt4all-j.bin verwendet

Um ein anderes Modell zu verwenden, versuchen Sie es mit dem Parameter MODEL_URL wie:

kurtosis run github.com/kurtosis-tech/autogpt-package ' {"GPT_4ALL": true, "MODEL_URL": "https://gpt4all.io/models/ggml-gpt4all-l13b-snoozy.bin"} ' Um dieses Paket zu entwickeln, klonen Sie dieses Repo und führen Sie Folgendes aus:

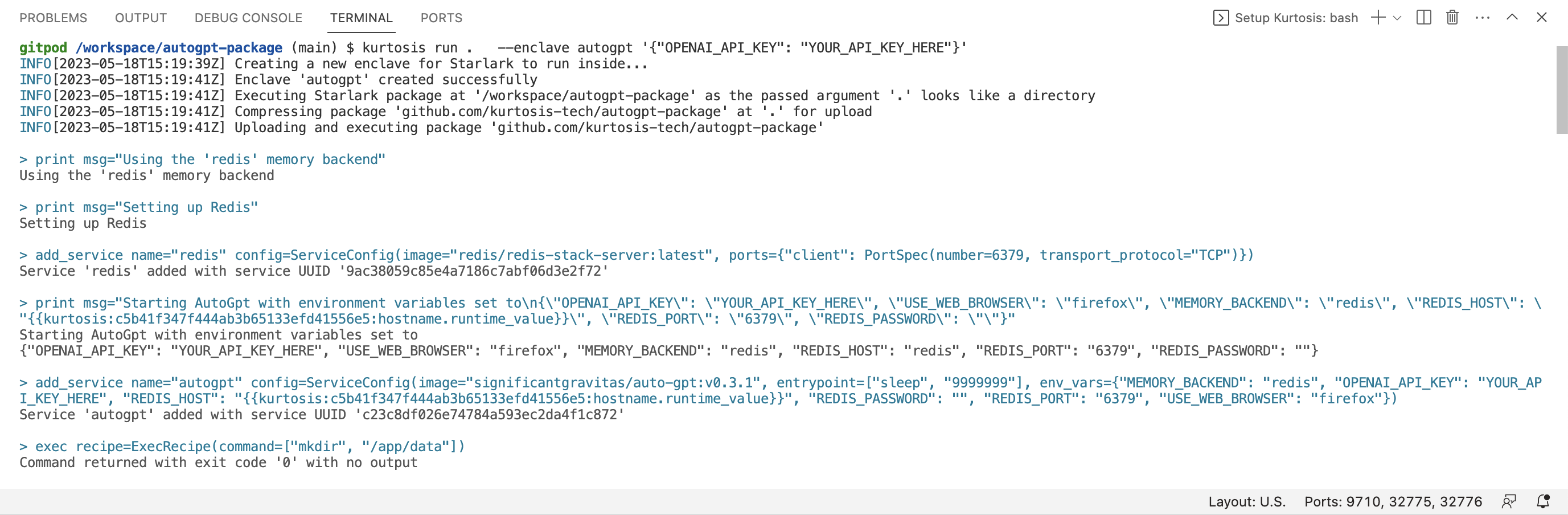

kurtosis run . --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} ' Beachten Sie die . – Dadurch wird Kurtosis angewiesen, die Version des Pakets auf Ihrem lokalen Computer zu verwenden (anstelle der Version auf Github).

Kurtosis verfügt außerdem über eine Erweiterung auf dem VSCode-Marktplatz, die Syntaxhervorhebung und automatische Vervollständigung für den Starlark bietet, aus dem dieses Paket besteht.

Lass es uns in unserem Discord oder auf Twitter @KurtosisTech wissen!

Wenn Sie Fehler oder Funktionswünsche haben, können Sie gerne ein Issue auf GitHub erstellen.