Foundationa LLM : Die Plattform für die Bereitstellung, Skalierung, Sicherung und Steuerung generativer KI in Unternehmen

Foundationa LLM bietet die Plattform für die Bereitstellung, Skalierung, Sicherung und Steuerung generativer KI im Unternehmen. Mit Foundationa LLM können Sie:

- Erstellen Sie KI-Agenten, die auf Ihren Unternehmensdaten basieren, seien es Text-, halbstrukturierte oder strukturierte Daten.

- Stellen Sie Ihren Benutzern KI-Agenten über eine gebrandete Chat-Schnittstelle zur Verfügung oder integrieren Sie die REST-API des KI-Agenten in Ihre Anwendung für ein Copilot-Erlebnis oder integrieren Sie die Agenten-API in einen automatisierten Maschine-zu-Maschine-Prozess.

- Experimentieren Sie mit Agenten, die eine Vielzahl großer Sprachmodelle verwenden können, darunter OpenAI GPT-4, Mistral und Llama 2 oder alle Modelle aus dem Hugging Face-Modellkatalog, die einen REST-Vervollständigungsendpunkt bereitstellen.

- Verwalten, konfigurieren und sichern Sie Ihre KI-Agenten UND ihre zugrunde liegenden Assets, einschließlich Eingabeaufforderungen, Datenquellen, Vektorisierungsdatenpipelines, Vektordatenbanken und große Sprachmodelle, zentral über das Verwaltungsportal.

- Ermöglichen Sie jedem in Ihrem Unternehmen, seine eigenen KI-Agenten zu erstellen. Ihre Nicht-Entwicklerbenutzer können ihre eigenen Agenten im Self-Service-Modus über das Verwaltungsportal erstellen und bereitstellen, aber wir stehen Ihren fortgeschrittenen KI-Entwicklern nicht im Weg, die ihre eigenen Orchestrierungen bereitstellen können, die auf LangChain, Semantic Kernel usw. basieren. Prompt Flow oder eine beliebige Orchestrierung, die einen Abschlussendpunkt verfügbar macht.

- Stellen Sie skalierbare Vektorisierungsdatenpipelines bereit und verwalten Sie sie, die Millionen von Dokumenten aufnehmen können, um Ihrem Modell Wissen bereitzustellen.

- Geben Sie Ihren Benutzern beliebig viele aufgabenorientierte KI-Agenten an die Hand.

- Kontrollieren Sie den Zugriff auf die KI-Agenten und die Ressourcen, auf die sie zugreifen, mithilfe rollenbasierter Zugriffskontrollen (RBAC).

- Nutzen Sie die sich schnell entwickelnden Funktionen von Azure AI und Azure OpenAI aus einem integrierten Stack.

Notiz

Foundationa LLM ist kein großes Sprachmodell. Es ermöglicht Ihnen, die großen Sprachmodelle Ihrer Wahl zu verwenden (z. B. OpenAI GPT-4, Mistral, LLama 2 usw.).

Foundationa LLM stellt eine sichere, umfassende und hochgradig konfigurierbare Copilot-Plattform in Ihrer Azure-Cloud-Umgebung bereit:

- Vereinfacht die Integration mit Unternehmensdatenquellen, die von Agenten für kontextbezogenes Lernen verwendet werden (z. B. Ermöglichung von RAG-, CoT-, ReAct- und inneren Monologmustern).

- Bietet umfassenden Schutz mit feinkörnigen Sicherheitskontrollen für die vom Agenten verwendeten Daten und Pre-/Post-Completion-Filtern, die vor Angriffen schützen.

- Gehärtete Lösung, die von Anfang an von einem roten LLM-Team angegriffen wurde.

- Skalierbare Lösungslastverteilung über mehrere LLM-Endpunkte.

- Erweiterbar auf neue Datenquellen, neue LLM-Orchestratoren und LLMs.

Warum wird Foundationa LLM benötigt?

Kurz gesagt: Wir haben viele Leute gesehen, die das Rad neu erfunden haben, nur um einen maßgeschneiderten Copiloten oder KI-Agenten zu bekommen, der geerdet ist und seine Antworten auf ihre eigenen Daten und nicht auf das trainierte parametrische Wissen des Modells gründet. Viele der Lösungen, die wir gesehen haben, eigneten sich hervorragend für Demos, waren aber im Grunde genommen Spielzeuge, die Aufrufe an OpenAI-Endpunkte abwickeln – sie waren nicht für die Produktion im Unternehmensmaßstab gedacht oder bereit. Wir haben Foundationa LLM entwickelt, um eine kontinuierliche Reise zu bieten, mit der man schnell beginnen konnte, sodass die Leute schnell mit LLMs experimentieren konnten, aber danach nicht mit einer Lösung abstürzten, die unsicher, nicht lizenziert, unflexibel und nicht umfassend genug ausgestattet war Vom Prototyp zur Produktionslösung wachsen, ohne ganz von vorne beginnen zu müssen.

Die Kernprobleme bei der Bereitstellung von Unternehmens-Copiloten oder KI-Agenten sind:

- Copiloten oder KI-Agenten der Enterprise-Klasse sind komplex und bestehen aus vielen beweglichen Teilen (ganz zu schweigen von der Infrastruktur).

- In der Branche besteht ein Kompetenzdefizit, wenn es darum geht, die Rollen zu besetzen, die für die Bereitstellung dieser komplexen Copilot-Lösungen erforderlich sind.

- Die größten KI-Risiken (Ungenauigkeit, Cybersicherheit, Compliance, Erklärbarkeit, Datenschutz) werden durch einzelne Tools nicht gemindert.

- Die Bereitstellung einer Copilot- oder KI-Agentenlösung ist zeitaufwändig, teuer und frustrierend, wenn man bei Null anfängt.

Das Missverständnis vs. Realität

Missverständnis

Es besteht die falsche Vorstellung, dass es bei der Entwicklung von LLM-Apps und KI-Agenten nur auf schnelles Engineering ankommt. Es ist so einfach wie:

Das mag für Demos und Spielzeugszenarien zutreffen, aber für KI-Agenten im Unternehmen gibt es noch viel mehr Anforderungen, wie zum Beispiel: Wie können Sie:

- Tausende bis Millionen von Dokumenten als Wissen für das Modell skalieren und stapelweise laden? andere LLMs (Llama 2, Mistral) neben ChatGPT-Modellen nutzen?

- Sensible Wissensquellen für autorisierte Benutzer geheim halten?

- verhindern, dass sensible Daten (PII, Geschäftsgeheimnisse) an das LLM gesendet werden?

- Schaffen Sie es, mehrere KI-Agenten zu haben?

- die Token-Nutzung regeln und Rückbuchungen für Anwendungen verwalten?

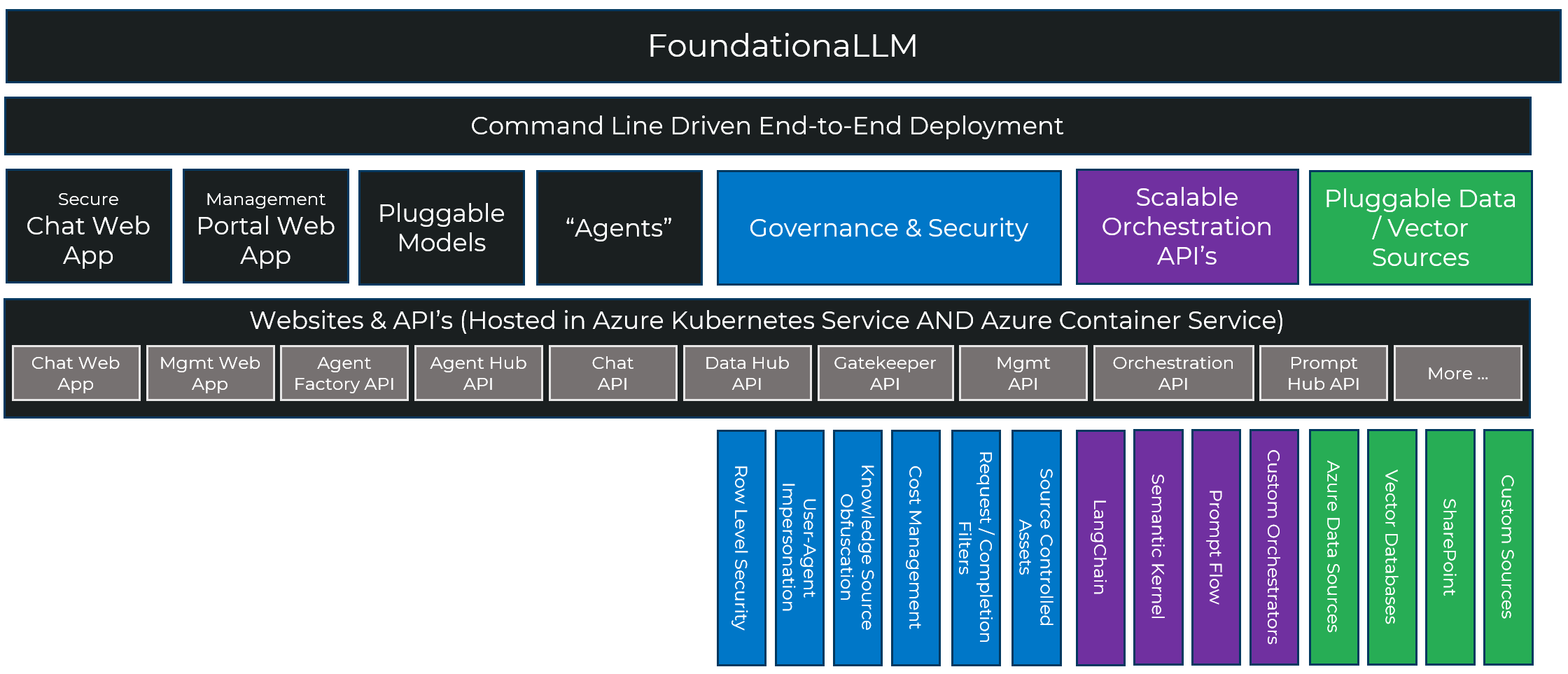

Wirklichkeit

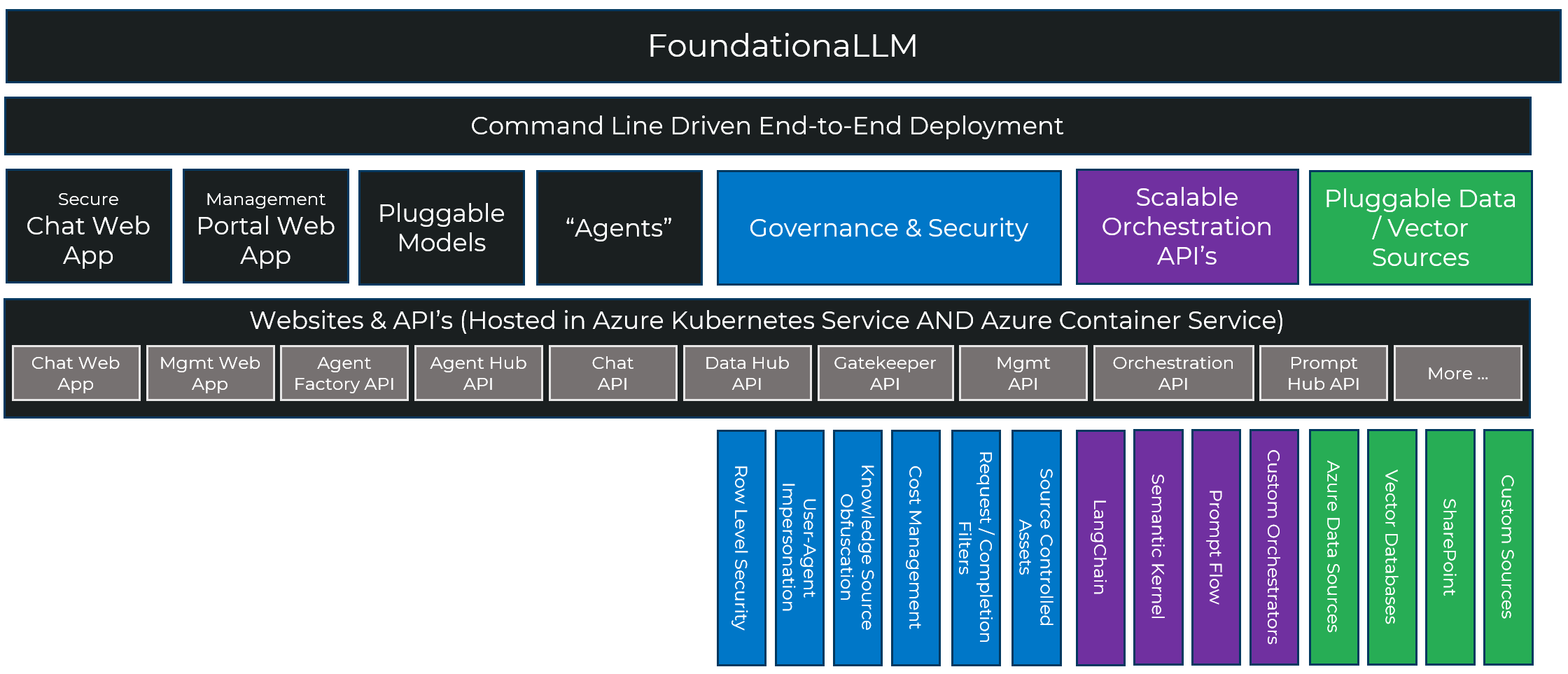

Es gibt viele Komponenten, die in den Aufbau eines sicheren, gut gesteuerten, skalierbaren und erweiterbaren KI-Agenten einfließen, und Foundationa LLM bietet einen umfassenden Stack, um diesen Prozess schneller, wiederholbarer und zuverlässiger zu machen:

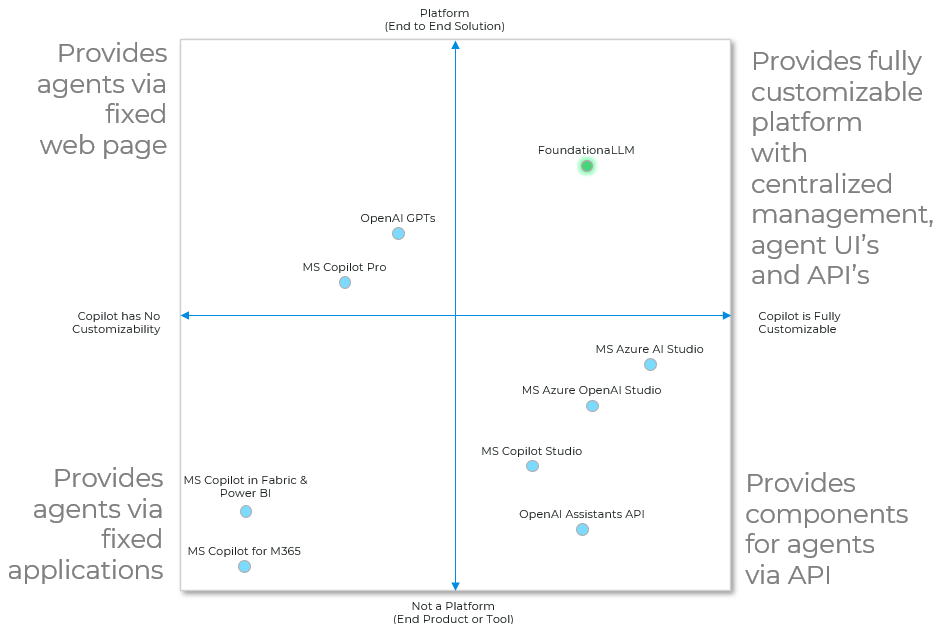

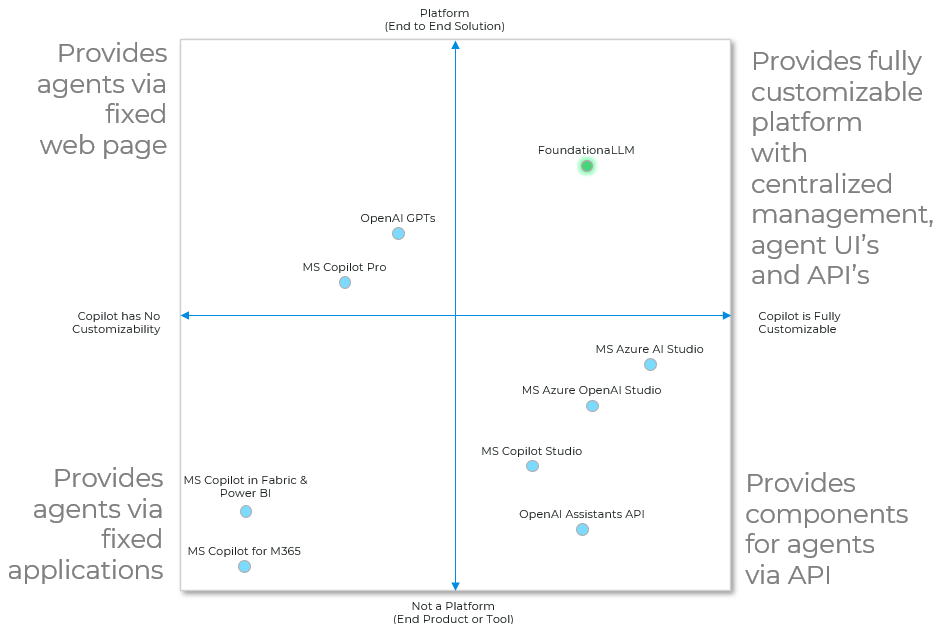

Wo steht Foundationa LLM im Vergleich zu anderen Lösungen?

Es gibt viele großartige Tools im Ökosystem, die bei Teilen des Aufbaus eines Copiloten oder eines KI-Agenten helfen. Nur Foundationa LLM bringt sie zusammen, um die End-to-End-Plattform für die Erstellung vollständig anpassbarer KI-Agenten mit zentraler Verwaltung, Agenten-Benutzeroberflächen und APIs bereitzustellen.

Im einfachsten Fall nutzt ein Copilot oder KI-Agent vom Unternehmen bereitgestelltes Wissen und generative KI-Modelle, um Texte zu verfassen, Code zu schreiben oder Bilder zu rendern, oft indem er über von Menschen eingegebene Eingabeaufforderungen nachdenkt. Bei diesen Modalitäten wird die KI verwendet, um einen Menschen direkt bei einer bestimmten Aufgabe zu unterstützen.

Diese grundlegende Fähigkeit tritt in zwei Archetypen auf, die beide von Foundationa LLM nativ unterstützt werden:

- Wissensmanagement: Helfen Sie Benutzern, die gesuchten Informationen schnell zu finden und auf der richtigen Ebene und im richtigen Format bereitzustellen. Beispiele hierfür sind Zusammenfassungen, Umformulierungen oder Retargeting, um eine Persona anzusprechen (z. B. so zu erklären, als wäre ich fünf), Sentimentanalysen und Empfehlungen.

- Analytics: Helfen Sie Benutzern, schnell zu den datengesteuerten Erkenntnissen zu gelangen, die sie suchen. Beispiele hierfür sind Empfehlungen, Vorhersagen, Anomalieerkennung, statistische Analysen sowie Datenabfragen und -berichte.

Foundationa LLM vereinfacht und rationalisiert den Aufbau von Wissensmanagement-Agenten (z. B. Frage-/Antwort-Agenten) und Analyse- Agenten (z. B. Self-Service-Business-Intelligence) über die in Ihrem Unternehmen vorhandenen Datenquellen.

Dokumentation

Machen Sie sich mit Foundationa LLM vertraut, indem Sie die Dokumentation lesen. Dazu gehören Bereitstellungsanweisungen, Schnellstarts, Architektur und API-Referenzen.

Erste Schritte

Foundationa LLM bietet einen einfachen befehlszeilengesteuerten Ansatz, um Ihre erste Bereitstellung zum Laufen zu bringen. Im Grunde sind es zwei Befehle. Anschließend können Sie die Lösung anpassen, lokal auf Ihrem Computer ausführen und die Bereitstellung mit Ihren Anpassungen aktualisieren.

Befolgen Sie die Anweisungen zur Schnellstartbereitstellung, um Foundationa LLM in Ihrem Azure-Abonnement bereitzustellen.

Melden von Problemen und Support

Wenn Sie auf Probleme mit Foundationa LLM stoßen, öffnen Sie bitte ein Problem auf GitHub. Wir werden so schnell wie möglich auf Ihr Problem reagieren. Bitte verwenden Sie die Bezeichnungen ( bug , documentation , general question , release xxx ), um Ihr Problem zu kategorisieren und so viele Details wie möglich anzugeben, damit wir das Problem besser verstehen und lösen können.

Mitarbeit bei Foundationa LLM

Gerne nehmen wir Beiträge zum FoundationaLLM-Projekt in Form von Feedback, Fehlerberichten und Pull-Requests entgegen. Anweisungen hierzu finden Sie unter Mitwirken bei FoundationaLLM.