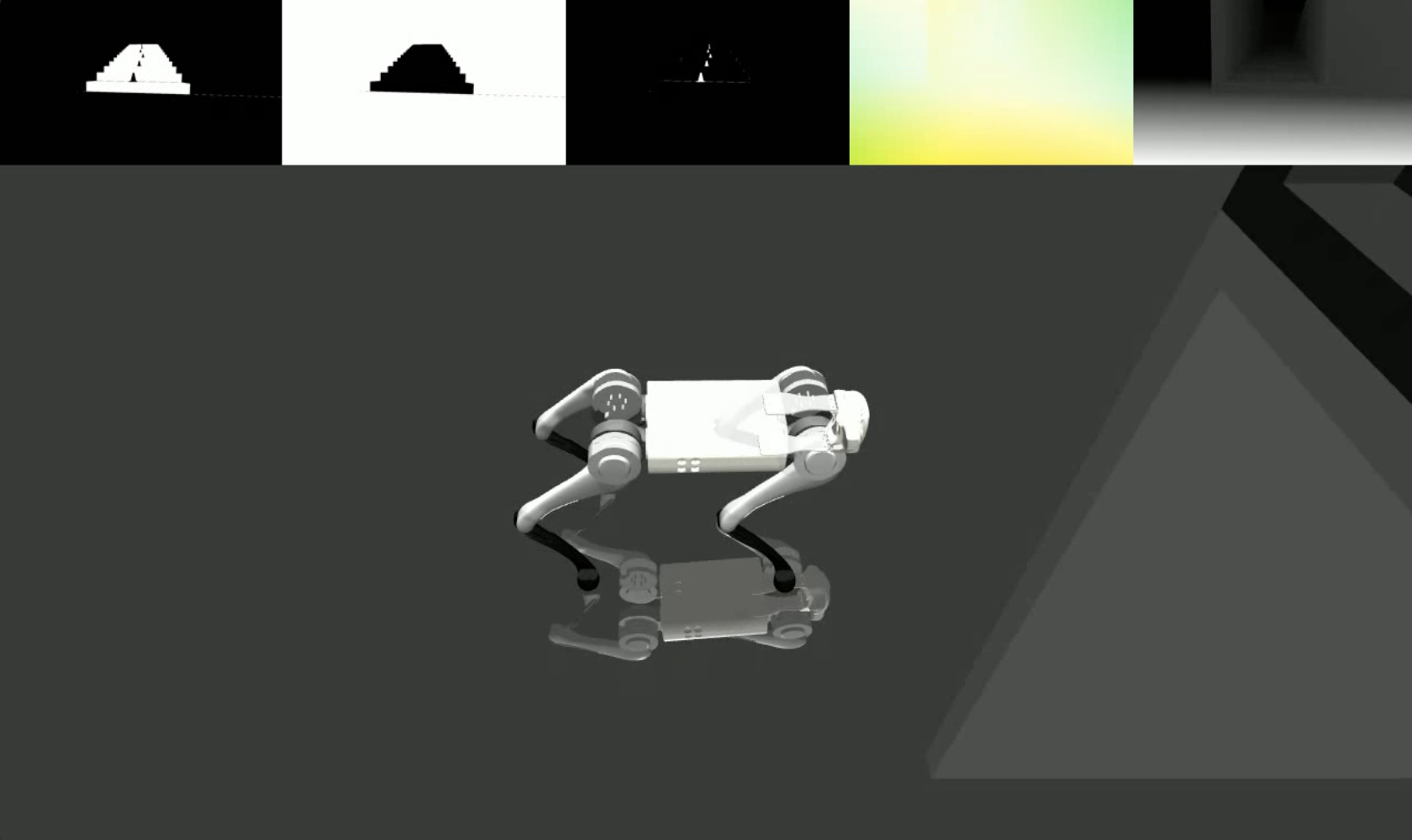

Wir bringen realistische und vielfältige visuelle Daten von generativen Modellen in klassische Physiksimulatoren und ermöglichen es Robotern, hochdynamische Aufgaben wie Parkour zu erlernen, ohne dass dafür Tiefe erforderlich ist.

lucidsim enthält unsere simulierten Umgebungen, die mit MuJoCo erstellt wurden. Wir stellen die Umgebungen und Tools zum Ausführen der LucidSim-Rendering-Pipeline für Vierbeiner-Parkour bereit. Der Schulungscode ist noch nicht enthalten.

Wenn Sie nach dem generativen Erweiterungscode suchen (erforderlich zum Ausführen der vollständigen Rendering-Pipeline), schauen Sie sich bitte das Weaver-Repo an!

Alan Yu *1 , Ge Yang *1,2 , Ran Choi 1 , Yajvan Ravan 1 , John Leonard 1 , Phillip Isola 1

1 MIT CSAIL, 2 Institut für KI und grundlegende Interaktionen (IAIFI)

* Zeigt gleichen Beitrag an

CoRL 2024

|  |

Inhaltsverzeichnis

Wenn Sie die Setup-Anweisungen von weaver befolgt haben, können Sie die Installation auch auf dieser Umgebung durchführen.

conda create -n lucidsim python=3.10

conda activate lucidsim # Choose the CUDA version that your GPU supports. We will use CUDA 12.1

pip install torch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 --extra-index-url https://download.pytorch.org/whl/cu121

# Install lucidsim with more dependencies

git clone https://github.com/lucidsim/lucidsim

cd lucidsim

pip install -e . Für die Installation der letzten paar Abhängigkeiten sind heruntergestufte setuptools und ein wheel erforderlich. Um die Installation durchzuführen, führen Sie bitte ein Downgrade durch und kehren Sie anschließend zurück.

pip install setuptools==65.5.0 wheel==0.38.4 pip==23

pip install gym==0.21.0

pip install gym-dmc==0.2.9

pip install -U setuptools wheel pip Hinweis: Stellen Sie unter Linux sicher, dass die Umgebungsvariable MUJOCO_GL=egl festgelegt ist.

LucidSim generiert fotorealistische Bilder, indem es ein generatives Modell verwendet, um das Rendering des Simulators zu verbessern, und konditionierte Bilder verwendet, um die Kontrolle über die Szenengeometrie zu behalten.

Unter checkpoints/expert.pt haben wir einen Prüfpunkt für Expertenrichtlinien bereitgestellt. Diese Richtlinie wurde von der des Extreme Parkour abgeleitet. Sie können diese Richtlinie verwenden, um eine Umgebung abzutasten und die Konditionierungsbilder zu visualisieren mit:

# env-name: one of ['parkour', 'hurdle', 'gaps', 'stairs_v1', 'stairs_v2']

python play.py --save-path [--env-name] [--num-steps] [--seed] Dabei ist save_path der Ort, an dem das resultierende Video gespeichert werden soll.

Um die vollständige generative Erweiterungspipeline auszuführen, müssen Sie das weaver -Paket von hier aus installieren. Wenn Sie fertig sind, stellen Sie bitte auch sicher, dass die Umgebungsvariablen noch korrekt eingestellt sind:

COMFYUI_CONFIG_PATH=/path/to/extra_model_paths.yaml

PYTHONPATH=/path/to/ComfyUI: $PYTHONPATHAnschließend können Sie die gesamte Pipeline ausführen mit:

python play_three_mask_workflow.py --save-path --prompt-collection [--env-name] [--num-steps] [--seed] Dabei sind save_path und env_name dieselben wie zuvor. prompt_collection sollte ein Pfad zu einer .jsonl Datei mit korrekt formatierten Eingabeaufforderungen sein, wie im Ordner weaver/examples .

Wir danken den Autoren von Extreme Parkour für ihre Open-Source-Codebasis, die wir als Ausgangspunkt für unsere Expertenrichtlinie ( lucidsim.model ) verwendet haben.

Wenn Sie unsere Arbeit nützlich finden, denken Sie bitte darüber nach, Folgendes zu zitieren:

@inproceedings{yu2024learning,

title={Learning Visual Parkour from Generated Images},

author={Alan Yu and Ge Yang and Ran Choi and Yajvan Ravan and John Leonard and Phillip Isola},

booktitle={8th Annual Conference on Robot Learning},

year={2024},

}