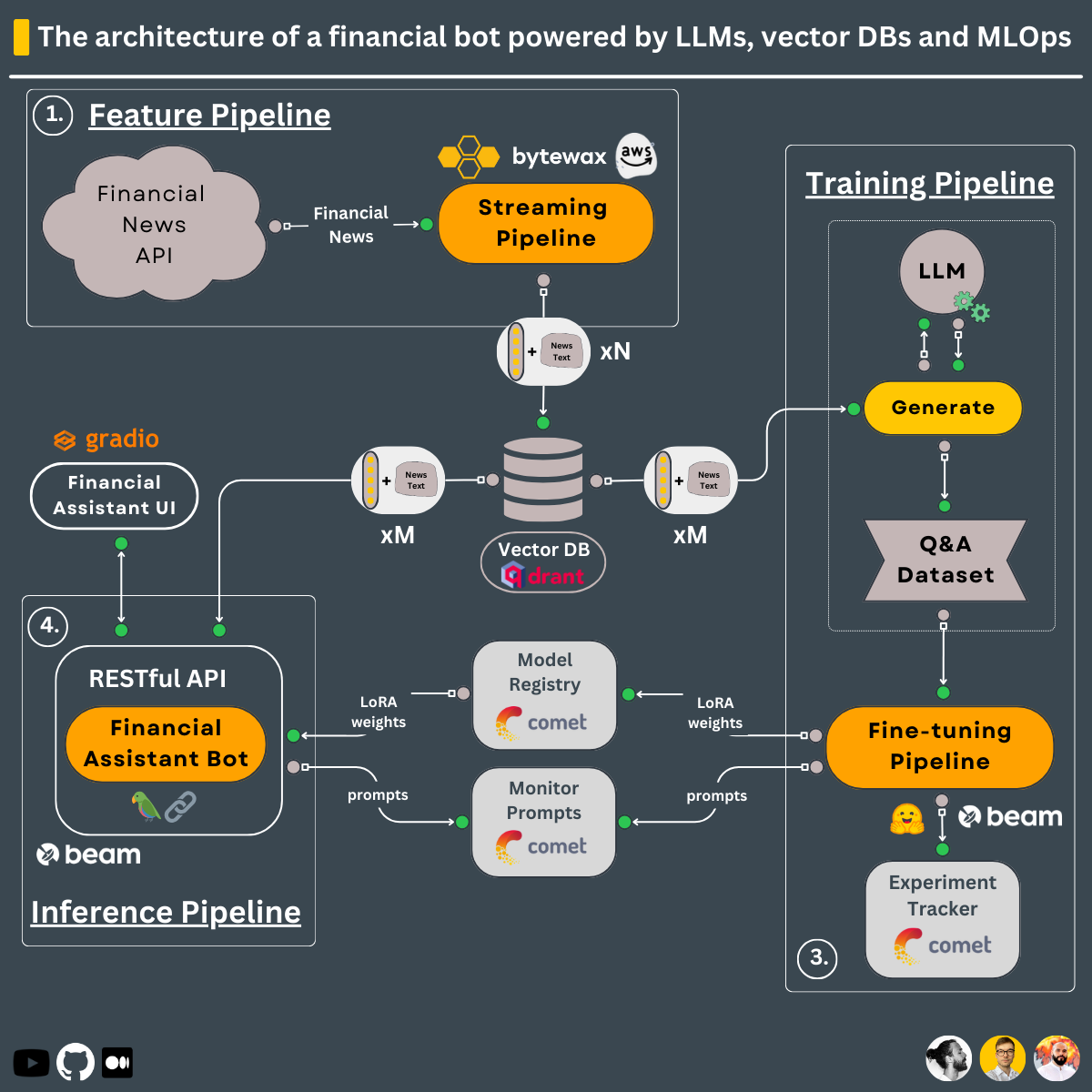

Mithilfe des 3-Pipeline-Designs lernen Sie in diesem Kurs, Folgendes zu erstellen ↓

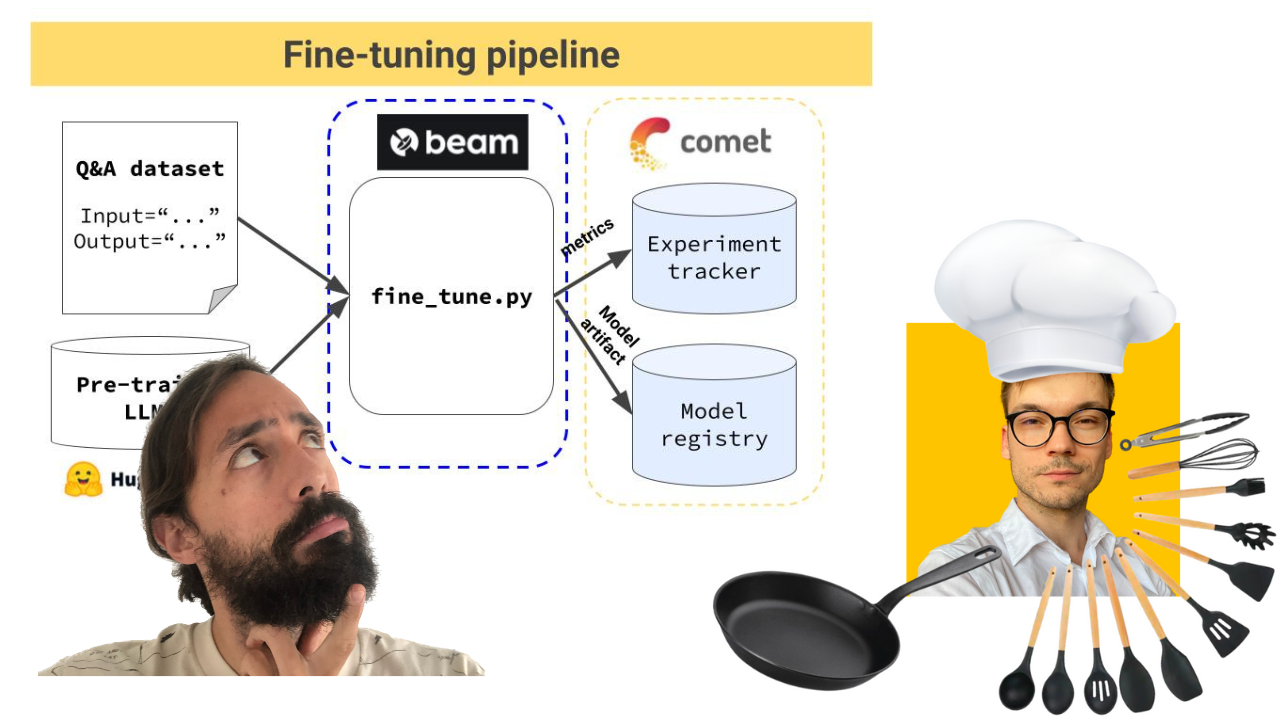

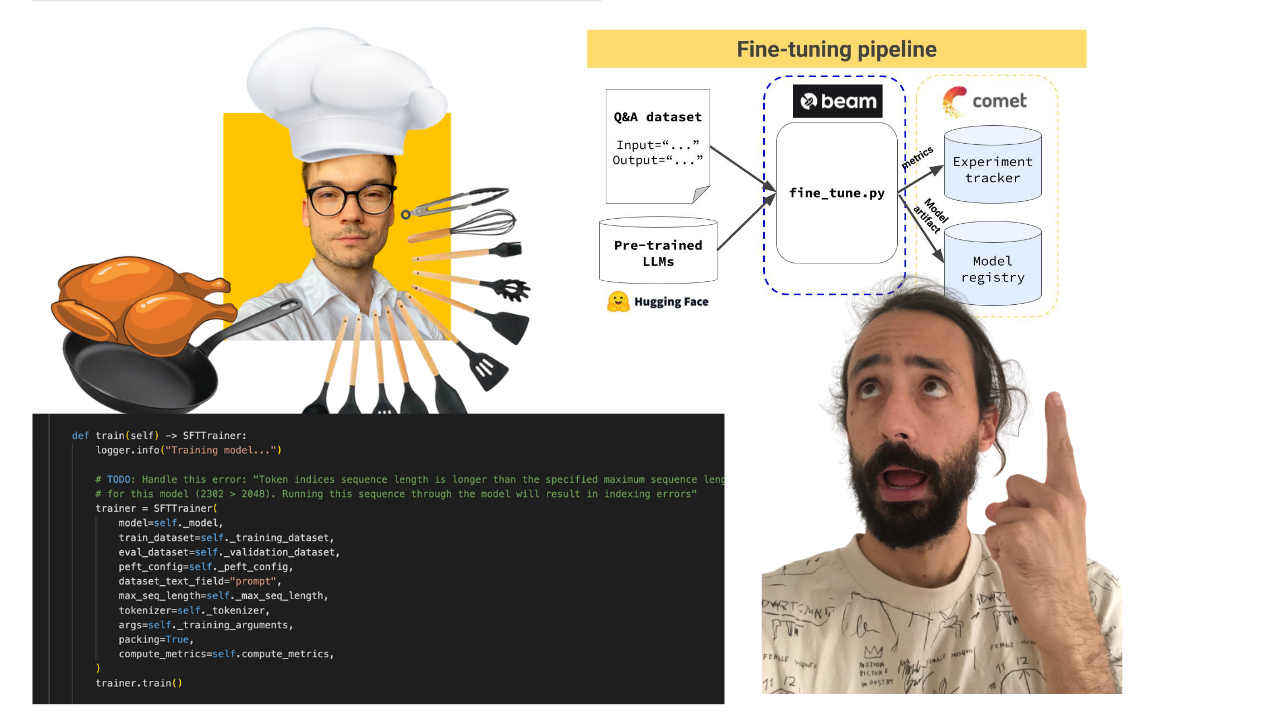

Trainingspipeline, die:

Die Trainingspipeline wird mithilfe von Beam als serverlose GPU-Infrastruktur bereitgestellt .

-> Gefunden im Verzeichnis modules/training_pipeline .

Hinweis: Machen Sie sich keine Sorgen, wenn Sie nicht über die Mindestanforderungen an die Hardware verfügen. Wir zeigen Ihnen, wie Sie die Trainingspipeline in der serverlosen Infrastruktur von Beam bereitstellen und dort den LLM trainieren.

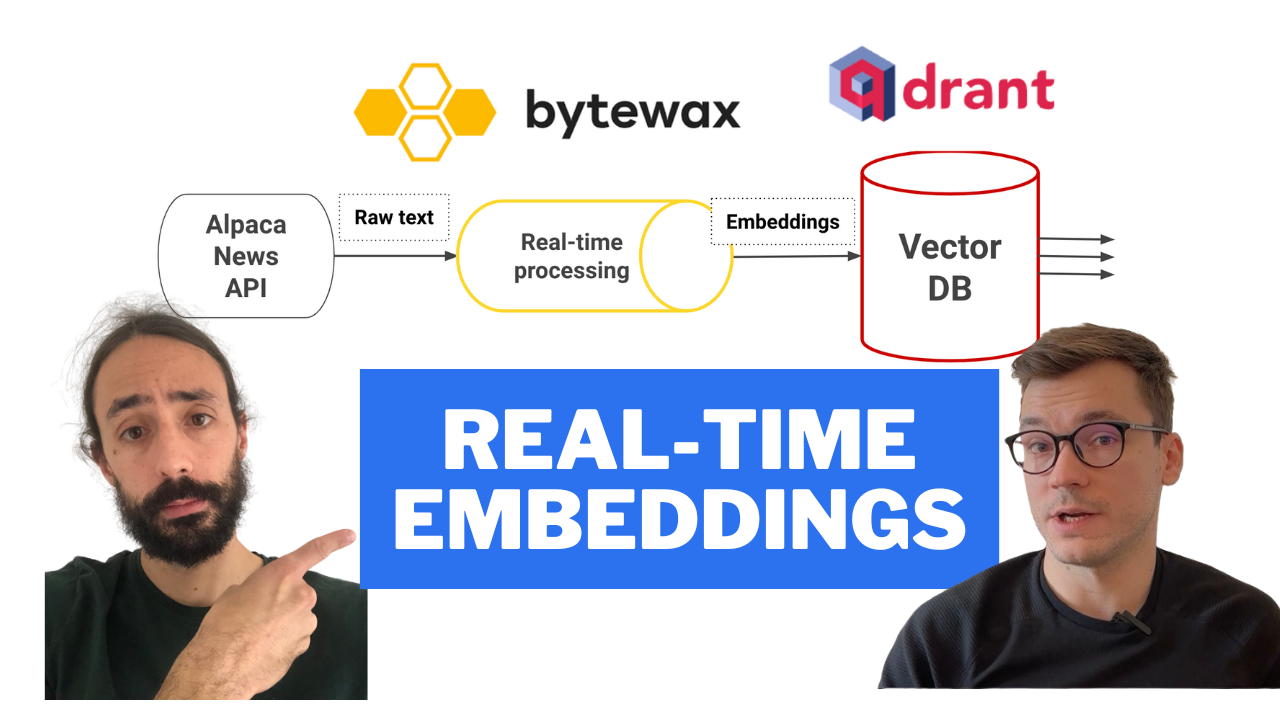

Echtzeit-Feature-Pipeline, die:

Die Streaming-Pipeline wird mithilfe einer in GitHub-Aktionen integrierten CI/CD-Pipeline automatisch auf einer AWS EC2-Maschine bereitgestellt .

-> Gefunden im Verzeichnis modules/streaming_pipeline .

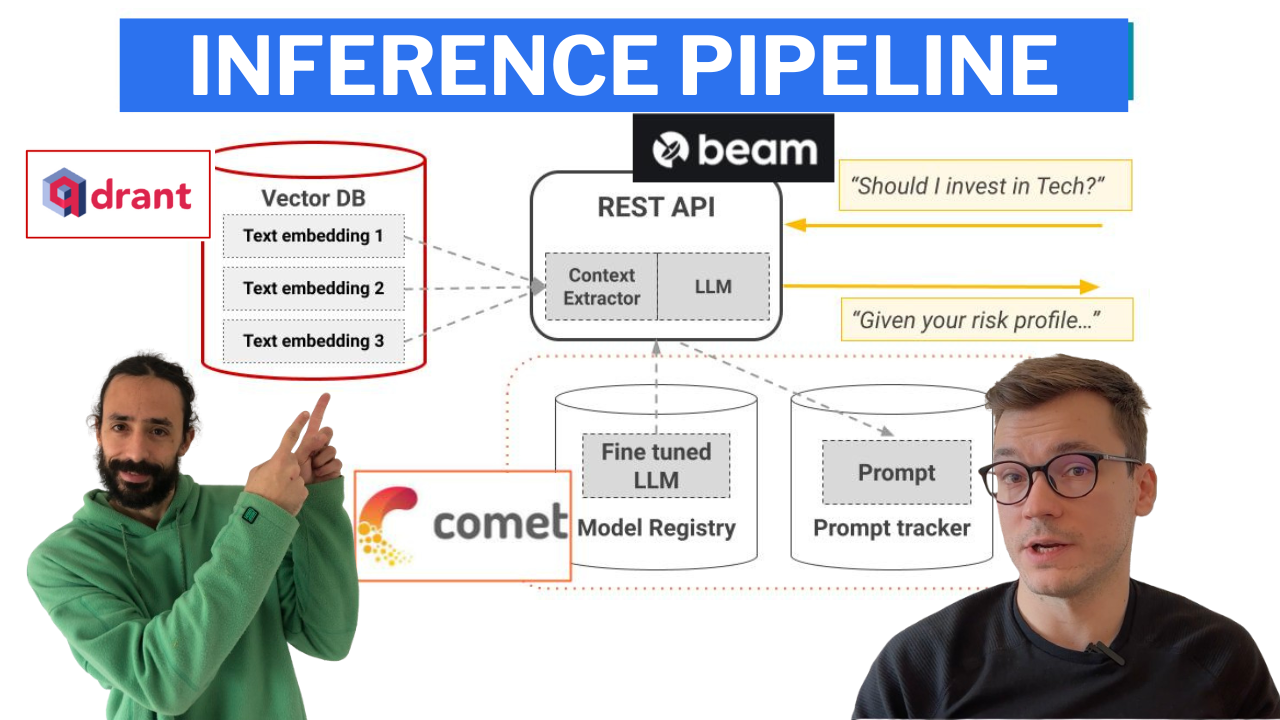

Inferenzpipeline, die LangChain verwendet, um eine Kette zu erstellen, die:

Die Inferenzpipeline wird mithilfe von Beam als serverlose GPU-Infrastruktur als RESTful-API bereitgestellt . Außerdem ist es zu Demozwecken in eine Benutzeroberfläche eingebettet, die in Gradio implementiert ist.

-> Gefunden im Verzeichnis modules/financial_bot .

Hinweis: Machen Sie sich keine Sorgen, wenn Sie nicht über die Mindestanforderungen an die Hardware verfügen. Wir zeigen Ihnen, wie Sie die Inferenzpipeline in der serverlosen Infrastruktur von Beam bereitstellen und von dort aus das LLM aufrufen.

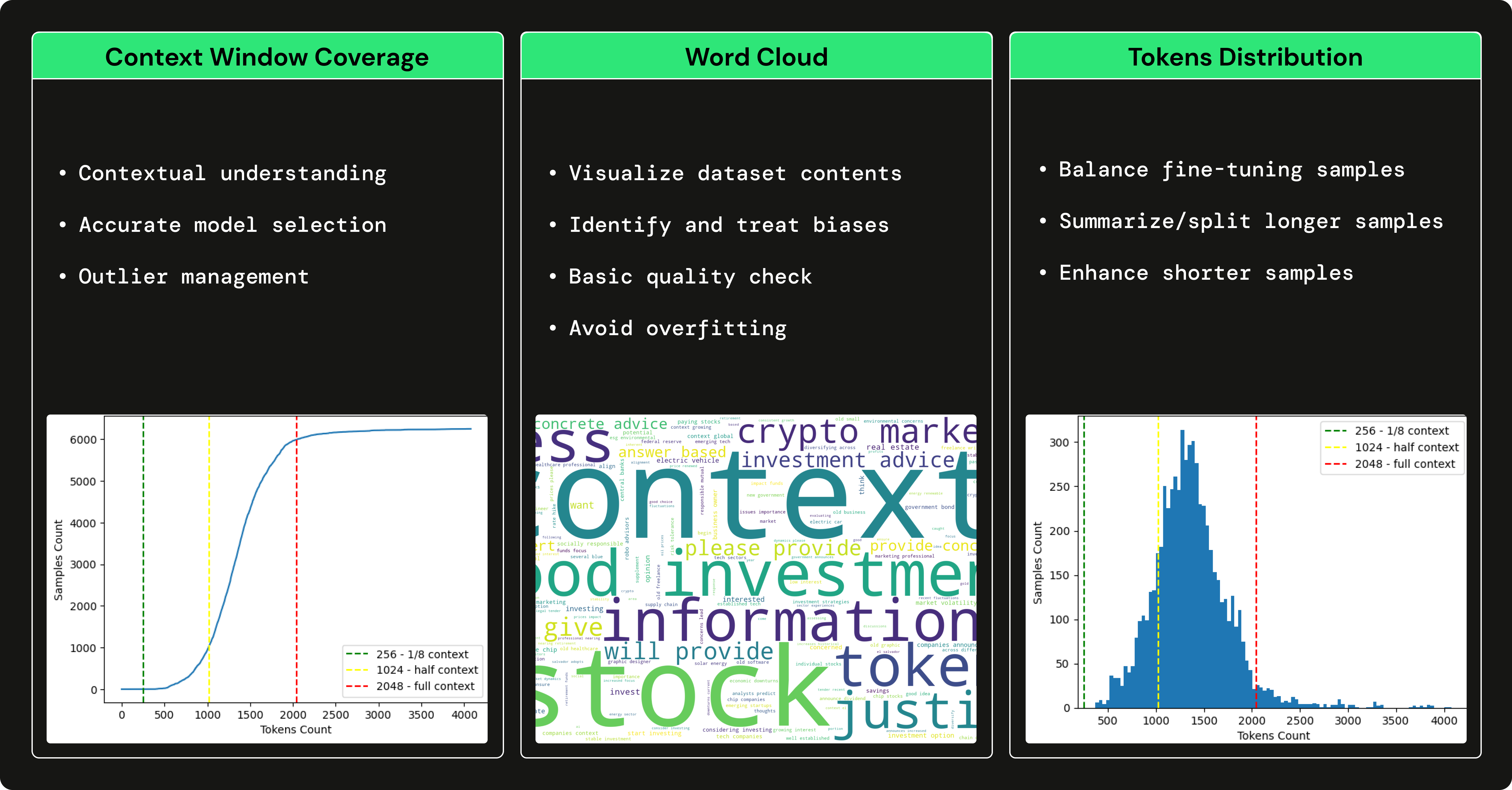

Wir haben GPT3.5 verwendet, um einen Finanz-Q&A-Datensatz zu generieren, um unser Open-Source-LLM zu verfeinern und uns auf die Verwendung von Finanzbegriffen und die Beantwortung von Finanzfragen zu spezialisieren. Die Verwendung eines großen LLM wie GPT3.5 zum Generieren eines Datensatzes, der einen kleineren LLM (z. B. Falcon 7B) trainiert, wird als Feinabstimmung mit Destillation bezeichnet.

→ Um zu verstehen, wie wir den Finanz-Q&A-Datensatz erstellt haben, lesen Sie diesen Artikel von Pau Labarta.

→ Eine vollständige Analyse des Finanz-Q&A-Datensatzes finden Sie im Unterabschnitt „dataset_analysis“ des von Alexandru Razvant verfassten Kurses.

Bevor Sie in die Module eintauchen, müssen Sie einige zusätzliche externe Tools für den Kurs einrichten.

HINWEIS: Sie können sie nach und nach für jedes Modul einrichten, da wir Ihnen in jedem Modul zeigen, was Sie benötigen.

financial news data source

Befolgen Sie dieses Dokument, um Ihnen zu zeigen, wie Sie ein KOSTENLOSES Konto erstellen und die API-Schlüssel generieren, die Sie für diesen Kurs benötigen.

Hinweis: 1x Alpaca-Datenverbindung ist KOSTENLOS.

serverless vector DB

Gehen Sie zu Qdrant und erstellen Sie ein KOSTENLOSES Konto.

Befolgen Sie anschließend dieses Dokument zum Generieren der API-Schlüssel, die Sie in diesem Kurs benötigen.

Hinweis: Wir verwenden ausschließlich den Freemium-Plan von Qdrant.

serverless ML platform

Gehen Sie zu Comet ML und erstellen Sie ein KOSTENLOSES Konto.

Befolgen Sie anschließend diese Anleitung, um einen API-SCHLÜSSEL und ein neues Projekt zu generieren, die Sie im Kurs benötigen.

Hinweis: Wir verwenden ausschließlich den Freemium-Plan von Comet ML.

serverless GPU compute | training & inference pipelines

Gehen Sie zu Beam und erstellen Sie ein KOSTENLOSES Konto.

Anschließend müssen Sie der Installationsanleitung folgen, um die CLI zu installieren und mit Ihren Beam-Anmeldeinformationen zu konfigurieren.

Um mehr über Beam zu erfahren, finden Sie hier einen Einführungsleitfaden.

Hinweis: Sie haben ca. 10 kostenlose Rechenstunden. Danach zahlen Sie nur für das, was Sie nutzen. Wenn Sie über eine Nvidia-GPU mit >8 GB VRAM verfügen und die Trainings- und Inferenzpipelines nicht bereitstellen möchten, ist die Verwendung von Beam optional.

Bei der Verwendung von Poetry hatten wir Probleme, die Beam-CLI in einer virtuellen Poetry-Umgebung zu finden. Um dies zu beheben, erstellen wir nach der Installation von Beam einen symbolischen Link, der auf die Binärdateien von Poetry verweist, wie folgt:

export COURSE_MODULE_PATH= < your-course-module-path > # e.g., modules/training_pipeline

cd $COURSE_MODULE_PATH

export POETRY_ENV_PATH= $( dirname $( dirname $( poetry run which python ) ) )

ln -s /usr/local/bin/beam ${POETRY_ENV_PATH} /bin/beam cloud compute | feature pipeline

Gehen Sie zu AWS, erstellen Sie ein Konto und generieren Sie ein Paar Anmeldeinformationen.

Laden Sie anschließend die AWS CLI v2.11.22 herunter, installieren Sie sie und konfigurieren Sie sie mit Ihren Anmeldeinformationen.

Hinweis: Sie zahlen nur für das, was Sie nutzen. Sie stellen nur eine t2.small EC2-VM bereit, was nur ~$0.023 /Stunde kostet. Wenn Sie die Feature-Pipeline nicht bereitstellen möchten, ist die Verwendung von AWS optional.

Jedes Modul hat seine Abhängigkeiten und Skripte. In einem Produktionsaufbau hätte jedes Modul sein eigenes Repository, aber in diesem Anwendungsfall haben wir zu Lernzwecken alles an einem Ort abgelegt:

Sehen Sie sich daher die README-Datei für jedes Modul einzeln an, um zu erfahren, wie es installiert und verwendet wird:

Wir empfehlen Ihnen dringend, dieses Repository zu klonen und alles zu replizieren, was wir getan haben, um das Beste aus diesem Kurs herauszuholen.

In den Videovorträgen, Artikeln und der README-Dokumentation jedes Moduls finden Sie Schritt-für-Schritt-Anleitungen.

Viel Spaß beim Lernen!

Der GitHub-Code (veröffentlicht unter der MIT-Lizenz) und die Videovorträge (veröffentlicht auf YouTube) sind völlig kostenlos. Wird es immer sein.

Die Medium-Lektionen werden unter der kostenpflichtigen Pinnwand von Medium veröffentlicht. Wenn Sie es bereits haben, sind sie kostenlos. Andernfalls müssen Sie für das Lesen der Artikel eine monatliche Gebühr von 5 US-Dollar zahlen.

Wenn Sie während des Kurses Fragen oder Probleme haben, empfehlen wir Ihnen, in diesem Repository eine Ausgabe zu erstellen, in der Sie alles, was Sie brauchen, ausführlich erklären können.

Ansonsten können Sie die Lehrkräfte auch auf LinkedIn kontaktieren:

Klicken Sie hier, um das Video anzusehen?

Klicken Sie hier, um das Video anzusehen?

Klicken Sie hier, um das Video anzusehen?

Klicken Sie hier, um das Video anzusehen?

Klicken Sie hier, um das Video anzusehen?

To understand the entire code step-by-step, check out our articles ↓

Dieser Kurs ist ein Open-Source-Projekt, das unter der MIT-Lizenz veröffentlicht wird. Solange Sie also unsere LIZENZ weitergeben und unsere Arbeit anerkennen, können Sie dieses Projekt sicher klonen oder teilen und es als Inspirationsquelle für alles verwenden, was Sie wollen (z. B. Universitätsprojekte, Hochschulabschlussprojekte usw.).

| Pau Labarta Bajo | Leitender ML- und MLOps-Ingenieur Hauptlehrer. Der Typ aus den Video-Lektionen. Twitter/X Youtube Real-World-ML-Newsletter Real-World-ML-Site |

| Alexandru Razvant | Leitender ML-Ingenieur Zweiter Koch. Der Ingenieur hinter den Kulissen. Neura-Sprünge |

| Paul Iusztin | Leitender ML- und MLOps-Ingenieur Hauptkoch. Die Jungs, die zufällig in den Video-Lektionen vorbeischauen. Twitter/X Dekodierung des ML-Newsletters Persönliche Website | ML- und MLOps-Hub |