VERI-Wild: Ein großer Datensatz und eine neue Methode zur Neuidentifizierung von Fahrzeugen in freier Wildbahn

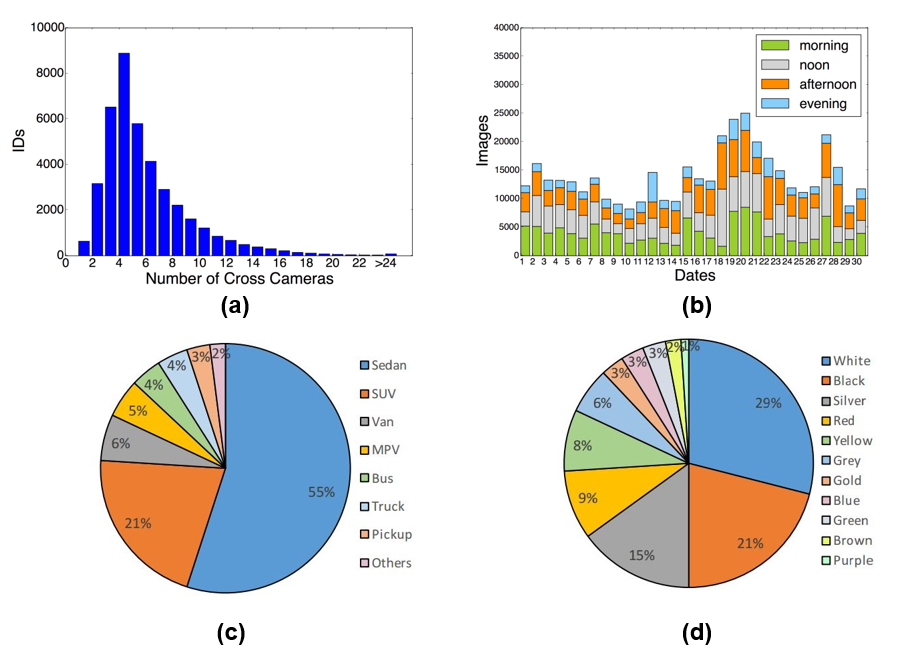

Ein umfangreicher ReID-Datensatz für Fahrzeuge in freier Wildbahn (VERI-Wild) wird von einem großen CCTV-Überwachungssystem, bestehend aus 174 Kameras, über einen Monat (30*24 Stunden) unter uneingeschränkten Szenarien erfasst. Die Kameras sind in einem großen Stadtbezirk von mehr als 200 km2 verteilt. YOLO-v2 [2] wird verwendet, um den Begrenzungsrahmen von Fahrzeugen zu erkennen. Der Rohdatensatz der Fahrzeugbilder enthält 12 Millionen Fahrzeugbilder, und 11 Freiwillige werden eingeladen, den Datensatz einen Monat lang zu bereinigen. Nach der Datenbereinigung und Annotation werden 416.314 Fahrzeugbilder von 40.671 Identitäten gesammelt. Die Statistiken von VERI-Wild sind in Abbildung dargestellt. Aus Datenschutzgründen werden die Nummernschilder im Datensatz maskiert. Die Besonderheiten von VERI-Wild lassen sich in folgenden Aspekten zusammenfassen:

Unconstrained capture conditions in the wild Der VERI-Wild-Datensatz wird von einem echten CCTV-Kamerasystem bestehend aus 174 Überwachungskameras erfasst, bei dem die uneingeschränkten Bildaufnahmebedingungen eine Vielzahl von Herausforderungen mit sich bringen.

Complex capture conditions Die 174 Überwachungskameras sind in einem Stadtbezirk auf einer Fläche von 200 km2 verteilt und zeigen unterschiedliche Hintergründe, Auflösungen, Standpunkte und Verdeckungen in freier Wildbahn. Im Extremfall erscheint ein Fahrzeug in mehr als 40 verschiedenen Kameras, was für ReID-Algorithmen eine Herausforderung darstellen würde.

Large time span involving severe illumination and weather changes Das VERI-Wild wird aus einer Dauer von 125.280 (174x24x30) Videostunden zusammengestellt. Abbildung (b) zeigt die Fahrzeugverteilungen in 4 Zeitfenstern von 24 Stunden, dh morgens, mittags, nachmittags und abends, über 30 Tage hinweg. VERI-Wild enthält auch schlechte Wetterbedingungen wie Regen, Nebel usw., die in früheren Datensätzen nicht enthalten waren.

Rich Context Information Wir stellen umfangreiche Kontextinformationen wie Kamera-IDs, Zeitstempel und Verfolgungsbeziehungen zwischen Kameras bereit, die das Potenzial haben, die Forschung zur Verhaltensanalyse in Kameranetzwerken wie Fahrzeugverhaltensmodellierung, kameraübergreifender Verfolgung und grafikbasiertem Abruf zu erleichtern.

Wichtig!!!!!!!!!

Beachten Sie, dass Sie für den VERI-Wild-Testsatz bei gegebenem Abfragebild die Bilder mit derselben Kamera-ID und derselben Fahrzeug-ID wie das Abfragebild im Galeriesatz entfernen müssen. Sie werden bei der Berechnung von mAP und CMC nicht berücksichtigt.

@inproceedings{lou2019large,

title={VERI-Wild: A Large Dataset and a New Method for Vehicle Re-Identification in the Wild},

author={Lou, Yihang and Bai, Yan and Liu, Jun and Wang, Shiqi and Duan, Ling-Yu},

booktitle={Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition},

pages = {3235--3243},

year={2019}

}

@inproceedings{lou2019large,

title={Disentangled Feature Learning Network and a Comprehensive Benchmark for Vehicle Re-Identification},

author={Bai, Yan and Liu, Jun and Lou, Yihang and Wang, Ce and Duan, Ling-Yu},

booktitle={In IEEE Transactions on Pattern Analysis and Machine Intelligence},

year={2021}

}

Yan Bai, E-Mail: [email protected]

Um entsprechende Forschung zu fördern, stellen wir den Datensatz entsprechend Ihrer Anfrage zur Verfügung. Bitte senden Sie Ihren vollständigen Namen und Ihre Zugehörigkeit per E-Mail an die Kontaktperson (yanbai at pku dot edu dot cn). Wir erfragen Ihre Angaben ausschließlich, um sicherzustellen, dass der Datensatz für nichtkommerzielle Zwecke genutzt wird. Wir werden es nicht an Dritte weitergeben oder irgendwo öffentlich veröffentlichen. Aus Datenschutzgründen werden wir die Nummernschilder in Zukunft nicht mehr zur Verfügung stellen. Wenn Sie unseren Datensatz herunterladen, bedeutet dies, dass Sie unseren Zugangsbedingungen in der E-Mail zugestimmt haben.

| Methoden | Klein | Medium | Groß | ||||||

| Karte | Top1 | Top5 | Karte | Top1 | Top5 | Karte | Top1 | Top5 | |

| GoogleNet[1] | 24.27 | 57.16 | 75.13 | 24.15 | 53.16 | 71.1 | 21.53 | 44,61 | 63,55 |

| FDA-Net(VGGM)[2] | 35.11 | 64.03 | 82,80 | 29,80 | 57,82 | 78,34 | 22.78 | 49,43 | 70,48 |

| MLSL[3] | 46,32 | - | - | 42,37 | - | - | 36,61 | - | - |

| Triplett (Resnet50) | 58,43 | 65,76 | 86,98 | 49,72 | 57,76 | 80,86 | 38,57 | 47,65 | 71,66 |

| FDA-Net(Resnet50)[2] | 61,57 | 73,62 | 91,23 | 52,69 | 64,29 | 85,39 | 45,78 | 58,76 | 80,97 |

| AAVER(Resnet50)[4] | 62.23 | 75,80 | 92,70 | 53,66 | 68,24 | 88,88 | 41,68 | 58,69 | 81,59 |

| DFLNet(Resnet50)[5] | 68.21 | 80,68 | 93,24 | 60.07 | 70,67 | 89,25 | 49.02 | 61,60 | 82,73 |

| BS(mobilenet)[6] | 70,54 | 84,17 | 95,30 | 62,83 | 78,22 | 93.06 | 51,63 | 69,99 | 88,45 |

| UMTS(Resnet50)[7] | 72,7 | 84,5 | - | 66.1 | 79,3 | - | 54.2 | 72,8 | - |

| Starke Baesline(Resnet50)[8] | 76,61 | 90,83 | 97,29 | 70.11 | 87,45 | 95,24 | 61.3 | 82,58 | 92,73 |

| HPGN(Resnet50+PGN)[9] | 80,42 | 91,37 | - | 75,17 | 88,21 | - | 65.04 | 82,68 | - |

| GLAMOUR(Resnet50+PGN)[10] | 77,15 | 92.13 | 97,43 | - | - | - | - | - | - |

| PVEN(Resnet50)[12] | 79,8 | 94.01 | 98.06 | 73,9 | 92.03 | 97,15 | 66.2 | 88,62 | 95,31 |

| SPARER(Resnet50)[11] | 80,9 | 93,78 | 97,93 | 75,3 | 92,7 | 97,48 | 67,7 | 89,5 | 95,8 |

| DFNet(Resnet50)[14] | 83.09 | 94,79 | 98.05 | 77,27 | 93,22 | 97,46 | 69,85 | 89,38 | 96.03 |

| Methoden | Alle testen | Testsatz A | Testsatz B | ||||||

| Karte | Top1 | Top5 | Karte | Top1 | Top5 | Karte | Top1 | Top5 | |

| Starke Basislinie (Resnet50) [8] | 34,71 | 54,37 | 63,99 | 32,75 | 40.12 | 52.18 | 42,25 | 82,72 | 90,67 |

| GSTE (Resnet50) (mit Trickkiste)[13] | 32,57 | 59,25 | 64,48 | 33.01 | 47,54 | 50,81 | 41,82 | 86.08 | 91,43 |

| FDA-Net (Resnet50) (mit Trickkiste) [2] | 34.21 | 57,32 | 64,90 | 34,63 | 45,53 | 52,77 | 3,93 | 84,78 | 92,47 |

| ÜBERHAUPT (Resnet50) [41] | 36.8 | 59.1 | 67,6 | 36.8 | 48,7 | 57.3 | 45.4 | 86.1 | 94,3 |

| PVEN(Resnet50)[12] | 37.15 | 61.19 | 68,63 | 38,77 | 51,28 | 59,32 | 45,48 | 88.05 | 94,35 |

| SPARER(Resnet50)[11] | 38,0 | 62.1 | 69,50 | 39.2 | 52.3 | 60.2 | 45.1 | 88.1 | 94.1 |

| DFNet(Resnet50)[14] | 39,84 | 62.21 | 68,90 | 40,39 | 51,68 | 60,51 | 46.13 | 88,56 | 94,17 |

[1] Yang, L., Luo, P., Change Loy, C., Tang, X.: Ein umfangreicher Autodatensatz für eine feinkörnige Kategorisierung und Verifizierung. In: IEEE-Konferenz zu Computer Vision und Mustererkennung. (2015)

[2] Lou, Y., Bai, Y., Liu, J., Wang, S., Duan, L.: Veri-wild: Ein großer Datensatz und eine neue Methode zur Neuidentifizierung von Fahrzeugen in freier Wildbahn. In: IEEE-Konferenz zu ComputerVision und Mustererkennung. (2019)

[3] Alfasly, S., Hu, Y., Li, H., Liang, T., Jin, X., Liu, B., Zhao, Q.: Multi-Label-basiertes Ähnlichkeitslernen für die Neuidentifizierung von Fahrzeugen. IEEE Access7 (2019)

[4] Pirazh, K., Kumar, A., Peri, N., et al: Ein Dual-Path-Modell mit adaptiver Aufmerksamkeit für die Neuidentifizierung von Fahrzeugen. In: Internationale IEEE-Konferenz zu Computer Vision (2019)

[5] Yan Bai, Yihang Lou, Yongxing Dai, et al: Disentangled Feature Learning Network for Vehicle Re-Identification. In: IJCAI 2020

[6] Kuma Ratnesh und Weill Edwin und et al: Fahrzeug-Re-Identifizierung: eine effiziente Basislinie mit Triplett-Einbettung. IN IJCNN 2019

[7] Xin Jin, Cuiling Lan, Wenjun Zeng, Zhibo Chen: Unsicherheitsbewusste Multi-Shot-Wissensdestillation zur bildbasierten Objekt-Neuidentifizierung. In: AAAI 2020

[8] Luo Hao und Gu Youzhi und et al.: Eine Trickkiste und eine starke Grundlage für eine tiefe Personen-Re-Identifizierung. Im CVPR-Workshop 2019.

[9] Shen Fei, Zhu Jianqing und et al.: Erforschung der räumlichen Bedeutung mithilfe eines hybriden Pyramidengraphennetzwerks zur Neuidentifizierung von Fahrzeugen. Im arXiv-Vorabdruck arXiv:2005.14684

[10] Abhijit Suprem und Calton Pu: Glamourös aussehen: Fahrzeug-Neuidentifizierung in heterogenen Kameranetzwerken mit globaler und lokaler Aufmerksamkeit. Im arXiv-Vorabdruck arXiv:2002.02256

[11] Khorramshahi Pirazh, Peri Neehar, Chen Jun-cheng, Chellappa Rama: Der Teufel steckt im Detail: Selbstüberwachte Aufmerksamkeit für die Neuidentifizierung von Fahrzeugen. Im ECCV 2020

[12] Meng, Decao et al. „Parsing-basiertes, ansichtsbewusstes Einbettungsnetzwerk zur Neuidentifizierung von Fahrzeugen.“ Tagungsband der IEEE/CVF-Konferenz zu Computer Vision und Mustererkennung. 2020.

[13] Yan Bai, Yihang Lou, Feng Gao, Shiqi Wang, Yuwei Wu und Lingyu Duan. Gruppensensitive Triplett-Einbettung zur Neuidentifizierung von Fahrzeugen. IEEE-Transaktionen zu Multimedia, 2018.

[14] Yan Bai, Jun Liu, Yihang Lou, Ce Wang und Lingyu Duan. Entwirrtes Feature-Learning-Netzwerk und ein umfassender Benchmark für die Neuidentifizierung von Fahrzeugen. Tpami 2021.