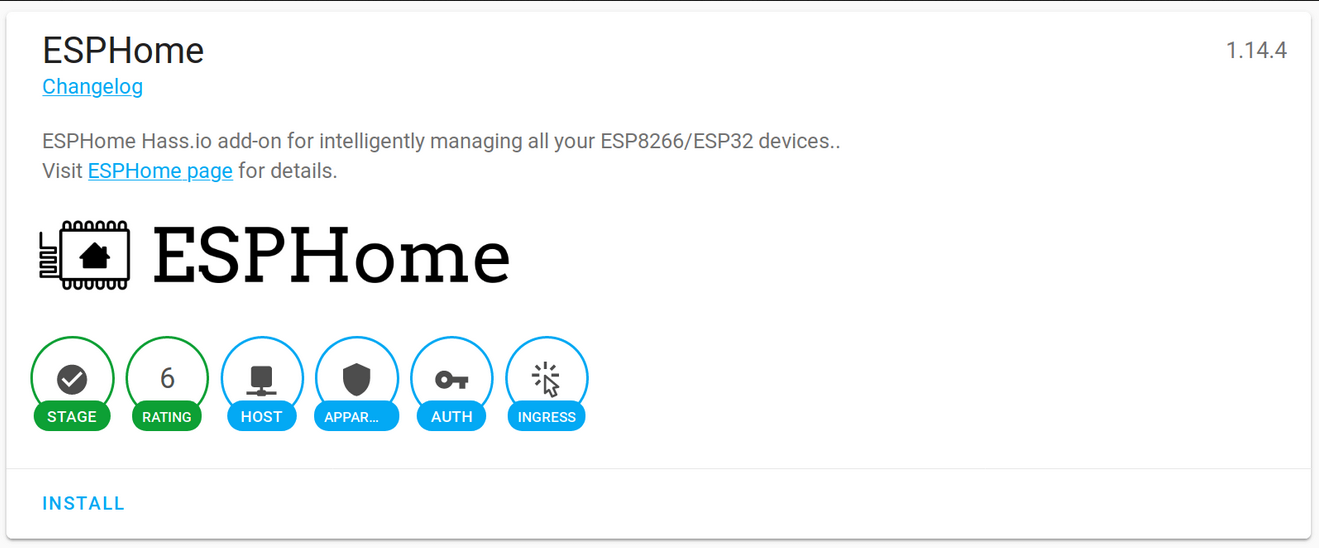

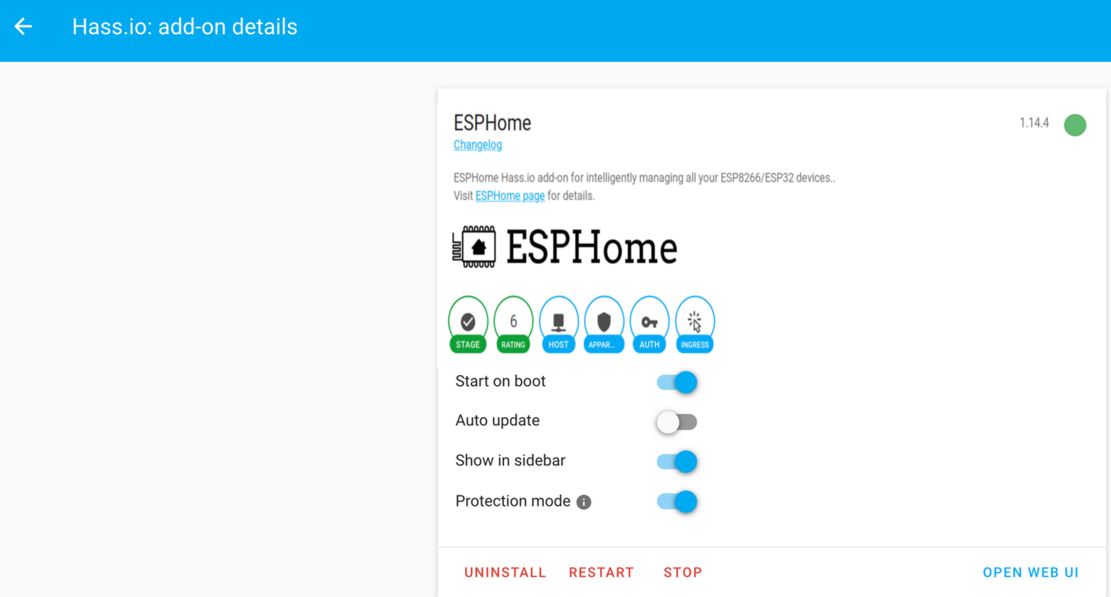

Als Erstes müssen Sie das ESPHome Docker-Image vom Docker Hub (Online) abrufen.

docker pull esphome/esphome

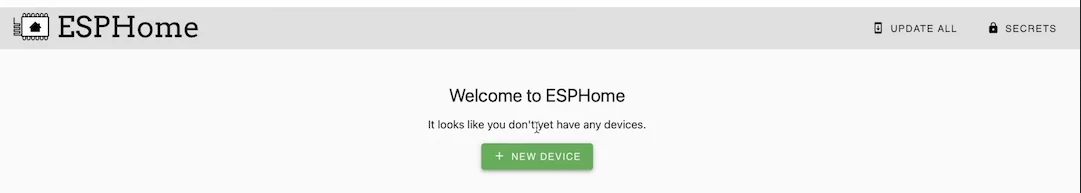

Starten Sie dann den ESPHome-Assistenten. Dieser Assistent fragt Sie nach Ihrem Gerätetyp, Ihrem Gerätenamen und Ihren WLAN-Anmeldeinformationen und generiert schließlich eine Yaml-Datei mit allen Konfigurationen für Sie.

docker run --rm -v "${PWD}":/config -it esphome/esphome wizard stl.yaml

dmesg | grep ttyUSB

docker run --rm -v "${PWD}":/config --device=/dev/ttyUSB1 -it esphome/esphome run stl.yaml

python3 --version

pip3 install wheel esphome

pip3 install --user esphome

esphome wizard stl-python.yaml

esphome run stl-python.yaml

Zurück nach oben

OpenWrt Project ist ein Linux-Betriebssystem für eingebettete Geräte. Anstatt zu versuchen, eine einzelne, statische Firmware zu erstellen, bietet OpenWrt ein vollständig beschreibbares Dateisystem mit Paketverwaltung. Es wird hauptsächlich auf eingebetteten Geräten verwendet, um den Netzwerkverkehr weiterzuleiten.

Laden Sie das entsprechende OpenWrt-Image für Ihren Raspberry PI herunter, indem Sie auf den Link oben klicken.

Raspberry Pi Imager ist die schnelle und einfache Möglichkeit, Raspberry Pi OS und andere Betriebssysteme auf einer microSD-Karte zu installieren und sie dann mit Ihrem Raspberry Pi zu verwenden.

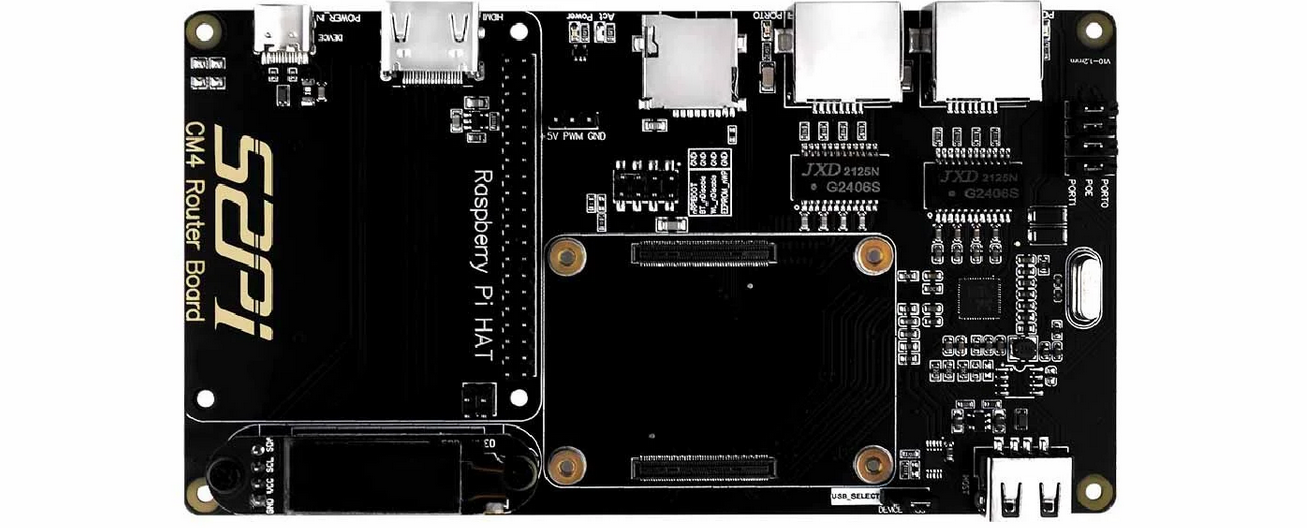

Das Raspberry Pi Router Board für das CM4-Modul (Kosten: 55 USD) ist ein Erweiterungsboard, das auf dem Raspberry Pi Compute Module 4 basiert. Es bringt Raspberry Pi CM4 zwei Gigabit-Netzwerkanschlüsse mit voller Geschwindigkeit und bietet bessere Leistung, geringere CPU-Auslastung und höhere Stabilität für eine lange Zeit arbeiten im Vergleich zu einer USB-Netzwerkkarte. Es ist kompatibel mit Raspberry Pi OS, Ubuntu Server und anderen Raspberry Pi-Systemen.

Raspberry Pi Router Board für CM4-Modul

Technische Daten:

Zurück nach oben

Watchdog Timer (WDT) ist ein Timer, der Mikrocontroller-Programme (MCU) überwacht, um festzustellen, ob sie außer Kontrolle geraten oder nicht mehr funktionieren.

Um Watchdog zu aktivieren, müssen Sie die Boot-Parameter ändern, indem Sie dtparam=watchdog=on in /boot/config.txt mit einem Texteditor wie Nano, Vim, Gedit usw. hinzufügen. Installieren Sie außerdem das Watchdog-Paket und aktivieren Sie es, um es zu starten Start-up. Stellen Sie außerdem sicher, dass Sie Ihren Raspberry Pi neu starten, damit diese Einstellungen wirksam werden.

pi@raspberrypi:~ $ sudo apt install watchdog

pi@raspberrypi:~ $sudo systemctl enable watchdog

Die Konfigurationsdatei für Watchdog finden Sie in /etc/watchdog.conf .

max-load-1 = 24

watchdog-device = /dev/watchdog

realtime = yes

priority = 1

So starten Sie den WTD-Dienst:

pi@raspberrypi:~ $ sudo systemctl start watchdog

Watchdog-Status prüfen:

pi@raspberrypi:~ $ sudo systemctl status watchdog

So beenden Sie den Dienst:

pi@raspberrypi:~ $ sudo systemctl stop watchdog

Zurück nach oben

Raspberry Pi Gehäuse von Pi-Shop US

Raspberry Pi-Gehäuse von The Pi Hut

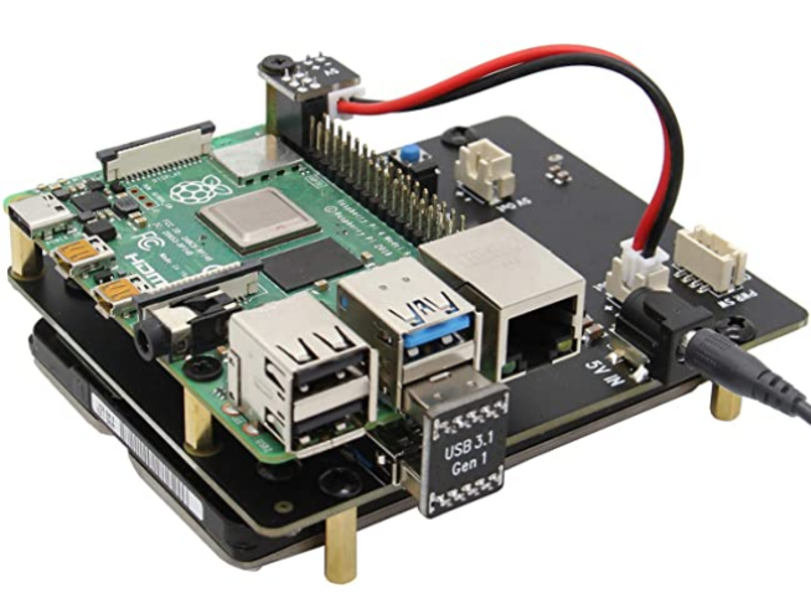

Die X825-Erweiterungskarte bietet eine vollständige Speicherlösung für das neueste Raspberry Pi 4 Modell B und unterstützt bis zu 4 TB 2,5-Zoll-SATA-Festplattenlaufwerke (HDD)/Solid-State-Laufwerke (SSD).

Sabrent M.2 SSD [NGFF] auf USB 3.0 / SATA III 2,5-Zoll-Aluminiumgehäuse-Adapter

Samsung 970 EVO 250 GB – NVMe PCIe M.2 2280 SSD

Western Digital 1 TB WD Blue SN550 NVMe interne SSD

Tragbare SSD SAMSUNG T5

Samsung SSD 860 EVO 250 GB mSATA Interne SSD

Samsung 850 EVO 120 GB SSD mSATA

Zurück nach oben

Grafana ist eine Analyseplattform, die es Ihnen ermöglicht, Daten abzufragen und zu visualisieren und anschließend Dashboards basierend auf Ihren Visualisierungen zu erstellen und zu teilen. Visualisieren Sie ganz einfach Metriken, Protokolle und Traces aus mehreren Quellen wie Prometheus, Loki, Elasticsearch, InfluxDB, Postgres, Fluentd, Fluentbit, Logstash und vielen mehr.

Erste Schritte mit Grafana

Grafana-Gemeinschaft

Grafana Professional Services-Schulung | Grafana Labs

Grafana Pro-Schulung AWS | Grafana Labs

Grafana-Tutorials

Die besten Grafana-Kurse auf Udemy

Grafana Online-Schulungskurse | LinkedIn-Lernen

Grafana-Schulungskurse – NobleProg

Einrichten von Grafana zur Visualisierung unseres Metrikkurses auf Coursera

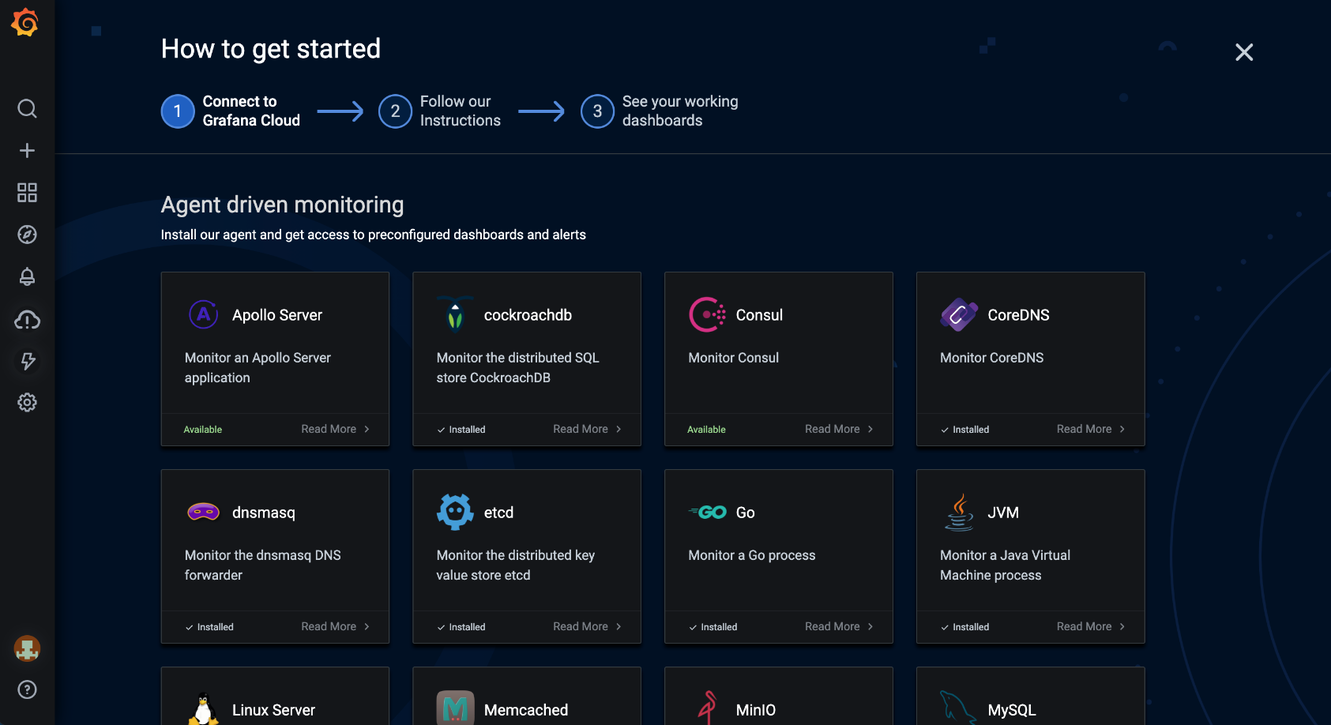

Grafana Cloud ist eine zusammensetzbare Observability-Plattform, die Metriken, Traces und Protokolle mit Grafana integriert. Nutzen Sie die beste Open-Source-Observability-Software – einschließlich Prometheus, Loki und Tempo – ohne den Aufwand für die Installation, Wartung und Skalierung Ihres Observability-Stacks.

Grafana Cloud-Integrationen. Quelle: Grafana

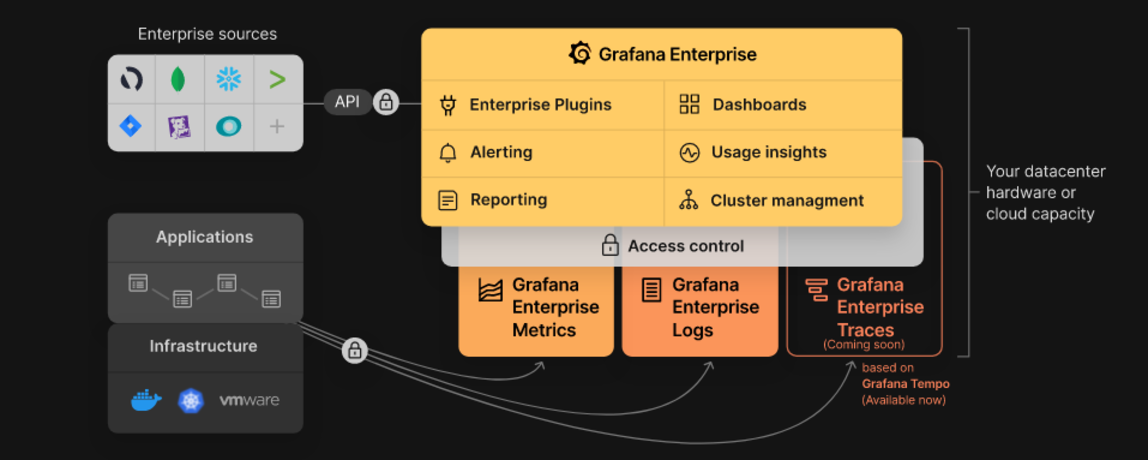

Grafana Enterprise ist ein Dienst, der Funktionen umfasst, die eine bessere Skalierbarkeit, Zusammenarbeit, Abläufe und Governance in einer selbstverwalteten Umgebung bieten.

Grafana Enterprise Stack. Quelle: Grafana

Grafana Tempo ist ein hochskaliertes, verteiltes Open-Source-Tarcing-Backend. Tempo ist kosteneffizient, erfordert zum Betrieb nur Objektspeicher und ist tief in Grafana, Loki und Prometheus integriert.

Grafana MetricTank ist eine von Grafana Labs entwickelte mandantenfähige Zeitreihenplattform für Graphite. MetricTank bietet Hochverfügbarkeit (HA) und effiziente langfristige Speicherung, Abfrage und Verarbeitung für große Umgebungen.

Grafana Tanka ist ein robustes Konfigurationsdienstprogramm für Ihren Kubernetes-Cluster, das auf der Jsonnet-Sprache basiert.

Grafana Loki ist ein horizontal skalierbares, hochverfügbares (HA) Multi-Tenant-Log-Aggregationssystem, das von Prometheus inspiriert ist.

Cortex ist ein Projekt, mit dem Benutzer Metriken von vielen Prometheus-Servern an einem einzigen Ort abfragen können, ohne dass Lücken in den GRPAHs aufgrund von Serverausfällen entstehen. Außerdem können Sie mit Cortex Prometheus-Metriken für die langfristige Kapazitätsplanung und Leistungsanalyse speichern.

Graphite ist ein Open-Source-Überwachungssystem.

Zurück nach oben

cURL ist ein Computersoftwareprojekt, das eine Bibliothek und ein Befehlszeilentool für die Datenübertragung mithilfe verschiedener Netzwerkprotokolle (HTTP, HTTPS, FTP, FTPS, SCP, SFTP, TFTP, DICT, TELNET, LDAP LDAPS, MQTT, POP3, POP3S, RTMP) bereitstellt , RTMPS, RTSP, SCP, SFTP, SMB, SMBS, SMTP oder SMTPS). cURL wird auch in Autos, Fernsehgeräten, Routern, Druckern, Audiogeräten, Mobiltelefonen, Tablets, Set-Top-Boxen und Mediaplayern verwendet und ist die Internet-Übertragungsmaschine für Tausende von Softwareanwendungen in über zehn Milliarden Installationen.

cURL Fuzzer ist ein Qualitätssicherungstest für das Curl-Projekt.

DoH ist eine eigenständige Anwendung für DoH-Namensauflösungen und -Suchen (DNS-over-HTTPS).

Authelia ist ein hochverfügbarer Open-Source-Authentifizierungsserver, der Single-Sign-On-Funktionen und Zwei-Faktor-Authentifizierung für Anwendungen bietet, die hinter NGINX ausgeführt werden.

nginx(engine x) ist ein HTTP- und Reverse-Proxy-Server, ein Mail-Proxy-Server und ein generischer TCP/UDP-Proxy-Server, ursprünglich geschrieben von Igor Sysoev.

Proxmox Virtual Environment (VE) ist eine vollständige Open-Source-Plattform für die Unternehmensvirtualisierung. Es umfasst eine integrierte Weboberfläche, mit der Sie VMs und Container, softwaredefinierten Speicher und Netzwerk, Hochverfügbarkeits-Clustering und mehrere sofort einsatzbereite Tools einfach in einer einzigen Lösung verwalten können.

Wireshark ist ein sehr beliebter Netzwerkprotokollanalysator, der häufig zur Fehlerbehebung, Analyse und Entwicklung von Kommunikationsprotokollen im Netzwerk verwendet wird. Erfahren Sie mehr über die anderen verfügbaren nützlichen Wireshark-Tools.

HTTPie ist ein Befehlszeilen-HTTP-Client. Ziel ist es, die CLI-Interaktion mit Webdiensten so benutzerfreundlich wie möglich zu gestalten. HTTPie wurde zum Testen, Debuggen und zur allgemeinen Interaktion mit APIs und HTTP-Servern entwickelt.

HTTPStat ist ein Tool, das Curl-Statistiken in einem einfachen Layout visualisiert.

Wuzz ist ein interaktives CLI-Tool für die HTTP-Inspektion. Es kann zum Überprüfen/Ändern von Anforderungen verwendet werden, die mit der Funktion „Als cURL kopieren“ aus dem Netzwerkinspektor des Browsers kopiert wurden.

Websocat ist ein Befehlszeilen-Client für WebSockets, wie Netcat (oder Curl) für ws:// mit erweiterten Socat-ähnlichen Funktionen.

• Connection: In networking, a connection refers to pieces of related information that are transferred through a network. This generally infers that a connection is built before the data transfer (by following the procedures laid out in a protocol) and then is deconstructed at the at the end of the data transfer.

• Packet: A packet is, generally speaking, the most basic unit that is transferred over a network. When communicating over a network, packets are the envelopes that carry your data (in pieces) from one end point to the other.

Pakete verfügen über einen Header-Teil, der Informationen über das Paket enthält, einschließlich Quelle und Ziel, Zeitstempel und Netzwerk-Hops. Der Hauptteil eines Pakets enthält die tatsächlich übertragenen Daten. Es wird manchmal als Körper oder Nutzlast bezeichnet.

• Network Interface: A network interface can refer to any kind of software interface to networking hardware. For instance, if you have two network cards in your computer, you can control and configure each network interface associated with them individually.

Eine Netzwerkschnittstelle kann einem physischen Gerät zugeordnet sein oder eine Darstellung einer virtuellen Schnittstelle sein. Ein Beispiel hierfür ist das „Loop-Back“-Gerät, das eine virtuelle Schnittstelle zur lokalen Maschine darstellt.

• LAN: LAN stands for "local area network". It refers to a network or a portion of a network that is not publicly accessible to the greater internet. A home or office network is an example of a LAN.

• WAN: WAN stands for "wide area network". It means a network that is much more extensive than a LAN. While WAN is the relevant term to use to describe large, dispersed networks in general, it is usually meant to mean the internet, as a whole.

Ist eine Schnittstelle mit dem WAN verbunden, wird grundsätzlich davon ausgegangen, dass sie über das Internet erreichbar ist.

• Protocol: A protocol is a set of rules and standards that basically define a language that devices can use to communicate. There are a great number of protocols in use extensively in networking, and they are often implemented in different layers.

Einige Low-Level-Protokolle sind TCP, UDP, IP und ICMP. Einige bekannte Beispiele für Protokolle der Anwendungsschicht, die auf diesen niedrigeren Protokollen aufbauen, sind HTTP (für den Zugriff auf Webinhalte), SSH, TLS/SSL und FTP.

• Port: A port is an address on a single machine that can be tied to a specific piece of software. It is not a physical interface or location, but it allows your server to be able to communicate using more than one application.

• Firewall: A firewall is a program that decides whether traffic coming into a server or going out should be allowed. A firewall usually works by creating rules for which type of traffic is acceptable on which ports. Generally, firewalls block ports that are not used by a specific application on a server.

• NAT: Network address translation is a way to translate requests that are incoming into a routing server to the relevant devices or servers that it knows about in the LAN. This is usually implemented in physical LANs as a way to route requests through one IP address to the necessary backend servers.

• VPN: Virtual private network is a means of connecting separate LANs through the internet, while maintaining privacy. This is used as a means of connecting remote systems as if they were on a local network, often for security reasons.

While networking is often discussed in terms of topology in a horizontal way, between hosts, its implementation is layered in a vertical fashion throughout a computer or network. This means is that there are multiple technologies and protocols that are built on top of each other in order for communication to function more easily. Each successive, higher layer abstracts the raw data a little bit more, and makes it simpler to use for applications and users. It also allows you to leverage lower layers in new ways without having to invest the time and energy to develop the protocols and applications that handle those types of traffic.

As data is sent out of one machine, it begins at the top of the stack and filters downwards. At the lowest level, actual transmission to another machine takes place. At this point, the data travels back up through the layers of the other computer. Each layer has the ability to add its own "wrapper" around the data that it receives from the adjacent layer, which will help the layers that come after decide what to do with the data when it is passed off.

One method of talking about the different layers of network communication is the OSI model. OSI stands for Open Systems Interconnect.This model defines seven separate layers. The layers in this model are:

• Application: The application layer is the layer that the users and user-applications most often interact with. Network communication is discussed in terms of availability of resources, partners to communicate with, and data synchronization.

• Presentation: The presentation layer is responsible for mapping resources and creating context. It is used to translate lower level networking data into data that applications expect to see.

• Session: The session layer is a connection handler. It creates, maintains, and destroys connections between nodes in a persistent way.

• Transport: The transport layer is responsible for handing the layers above it a reliable connection. In this context, reliable refers to the ability to verify that a piece of data was received intact at the other end of the connection. This layer can resend information that has been dropped or corrupted and can acknowledge the receipt of data to remote computers.

• Network: The network layer is used to route data between different nodes on the network. It uses addresses to be able to tell which computer to send information to. This layer can also break apart larger messages into smaller chunks to be reassembled on the opposite end.

• Data Link: This layer is implemented as a method of establishing and maintaining reliable links between different nodes or devices on a network using existing physical connections.

• Physical: The physical layer is responsible for handling the actual physical devices that are used to make a connection. This layer involves the bare software that manages physical connections as well as the hardware itself (like Ethernet).

Das TCP/IP-Modell, besser bekannt als Internet Protocol Suite, ist ein weiteres Schichtmodell, das einfacher ist und weit verbreitet ist. Es definiert die vier separaten Schichten, von denen sich einige mit dem OSI-Modell überschneiden:

• Application: In this model, the application layer is responsible for creating and transmitting user data between applications. The applications can be on remote systems, and should appear to operate as if locally to the end user.

Die Kommunikation findet zwischen Peers im Netzwerk statt.

• Transport: The transport layer is responsible for communication between processes. This level of networking utilizes ports to address different services. It can build up unreliable or reliable connections depending on the type of protocol used.

• Internet: The internet layer is used to transport data from node to node in a network. This layer is aware of the endpoints of the connections, but does not worry about the actual connection needed to get from one place to another. IP addresses are defined in this layer as a way of reaching remote systems in an addressable manner.

• Link: The link layer implements the actual topology of the local network that allows the internet layer to present an addressable interface. It establishes connections between neighboring nodes to send data.

Schnittstellen sind Netzwerkkommunikationspunkte für Ihren Computer. Jede Schnittstelle ist einem physischen oder virtuellen Netzwerkgerät zugeordnet. Normalerweise verfügt Ihr Server über eine konfigurierbare Netzwerkschnittstelle für jede Ethernet- oder WLAN-Internetkarte, die Sie besitzen. Darüber hinaus wird eine virtuelle Netzwerkschnittstelle namens „Loopback“ oder Localhost-Schnittstelle definiert. Dies dient als Schnittstelle, um Anwendungen und Prozesse auf einem einzelnen Computer mit anderen Anwendungen und Prozessen zu verbinden. In vielen Tools wird dies als „lo“-Schnittstelle bezeichnet.

Die Vernetzung funktioniert, indem mehrere verschiedene Protokolle huckepack übereinander gelegt werden. Auf diese Weise kann ein Datenelement mithilfe mehrerer ineinander gekapselter Protokolle übertragen werden.

Media Access Control (MAC) ist ein Kommunikationsprotokoll, das zur Unterscheidung bestimmter Geräte verwendet wird. Jedes Gerät soll während des Herstellungsprozesses eine eindeutige MAC-Adresse erhalten, die es von allen anderen Geräten im Internet unterscheidet. Durch die Adressierung von Hardware über die MAC-Adresse können Sie ein Gerät anhand eines eindeutigen Werts referenzieren, selbst wenn die Software darüber den Namen für dieses bestimmte Gerät während des Betriebs ändern kann. Die Medienzugriffskontrolle ist eines der wenigen Protokolle der Verbindungsschicht, mit denen Sie wahrscheinlich regelmäßig interagieren.

Das IP-Protokoll ist eines der grundlegenden Protokolle, die das Funktionieren des Internets ermöglichen. IP-Adressen sind in jedem Netzwerk eindeutig und ermöglichen es Maschinen, sich im gesamten Netzwerk gegenseitig anzusprechen. Es wird auf der Internetschicht im IP/TCP-Modell implementiert. Netzwerke können miteinander verbunden werden, der Datenverkehr muss jedoch beim Überschreiten von Netzwerkgrenzen weitergeleitet werden. Dieses Protokoll geht von einem unzuverlässigen Netzwerk und mehreren Pfaden zum selben Ziel aus, zwischen denen es dynamisch wechseln kann. Es gibt eine Reihe unterschiedlicher Implementierungen des Protokolls. Die heute am weitesten verbreitete Implementierung ist IPv4, obwohl IPv6 als Alternative aufgrund der Knappheit verfügbarer IPv4-Adressen und verbesserter Protokollfunktionen immer beliebter wird.

ICMP: Internet Control Message Protocol wird zum Senden von Nachrichten zwischen Geräten verwendet, um die Verfügbarkeit oder Fehlerbedingungen anzuzeigen. Diese Pakete werden in verschiedenen Netzwerkdiagnosetools wie Ping und Traceroute verwendet. Normalerweise werden ICMP-Pakete übertragen, wenn ein Paket einer anderen Art auf ein Problem stößt. Grundsätzlich werden sie als Feedback-Mechanismus für die Netzwerkkommunikation verwendet.

TCP: Das Übertragungskontrollprotokoll ist in der Transportschicht des IP/TCP-Modells implementiert und dient dem Aufbau zuverlässiger Verbindungen. TCP ist eines der Protokolle, das Daten in Pakete kapselt. Anschließend überträgt es diese mithilfe der auf den unteren Schichten verfügbaren Methoden an das entfernte Ende der Verbindung. Auf der anderen Seite kann es auf Fehler prüfen, das erneute Senden bestimmter Teile anfordern und die Informationen wieder zu einem logischen Teil zusammensetzen, um ihn an die Anwendungsschicht zu senden. Das Protokoll baut vor der Datenübertragung mithilfe eines Systems namens Drei-Wege-Handshake eine Verbindung auf. Auf diese Weise können die beiden Enden der Kommunikation die Anfrage bestätigen und sich auf eine Methode zur Gewährleistung der Datenzuverlässigkeit einigen. Nachdem die Daten gesendet wurden, wird die Verbindung mithilfe eines ähnlichen Vier-Wege-Handshakes abgebaut. TCP ist das Protokoll der Wahl für viele der beliebtesten Internetanwendungen, darunter WWW, FTP, SSH und E-Mail. Man kann mit Sicherheit sagen, dass es das Internet, wie wir es heute kennen, ohne TCP nicht gäbe.

UDP: Das User Datagram Protocol ist ein beliebtes Begleitprotokoll zu TCP und wird auch in der Transportschicht implementiert. Der grundlegende Unterschied zwischen UDP und TCP besteht darin, dass UDP eine unzuverlässige Datenübertragung bietet. Es wird nicht überprüft, ob am anderen Ende der Verbindung Daten empfangen wurden. Das hört sich vielleicht nach einer schlechten Sache an, und aus vielen Gründen ist es das auch. Für einige Funktionen ist es jedoch auch äußerst wichtig. Es ist nicht erforderlich, auf die Bestätigung zu warten, dass die Daten empfangen wurden, und dann zum erneuten Senden der Daten gezwungen zu werden. UDP ist viel schneller als TCP. Es stellt keine Verbindung mit dem Remote-Host her, sondern leitet die Daten einfach an diesen Host weiter und kümmert sich nicht darum, ob sie akzeptiert werden oder nicht. Da es sich bei UDP um eine einfache Transaktion handelt, eignet es sich für einfache Kommunikationen wie die Abfrage von Netzwerkressourcen. Außerdem behält es keinen Status bei, was es ideal für die Übertragung von Daten von einem Computer an viele Echtzeit-Clients macht. Dies macht es ideal für VOIP, Spiele und andere Anwendungen, die sich keine Verzögerungen leisten können.

HTTP: Hypertext Transfer Protocol ist ein in der Anwendungsschicht definiertes Protokoll, das die Grundlage für die Kommunikation im Web bildet. HTTP definiert eine Reihe von Funktionen, die dem Remote-System mitteilen, was Sie anfordern. Beispielsweise interagieren GET, POST und DELETE alle auf unterschiedliche Weise mit den angeforderten Daten.

FTP: Das Dateiübertragungsprotokoll befindet sich auf der Anwendungsebene und bietet eine Möglichkeit, vollständige Dateien von einem Host auf einen anderen zu übertragen. Da es von Natur aus unsicher ist, wird es nicht für externe Netzwerke empfohlen, es sei denn, es wird als öffentliche, nur herunterladbare Ressource implementiert.

DNS: Domain Name System ist ein Protokoll auf Anwendungsebene, das einen benutzerfreundlichen Benennungsmechanismus für Internetressourcen bereitstellt. Dadurch wird ein Domänenname mit einer IP-Adresse verknüpft und Sie können in Ihrem Browser namentlich auf Websites zugreifen.

SSH: Secure Shell ist ein verschlüsseltes Protokoll, das in der Anwendungsschicht implementiert ist und für die sichere Kommunikation mit einem Remote-Server verwendet werden kann. Aufgrund seiner Ende-zu-Ende-Verschlüsselung und Allgegenwärtigkeit basieren viele weitere Technologien auf diesem Protokoll. Es gibt viele andere Protokolle, die wir nicht behandelt haben und die ebenso wichtig sind. Dies sollte Ihnen jedoch einen guten Überblick über einige der grundlegenden Technologien geben, die das Internet und die Vernetzung ermöglichen.

REST (REpresentational State Transfer) ist ein Architekturstil zur Bereitstellung von Standards zwischen Computersystemen im Web, der die Kommunikation zwischen Systemen erleichtert.

JSON Web Token (JWT) ist ein kompaktes URL-sicheres Mittel zur Darstellung von Ansprüchen, die zwischen zwei Parteien übertragen werden sollen. Die Ansprüche in einem JWT werden als JSON-Objekt codiert, das mit JSON Web Signature (JWS) digital signiert ist.

OAuth 2.0 ist ein Open-Source-Autorisierungsframework, das es Anwendungen ermöglicht, eingeschränkten Zugriff auf Benutzerkonten auf einem HTTP-Dienst wie Amazon, Google, Facebook, Microsoft, Twitter GitHub und DigitalOcean zu erhalten. Es funktioniert, indem es die Benutzerauthentifizierung an den Dienst delegiert, der das Benutzerkonto hostet, und Drittanbieteranwendungen autorisiert, auf das Benutzerkonto zuzugreifen.

Zurück nach oben

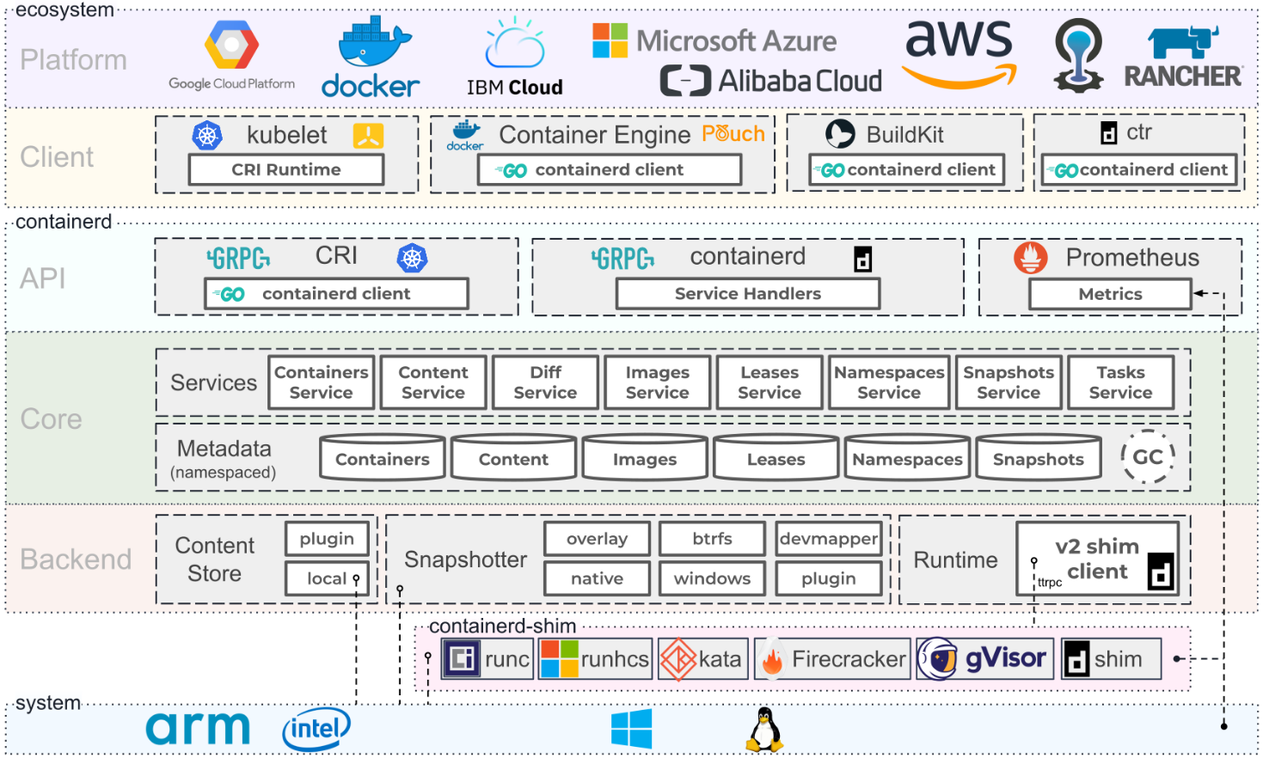

Containerarchitektur. Quelle: Containerd.io

Docker-Schulungsprogramm

Docker Certified Associate (DCA)-Zertifizierung

Docker-Dokumentation | Docker-Dokumentation

Der Docker-Workshop

Docker-Kurse auf Udemy

Docker-Kurse auf Coursera

Docker-Kurse zu edX

Docker-Kurse zu Linkedin Learning

Docker ist eine offene Plattform zum Entwickeln, Versenden und Ausführen von Anwendungen. Mit Docker können Sie Ihre Anwendungen von Ihrer Infrastruktur trennen, sodass Sie in Zusammenarbeit mit Cloud-, Linux- und Windows-Anbietern, einschließlich Microsoft, schnell Software bereitstellen können.

Docker Enterprise ist ein Abonnement inklusive Software, unterstützter und zertifizierter Containerplattform für CentOS, Red Hat Enterprise Linux (RHEL), Ubuntu, SUSE Linux Enterprise Server (SLES), Oracle Linux und Windows Server 2016 sowie für die Cloud-Anbieter AWS und Azurblau. Im November 2019 wurde das Enterprise Platform-Geschäft von Docker von Mirantis übernommen.

Docker Desktop ist eine Anwendung für MacOS- und Windows-Maschinen zum Erstellen und Teilen von Containeranwendungen und Mikrodiensten. Docker Desktop bietet die Geschwindigkeit, Auswahl und Sicherheit, die Sie zum Entwerfen und Bereitstellen von Containeranwendungen auf Ihrem Desktop benötigen. Docker Desktop umfasst die Docker-App, Entwicklertools, Kubernetes und Versionssynchronisierung mit Produktions-Docker-Engines.

Docker Hub ist die weltweit größte Bibliothek und Community für Container-Images. Durchsuchen Sie über 100.000 Container-Images von Softwareanbietern, Open-Source-Projekten und der Community.

Docker Compose ist ein Tool, das entwickelt wurde, um beim Definieren und Teilen von Multi-Container-Anwendungen zu helfen. Mit Docker Compose können Sie eine YAML-Datei erstellen, um die Dienste zu definieren, und mit einem einzigen Befehl alles hochfahren oder herunterfahren.

Docker Swarm ist ein Docker-natives Clustering-System. Swarm ist ein einfaches Tool, das einen Cluster von Docker-Hosts steuert und ihn als einzelnen „virtuellen“ Host verfügbar macht.

Dockerfile ist ein Textdokument, das alle Befehle enthält, die ein Benutzer in der Befehlszeile aufrufen könnte, um ein Bild zusammenzustellen. Mithilfe von Docker Build können Benutzer einen automatisierten Build erstellen, der mehrere Befehlszeilenanweisungen nacheinander ausführt.

Docker Containers ist eine Standardsoftwareeinheit, die Code und alle seine Abhängigkeiten bündelt, sodass die Anwendung schnell und zuverlässig von einer Computerumgebung in eine andere ausgeführt werden kann.

Docker Engine ist eine Container-Laufzeitumgebung, die auf verschiedenen Linux- (CentOS, Debian, Fedora, Oracle Linux, RHEL, SUSE und Ubuntu) und Windows Server-Betriebssystemen läuft. Docker erstellt einfache Tools und einen universellen Verpackungsansatz, der alle Anwendungsabhängigkeiten in einem Container bündelt, der dann auf der Docker Engine ausgeführt wird.

Docker Images ist ein leichtes, eigenständiges, ausführbares Softwarepaket, das alles enthält, was zum Ausführen einer Anwendung erforderlich ist: Code, Laufzeit, Systemtools, Systembibliotheken und Einstellungen. Bilder verfügen über Zwischenschichten, die die Wiederverwendbarkeit erhöhen, die Festplattennutzung verringern und die Docker-Erstellung beschleunigen, indem sie die Zwischenspeicherung jedes Schritts ermöglichen. Diese Zwischenebenen werden standardmäßig nicht angezeigt. Die GRÖSSE ist der kumulierte Speicherplatz, den das Bild und alle seine übergeordneten Bilder einnehmen.

Docker Network ist ein Netzwerk, das detaillierte Informationen zu einem oder mehreren Netzwerken anzeigt.

Docker Daemon ist ein Dienst, der von einem Systemdienstprogramm gestartet wird, nicht manuell von einem Benutzer. Dies erleichtert das automatische Starten von Docker beim Neustart der Maschine. Der Befehl zum Starten von Docker hängt von Ihrem Betriebssystem ab. Derzeit läuft es nur unter Linux, da es von einer Reihe von Linux-Kernelfunktionen abhängt. Es gibt jedoch einige Möglichkeiten, Docker auch unter MacOS und Windows auszuführen, indem Sie die Dienstprogramme des Betriebssystems konfigurieren.

Docker Storage ist ein Treiber, der steuert, wie Bilder und Container auf Ihrem Docker-Host gespeichert und verwaltet werden.

Kitematic ist eine einfache Anwendung zur Verwaltung von Docker-Containern auf Mac, Linux und Windows, mit der Sie Ihre App-Container über eine grafische Benutzeroberfläche (GUI) steuern können.

Die Open Container Initiative ist eine offene Governance-Struktur mit dem ausdrücklichen Ziel, offene Industriestandards rund um Containerformate und Laufzeiten zu schaffen.

Buildah ist ein Befehlszeilentool zum Erstellen von OCI-Images (Open Container Initiative). Es kann mit Docker, Podman, Kubernetes verwendet werden.

Podman ist ein daemonloses, quelloffenes, natives Linux-Tool, das das Suchen, Ausführen, Erstellen, Teilen und Bereitstellen von Anwendungen mithilfe von Containern und Container-Images der Open Containers Initiative (OCI) erleichtert. Podman bietet eine Befehlszeilenschnittstelle (CLI), die jedem vertraut ist, der die Docker Container Engine verwendet hat.

Containerd ist ein Daemon, der den gesamten Containerlebenszyklus seines Hostsystems verwaltet, von der Bildübertragung und -speicherung über die Containerausführung und -überwachung bis hin zur Low-Level-Speicherung, Netzwerkanbindungen und darüber hinaus. Es ist für Linux und Windows verfügbar.

Zurück nach oben

Kubernetes (K8s) ist ein Open-Source-System zur Automatisierung der Bereitstellung, Skalierung und Verwaltung von Containeranwendungen.

Kubernetes-Zertifizierungen erhalten

Erste Schritte mit Kubernetes auf AWS

Kubernetes auf Microsoft Azure

Einführung in den Azure Kubernetes Service

Azure Red Hat OpenShift

Erste Schritte mit Google Cloud

Erste Schritte mit Kubernetes auf Red Hat

Erste Schritte mit Kubernetes auf IBM

Red Hat OpenShift in der IBM Cloud

Aktivieren Sie die OpenShift-Virtualisierung auf Red Hat OpenShift

YAML-Grundlagen in Kubernetes

Elastic Cloud auf Kubernetes

Docker und Kubernetes

Ausführen von Apache Spark auf Kubernetes

Kubernetes in VMware vRealize Automation

VMware Tanzu Kubernetes Grid

Alle Möglichkeiten, wie VMware Tanzu mit AWS funktioniert

VMware Tanzu-Ausbildung

Verwendung von Ansible in einer Cloud-nativen Kubernetes-Umgebung

Verwalten von Kubernetes (K8s)-Objekten mit Ansible

Einrichten eines Kubernetes-Clusters mit Vagrant und Ansible

Ausführen von MongoDB mit Kubernetes

Kubernetes Fluentd

Den neuen GitLab Kubernetes Agent verstehen

Einführung in den lokalen Prozess mit Kubernetes für Visual Studio 2019

Kubernetes-Mitwirkende

KubeAcademy von VMware

Kubernetes-Tutorials von Pulumi

Kubernetes Playground von Katacoda

Kurs „Skalierbare Microservices mit Kubernetes“ von Udacity

Die Open Container Initiative ist eine offene Governance-Struktur mit dem ausdrücklichen Ziel, offene Industriestandards rund um Containerformate und Laufzeiten zu schaffen.

Buildah ist ein Befehlszeilentool zum Erstellen von OCI-Images (Open Container Initiative). Es kann mit Docker, Podman, Kubernetes verwendet werden.

Podman ist ein daemonloses, quelloffenes, natives Linux-Tool, das das Suchen, Ausführen, Erstellen, Teilen und Bereitstellen von Anwendungen mithilfe von Containern und Container-Images der Open Containers Initiative (OCI) erleichtert. Podman bietet eine Befehlszeilenschnittstelle (CLI), die jedem vertraut ist, der die Docker Container Engine verwendet hat.

Containerd ist ein Daemon, der den gesamten Containerlebenszyklus seines Hostsystems verwaltet, von der Bildübertragung und -speicherung über die Containerausführung und -überwachung bis hin zur Low-Level-Speicherung, Netzwerkanbindungen und darüber hinaus. Es ist für Linux und Windows verfügbar.

Google Kubernetes Engine (GKE) ist eine verwaltete, produktionsbereite Umgebung zum Ausführen von Containeranwendungen.

Azure Kubernetes Service (AKS) ist serverloses Kubernetes mit integrierter Continuous Integration und Continuous Delivery (CI/CD) sowie Sicherheit und Governance auf Unternehmensniveau. Vereinen Sie Ihre Entwicklungs- und Betriebsteams auf einer einzigen Plattform, um Anwendungen schnell und zuverlässig zu erstellen, bereitzustellen und zu skalieren.

Amazon EKS ist ein Tool, das Kubernetes-Steuerungsebeneninstanzen über mehrere Availability Zones hinweg ausführt, um eine hohe Verfügbarkeit sicherzustellen.

AWS Controllers for Kubernetes (ACK) ist ein neues Tool, mit dem Sie AWS-Dienste direkt von Kubernetes aus verwalten können. ACK macht es einfach, skalierbare und hochverfügbare Kubernetes-Anwendungen zu erstellen, die AWS-Dienste nutzen.

Container Engine for Kubernetes (OKE) ist ein von Oracle verwalteter Container-Orchestrierungsdienst, der den Zeit- und Kostenaufwand für die Erstellung moderner Cloud-nativer Anwendungen reduzieren kann. Im Gegensatz zu den meisten anderen Anbietern bietet Oracle Cloud Infrastructure Container Engine für Kubernetes als kostenlosen Service an, der auf leistungsfähigeren und kostengünstigeren Rechnern ausgeführt wird.

Anthos ist eine moderne Anwendungsverwaltungsplattform, die ein konsistentes Entwicklungs- und Betriebserlebnis für Cloud- und lokale Umgebungen bietet.

Red Hat Openshift ist eine vollständig verwaltete Kubernetes-Plattform, die eine Grundlage für lokale, Hybrid- und Multicloud-Bereitstellungen bietet.

OKD ist eine Community-Distribution von Kubernetes, die für die kontinuierliche Anwendungsentwicklung und die mandantenfähige Bereitstellung optimiert ist. OKD fügt zusätzlich zu Kubernetes entwickler- und betriebsorientierte Tools hinzu, um eine schnelle Anwendungsentwicklung, einfache Bereitstellung und Skalierung sowie eine langfristige Lebenszykluswartung für kleine und große Teams zu ermöglichen.

Odo ist ein schnelles, iteratives und unkompliziertes CLI-Tool für Entwickler, die Anwendungen auf Kubernetes und OpenShift schreiben, erstellen und bereitstellen.

Kata Operator ist ein Operator, der das Lebenszyklusmanagement (Installation/Upgrade/Deinstallation) von Kata Runtime auf Openshift und Kubernetes-Clustern durchführt.

Thanos ist eine Reihe von Komponenten, die zu einem hochverfügbaren Metriksystem mit unbegrenzter Speicherkapazität zusammengestellt werden können, das nahtlos zu bestehenden Prometheus-Bereitstellungen hinzugefügt werden kann.

OpenShift Hive ist ein Operator, der als Dienst auf Kubernetes/OpenShift läuft. Der Hive-Dienst kann zur Bereitstellung und Erstkonfiguration von OpenShift 4-Clustern verwendet werden.

Rook ist ein Tool, das verteilte Speichersysteme in selbstverwaltende, selbstskalierende und selbstheilende Speicherdienste verwandelt. Es automatisiert die Aufgaben eines Speicheradministrators: Bereitstellung, Bootstrapping, Konfiguration, Bereitstellung, Skalierung, Upgrades, Migration, Notfallwiederherstellung, Überwachung und Ressourcenverwaltung.

VMware Tanzu ist eine zentralisierte Verwaltungsplattform für den konsistenten Betrieb und die Sicherung Ihrer Kubernetes-Infrastruktur und modernen Anwendungen über mehrere Teams und private/öffentliche Clouds hinweg.

Kubespray ist ein Tool, das Kubernetes und Ansible kombiniert, um Kubernetes-Cluster einfach zu installieren, die auf AWS, GCE, Azure, OpenStack, vSphere, Packet (Bare Metal), Oracle Cloud Infrastructure (Experimental) oder Baremetal bereitgestellt werden können.

KubeInit stellt Ansible-Playbooks und -Rollen für die Bereitstellung und Konfiguration mehrerer Kubernetes-Distributionen bereit.

Rancher ist ein kompletter Software-Stack für Teams, die Container einführen. Es bewältigt die betrieblichen und sicherheitstechnischen Herausforderungen bei der Verwaltung mehrerer Kubernetes-Cluster und stellt DevOps-Teams gleichzeitig integrierte Tools für die Ausführung von Container-Workloads zur Verfügung.

K3s ist eine hochverfügbare, zertifizierte Kubernetes-Distribution, die für Produktions-Workloads an unbeaufsichtigten, ressourcenbeschränkten, entfernten Standorten oder innerhalb von IoT-Geräten entwickelt wurde.

Helm ist ein Kubernetes Package Manager-Tool, das die Installation und Verwaltung von Kubernetes-Anwendungen erleichtert.

Knative ist eine Kubernetes-basierte Plattform zum Erstellen, Bereitstellen und Verwalten moderner serverloser Workloads. Knative kümmert sich um die operativen Overhead-Details der Vernetzung, der automatischen Skalierung (sogar auf Null) und der Revisionsverfolgung.

KubeFlow ist ein Tool, das die Bereitstellung von Arbeitsabläufen für maschinelles Lernen (ML) auf Kubernetes einfach, portierbar und skalierbar macht.

Etcd ist ein verteilter Schlüsselwertspeicher, der eine zuverlässige Möglichkeit zum Speichern von Daten bietet, auf die ein verteiltes System oder ein Cluster von Maschinen zugreifen muss. Etcd wird als Backend für die Serviceerkennung verwendet und speichert den Clusterstatus und die Konfiguration für Kubernetes.

OpenEBS ist ein Kubernetes-basiertes Tool zum Erstellen zustandsbehafteter Anwendungen mithilfe von Container Attached Storage.

Container Storage Interface (CSI) ist eine API, die es Container-Orchestrierungsplattformen wie Kubernetes ermöglicht, über ein Plug-in nahtlos mit gespeicherten Daten zu kommunizieren.

MicroK8s ist ein Tool, das das volle Kubernetes-Erlebnis bietet. In einer vollständig containerisierten Bereitstellung mit komprimierten Over-the-Air-Updates für äußerst zuverlässigen Betrieb. Es wird unter Linux, Windows und MacOS unterstützt.

Charmed Kubernetes ist eine gut integrierte, schlüsselfertige und konforme Kubernetes-Plattform, die von Canonical für Ihre Multi-Cloud-Umgebungen optimiert wurde.

Die Grafana Kubernetes App ist eine kostenpflichtige App, mit der Sie die Leistung Ihres Kubernetes-Clusters überwachen können. Es umfasst 4 Dashboards: Cluster, Knoten, Pod/Container und Bereitstellung. Es ermöglicht die automatische Bereitstellung der erforderlichen Prometheus-Exporteure und eine Standard-Scrape-Konfiguration zur Verwendung mit Ihrer Prometheus-Bereitstellung im Cluster.

KubeEdge ist ein Open-Source-System zur Erweiterung der nativen Orchestrierungsfunktionen für Containeranwendungen auf Hosts bei Edge. Es basiert auf Kubernetes und bietet grundlegende Infrastrukturunterstützung für Netzwerke und Anwendungen. Bereitstellung und Metadatensynchronisierung zwischen Cloud und Edge.

Lens ist die leistungsstärkste IDE für Menschen, die täglich mit Kubernetes-Clustern zu tun haben. Es unterstützt die Betriebssysteme MacOS, Windows und Linux.

Flux CD ist ein Tool, das automatisch sicherstellt, dass der Status Ihres Kubernetes-Clusters mit der Konfiguration übereinstimmt, die Sie in Git angegeben haben. Es nutzt einen Operator im Cluster, um Bereitstellungen innerhalb von Kubernetes auszulösen, was bedeutet, dass Sie kein separates Continuous-Delivery-Tool benötigen.

Platform9 Managed Kubernetes (PMK) ist ein Kubernetes-as-a-Service, der einen vollständig automatisierten Day-2-Betrieb mit 99,9 % SLA in jeder Umgebung gewährleistet, sei es in Rechenzentren, öffentlichen Clouds oder am Edge.

Zurück nach oben

Mac Development Ansible Playbook von Jeff Geerling

Ansible ist eine einfache IT-Automatisierungs-Engine, die Cloud-Bereitstellung, Konfigurationsmanagement, Anwendungsbereitstellung, Intra-Service-Orchestrierung und viele andere IT-Anforderungen automatisiert. Es verwendet eine sehr einfache Sprache (YAML, in Form von Ansible Playbooks), die es Ihnen ermöglicht, Ihre Automatisierungsaufgaben auf eine Weise zu beschreiben, die an einfaches Englisch herankommt. Anisble funktioniert unter Linux (Red Hat EnterPrise Linux (RHEL) und Ubuntu) und Microsoft Windows.

Red Hat-Schulung für Ansible

Die besten Ansible-Kurse online von Udemy

Einführung in Ansible: Die Grundlagen auf Coursera

Erlernen der Ansible-Grundlagen auf Pluralsight

Einführung der Red Hat Ansible Automation Platform 2.1

Ansible-Dokumentation

Ansible Galaxy-Benutzerhandbuch

Ansible-Anwendungsfälle

Ansible-Integrationen

Übersicht über die Ansible-Sammlungen

Arbeiten mit Spielbüchern

Ansible für DevOps-Beispiele von Jeff Geerling

Erste Schritte: Schreiben Ihres ersten Playbooks – Ansible

Arbeiten mit Modulen in Ansible

Ansible Best Practices: Rollen und Module

Arbeiten mit Befehlszeilentools für Ansible

Inhalte mit Ansible Vault verschlüsseln

Verwendung von Vault in Playbooks mit Ansible

Verwendung von Ansible mit Azure

Konfigurieren von Ansible auf einer Azure-VM

Verwendung von Ansible: Ein Ansible Cheat Sheet von Digitalocean

Einführung in Ansible auf Linode | Raumlabors

Ansible Automation Hub ist der offizielle Ort, an dem unterstützte Sammlungen entdeckt und heruntergeladen werden können, die als Teil eines Abonnements der Ansible Automation Platform enthalten sind. Diese Inhaltskollektionen enthalten Module, Plugins, Rollen und Playbooks in einem herunterladbaren Paket.

Sammlungen sind ein Verteilungsformat für Ansible -Inhalte, die Playbooks, Rollen, Module und Plugins umfassen können. Wenn sich Module vom Kern -Ansible -Repository in Sammlungen bewegen, wechselt die Moduldokumentation auf die Sammlungsseiten.

Ansible Lint ist ein Befehlszeilen-Tool zum Linken von Playbooks, Rollen und Sammlungen, die auf Ansible-Benutzer abzielen. Das Hauptziel ist es, bewährte Praktiken, Muster und Verhaltensweisen zu fördern und gleichzeitig häufige Fallstricke zu vermeiden, die leicht zu Fehlern führen oder Code schwerer machen können.

Ansible CMDB ist ein Tool, das die Ausgabe der Tatsache von Ansible aufnimmt, sie zu sammeln und in eine statische HTML -Übersichtsseite mit Systemkonfigurationsinformationen umzuwandeln.

Ansible Inventory Graph zeigt visuell Inventar -Vererbungshierarchien und auf welcher Ebene eine Variable im Inventar definiert ist.

Ansible Playbook Graph ist ein Befehlszeilen -Tool zum Erstellen eines Diagramms, das Ihre Ansible Playbook -Aufgaben und -Rollen darstellt.

Ansible Shell ist eine interaktive Shell für Ansible mit integrierter Registerkartenabschluss für alle Module.

Ansible Silo ist eine in sich geschlossene Umgebung von Docker.

Ansimenom ist ein Befehlszeilen -Tool, mit dem Sie Ihre Ansible -Rollen verwalten können.

ARA ist ein Aufzeichnungsaufzeichnungs -Playbook läuft und stellt die aufgezeichneten Daten für Benutzer und Systeme verfügbar und intuitiv, indem sie sich in ANSIBLE als Callback -Plugin integrieren.

Capistrano ist ein Remote -Server -Automatisierungswerkzeug. Es unterstützt die Skript- und Ausführung willkürlicher Aufgaben und enthält eine Reihe von Workflows für Default-Bereitstellungen.

Fabric ist eine hochrangige Python -Bibliothek (2,7, 3,4+), mit der Shell -Befehle remote über SSH ausgeführt werden und nützliche Python -Objekte im Gegenzug liefert. Es erstellt auf Invoke (Subprocess-Befehlsausführung und Befehlszeilenfunktionen) und Paramiko (SSH-Protokollimplementierung), wodurch sich die APIs umeinander ausdehnen und zusätzliche Funktionen liefert.

Ansible-Role-Wire-Guard ist eine Ansible-Rolle für die Installation von Drahtguard VPN. Unterstützt Ubuntu, Debian, Archlinx, Fedora und Centos Stream.

WireGuard_Cloud_Gateway ist eine ansible Rolle für die Einrichtung von Drahtguard als Gateway VPN -Server für Cloud -Netzwerke.

Red Hat OpenShift konzentriert sich auf die Sicherheit auf jeder Ebene des Containerstapels und im gesamten Anwendungslebenszyklus. Es beinhaltet eine langfristige Unterstützung von Unternehmen von einem der führenden Kubernetes-Mitwirkenden und Open-Source-Softwareunternehmen.

OpenShift Hive ist ein Bediener, der als Service auf Kubernetes/OpenShift läuft. Der Hive -Service kann verwendet werden, um die anfängliche Konfiguration von OpenShift 4 -Clustern bereitzustellen und durchzuführen.

Zurück nach oben

SQL ist eine Standardsprache zum Speichern, Manipulieren und Abrufen von Daten in relationalen Datenbanken.

NoSQL ist eine Datenbank, die austauschbar als "nicht relational oder" nicht-SQL "bezeichnet wird, um hervorzuheben, dass die Datenbank große Mengen schnell ändern .

Transact-SQL (T-SQL) ist eine Microsoft-Erweiterung von SQL mit allen Tools und Anwendungen, die an eine SQL-Datenbank kommunizieren, indem T-SQL-Befehle gesendet werden.

Einführung in Transact-SQL

SQL Tutorial von W3Schools

Lernen Sie SQL -Fähigkeiten online von Coursera kennen

SQL -Kurse online von udemy

SQL Online -Schulungskurse von LinkedIn Learning

Lerne SQL kostenlos aus Codecademy

Gitlabs SQL Style Guide

Oracledb SQL Style Guide Grundlagen

Tableau CRM: BI -Software und Tools

Datenbanken auf AWS

Best Practices und Empfehlungen für SQL Server -Clustering in AWS EC2.

Verbindung von Google Kubernetes Engine mit einer Cloud -SQL -Instanz.

Pädagogische Microsoft Azure SQL -Ressourcen

MySQL -Zertifizierungen

SQL vs. NoSQL -Datenbanken: Was ist der Unterschied?

Was ist NoSQL?

NetData ist eine Überwachung und Fehlerbehebung in der Infrastruktur in der Infrastruktur und der Fehlerbehebung, Echtzeit-Überwachungsagent sammelt Tausende von Metriken aus Systemen, Hardware, Containern und Anwendungen ohne Konfiguration. Es wird dauerhaft auf all Ihren physischen/virtuellen Servern, Containern, Cloud-Bereitstellungen und Edge-/IoT-Geräten ausgeführt. Ohne Vorbereitung ist es mit Mitte des Unfalls auf Ihren Systemen sicher.

Azure Data Studio ist ein Open -Source -Datenverwaltungs -Tool, mit dem die Arbeit mit SQL Server, Azure SQL DB und SQL DW von Windows, MacOS und Linux gearbeitet werden kann.

RSTUDIO ist eine integrierte Entwicklungsumgebung für R und Python mit einer Konsole, einer Syntax-Highlighting-Editor, die die direkte Codeausführung und Tools für das Verschwören, die Geschichte, das Debugging und die Arbeitsspanne unterstützt.

MySQL ist ein vollständig verwalteter Datenbankdienst, mit dem Cloud-native Anwendungen mithilfe der weltweit beliebtesten Open-Source-Datenbank bereitgestellt werden können.

PostgreSQL ist ein leistungsstarkes Open-Source-Objekt-Relationsdatenbanksystem mit über 30 Jahren aktiver Entwicklung, das es zu einem starken Ruf für Zuverlässigkeit, Robustheit und Leistung erzielt hat.

Amazon DynamoDB ist eine Schlüsselwert- und Dokumentendatenbank, die eine einstellige Millisekundenleistung in jeder Skala liefert. Es handelt sich um eine vollständig verwaltete, multiregion-, multimaster-, langlebige Datenbank mit integrierten Sicherheit, Sicherung und Wiederherstellung und In-Memory-Caching für Anwendungen im Internetmaßstab.

Apache Cassandra ™ ist eine Open -Source -NoSQL -verteilte Datenbank, die von Tausenden von Unternehmen für Skalierbarkeit und hohe Verfügbarkeit vertraut ist, ohne die Leistung zu beeinträchtigen. Cassandra bietet lineare Skalierbarkeit und nachgewiesene Fehlertoleranz gegenüber Rohstoffhardware oder Cloud-Infrastruktur zur perfekten Plattform für missionskritische Daten.

Apache Hbase ™ ist ein verteilter Big-Data-Store von Open-Source, NoSQL. Es ermöglicht zufälligen, streng konsistenten Echtzeitzugriff auf Petabyte von Daten. HBase ist sehr effektiv für die Behandlung großer, spärlicher Datensätze. HBase dient als direkte Eingabe und Ausgabe für das Apache MapReduce-Framework für Hadoop und arbeitet mit Apache Phoenix zusammen, um SQL-ähnliche Abfragen über HBase-Tabellen zu ermöglichen.

Hadoop Distributed Dateisystem (HDFS) ist ein verteiltes Dateisystem, das große Datensätze übernimmt, die auf Warenhardware ausgeführt werden. Es wird verwendet, um einen einzelnen Apache -Hadoop -Cluster auf Hunderte (und sogar Tausende) Knoten zu skalieren. HDFS ist eine der Hauptkomponenten von Apache Hadoop, die anderen sind MapReduce und Garn.

Apache Mesos ist ein Cluster -Manager, der eine effiziente Ressourcenisolierung und -heilung über verteilte Anwendungen oder Frameworks bietet. Es kann Hadoop, Jenkins, Spark, Aurora und andere Frameworks auf einem dynamisch gemeinsam genutzten Knotenpool ausführen.

Apache Spark ist eine einheitliche Analyse-Engine für die Big-Data-Verarbeitung mit integrierten Modulen für Streaming, SQL, maschinelles Lernen und Diagrammverarbeitung.

Elasticsearch ist eine Suchmaschine, die auf der Lucene -Bibliothek basiert. Es bietet eine verteilte, multitenant-fähige Volltext-Suchmaschine mit einer HTTP-Weboberfläche und schemafreien JSON-Dokumenten. Elasticsearch wird in Java entwickelt.

Logstash ist ein Tool zum Verwalten von Ereignissen und Protokollen. Bei allgemeiner Anwendung umfasst der Begriff ein größeres System der Protokollabwicklung, Verarbeitung, Speicherung und Suchaktivitäten.

Kibana ist ein Open -Source -Datenvisualisierungs -Plugin für Elasticsearch. Es bietet Visualisierungsfunktionen zusätzlich zu dem in einem Elasticsearch -Cluster indizierten Inhalt. Benutzer können eine Bar erstellen,