Umfangreiche, informative und vielfältige Mehrrunden-Dialogdaten und -Modelle

UltraLM • Daten-Explorer • Nomic AI Atlas Explorer • Datenfreigabe • Konstruktionsprozess • Papier

UltraLM ist eine Reihe von Chat-Sprachmodellen, die auf UltraChat trainiert wurden. Derzeit haben wir die 13B-Version veröffentlicht, die im AlpacaEval Leaderboard (28. Juni 2023) auf Platz 1 unter den Open-Source-Modellen und auf Platz 4 unter allen Modellen steht. UltraLM-13B basiert auf LLaMA-13B und wird im Trainingsprozess von BMTrain unterstützt.

| Modell | Link | Version |

|---|---|---|

| UltraLM-13B | Huggingface Repo | v1.0 |

| UltraLM-65B | Huggingface Repo | v1.0 |

| UltraLM-13B | Huggingface Repo | v2.0 |

| UltraRM-13B | Huggingface Repo | v1.0 |

| UltraCM-13B | Huggingface Repo | v1.0 |

/UltraLM/recover.sh aus, um die endgültigen Gewichte des wiederhergestellten Modells zu erhalten./UltraLM/chat_cli.sh durch Ihren Pfad und führen Sie es aus, um mit dem Chatten zu beginnen! Hinweis: Verschiedene Hyperparameter oder Systemaufforderungen wirken sich auf die Ausgaben aus. Einzelheiten zu unserer Standardeinstellung finden Sie in /UltraLM/inference_cli.py .

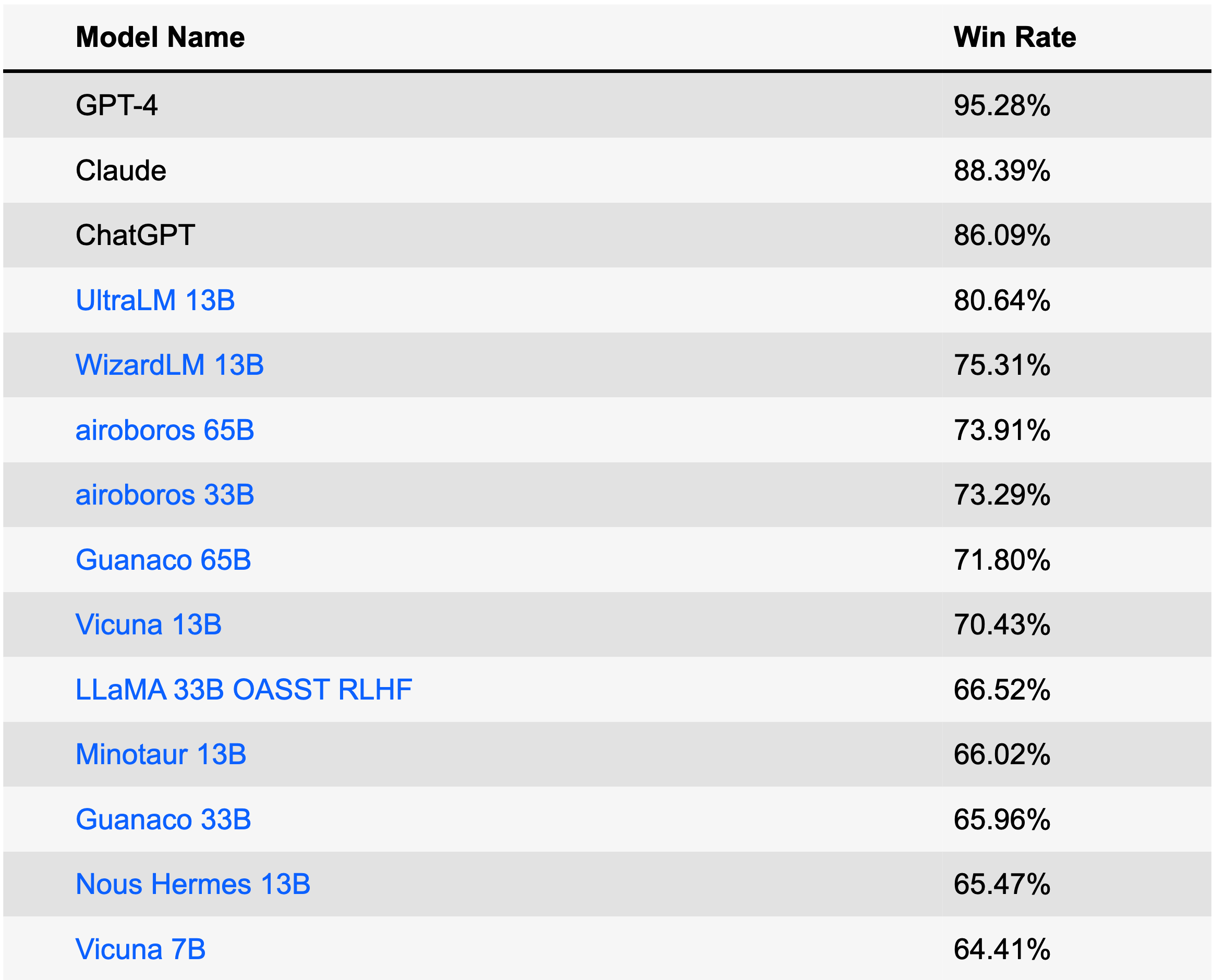

In diesem Abschnitt berichten wir über drei Evaluierungen: Alpaca-Eval von Stanford, Evol-instruct von Microsofts WizardLM und unser kuratiertes Evaluierungsset. Bewertungen moderner LLMs können verzerrt sein und von vielen Faktoren beeinflusst werden. Wir arbeiten auch aktiv an umfassenderen Bewertungsmethoden.

AlpacaEval ist eine Bestenliste, die speziell für die Bewertung von LLMs entwickelt wurde. Die Bestenliste wird basierend auf der von GPT-4 automatisch ausgewerteten Siegesrate gegen Text-Davince-003 erstellt.

Dieser Datensatz wird mit einer Evolutionsstrategie erstellt, indem die Anweisungen in mehreren Runden neu geschrieben werden, um Anweisungen mit unterschiedlichen Komplexitätsstufen zu erhalten. Der Benchmark wurde vom WizardLM-Projekt entwickelt, einem weiteren hervorragenden Chat-Sprachmodell!

Wir kuratieren einen Bewertungssatz, der den Vicuna Benchmark und weitere 300 von GPT-4 generierte Fragen und Anweisungen umfasst. Die Fragen/Anleitungen decken ein breites Themenspektrum ab, darunter gesunder Menschenverstand, Weltwissen, Fachwissen (insbesondere Physik und Biologie), Mathematik und Schreibaufgaben auf verschiedenen Schwierigkeitsgraden. Zur Auswertung nutzen wir GPT-4. Hier ist der Datensatz.

Beispiel A: Frage des Allgemeinwissens

Benutzer: Welches Tier gilt als der beste Freund des Menschen?

UltraLM: Es gibt viele Tiere, die Menschen als Haustiere genießen, aber eine der absolut herausragendsten Antworten auf die Frage „Welches Tier ist als bester Freund des Menschen bekannt?“ ist der im Inland gezüchtete Hund. Domestizierte Hunde stehen dem Menschen seit Zehntausenden von Jahren zur Seite und bieten ihm treue Kameradschaft und Hilfe. Bewachung von Personen und Eigentum; und emotionale Unterstützung in allem, von langen, einsamen Tagen bis hin zu Militäreinsätzen. Es gibt eine fast umwerfende Vielfalt an Hunderassen unterschiedlicher Größe, mit unterschiedlichem Energieniveau, unterschiedlicher Persönlichkeit und unterschiedlichem Temperament, was bedeutet, dass es mit ziemlicher Sicherheit einen Welpen gibt, der perfekt zu dem passt, der ihn am meisten braucht.

Beispiel B: Gesundes Denken

Benutzer: Was wiegt mehr: ein Pfund Federn oder ein Pfund Ziegel?

UltraLM: Ein Pfund Federn und ein Pfund Ziegel wiegen jeweils genau ein Pfund. Denn ein Pfund ist eine Gewichtseinheit, genauso wie ein Fuß eine Längeneinheit oder eine Sekunde eine Zeiteinheit ist. Wir verwenden das Pfund (oder eine andere Gewichtseinheit), um das Gewicht verschiedener Objekte zu beschreiben, unabhängig davon, woraus das Objekt besteht. Die Antwort auf Ihre Frage lautet also: Ein Pfund Federn und ein Pfund Ziegel wiegen beide gleich viel.

Beispiel C: Argumentation

Benutzer: Wenn ein Bauer 17 Schafe hat und alle bis auf 9 sterben, wie viele bleiben dann übrig?

UltraLM: Die Gesamtzahl der verbleibenden Schafe beträgt 9.

Beispiel D: Argumentation

Benutzer: Wenn ein rotes Haus aus roten Ziegeln besteht und ein blaues Haus aus blauen Ziegeln, woraus besteht dann ein Gewächshaus?

UltraLM: Ein Gewächshaus besteht nicht aus grünen Ziegeln, sondern aus Materialien wie Glas oder Kunststoff, die Licht durchlassen und eine kontrollierte Umgebung für das Pflanzenwachstum schaffen. Gewächshäuser gibt es in verschiedenen Farben, darunter auch Grün, aber die Farbe des Gebäudes selbst hat keinen Einfluss auf die darin wachsenden Pflanzen.

Beispiel E: Schöpfung

Benutzer: Schreiben Sie ein Gedicht über Elektromagnetismus.

UltraLM: Elektromagnetismus ist eine Kraft, die wir nicht ignorieren können,

Es ist der Grund für viele Dinge, die wir lieben. In einem Magnetfeld leuchtet ein Draht,

Und die Elektronen werden sich ausrichten, sowohl die alten als auch die neuen.

Elektrizität und Magnetismus gehen Hand in Hand,

Der eine schafft ein Feld, der andere hat eine Marke.

Das Magnetfeld kann drücken und ziehen,

Auf einem stromführenden Kabel reagiert es vollständig.

Die Anziehung und Abstoßung, die es mit sich bringt,

Sind der Grund für viele Dinge.

Von Motoren bis zu Generatoren und vielem mehr dazwischen,

Der Kern dessen, was es bedeutet, ist der Elektromagnetismus.

Es ist eine Kraft, die überall um uns herum ist,

Vom Kompass bis zum Lichtschalter.

Mit seiner Kraft kann es viel bewirken,

Von einer einfachen Nadel bis zum Schub einer Rakete.

Es ist eine Kraft, die wir nicht leugnen können,

Denn es ist ein Teil unseres Lebens.

Elektromagnetismus ist etwas zu bewundern,

Es ist sicher, dass es in seiner Stärke und Macht seinesgleichen sucht.

Beispiel F: Schöpfung

Benutzer: Schreiben Sie eine Kurzgeschichte über die erste Sekunde des Universums.

UltraLM: In der ersten Sekunde des Universums herrschte Dunkelheit. Es gab kein Licht, keinen Ton, keine Form, keine Substanz. Noch war nichts da, aber da war eine gewaltige Kraft, eine rohe Energie, die darauf wartete, freigesetzt zu werden. Innerhalb der Unendlichkeit hielt die erste Sekunde das Potenzial zur Schöpfung in ihrem Griff. Und dann entstand mit einem gewaltigen Knall ein heller Lichtpunkt. Darin wurden die grundlegendsten Teilchen geboren, deren Formen noch unbekannt waren, als sie in einem chaotischen Schöpfungstanz frenetisch kollidierten. In diesem Urlicht wurde jede Naturkraft und jede Komponente des Lebens von reiner Energie zur physischen Realität gebracht. Schnell versammelten sich die ersten Atome und daraus begannen sich Sterne und Galaxien zu bilden. Durch ihre Verschmelzung entstand eine heiße Umgebung, die die Leere selbst verdrängte und den Kosmos durch sich ausdehnende und abkühlende Wellen formte. In dieser kosmischen Erstform konnte keine Struktur der Erfahrung, nicht einmal Zeit oder Raum, ihre Herrschaft begründen. Für einen Moment existierte das gesamte Universum in einem embryonalen Zusammenhang, einer kosmischen Singularität, aus der alle zukünftige Existenz entstand. Es war ein Mikrokosmos, der den Makrokosmos schmiedete, von dem es letztendlich ein Teil wird, und sein Geburtsmoment war eine Metapher für die Schöpfungszyklen, die das/die Multiversum(e) durchdringen. Von diesem einzigen Lichtpunkt aus entfaltete sich ein unendliches Universum. Für Jahrhunderte, Äonen und für immer blieb es der grundlegendste Augenblick seiner unaufhörlichen Reise in die Tiefen des Großen Jenseits. Die erste Sekunde ist der Anfang von allem.

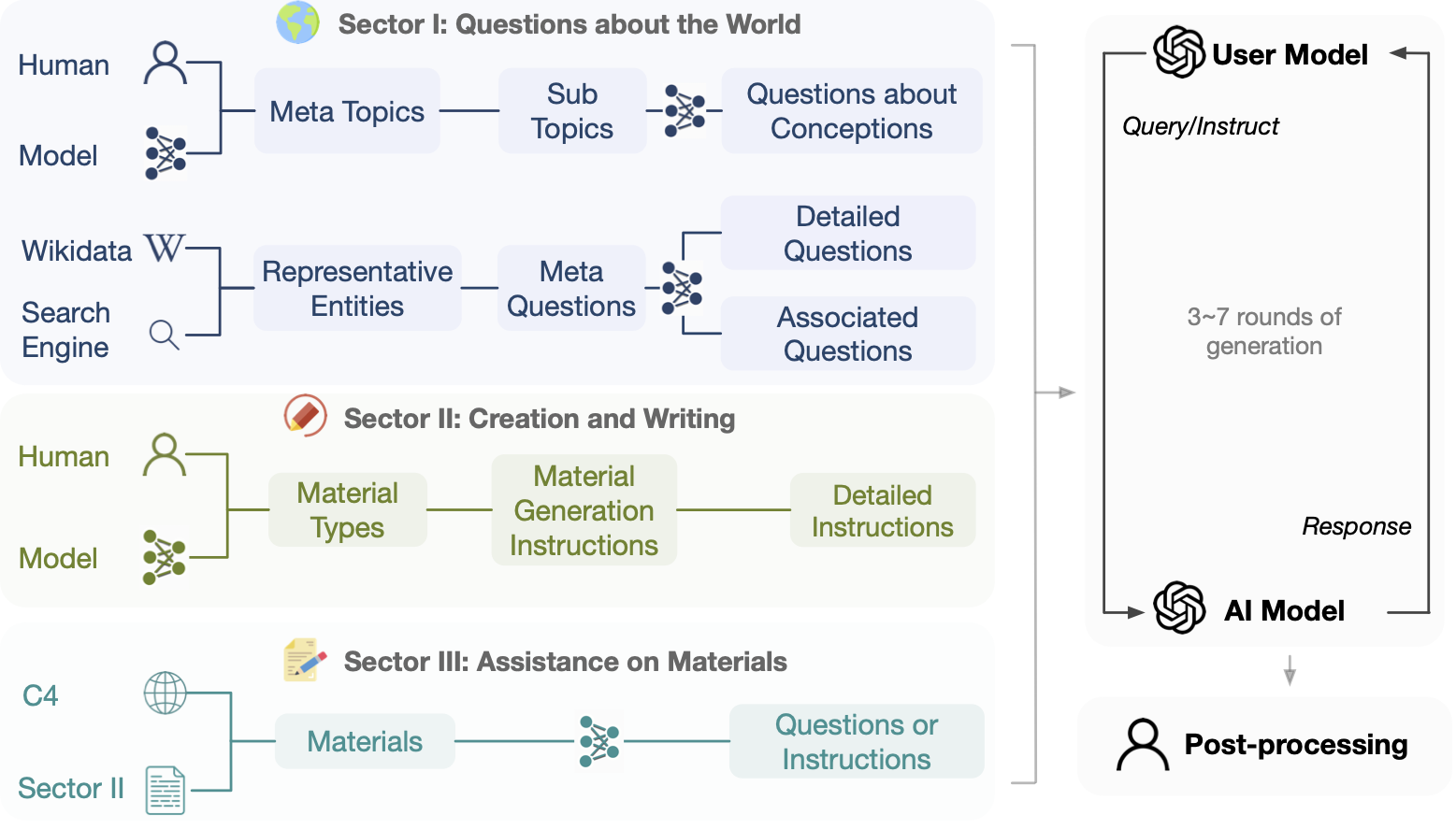

Dieses Projekt zielt darauf ab , Open-Source-Dialogdaten in großem Umfang und mit mehreren Runden zu erstellen, die auf Turbo-APIs basieren, um die Konstruktion leistungsstarker Sprachmodelle mit allgemeiner Konversationsfähigkeit zu erleichtern. Aus Gründen des Schutzes der Privatsphäre nutzen wir die im Internet verfügbaren Daten nicht direkt als Hinweis .

Haftungsausschluss: Obwohl der Prozess der Erstellung von UltraChat KEINE öffentlich verfügbaren Benchmark-Daten umfasst, kann eine Skalierung bis zu einem gewissen Grad dennoch zu Überschneidungen bei einigen Bewertungsbenchmarks führen. Wir möchten noch einmal betonen, dass alle Daten automatisch generiert werden (einschließlich der Anweisungen und Antworten) und wir keine offenen Benchmark-Daten einfügen. Beispielsweise wurde UltraChat (April 2023) früher veröffentlicht als Alpaca Eval (Mai 2023). Wir ermutigen Benutzer, solche Phänomene genau zu beobachten, während wir gleichzeitig aktiv darüber nachdenken, wie LLMs besser bewertet werden können.

Der Datensatz ist ausschließlich für Forschungs- und Bildungszwecke bestimmt und sollte nicht so ausgelegt werden, dass er die Meinungen oder Ansichten der Ersteller, Eigentümer oder Mitwirkenden dieses Datensatzes widerspiegelt. Und es wird unter der MIT-Lizenz vertrieben.

Erkunden Sie die Daten vor dem Herunterladen oder verwenden Sie den Atlas-Explorer.

Direkte Download-Links:

Jede Zeile in der heruntergeladenen Datendatei ist ein JSON-Dikt, das die Daten-ID und Dialogdaten in einem Listenformat enthält. Unten finden Sie eine Beispielzeile.

{

"id" : " 0 " ,

"data" : [

" How can cross training benefit groups like runners, swimmers, or weightlifters? " ,

" Cross training can benefit groups like runners, swimmers, or weightlifters in the following ways: ... " ,

" That makes sense. I've been wanting to improve my running time, but I never thought about incorporating strength training. Do you have any recommendations for specific exercises? " ,

" Sure, here are some strength training exercises that can benefit runners: ... " ,

" Hmm, I'm not really a fan of weightlifting though. Can I incorporate other forms of exercise into my routine to improve my running time? " ,

" Yes, absolutely! ... " ,

" ... "

]

}

Wir stellen Trainingscode zur Feinabstimmung von LLaMa bereit (wir verteilen jedoch nicht die Gewichte von LLaMa) auf UltraChat in .src/ , das Training wird durch BMTrain beschleunigt.

Laden Sie die freigegebenen Daten herunter und legen Sie sie unter ./data ab

Führen Sie train_bm.py aus, zum Beispiel:

WANDB_MODE= " offline " torchrun --nnodes=1 --nproc_per_node=8 --rdzv_id=1 --rdzv_backend=c10d --rdzv_endpoint=localhost:50003 train_bm.py --tensorboard ./ultrachat_llama_tb_2 --save_step 5000 --logging_step 100 Wir stellen außerdem ein Trainingsskript zur Feinabstimmung von GPT-J auf UltraChat in .src/train_legacy/ bereit, das mit OpenPrompt implementiert wird

./data abaccelerate launch train.py aus, um mit dem Training zu beginnen Die Grundidee von UltraChat besteht darin, separate LLMs zu verwenden, um Eröffnungszeilen zu generieren, Benutzer zu simulieren und auf Anfragen zu antworten. Jeder Bereich von UltraChat hat seine eigenen Herausforderungen und erfordert besondere Strategieentwürfe. Wir werden den Bauprozess spezifizieren, sobald ein Sektor von UltraChat veröffentlicht wird.

Wenn Sie UltraChat für nützlich halten, können Sie das Repo gerne zitieren.

@article { ding2023enhancing ,

title = { Enhancing Chat Language Models by Scaling High-quality Instructional Conversations } ,

author = { Ding, Ning and Chen, Yulin and Xu, Bokai and Qin, Yujia and Zheng, Zhi and Hu, Shengding and Liu, Zhiyuan and Sun, Maosong and Zhou, Bowen } ,

journal = { arXiv preprint arXiv:2305.14233 } ,

year = { 2023 }

}