Dies ist das Repo für das ChatPLUG-Projekt, dessen Ziel es ist, ein chinesisches Open-Domain-Dialogsystem aufzubauen und zu teilen.

| 爱用emoji的萌妹子小婉 | 富有智慧的得道高僧 | 会说古文的的三国NPC关羽 |

|---|---|---|

|  |  |

Rollenspiel-Chat

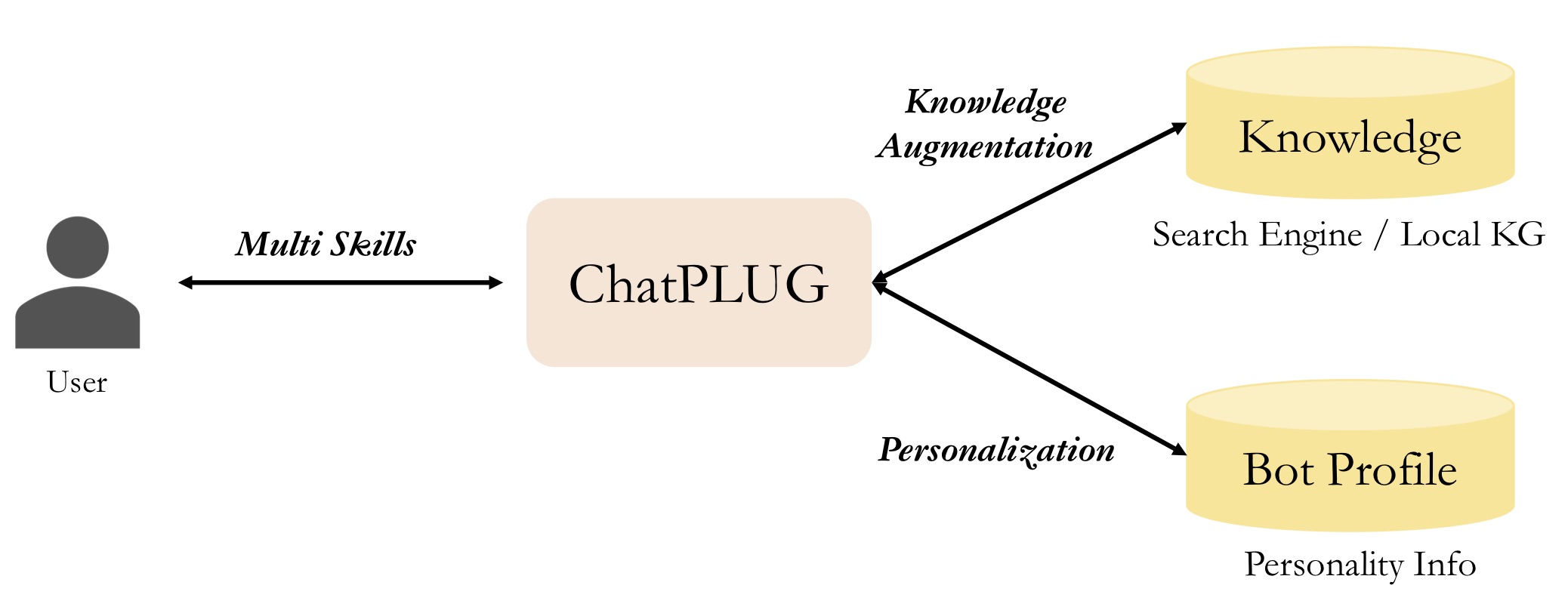

Im Vergleich zu bestehenden Open-Source-Modellen heben wir drei Merkmale von ChatPLUG wie folgt hervor:

Es ist flexibel, externes Wissen während der Inferenz zu integrieren, und dies ist eine optionale Eingabe. Sie können eine

search engineverwenden, um aktuelle Informationen zu erhalten, oder eine lokale Wissensdatenbank nutzen, um Fachwissen zu erhalten.

Es ist einfach, den Stil von Gesprächen und Charakteren anzupassen, indem Sie

bot profilesfestlegen oderrole-paly instructionsverwenden.

Es stellt seine Kompetenz im offenen Dialog durch Multi-Turn-Konversation unter Beweis und zeigt gleichzeitig beeindruckende

multi-task abilitiesbei einem breiten Spektrum von NLP-Aufgaben.

Wir bieten drei Methoden an, um ChatPLUG zu nutzen oder weiterzuentwickeln:

| Erste Schritte | Schlussfolgerung | Zug | Einsetzen | |

|---|---|---|---|---|

| ModelScope | Einfach | ✔️ Kli | Nicht bereit | Nicht bereit |

| Umarmendes Gesicht | Medium | ✔️ Kli | Nicht bereit | Nicht bereit |

| XDPX | Hart | ✔️ Kli | ✔️ Unterstützung | ✔️ Servieren |

Sie können ChatPLUG-Modelle von ModelScope herunterladen und verwenden.

| Modellname | URL |

|---|---|

| ChatPLUG-240M | ChatPLUG-开放域对话模型-240M |

| ChatPLUG-3.7B | ChatPLUG-3.7B |

Kommt bald.

XDPX ist eine benutzerfreundliche Bibliothek, die es Forschern und Entwicklern ermöglicht, benutzerdefinierte Modelle zu trainieren und eigene Chatbots auf optimierte Weise zu erstellen. Seine All-in-One-Funktionalität ermöglicht eine Komplettlösung, die komplexe Prozesse vereinfacht. Schnellstart

Wenn Sie ChatPLUG-3.7B verwenden, können Sie

core_chat_half_precision : truefestlegen, um Speicher zu sparen.

# Requirement

# in the dir of XDPX

cd XDPX

pip install -e .

# Download checkpoints

# in the same dir as the download.sh

cd ..

sh download.sh

# Inference

# in the dir of XDPX

cd XDPX

CUDA_VISIBLE_DEVICES=0 x-script fidchat_new chat_pipeline/chatplug_3.7B_sftv2.6.0_instruction.hjson

# input `#exit` and exit the terminal Wenn Ihre GPU (z. B. A100, A10) bf16 unterstützt, legen Sie

deepspeed_bf16: trueunddeepspeed_fp16: falsefest, andernfalls legen Siedeepspeed_bf16: falseunddeepspeed_fp16: truefest

# 1. Download dataset from belle

# in ChatPLUG/data/belle dir

cd data/belle

git lfs install

git clone https://huggingface.co/datasets/BelleGroup/train_0.5M_CN

python process_belle_0.5M.py

# $ls data/belle

# train_0.jsonl dev.jsonl ...

# 2. Preprocess Data

# in XDPX dir

x-prepro chat_pipeline/chatplug_prepro_sft_instruction.hjson

# $ls data/dialogue/sft/chatplug/belle_instruction

# train_0.pt dev.pt

# 3. Training

# in XDPX dir

x-train chat_pipeline/chatplug_3.7B_train_sftv2.6.0_instruction.hjsonKommt bald.

Installationsanweisungen finden Sie unter Installation.

Ausführliche Benutzerhandbücher finden Sie in unserer Dokumentation:

Benutzerhandbücher

Erweiterte Anleitungen

Wenn Sie unser Projekt für Ihre Arbeit nützlich finden, nennen Sie bitte:

@misc{tian2023chatplug,

title={ChatPLUG: Open-Domain Generative Dialogue System with Internet-Augmented Instruction Tuning for Digital Human},

author={Junfeng Tian and Hehong Chen and Guohai Xu and Ming Yan and Xing Gao and Jianhai Zhang and Chenliang Li and Jiayi Liu and Wenshen Xu and Haiyang Xu and Qi Qian and Wei Wang and Qinghao Ye and Jiejing Zhang and Ji Zhang and Fei Huang and Jingren Zhou},

year={2023},

eprint={2304.07849},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{plug2021,

title = {{PLUG: Pre-training for Language Understanding and Generation}},

author={ModelScope},

publisher = {ModelScope},

journal = {ModelScope repository},

year = {2021},

howpublished = {url{https://modelscope.cn/models/damo/nlp_plug_text-generation_27B/summary}},

}

Dieser Code ist unter der Apache-Lizenz (Version 2.0) lizenziert.