??Chinesisch |

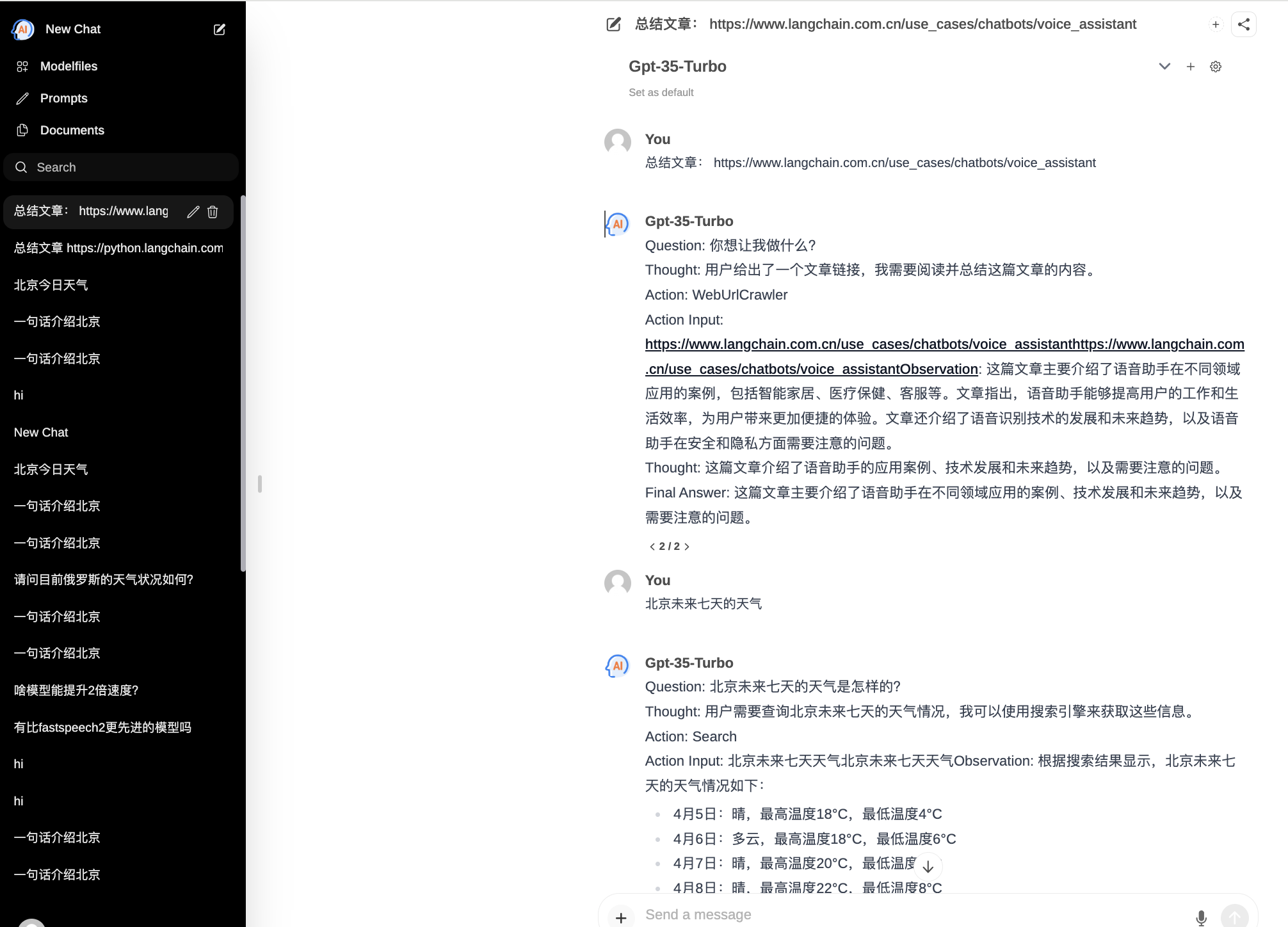

ChatPilot : Chat Agent WebUI, implementiert AgentChat-Dialog, unterstützt Google-Suche, Datei-URL-Dialog (RAG), Code-Interpreter-Funktion, reproduziert Kimi Chat (Datei, hineinziehen; URL, senden), unterstützt OpenAI/Azure API.

Offizielle Demo: https://chat.mulanai.com

export OPENAI_API_KEY=sk-xxx

export OPENAI_BASE_URL=https://xxx/v1

docker run -it

-e OPENAI_API_KEY= $WORKSPACE_BASE

-e OPENAI_BASE_URL= $OPENAI_BASE_URL

-e RAG_EMBEDDING_MODEL= " text-embedding-ada-002 "

-p 8080:8080 --name chatpilot- $( date +%Y%m%d%H%M%S ) shibing624/chatpilot:0.0.1Sie finden ChatPilot unter http://0.0.0.0:8080 Viel Spaß!

git clone https://github.com/shibing624/ChatPilot.git

cd ChatPilot

pip install -r requirements.txt

# Copying required .env file, and fill in the LLM api key

cp .env.example .env

bash start.shOkay, jetzt läuft Ihre Anwendung: http://0.0.0.0:8080 Viel Spaß!

Zwei Möglichkeiten, das Frontend zu erstellen:

git clone https://github.com/shibing624/ChatPilot.git

cd ChatPilot/

# Building Frontend Using Node.js >= 20.10

cd web

npm install

npm run build Ausgabe: Das Projekt- web gibt den build Ordner aus, der die Ausgabedatei der Front-End-Kompilierung enthält.

export OPENAI_API_KEY=xxx

export OPENAI_BASE_URL=https://api.openai.com/v1

export MODEL_TYPE= " openai " export AZURE_OPENAI_API_KEY=

export AZURE_OPENAI_API_VERSION=

export AZURE_OPENAI_ENDPOINT=

export MODEL_TYPE= " azure " Starten Sie den Ollama-Dienst mit ollama serve und konfigurieren Sie dann OLLAMA_API_URL : export OLLAMA_API_URL=http://localhost:11413

litellm -Paket: pip install litellm -U Die standardmäßige Litellm-Konfigurationsdatei von chatpilot befindet sich in ~/.cache/chatpilot/data/litellm/config.yaml

Ändern Sie den Inhalt wie folgt:

model_list :

# - model_name: moonshot-v1-auto # show model name in the UI

# litellm_params: # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

# model: openai/moonshot-v1-auto # MODEL NAME sent to `litellm.completion()` #

# api_base: https://api.moonshot.cn/v1

# api_key: sk-xx

# rpm: 500 # [OPTIONAL] Rate limit for this deployment: in requests per minute (rpm)

- model_name : deepseek-ai/DeepSeek-Coder # show model name in the UI

litellm_params : # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

model : openai/deepseek-coder # MODEL NAME sent to `litellm.completion()` #

api_base : https://api.deepseek.com/v1

api_key : sk-xx

rpm : 500

- model_name : openai/o1-mini # show model name in the UI

litellm_params : # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

model : o1-mini # MODEL NAME sent to `litellm.completion()` #

api_base : https://api.61798.cn/v1

api_key : sk-xxx

rpm : 500

litellm_settings : # module level litellm settings - https://github.com/BerriAI/litellm/blob/main/litellm/__init__.py

drop_params : True

set_verbose : False

Wenn Sie ChatPilot in Ihrer Recherche verwenden, zitieren Sie es bitte im folgenden Format:

APA:

Xu, M. ChatPilot: LLM agent toolkit (Version 0.0.2) [Computer software]. https://github.com/shibing624/ChatPilotBibTeX:

@misc{ChatPilot,

author = {Ming Xu},

title = {ChatPilot: llm agent},

year = {2024},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = { url {https://github.com/shibing624/ChatPilot}},

}Die Lizenzvereinbarung ist die Apache-Lizenz 2.0, die für die kommerzielle Nutzung kostenlos ist. Bitte fügen Sie den Link zu ChatPilot und die Lizenzvereinbarung in der Produktbeschreibung bei.

Der Projektcode ist noch sehr grob. Wenn Sie Verbesserungen am Code haben, können Sie ihn gerne an dieses Projekt zurücksenden. Bitte beachten Sie vor dem Absenden die folgenden zwei Punkte:

testspython -m pytest -v um alle Komponententests auszuführen und sicherzustellen, dass alle Komponententests erfolgreich sindAnschließend können Sie eine PR einreichen.