Basierend auf den sechs Merkmalen aktiver Gesundheit: Initiative, Prävention, Genauigkeit, Personalisierung, Co-Konstruktion und Teilen sowie Selbstdisziplin hat die School of Future Technology der South China University of Technology – Guangdong Provincial Key Laboratory of Digital Twins Open Source entwickelt das aktive Gesundheitssystem des Wohnraums im chinesischen Bereich Modellbasis ProactiveHealthGPT, einschließlich:

BianQue, ein großes Wohnraum-Gesundheitsmodell, das durch zig Millionen chinesische Datenanweisungen zum Gesundheitsdialog verfeinert wurde

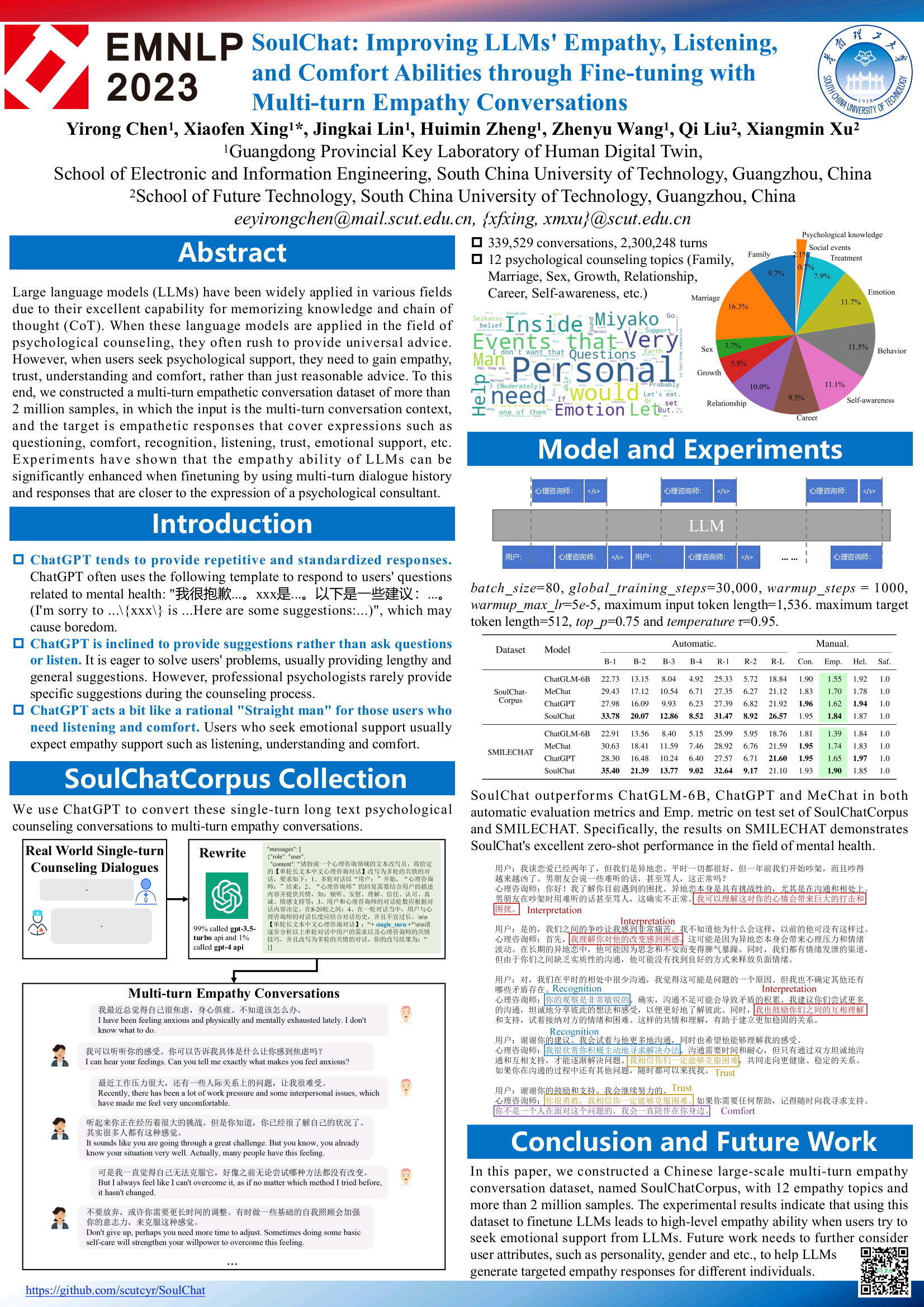

Das groß angelegte Modell für psychische Gesundheit SoulChat wurde durch gemeinsame Anweisungen mit chinesischen Langtextanweisungen und mehreren Runden empathischer Dialogdaten im Bereich von Millionen psychologischer Konsultationen verfeinert.

Wir hoffen, dass die große Modellbasis ProactiveHealthGPT für aktive Gesundheit der akademischen Gemeinschaft dabei helfen kann, die Forschung und Anwendung großer Modelle in aktiven Gesundheitsbereichen wie chronischen Krankheiten und psychologischer Beratung zu beschleunigen. Dieses Projekt ist SoulChat, ein großes Modell für psychische Gesundheit .

2024.06.06: Die Open-Source-Version des SoulChatCorpus-Datensatzes wird veröffentlicht. Weitere Informationen finden Sie insbesondere unter https://www.modelscope.cn/datasets/YIRONGCHEN/SoulChatCorpus Wir haben etwa 90.000 Konversationsbeispiele herausgefiltert (aufgrund von Datenschutzrisiken, Sicherheitsproblemen, politischen Risiken, minderwertigen Beispielen usw. befinden sich diese Beispiele noch in der manuellen Optimierungsphase und werden auf die Open-Source-Version aktualisiert). Datensatz nach Abschluss der manuellen Überprüfung), wodurch letztendlich 258.354 Gespräche mit mehreren Runden, insgesamt 1.517.344 Runden, erhalten bleiben. Eine neue Version des Modells wird in naher Zukunft veröffentlicht und soll an mehrere Open-Source-Modelle und mehrere Parameterebenen angepasst werden, um die Benutzernutzung zu erleichtern oder vergleichende experimentelle Forschung durchzuführen.

07.12.2023: Unser Artikel, enthalten in den Ergebnissen von EMNLP 2023, siehe SoulChat: Improving LLMs' Empathie, Listening, and Comfort Fähigkeiten through Fine-tuning with Multi-turn Empathy Conversations

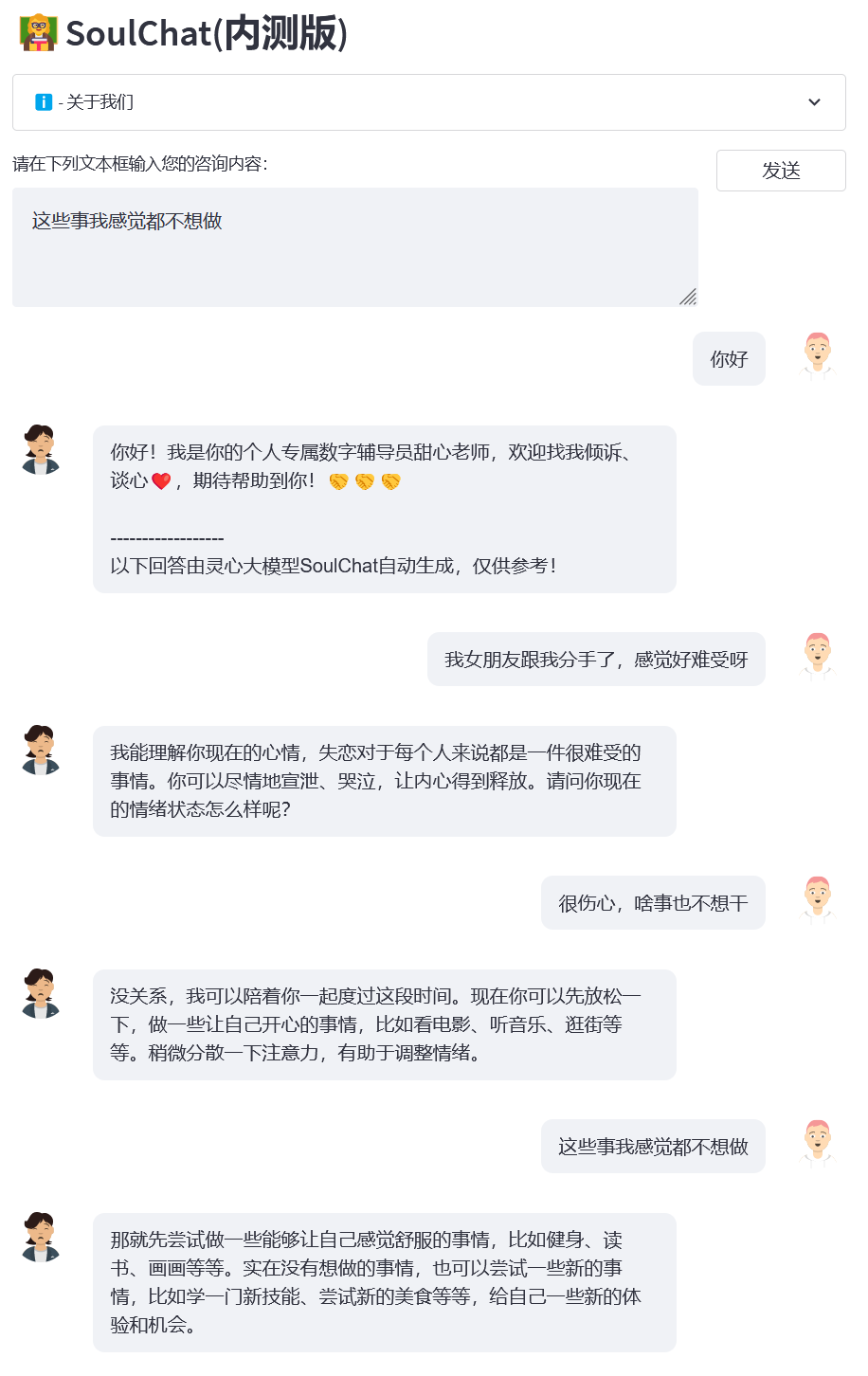

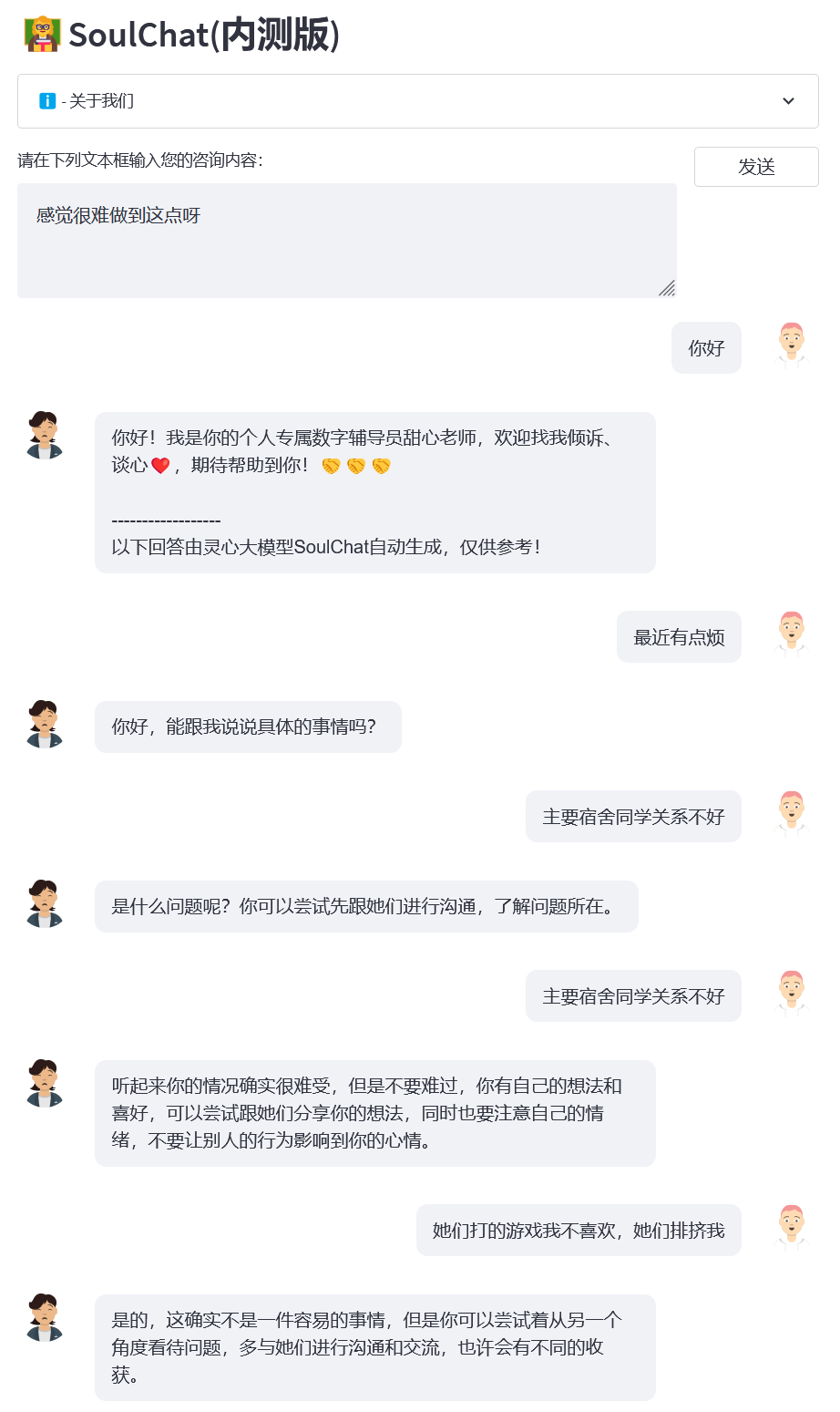

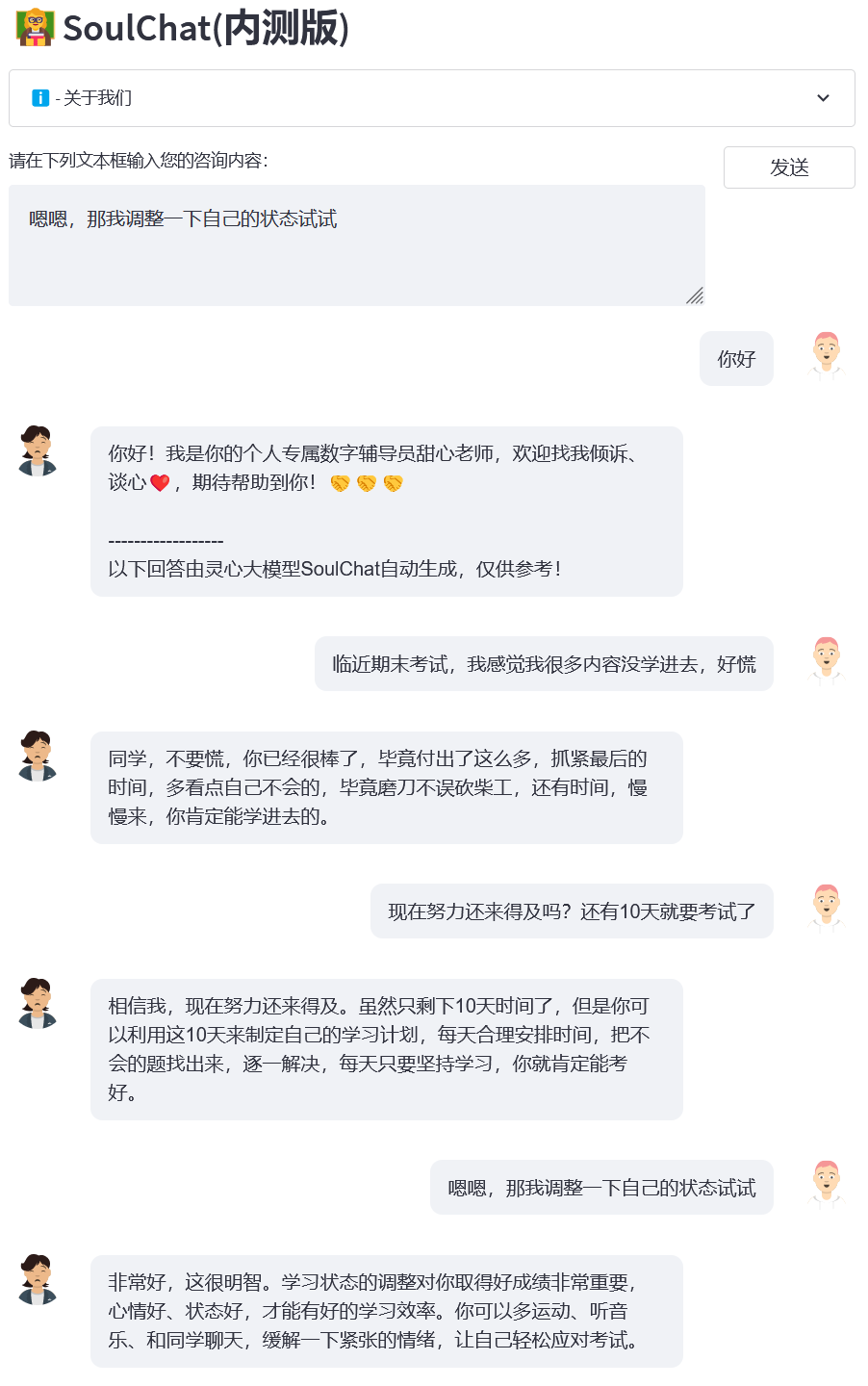

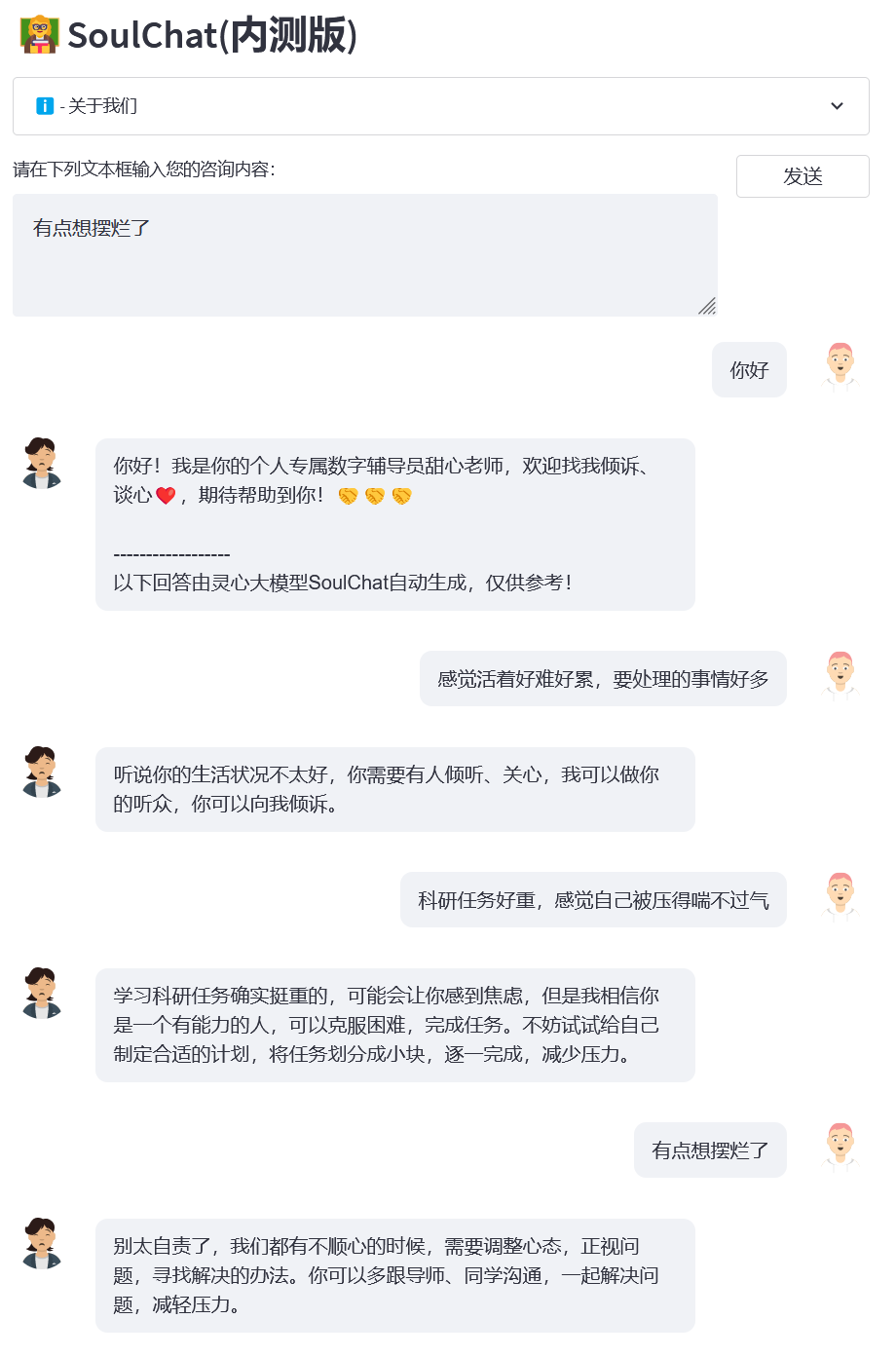

2023.07.07: Die geschlossene Online-Betaversion des großen Modells für psychische Gesundheit SoulChat wird gestartet. Klicken Sie gerne auf den Link, um die geschlossene Betaversion von SoulChat zu verwenden.

24.06.2023: Dieses Projekt wurde in die Liste der großen chinesischen Modelle aufgenommen. Es ist das erste inländische Open-Source-Großmodell im psychologischen Bereich mit Empathie- und Zuhörfähigkeiten.

06.06.2023: Das BianQue-2.0-Modell ist Open Source. Weitere Informationen finden Sie unter BianQue-2.0.

2023.06.06: SoulChat, ein großes spirituelles Gesundheitsmodell mit der Fähigkeit, sich einzufühlen und zuzuhören, wurde veröffentlicht. Einzelheiten finden Sie unter: SoulChat, ein großes spirituelles Gesundheitsmodell: Durch die gemischte Feinabstimmung von langen Textberatungsanweisungen und mehreren Runden von Empathische Dialogdatensätze, die Leistung des Modells verbessert die „Empathie“-Fähigkeit.

22.04.2023: Demo des medizinischen Frage- und Antwortsystems basierend auf dem Bianque-1.0-Modell. Weitere Informationen finden Sie unter: https://huggingface.co/spaces/scutcyr/BianQue

22.04.2023: BianQue-1.0-Versionsmodell wird veröffentlicht. Weitere Informationen finden Sie unter: BianQue-1.0: Verbesserung der „Fragen“-Fähigkeit des medizinischen Chat-Modells durch gemischte Anweisungen und Feinabstimmung mehrerer Runden von Arztanfragedatensätzen (BianQue-1.0). 1.0: Verbesserung der „Frage“-Fähigkeit des medizinischen Chat-Modells durch Feinabstimmung mit Hybridanweisungen und Multi-Turn-QA-Datensätzen für Ärzte.

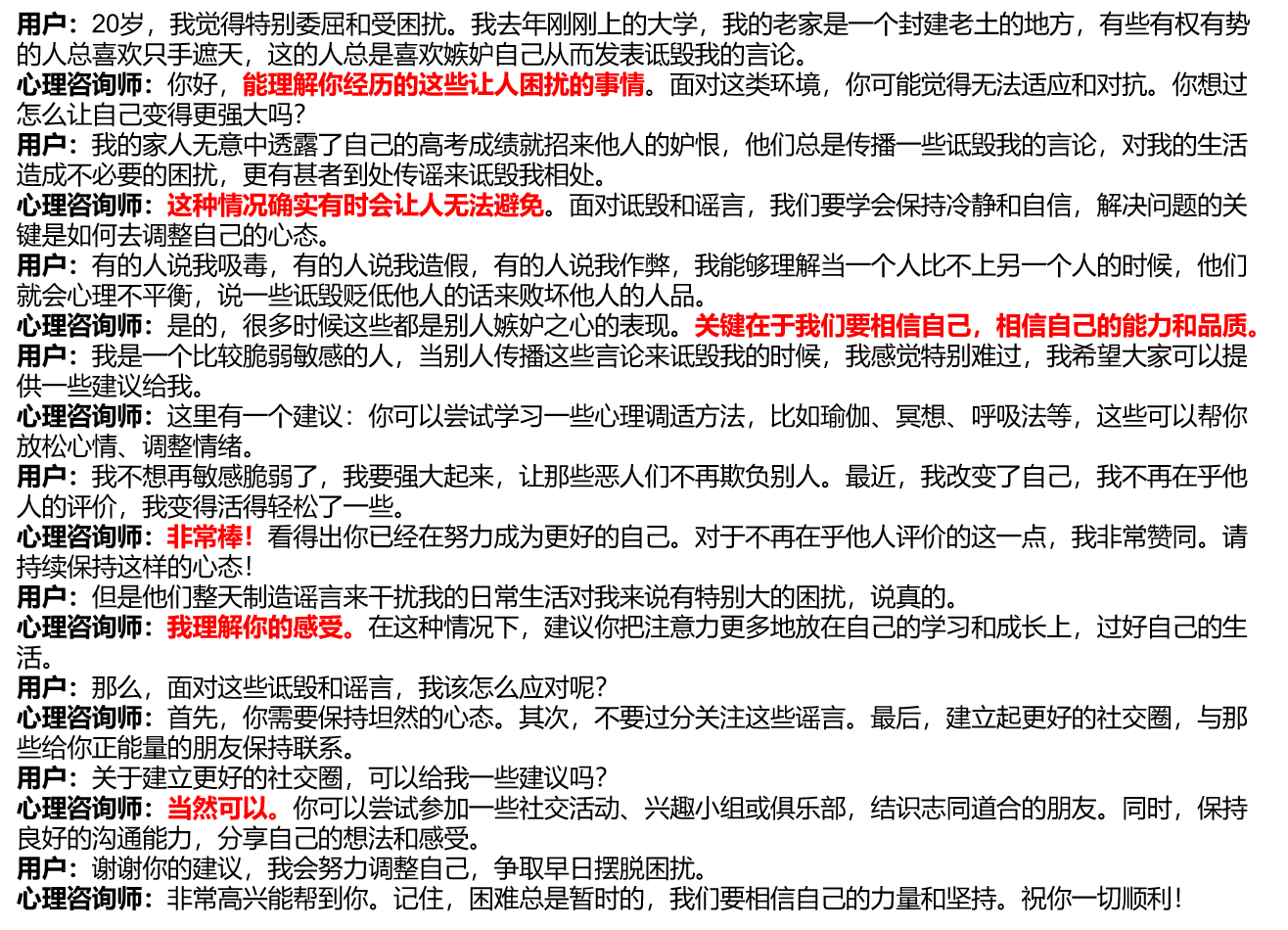

Wir haben die derzeit gängigen psychologischen Beratungsplattformen untersucht und festgestellt, dass Benutzer, die online psychologische Hilfe suchen, sich in der Regel ausführlich beschreiben müssen und die psychologischen Berater, die Hilfe anbieten, dann auch eine lange Antwort geben (siehe Abbildung/single_turn.png). , es fehlt ein progressiver Vertrauensprozess. Im eigentlichen psychologischen Beratungsprozess wird es jedoch mehrere Kommunikationsrunden zwischen dem Benutzer und dem psychologischen Berater geben. Während dieses Prozesses wird der psychologische Berater den Benutzer zum Sprechen anleiten und ihm Empathie vermitteln, wie zum Beispiel: „Es ist großartig.“ , „Ich verstehe, wie du dich fühlst“, „Natürlich kannst du das“ usw. (siehe Bild unten).

In Anbetracht des derzeitigen Mangels an empathischen Dialogdatensätzen mit mehreren Runden haben wir einerseits Anweisungen und Antworten für psychologische Beratung mit Einzelrunden-Langtext (SoulChatCorpus-single_turn) mit einer Skala von mehr als 150.000 erstellt und die Anzahl der Antworten überschritten 500.000 (die Anzahl der Anweisungen beträgt derzeit das 6,7-fache des allgemeinen psychologischen Beratungsdatensatzes PsyQA) und generierte mithilfe von ChatGPT und GPT4 insgesamt etwa 1 Million Runden Multi-Runden-Antwortdaten (SoulChatCorpus-multi_turn). . Insbesondere haben wir im Vorexperiment festgestellt, dass ein rein einstufiges psychologisches Beratungsmodell, das auf langen Artikeln basiert, zu einer Textlänge führt, die für Benutzer langweilig ist, und dass es nicht in der Lage ist, Benutzer zum Sprechen zu führen Datengesteuertes psychologisches Beratungsmodell für den runden psychologischen Beratungsdialog. Das Modell schwächt die Empfehlungsfähigkeit des Modells. Daher haben wir SoulChatCorpus-single_turn und SoulChatCorpus-multi_turn gemischt, um einen ein- und mehrrundigen gemischten empathischen Dialogdatensatz mit SoulChatCorpus zu erstellen als 1,2 Millionen Proben. . Alle Daten werden in einem Befehlsformat in der Form „Benutzer: xxxn Psychologischer Berater: xxxn Benutzer: xxxn Psychologischer Berater:“ zusammengefasst.

Wir wählten ChatGLM-6B als Initialisierungsmodell und führten eine Feinabstimmung aller Parameter durch, um die Empathiefähigkeit des Modells zu verbessern, Benutzer zum Sprechen anzuleiten und vernünftige Vorschläge zu machen. Für weitere Schulungsdetails beachten Sie bitte unsere nachfolgenden Dokumente.

Klonen Sie dieses Projekt

cd ~git clone https://github.com/scutcyr/SoulChat.git

Bitte beachten Sie bei der Installation von Abhängigkeiten, dass die Torch-Version basierend auf der tatsächlichen Cuda-Version Ihres Servers ausgewählt werden muss. Weitere Informationen finden Sie im Pytorch-Installationshandbuch.

CD SoulChat conda env create -n proactivehealthgpt_py38 --file proactivehealthgpt_py38.yml Conda aktiviert proactivehealthgpt_py38 pip cpm_kernels installieren pip install Torch==1.13.1+cu116 Torchvision==0.14.1+cu116 Torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu116

[Ergänzung] Benutzern unter Windows wird empfohlen, sich zum Konfigurieren der Umgebung an den folgenden Prozess zu halten.

cdBianQue conda create -n proactivehealthgpt_py38 python=3.8 Conda aktiviert proactivehealthgpt_py38 pip install Torch==1.13.1+cu116 Torchvision==0.14.1+cu116 Torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu116 pip install -r Anforderungen.txt pip install rouge_chinese nltk jieba datasets# Die folgende Installation besteht darin, demoopip install streamlit auszuführen pip install streamlit_chat

[Ergänzung] Konfigurieren von CUDA-11.6 unter Windows: Laden Sie CUDA-11.6 herunter und installieren Sie es, laden Sie cudnn-8.4.0 herunter, entpacken Sie die Dateien und kopieren Sie sie in den Pfad, der CUDA-11.6 entspricht. Weitere Informationen finden Sie unter: Verwenden von Conda zum Installieren von Pytorch unter Win11-Cuda11 . 6-Allgemeine Installationsideen

Aufrufen des SoulChat-Modells in Python

import Torchfrom Transformers Import AutoModel, AutoTokenizer# GPU-Einstellungen device = Torch.device("cuda" if Torch.cuda.is_available() else "cpu")# Modell mit Tokenizer laden model_name_or_path = 'scutcyr/SoulChat' model = AutoModel.from_pretrained( Modellname_oder_Pfad, trust_remote_code=True).half()model.to(device)tokenizer = AutoTokenizer.from_pretrained(model_name_or_path, trust_remote_code=True)# Ein-Runden-Dialog ruft die Chat-Funktion des Modells auf user_input = „Ich bin verliebt, so unangenehm!“ = „Benutzer:“ + user_input + „nPsychologischer Berater:“response, History = model.chat(tokenizer, query=input_text, History=None, max_length=2048, num_beams=1, do_sample=True, top_p=0.75, Temperature=0.95, logits_processor=None)# Rufen Sie die Chat-Funktion des Modells für mehrere Runden auf Dialog# Hinweis: Dieses Projekt verwendet „n Benutzer:“ und „n psychologische Berater:“, um den Gesprächsverlauf verschiedener Runden aufzuteilen# Hinweis: user_history ist länger als bot_history 1user_history = ['Hallo, Lehrer', 'Meine Freundin hat mit mir Schluss gemacht und ich fühle mich so unwohl']bot_history = ['Hallo! Ich bin Ihr persönlicher digitaler Berater, Sweetheart Teacher. Sie können gerne mit mir sprechen und ein persönliches Gespräch führen. ']# Splicing-Konversationsverlauf context = "n".join([f"User: {user_history[i]}n Psychologischer Berater: {bot_history[i]}" for i in range(len(bot_history))])input_text = Kontext + „nuser:“ + user_history[-1] + „npsychologischer Berater:“ Antwort, Verlauf = model.chat(tokenizer, query=input_text, History=None, max_length=2048, num_beams=1, do_sample=True, top_p=0.75, Temperature=0.95, logits_processor=None)Dienst starten

Dieses Projekt stellt soulchat_app.py als Beispiel für die Verwendung des SoulChat-Modells bereit. Sie können den Dienst über den folgenden Befehl starten und dann über http://<your_ip>:9026 darauf zugreifen.

streamlit run soulchat_app.py --server.port 9026

Insbesondere können Sie in soulchat_app.py den folgenden Code ändern, um die angegebene Grafikkarte zu ersetzen:

os.environ['CUDA_VISIBLE_DEVICES'] = '2'

Für Benutzer einer einzelnen Windows-Grafikkarte müssen Sie es wie folgt ändern: os.environ['CUDA_VISIBLE_DEVICES'] = '0' , andernfalls wird ein Fehler gemeldet!

Sie können den Modellpfad als lokalen Pfad angeben, indem Sie den folgenden Code ändern:

model_name_or_path = 'scutcyr/SoulChat'

Beispiel 1: Verliebt

Beispiel 2: Wohnheimbeziehung

Beispiel 3: Abschlussprüfung

Beispiel 4: Wissenschaftlicher Forschungsdruck

Dieses Projekt verwendet die Gewichte des ChatGLM-6B-Modells und muss seiner MODEL_LICENSE folgen. Daher kann dieses Projekt nur für Ihre nichtkommerziellen Forschungszwecke verwendet werden .

Das von diesem Projekt bereitgestellte SoulChat-Modell zielt darauf ab, die empathischen Dialog- und Zuhörfähigkeiten großer Modelle zu verbessern. Der Ausgabetext des Modells weist jedoch einen gewissen Grad an Zufälligkeit auf, was bei Verwendung als Zuhörer angemessen ist Es wird nicht empfohlen, das SoulChat-Modell zu verwenden. Der ausgegebene Text ersetzt die Diagnose und den Rat eines Psychologen usw. Dieses Projekt garantiert nicht, dass der vom Modell ausgegebene Text vollständig für Benutzer geeignet ist. Benutzer müssen bei der Verwendung dieses Modells alle Risiken tragen!

Es ist Ihnen nicht gestattet, das SoulChat-Modell ganz oder teilweise für kommerzielle, militärische oder illegale Zwecke zu verwenden, zu kopieren, zu modifizieren, zusammenzuführen, zu veröffentlichen, zu verteilen, zu reproduzieren oder abgeleitete Werke daraus zu erstellen.

Sie dürfen das SoulChat-Modell nicht für Verhaltensweisen nutzen, die die nationale Sicherheit und die nationale Einheit gefährden, soziale und öffentliche Interessen gefährden oder Persönlichkeitsrechte verletzen.

Wenn Sie das SoulChat-Modell verwenden, sollten Sie sich darüber im Klaren sein, dass es Fachkräfte wie Ärzte und Psychologen nicht ersetzen kann. Sie sollten sich nicht zu sehr auf die Ergebnisse des Modells verlassen, ihm gehorchen oder daran glauben, und Sie sollten nicht süchtig danach sein, mit dem SoulChat zu chatten Modell seit langem.

Dieses Projekt wurde vom Guangdong Provincial Key Laboratory of Digital Twins, School of Future Technology, South China University of Technology initiiert. Es wird vom Information Network Engineering Research Center, School of Electronics and Information und anderen Abteilungen der South China University of Technology unterstützt Es dankt außerdem dem Guangdong Maternal and Child Health Hospital, der Stadtregierung von Guangzhou. Zu den kooperierenden Einheiten gehören das Women and Children's Medical Center, das Third Affiliated Hospital der Sun Yat-sen University und das Artificial Intelligence Research Institute des Hefei Comprehensive National Science Center.

Gleichzeitig möchten wir uns bei den folgenden Medien bzw. öffentlichen Stellen für die Berichterstattung über dieses Projekt bedanken (in keiner bestimmten Reihenfolge):

Medienberichterstattung People's Daily, China.com, Guangming.com, TOM Technology, Future.com, Dazhong.com, China Development Report Network, China Daily Network, Xinhua News Network, China.com, Toutiao, Sohu, Tencent News, NetEase News , China Information Network, China Communication Network, China City Report Network, China City Network

Public Account Guangdong Laboratory Construction, Intelligent Voice New Youth, Deep Learning und NLP, AINLP

@inproceedings{chen-etal-2023-soulchat,title = „{S}oul{C}hat: Verbesserung der Empathie-, Zuhör- und Trostfähigkeiten von {LLM}s{'} durch Feinabstimmung mit Empathiegesprächen mit mehreren Runden“, Autor = „Chen, Yirong und Xing, Xiaofen und Lin, Jingkai und Zheng, Huimin und Wang, Zhenyu und Liu, Qi und Xu, Xiangmin",editor = "Bouamor, Houda und Pino, Juan und Bali, Kalika",booktitle = "Ergebnisse der Association for Computational Linguistics: EMNLP 2023",month = dec,year = "2023",address = "Singapur", editor = "Vereinigung für Computerlinguistik",url = "https://aclanthology.org/2023.findings-emnlp.83",pages = "1170--1183",abstract = "Große Sprachmodelle (LLMs) werden aufgrund ihrer hervorragenden Merkfähigkeit in verschiedenen Bereichen häufig eingesetzt Wenn diese Sprachmodelle im Bereich der psychologischen Beratung angewendet werden, beeilen sie sich häufig, universelle Ratschläge zu geben. Wenn Benutzer jedoch psychologische Unterstützung suchen, müssen sie Empathie entwickeln. Vertrauen, Verständnis und Trost, statt nur vernünftige Ratschläge. Zu diesem Zweck haben wir einen Datensatz zu empathischen Gesprächen mit mehreren Runden erstellt, der aus mehr als 2 Millionen Beispielen besteht die Ausdrücke wie Fragen, Trost, Anerkennung, Zuhören, Vertrauen, emotionale Unterstützung usw. abdecken. Experimente haben gezeigt, dass die Empathiefähigkeit von LLMs bei der Feinabstimmung durch die Verwendung von mehrstufigen Dialogverläufen und Antworten, die näher am Ausdruck liegen, erheblich verbessert werden kann eines psychologischen Beraters“,

}}