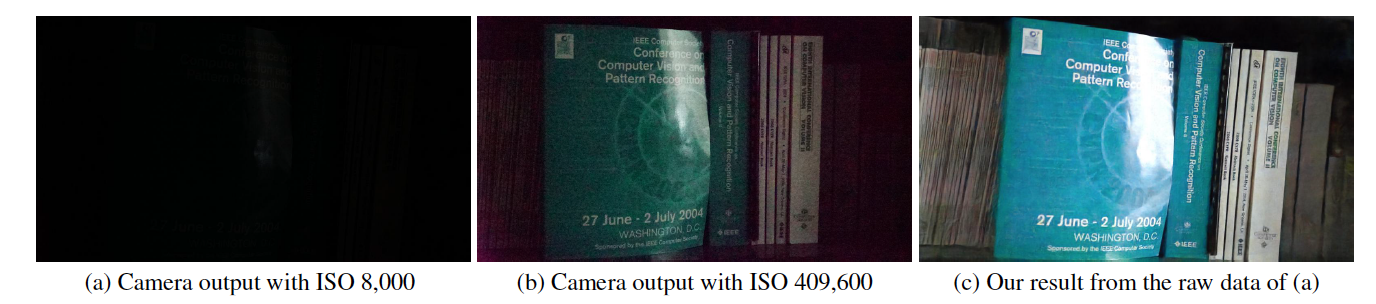

Dies ist eine Tensorflow-Implementierung von „Learning to See in the Dark“ in CVPR 2018 von Chen Chen, Qifeng Chen, Jia Xu und Vladlen Koltun.

Projekt-Website

Papier

Dieser Code enthält das Standardmodell für das Training und Testen des See-in-the-Dark-Datensatzes (SID).

https://youtu.be/qWKUFK7MWvg

Erforderliche Python-Bibliotheken (Version 2.7): Tensorflow (>=1.1) + Scipy + Numpy + Rawpy.

Getestet in Ubuntu + Intel i7 CPU + Nvidia Titan X (Pascal) mit Cuda (>=8.0) und CuDNN (>=5.0). Der CPU-Modus sollte mit geringfügigen Änderungen, die jedoch nicht getestet wurden, ebenfalls funktionieren.

Update August 2018: Wir haben für die Bilder 10034, 10045, 10172 eine gewisse Abweichung von der Grundwahrheit festgestellt. Bitte entfernen Sie diese Bilder für quantitative Ergebnisse, sie können jedoch weiterhin für qualitative Bewertungen verwendet werden.

Sie können es für die Sony- (25 GB) und Fuji-Sets (52 GB) direkt von Google Drive herunterladen.

Es gibt ein Download-Limit von Google Drive in einem festgelegten Zeitraum. Wenn Sie aus diesem Grund nicht herunterladen können, versuchen Sie es mit diesen Links: Sony (25 GB) und Fuji (52 GB).

Neu: Wir stellen jetzt Dateiteile in Baidu Drive bereit. Nachdem Sie alle Teile heruntergeladen haben, können Sie sie zusammenfügen, indem Sie Folgendes ausführen: „cat SonyPart* > Sony.zip“ und „cat FujiPart* > Fuji.zip“.

Die Dateilisten werden bereitgestellt. In jeder Zeile gibt es einen kurzbelichteten Bildpfad, den entsprechenden langbelichteten Bildpfad, den ISO-Wert und die Blendenzahl der Kamera. Beachten Sie, dass mehrere kurzbelichtete Bilder demselben langbelichteten Bild entsprechen können.

Der Dateiname enthält die Bildinformationen. Beispielsweise bedeutet in „10019_00_0.033s.RAF“ die erste Ziffer „1“, dass sie aus dem Testsatz stammt („0“ für Trainingssatz und „2“ für Validierungssatz); „0019“ ist die Bild-ID; die folgende „00“ ist die Nummer in der Sequenz/Burst; „0,033s“ ist die Belichtungszeit 1/30 Sekunde.

python download_models.pyStandardmäßig übernimmt der Code die Daten im Ordner „./dataset/Sony/“ und „./dataset/Fuji/“. Wenn Sie den Datensatz in anderen Ordnern speichern, ändern Sie bitte „input_dir“ und „gt_dir“ am Anfang des Codes.

Standardmäßig übernimmt der Code die Daten im Ordner „./dataset/Sony/“ und „./dataset/Fuji/“. Wenn Sie den Datensatz in anderen Ordnern speichern, ändern Sie bitte „input_dir“ und „gt_dir“ am Anfang des Codes.

Das Laden der Rohdaten und die Verarbeitung durch Rawpy dauert deutlich länger als die Backpropagation. Standardmäßig lädt der Code alle von Rawpy verarbeiteten Groundtruth-Daten ohne 8-Bit- oder 16-Bit-Quantisierung in den Speicher. Dafür sind mindestens 64 GB RAM für das Training des Sony-Modells und 128 GB RAM für das Fuji-Modell erforderlich. Wenn Sie es auf einem Computer mit weniger RAM trainieren müssen, müssen Sie möglicherweise den Code überarbeiten und die Groundtruth-Daten auf der Festplatte verwenden. Wir stellen die von Rawpy verarbeiteten 16-Bit-Groundtruth-Bilder zur Verfügung: Sony (12 GB) und Fuji (22 GB).

Wenn Sie unseren Code und Datensatz für Forschungszwecke verwenden, zitieren Sie bitte unseren Artikel:

Chen Chen, Qifeng Chen, Jia Xu und Vladlen Koltun, „Learning to See in the Dark“, in CVPR, 2018.

MIT-Lizenz.

Die vorgeschlagene Methode ist für Sensorrohdaten konzipiert. Das vorab trainierte Modell funktioniert wahrscheinlich nicht für Daten von einem anderen Kamerasensor. Für andere Kameradaten bieten wir keine Unterstützung. Es funktioniert auch nicht für Bilder nach dem Kamera-ISP, also JPG- oder PNG-Daten.

Hierbei handelt es sich um ein Forschungsprojekt und einen Prototyp zur Prüfung eines Konzepts.

Im Allgemeinen müssen Sie nur den richtigen Schwarzwert subtrahieren und die Daten auf die gleiche Weise wie Sony/Fuji-Daten packen. Wenn Sie Rawpy verwenden, müssen Sie den Schwarzwert ablesen, anstatt 512 im bereitgestellten Code zu verwenden. Der Datenbereich kann auch abweichen, wenn er nicht 14 Bit beträgt. Sie müssen es für die Netzwerkeingabe auf [0,1] normalisieren.

Dies liegt häufig daran, dass das vorab trainierte Modell nicht ordnungsgemäß heruntergeladen wurde. Nach dem Herunterladen sollten Sie 4 Checkpoint-bezogene Dateien für das Modell erhalten.

Wenn Sie nach dem Lesen der FAQ weitere Fragen haben, senden Sie bitte eine E-Mail an [email protected].